@xiaohaizi

2022-02-08T03:51:40.000000Z

字数 148111

阅读 1031

前言

本MySQL系列文章首发于微信公众号“我们都是小青蛙”,小孩子希望它们能在各位小伙伴工作面试过程中起到一定作用,希望对大家有帮助。

作者介绍:小孩子,目前创作:

- 《MySQL是怎样使用的:快速入门MySQL》书籍

- 《MySQL是怎样运行的:从根儿上理解MySQL》书籍

- 《计算机是怎样运行的:从根儿上理解计算机》掘金小册

MySQL索引是怎么推导出来的

公众号文章

写本文的起因

《MySQL是怎样运行的》于2020年11.1日发行至今近一年的时间,已经印刷近两万册,十分感谢各位小伙伴的捧场。不过最近在答疑群里一直有小伙伴说:“书看的时候很爽,以为自己啥都会了,不过过一段时间后就都忘了,面试一问好像都学过,但是就是想不起来具体的内容是个啥”。

小孩子在这里需要强调一下,这不是一本入门的书籍,不是随便翻翻就可以学会,需要大家拿出一个完整的时间,找一个笔记本好好记一下笔记才可以学会的。

另外,书里涉及大量的细节,比方说我们致力于将记录、页面、索引、表空间中涉及的结构的每一个字节都是干什么的给大家讲清楚,但记住这些细节并不是重点,细节是用来辅助大家理解脉络的。我们尝试过在没有细节的情况下去讲述MySQL是怎样执行查询的,但大家一定会如站在空中楼阁,表面看起来很光鲜,但时刻都有掉下去的危险。

本文来尝试以最简单的脉络来帮各位理出一条线,大家有了这条线作为主心骨,就不用怕淹没在细节的海洋中无法自拔了。

第1~2章

前两章非常简单,主要介绍如何启动MySQL服务器和客户端,以及启动选项和系统变量。没有什么难度,就不花篇幅唠叨了。

第3章

我们需要明白“字符”是面向人类的概念,计算机需要用一个二进制字节序列来表示字符,由于二进制字节序列和字符的映射关系谁都可以规定,所以市面上产生了各种各样的字符集。

数字之间可以比较大小,字符之间也可以比较大小,不过比较字符时取决于人的好恶。比方说有人觉得'A'和'a'是相等的,有人就觉得不相等。所以我们在比较字符前需要事先规定好一个规则来说明谁大谁小,这个规则就是所谓的比较规则。

MySQL支持若干种字符集,不同字符集也可以有不同的比较规则,我们可以通过一定语法来进行配置。

第4章

大家需要知道一条记录实际上是分两部分存储的:

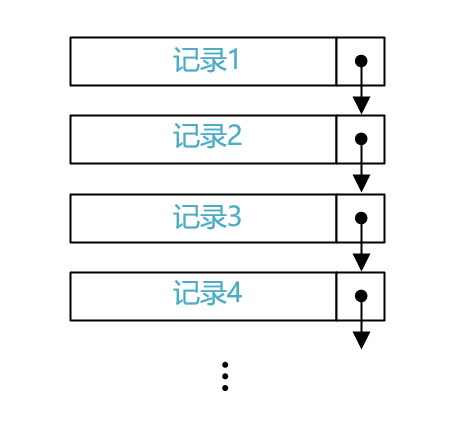

重点需要知道在记录的额外信息中有一个两字节的称为next_record指针,通过该指针各条记录可以组成一个单向链表:

单向链表中的记录的主键值是按照从小到大的顺序排序的,也就是说这个单向链表是有序的。

第5章

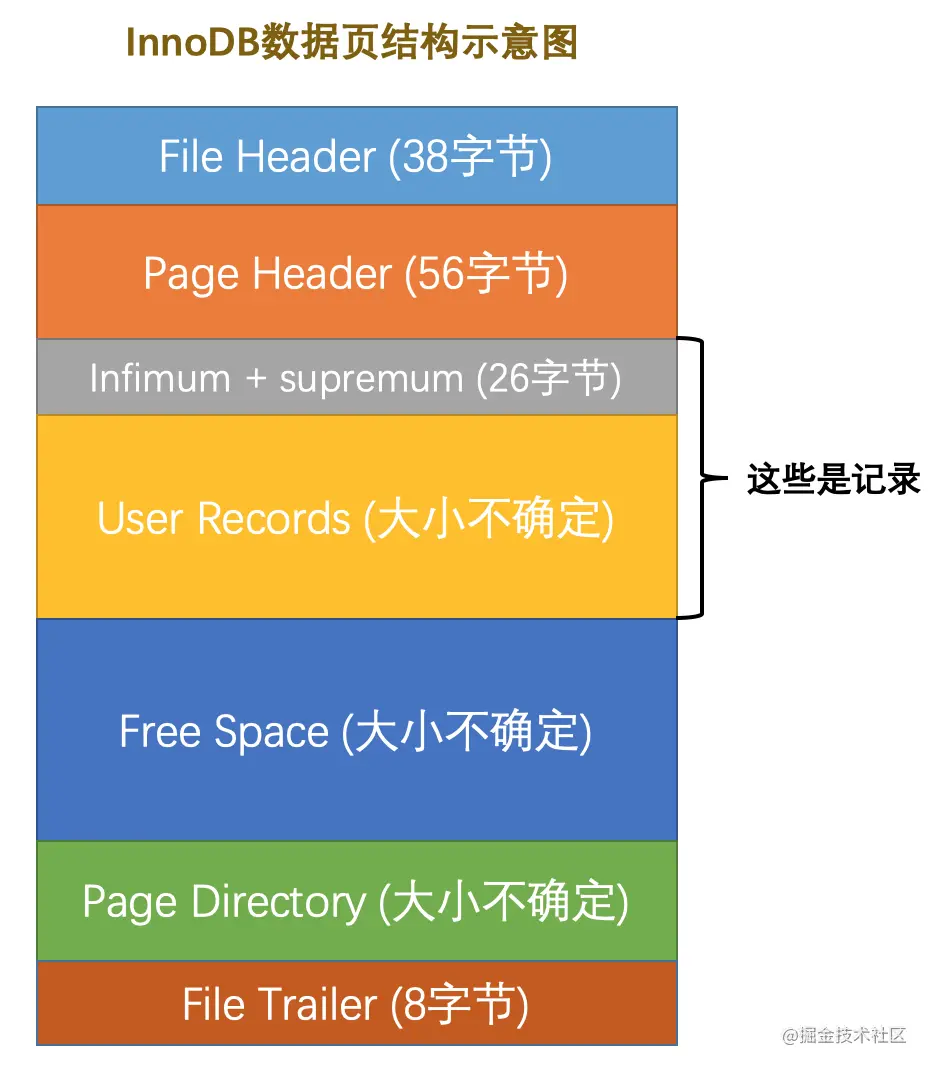

大家需要知道记录是放在页里边的, InnoDB是以页为单位从磁盘上加载数据的。页面可以配置成4KB、8KB、16KB、32KB、64KB几种大小,不过默认是16KB的。

对于存储记录的数据页来说,它的结构如下图所示:

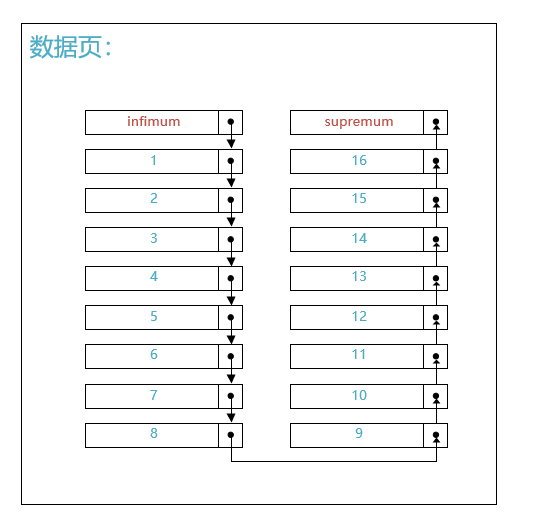

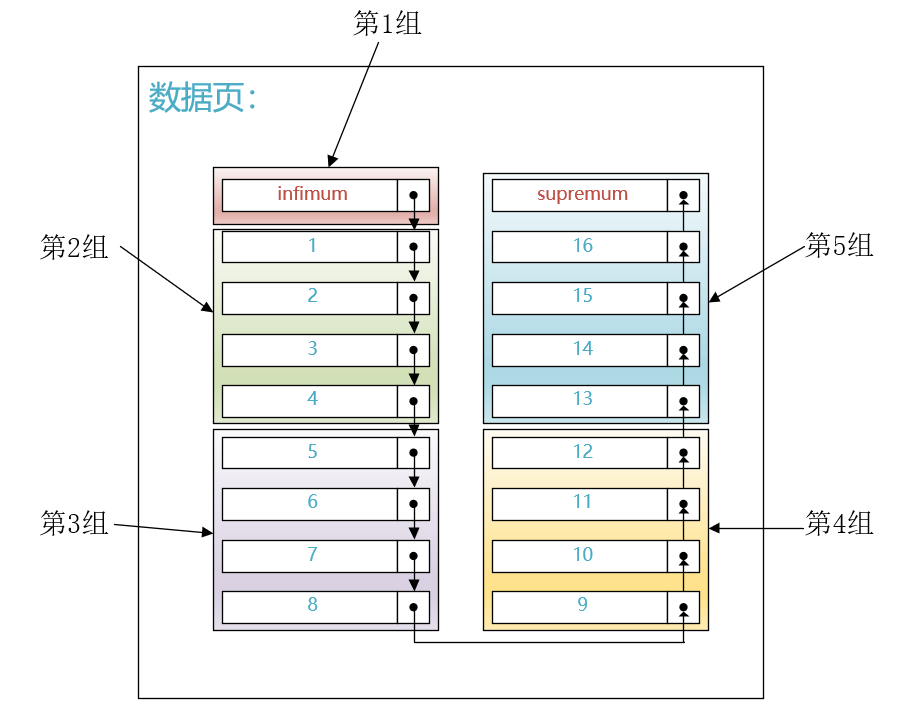

下边假设某个页中存储了16条用户插入的记录,该数据页的效果图如下所示:

其中Infimum记录和Supremum记录是InnoDB给我们自动生成的两个伪记录,并且规定:

Infimum记录作为本页面中最小的记录Supremum记录作为本页面中最大的记录

如上图所示,各条记录之间按照主键值大小组成了一个单向链表。

接下来我们面临的问题是如何从一个按照主键值大小进行排序的单向链表中快速定位到指定的主键值在哪里。很遗憾,链表做不到呀~

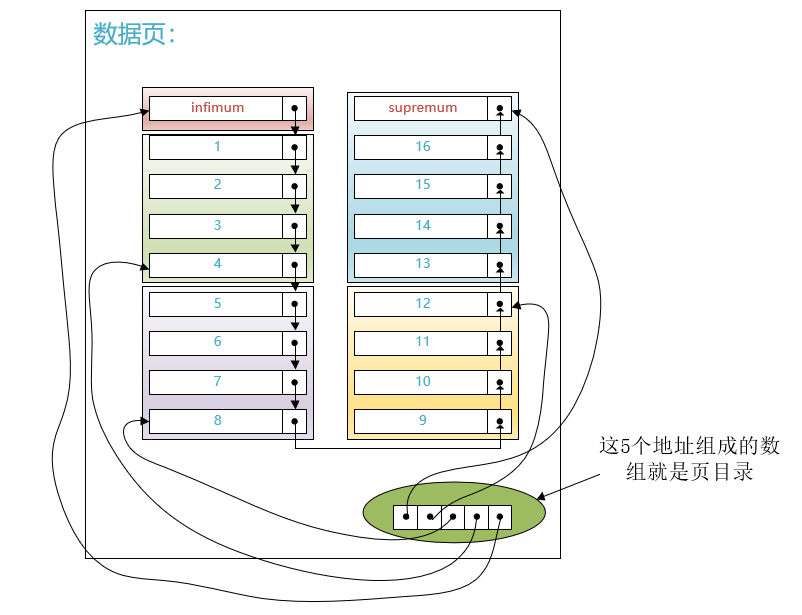

为了解决快速搜索的问题,设计InnoDB的大叔引入了一个称作页目录的东西。具体的做法就是将单向链表中的记录分成若干个组,如下图所示:

然后将把每个组最大的那条记录在页面中的地址(就是距离页面第0个字节处的偏移量)取出来单独放到页面中的一个部分。每个地址占用2个字节,多个地址就可以组成一个数组结构,如下图所示:

可见,页目录本质上就是一个指针数组,指针指向的记录是有序的,我们就可以针对这个页目录进行二分搜索。比方说我们想找主键值为6的记录,那就可以通过页目录先进行二分查找,定位到主键值6其实是在第3组里,然后再遍历第3组中的记录,就可以定位到具体的主键值6的记录在哪里了。

稍微总结一下,通过第5章的学习,我们应该知道如何在单个页面中快速定位某个主键值的记录了,大致分两步:

第一步:通过页目录定位到该记录所在的组。

第二部:遍历该组中的记录来找到待查询的主键值(由于一个组中最多有8条记录,所以遍历一个组中的记录的代价还是很小的)。

第6章

现在大家已经知道如何在单个页面中通过页目录来快速定位某个主键值对应的记录了。

一个页里可以放置若干条记录,如果记录太多,就得分散到不同的页中。

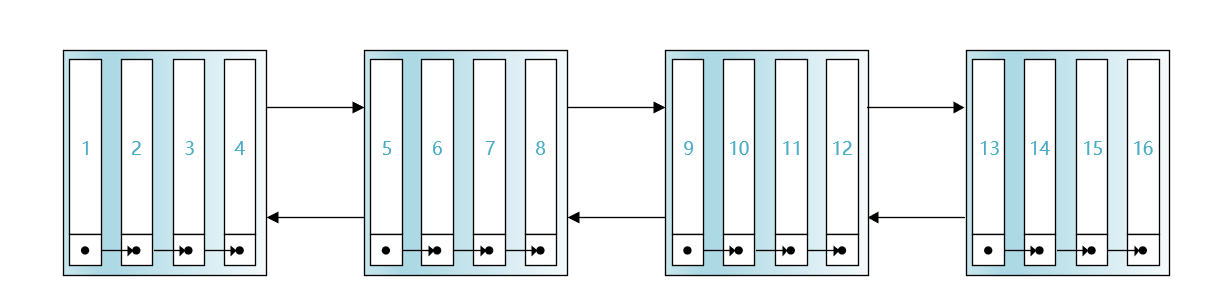

页中存储的除了记录以外,还有若干额外信息,其中包括两个指针(这两个指针在上图中的File Header中):

- 一个指针指向上一个页

- 一个指针指向下一个页

这样多个页之间也可以通过双向链表连接起来,而且InnoDB会保证每个页中存储记录的主键值肯定不大于下一个页中存储记录的主键值,也就是说由页面组成的双向链表也是按照它们中存储记录的主键值大小进行排序的。

现在我们做一个大胆的假设:假设一个页里只能存储4条记录,然后有16条记录分散在4个页里,页之间按照它们中存储的主键值进行排序为双向链表,如下图所示:

现在如果我们想查找主键值为6的记录该怎么办呢?很遗憾,我们不知道主键值为6的记录在哪个页里,只能从第一个页开始,一个页一个页的找。

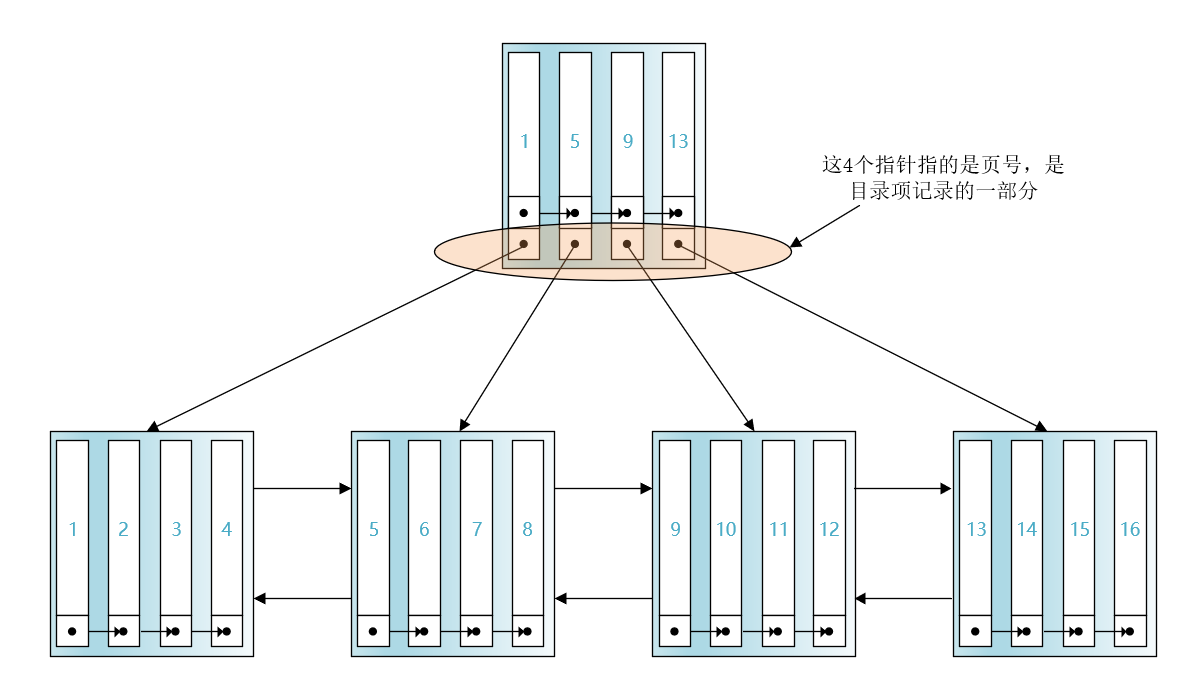

遍历很低效,InnoDB采取的方案就是将每个页的主键值最小的用户插入的记录的主键值拿出来,然后和该页的页号拼接成一个新的记录,为了和用户插入的记录做区分,我们把用户插入的记录称作用户记录,把这个新拼接成的记录称作目录项记录。

目录项记录也按照主键值排序成单向链表,也可以通过页目录来快速定位主键值等于某个值的目录项记录。

引入了目录项记录以及存储目录项记录的页之后,我们再查找主键值为6的记录就分为2步了:

先在存储目录项记录的页中通过页目录进行二分查找,快速定位用户记录所在的页。因为5 < 6 < 9,我们就知道了主键值为6的用户记录是在主键值为5的目录项记录所指向的页中。

然后在主键值为5的目录项记录所指向的页中,再通过页目录进行二分查找快速定位到主键值为6的用户记录。

表中的记录是可以不断扩充的,每增加一个存储用户记录的页,就需要在存储目录项记录的页中增加一条目录项记录,而页的大小是有限的(默认是16KB),所以存储目录项记录的页也可能被填满,这时候就需要再申请新的存储目录项记录的页,如下图所示:

多个存储目录项记录的页之间也是用双向链表连接的,而且它们也是按照各自页中目录项记录的主键值进行排序的。但是对于多个存储目录项记录的页来说,我们怎么知道我们要找的记录应该在哪个存储目录项记录的页中呢?

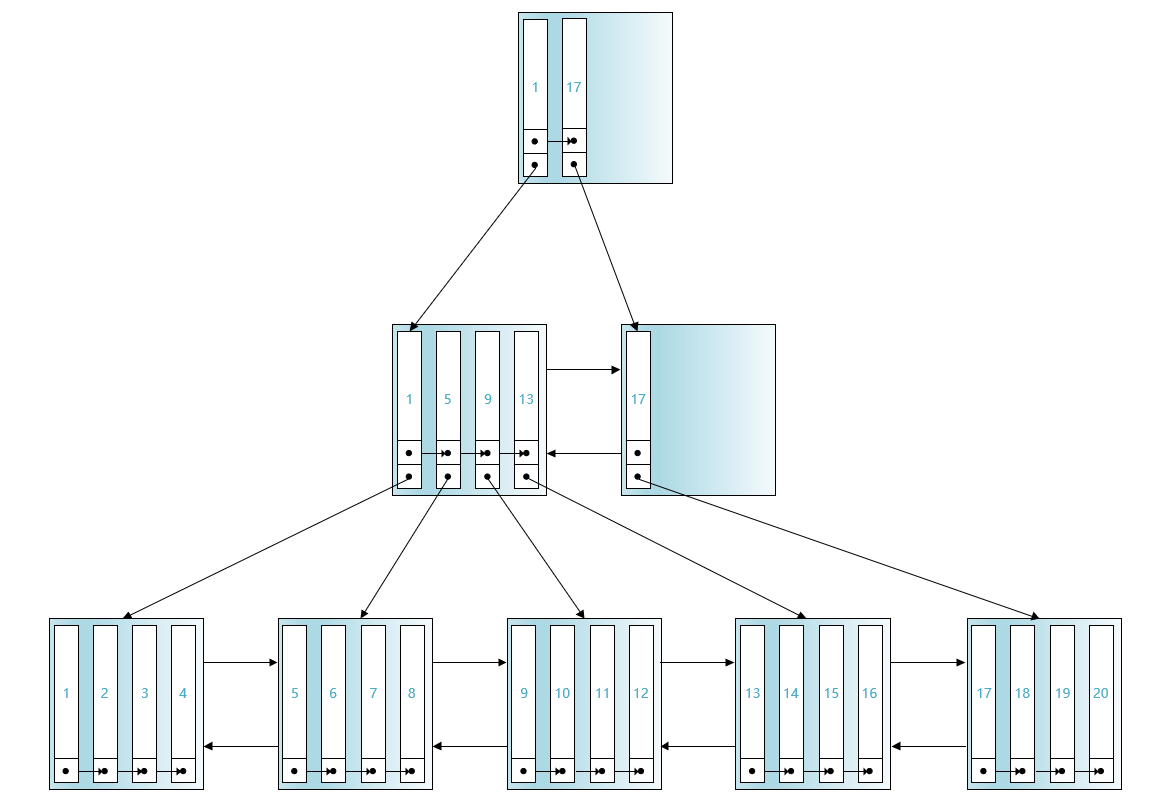

这时设计InnoDB的大叔开始了套娃操作,即再将各个存储目录项记录的页中最小的主键值给提取出来,与相应的页号组成更高一层的目录项记录,再填充到新的页里,如下图所示:

更高一层的目录项记录也按照主键值大小连成了单向链表,这些更高一层的目录项记录所在的页中也有页目录结构。

这样的话各个页面就分为了3层。设计InnoDB的大叔把最下边的存放用户记录的一层称作第0层,第0层往上是第1层,再往上是第2层。

现在如果我们想查找主键值为6的记录的话,那么查找过程就分为了3步:

第1步: 先通过第二层页面的页目录进行二分查找,可以快速定位到第1层目录项记录所在的页。因为1 < 6 < 17,我们就知道我们该去第1层中的最左边的那个页中进行进一步的查找。

第2步:在第1层的存储目录项记录的页中通过页目录进行二分查找,快速定位用户记录所在的页。因为5 < 6 < 9,我们就知道了主键值为6的用户记录是在主键值为5的目录项记录所指向的页中。

第3步:然后在主键值为5的目录项记录所指向的页中,再通过页目录进行二分查找快速定位到主键值为6的用户记录。

设计InnoDB的大叔给上边的结构给了个名:B+树(因为像一颗倒过来的树)。InnoDB中的B+树还有另一个别名:索引。B+树的第0层,也就是最下边那层的页面称作叶子节点,其余的页面被称作非叶子节点或者内节点。其中最高层的节点也被称作根节点或者根页面。

至此,我们了解了索引结构是如何诞生的。

上边介绍按照主键进行排序的B+树索引结构被称作聚簇索引,聚簇索引的叶子节点存放着完整的用户记录(即各个列的值)。我们也可以给自己感兴趣的列或者列组合建立B+树索引,不过此时B+树中就会按照我们给定的列或列组合进行排序(这里指的是每一层页面的排序以及页面中记录的排序),我们把这种给自己感兴趣的列建立的索引称作二级索引或者辅助索引。二级索引的叶子节点中只存放建立索引时指定的列的值以及该记录对应的主键值。

小结一下

下边的小结并不仅仅针对聚簇索引,也针对二级索引。我们将用键值来表示聚簇索引中的主键值或者二级索引中的二级索引列值。

记录是按照键值大小组成一个单向链表的。

记录是被存放在页面中的,页面中维护着一个页目录结构,通过页目录可以对键值进行二分查找,从而加快在单个页面中的查询速度。

多个页面可以按照键值大小组成双向链表,为了快速定位到需查找的键值在哪个页面中,我们引入了目录项记录以及存储目录项记录的页。

存储目录项记录的页大小也有限,我们引入了更高层次的目录项记录,从而形成了套娃结构。我们把这个套娃结构称作

B+树,也就是InnoDB中的索引。

好了,前6章的整体脉络就是上边这些了,大家抓住这些主线,然后进行针对性的阅读,补充更多的细节。一旦理解了这个脉络,之后想忘也忘不掉了。

MySQL的server层和存储引擎层是如何交互的

标签: 公众号文章

SQL的全称是Structured Query Language,翻译成中国话就是结构化查询语言。这是一种声明式的语法,何为声明式?可以联想一下我们生活中的老板,老板在布置任务的时候会告诉你:小王啊,今天把这些砖从A地搬到B地啊,然后就没然后了。老板并不关心你是用手抬,还是用车拉,老板只关心结果:你把砖搬过去就好了。我们之于数据库而言,就是一个老板,SQL语句就是我们给数据库下达的任务,至于具体数据库怎么执行我们并不关心,我们只关心最后数据库给我们返回的结果。

对于设计数据库的人而言,语句怎么执行就得好好考虑了,老板不操心,事儿总还得干。设计MySQL的大叔人为的把MySQL分为server层和存储引擎层,但是什么操作是在server层做的,什么操作是在存储引擎层做的大家可能有些迷糊。本文将以一个实例来展示它们二者各自负责的事情。

准备工作

为了故事的顺利发展,我们先创建一个表:

CREATE TABLE hero (id INT,name VARCHAR(100),country varchar(100),PRIMARY KEY (id),KEY idx_name (name)) Engine=InnoDB CHARSET=utf8;

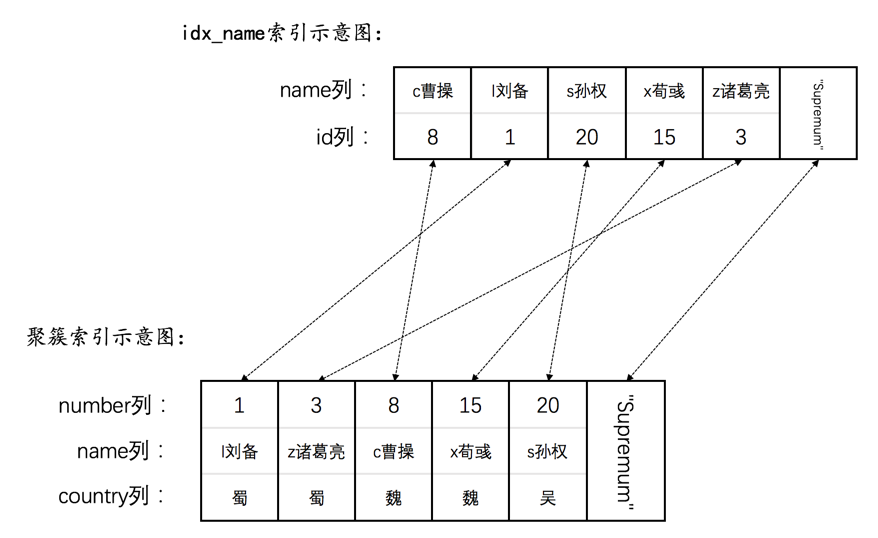

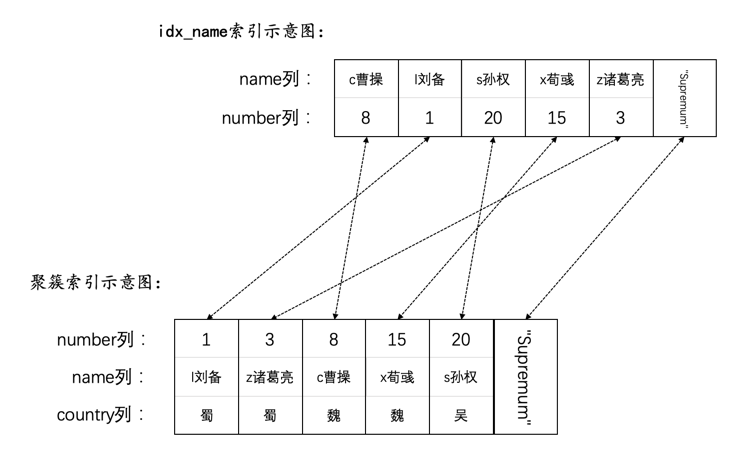

我们为hero表的id列创建了聚簇索引,为name列创建了一个二级索引。这个hero表主要是为了存储三国时的一些英雄,我们向表中插入一些记录:

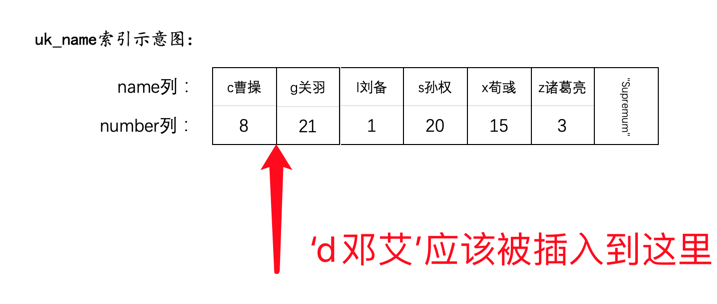

INSERT INTO hero VALUES(1, 'l刘备', '蜀'),(3, 'z诸葛亮', '蜀'),(8, 'c曹操', '魏'),(15, 'x荀彧', '魏'),(20, 's孙权', '吴');

现在表中的数据就是这样的:

mysql> SELECT * FROM hero;+----+------------+---------+| id | name | country |+----+------------+---------+| 1 | l刘备 | 蜀 || 3 | z诸葛亮 | 蜀 || 8 | c曹操 | 魏 || 15 | x荀彧 | 魏 || 20 | s孙权 | 吴 |+----+------------+---------+5 rows in set (0.00 sec)

准备工作就做完了。

正文

一条语句在执行之前需要生成所谓的执行计划,也就是该语句将采用什么方式来执行(使用什么索引,采用什么连接顺序等等),我们可以通过Explain语句来查看这个执行计划,比方说对于下边语句来说:

mysql> EXPLAIN SELECT * FROM hero WHERE name < 's孙权' AND country = '蜀';+----+-------------+-------+------------+-------+---------------+----------+---------+------+------+----------+------------------------------------+| id | select_type | table | partitions | type | possible_keys | key | key_len | ref | rows | filtered | Extra |+----+-------------+-------+------------+-------+---------------+----------+---------+------+------+----------+------------------------------------+| 1 | SIMPLE | hero | NULL | range | idx_name | idx_name | 303 | NULL | 2 | 20.00 | Using index condition; Using where |+----+-------------+-------+------------+-------+---------------+----------+---------+------+------+----------+------------------------------------+1 row in set, 1 warning (0.03 sec)

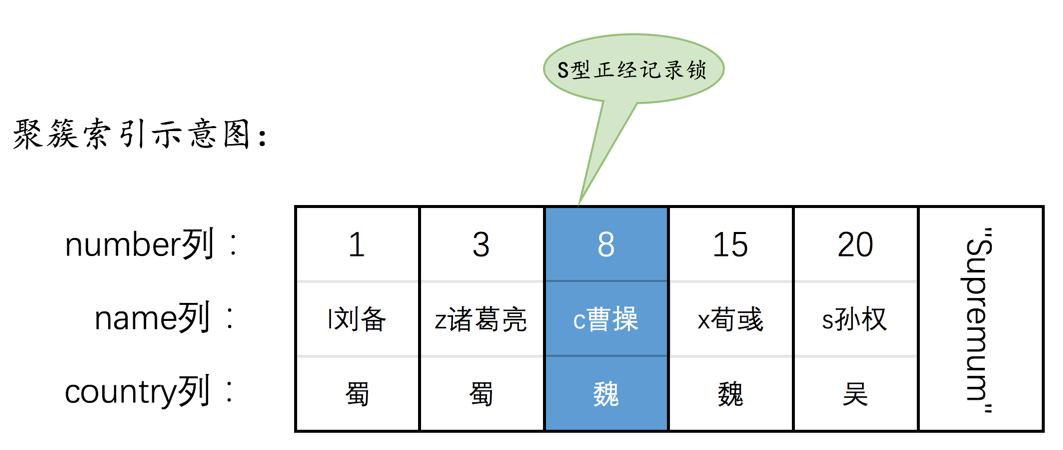

输出结果的key列值为idx_name,type列的值为range,表明会针对idx_name二级索引进行一个范围查询。很多同学在这里有一个疑惑:到底是一次性把所有符合条件的二级索引都取出来之后再统一进行回表操作,还是每从二级索引中取出一条符合条件的记录就进行回表一次?其实server层和存储引擎层的交互是以记录为单位的,上边这个语句的完整执行过程就是这样的:

server层第一次开始执行查询,把条件

name < 's孙权'交给存储引擎,让存储引擎定位符合条件的第一条记录。存储引擎在二级索引

idx_name中定位name < 's孙权'的第一条记录,很显然第一条符合该条件的二级索引记录的name列的值为'c曹操'。然后需要注意,我们看到EXPLAIN语句的输出结果的Extra列有一个Using index condition的提示,这表明会将有关idx_name二级索引的查询条件放在存储引擎层判断一下,这个特性就是所谓的索引条件下推(Index Condition Pushdown,简称ICP)。很显然这里的ICP条件就是name < 's孙权'。有的同学可能会问这不就是脱了裤子放屁么,name值为'c曹操'的这条记录就是通过name < 's孙权'这个条件定位的,为啥还要再判断一次?这就是设计MySQL 的大叔的粗暴设计,十分简单,没有为啥~小贴士:对于使用二级索引进行等值查询的情况有些许不同,比方说上边的条件换成`name = 's孙权'`,对于等值查询的这种情况,设计MySQL的大叔在InnoDB存储引擎层有特殊的处理方案,是不作为ICP条件进行处理的。

然后拿着该二级索引记录中的主键值去回表,把完整的用户记录都取到之后返回给

server层(也就是说得到一条二级索引记录后立即去回表,而不是把所有的二级索引记录都拿到后统一去回表)。我们的执行计划输出的

Extra列有一个Using Where的提示,意味着server层在接收到存储引擎层返回的记录之后,接着就要判断其余的WHERE条件是否成立(就是再判断一下country = '蜀'是否成立)。如果成立的话,就直接发送给客户端。小贴士:什么?发现一条记录符合条件就发送给了客户端?那为什么我的客户端不是一条一条的显示查询结果,而是一下子全部展示呢?这是客户端软件的鬼,人家规定在接收完全部的记录之后再展示而已。

如果不成立的话,就跳过该条记录。

接着server层向存储引擎层要求继续读刚才那条记录的下一条记录。

因为每条记录的头信息中都有

next_record的这个属性,所以可以快速定位到下一条记录的位置,然后继续判断ICP条件,然后进行回表操作,存储引擎把下一条记录取出后就将其返回给server层。然后重复第3步的过程,直到存储引擎层遇到了不符合

name < 's孙权'的记录,然后向server层返回了读取完毕的信息,这时server层将结束查询。

这个过程用语言描述还是有点儿啰嗦,我们写一个超级简化版的伪代码来瞅瞅(注意,是超级简化版):

first_read = true; //是否是第一次读取while (true) {if (first_read) {first_read = false;err = index_read(...); //调用存储引擎接口,定位到第一条符合条件的记录;} else {err = index_next(...); //调用存储引擎接口,读取下一条记录}if (err = 存储引擎的查询完毕信息) {break; //结束查询}if (是否符合WHERE条件) {send_data(); //将该记录发送给客户端;} else {//跳过本记录}}

上述的伪代码虽然很粗糙,但也基本表明了意思哈~ 之后有机会我们再唠叨唠叨使用临时表的情况已经使用filesort的情况是怎么执行的。

MySQL查询成本和扫描区间(MySQL中IS NULL、IS NOT NULL、!=不能用索引?胡扯!)

标签: 公众号文章

前情回顾

经过前面的学习我们知道了对于InnoDB存储引擎来说,表中的数据都存储在所谓的B+树中,我们每多建立一个索引,就相当于多建立一棵B+树。

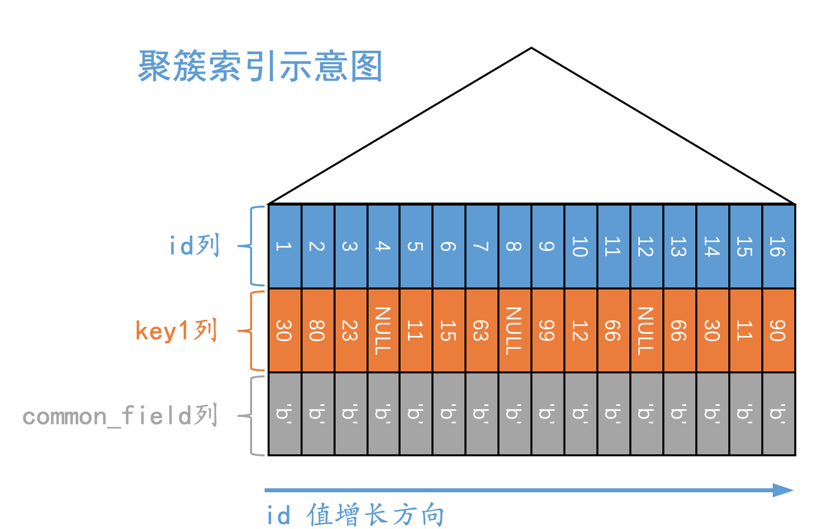

对于聚簇索引对应的B+树来说,叶子节点处存储了完整的用户记录(所谓完整用户记录,就是指一条聚簇索引记录中包含所有用户定义的列已经一些内建的列),并且这些聚簇索引记录按照主键值从小到大排序。

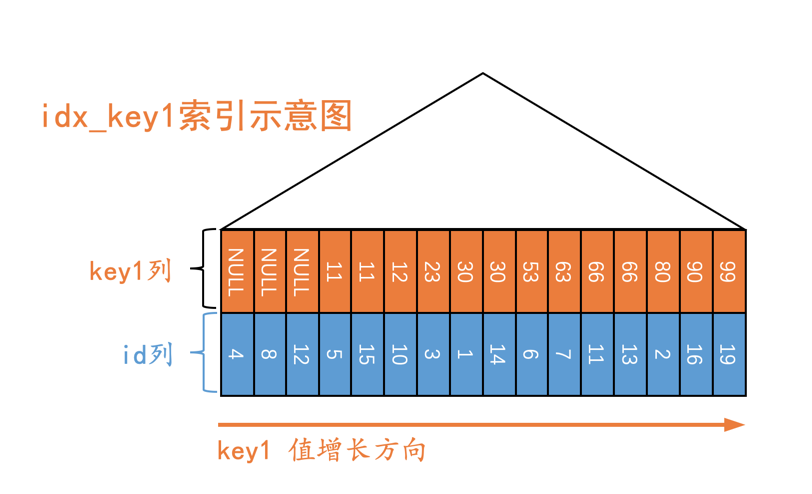

对于二级索引对应的B+树来说,叶子节点处存储了不完整的用户记录(所谓不完整用户记录,就是指一条二级索引记录只包含索引列和主键),并且这些二级索引记录按照索引列的值从小到大排序。

我们向表中存储了多少条记录,每一棵B+树的叶子节点中就包含多少条记录(注意是“每一棵”,包括聚簇索引对应的B+树以及二级索引对应的B+树)。

示例

我们举个例子:

CREATE TABLE t (id INT UNSIGNED NOT NULL AUTO_INCREMENT,key1 INT,common_field VARCHAR(100),PRIMARY KEY (id),KEY idx_key1 (key1)) Engine=InnoDB CHARSET=utf8;

这个表就包含2个索引(也就是2棵B+树):

以

id列为主键对应的聚簇索引。为

key1列建立的二级索引idx_key1。

我们向表中插入一些记录:

INSERT INTO t VALUES(1, 30, 'b'),(2, 80, 'b'),(3, 23, 'b'),(4, NULL, 'b'),(5, 11, 'b'),(6, 53, 'b'),(7, 63, 'b'),(8, NULL, 'b'),(9, 99, 'b'),(10, 12, 'b'),(11, 66, 'b'),(12, NULL, 'b'),(13, 66, 'b'),(14, 30, 'b'),(15, 11, 'b'),(16, 90, 'b');

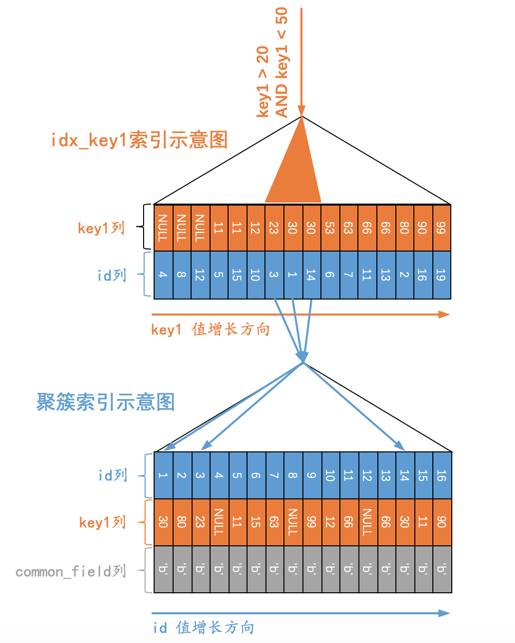

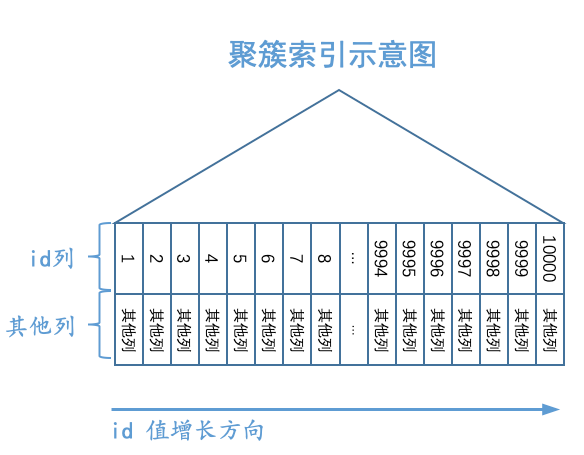

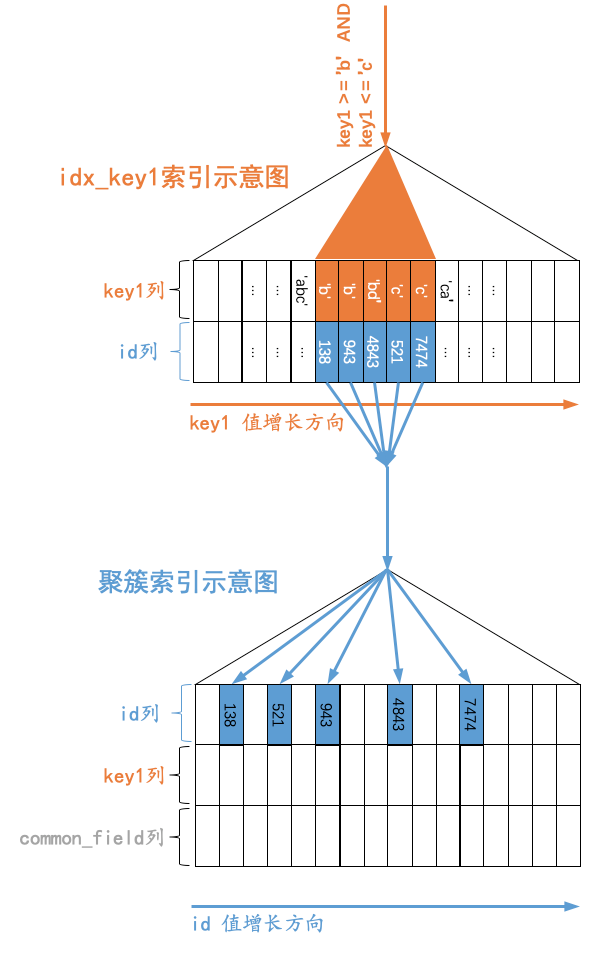

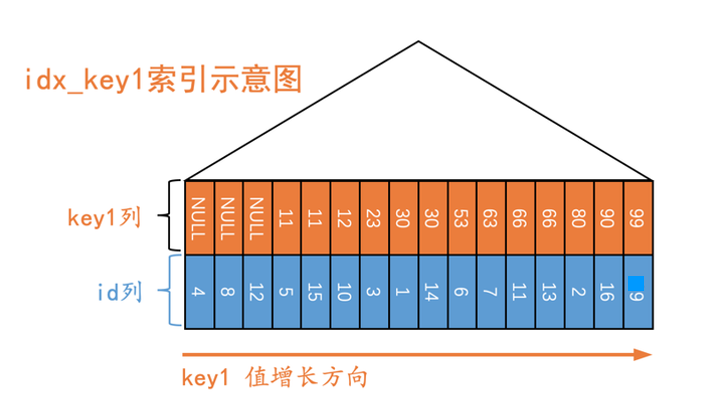

所以现在s1表的聚簇索引示意图就是这样:

s1表的二级索引示意图就是这样:

从图中可以看出,值为NULL的二级索引记录都被放到了B+树的最左边,这是因为设计InnoDB的大叔们有规定:

We define the SQL null to be the smallest possible value of a field.

也就是认为NULL值是最小的。

小贴士:

原谅我们把B+树的结构做了一个如此这般的简化,我们省略了页面的结构,省略了所有的内节点(只画了了三角形替代),省略了记录之间的链表,因为这些不是本文的重点,画成如果所示的样子只是为了突出叶子节点处的记录是按照给定索引的键值进行排序的。

查询是怎么执行的

比方说我们现在执行下边这个查询语句:

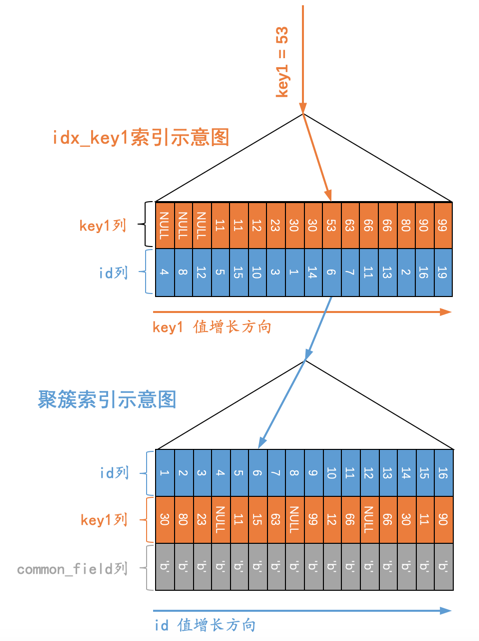

SELECT * FROM t WHERE key1 = 53;

那么语句的执行过程就如下图所示:

用文字描述一下这个过程也就是:

先通过二级索引

idx_key1对应的B+树快速定位到key1列值为53的那条二级索引记录。然后通过二级索引记录上的主键值,也就是

6到执行回表操作,也就是到聚簇索引中再找到id列值为6的聚簇索引记录。

小贴士:

B+树叶子节点中的记录都是按照键值按照从小到大的顺序排好序的,通过B+树索引定位到叶子节点中的一条记录是非常快速的。

像下边这个查询:

SELECT * FROM t WHERE key1 > 20 AND key1 < 50;

它的执行示意图就是这样:

用文字表述就是这样:

先通过二级索引

idx_key1对应的B+树快速定位到满足key1 > 20的第一条记录,也就是我们图中所示的key1值为23的那条记录,然后根据该二级索引中的主键值3执行回表操作,得到完整的用户记录后发送到客户端。然后根据上一步骤中获取到的

key1列值为23的二级索引记录的next_record属性,找到紧邻着的下一条二级索引记录,也就是key1列值为30的记录,然后执行回表操作,得到完整用户记录后发送到客户端。然后再找上一步骤中获取到的

key1列值为30的二级索引记录的下一条记录,该记录的key1列值也为30,继续执行回表操作将完整的用户记录发送到客户端。然后再找上一步骤中获取到的

key1列值为30的二级索引记录的下一条记录,该记录的key1列值为53,不满足key1 < 50的条件,所以查询就此终止。

从上边的步骤中也可以看出来:需要扫描的二级索引记录越多,需要执行的回表操作也就越多。如果需要扫描的二级索引记录占全部记录的比例达到某个范围,那优化器就可能选择使用全表扫描的方式执行查询(一个极端的例子就是扫描全部的二级索引记录,那么将对所有的二级索引记录执行回表操作,显然还不如直接全表扫描)。

所以现在的结论就是:判定某个查询是否可以使用索引的条件就是需要扫描的二级索引记录占全部记录的比例是否比较低,较低的话说明成本较低,那就可以使用二级索引来执行查询,否则要采用全表扫描。

扫描区间和边界条件

对于下边这个查询来说:

SELECT * FROM t WHERE key1 > 20 AND key1 < 50;

如果我们使用idx_key1执行该查询的话,那么就需要扫描key1值在(20, 50)这个区间中的所有二级索引记录,我们就把(20, 50)称作使用idx_key1执行上述查询时的扫描区间,把key1 > 20 AND key1 < 50称作形成该扫描区间的边界条件。

只要索引列和常数使用=、<=>、IN、NOT IN、IS NULL、IS NOT NULL、>、<、>=、<=、BETWEEN、!=或者LIKE操作符连接起来,就可以产生所谓的扫描区间。这里头有一些比较容易让人忽略的扫描区间:

IN操作符的语义和若干个等值匹配操作符=之间用OR连接起来的语义是一样的,它们都会产生多个单点扫描区间,比如下边这两个语句的语义上的效果是一样的:SELECT * FROM single_table WHERE key1 IN ('a', 'b');SELECT * FROM single_table WHERE key1 = 'a' OR key1 = 'b';

!=产生的扫描区间比较有趣,也容易被大家忽略,比如:SELECT * FROM single_table WHERE key1 != 'a';

此时使用idx_key1执行查询时对应的扫描区间就是:

(-∞, 'a')和('a', +∞)。LIKE操作符比较特殊,只有在匹配完整字符串或者匹配字符串前缀时才可以产生合适的扫描区间。比较字符串的大小其实就相当于依次比较每个字符的大小,那么:

先比较字符串的第一个字符,第一个字符小的那个字符串就比较小。

如果两个字符串的第一个字符相同,再比较第二个字符,第二个字符比较小的那个字符串就比较小。

如果两个字符串的前两个字符都相同,那就接着比较第三个字符;依此类推。

对于某个索引列来说,字符串前缀相同的记录肯定是相邻的。比方说我们有一个搜索条件是

key1 LIKE 'a%',而对于二级索引idx_key1来说,所有字符串前缀为'a'的二级索引记录肯定是相邻的,这也就意味着我们只要定位到第一条key1值的字符串前缀为'a'的记录,然后就可以沿着记录所在的单向链表向后扫描,直到某条二级索引记录的字符串前缀不为'a'为止很显然,

key1 LIKE 'a%'形成的扫描区间相当于是['a', 'b') (注意,这里是相当于,其实里边还有一些曲折的故事我们没说)。

其实对于任何查询语句来说,优化器都会按照下边的思路去判断该使用何种方式执行查询:

分析使用不同索引执行查询时对应的扫描区间都是什么。

采用某些手段来分析以下在使用扫描不同索引的扫描区间时对应的成本分别是多少。

小贴士:

我们这里定性的分析成本,而不是定量分析,定量分析可以到书中具体查看。大家粗略的认为扫描区间中的记录越多,成本就越高就好了。比较使用不同索引执行查询的成本以及全表扫描的成本哪个更低,选择成本最低的那个方案去执行查询,这个方案就是所谓的

执行计划。

具体的查询条件分析

我们分别看一下WHERE子句中出现IS NULL、IS NOT NULL、!=这些条件时优化器是怎么做决策的。

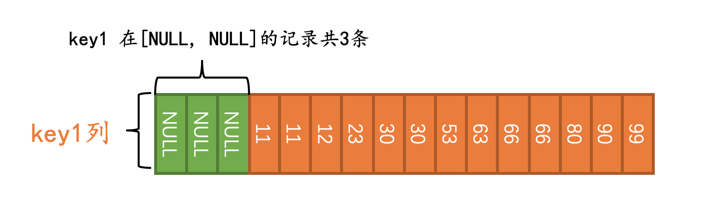

IS NULL的情况

比方说这个查询:

SELECT * FROM t WHERE key1 IS NULL;

优化器在真正执行查询前,会首先少量的访问一下索引,调查一下key1在[NULL, NULL]这个区间的记录有多少条:

小贴士:

[NULL, NULL]这个区间代表区间里只有一个NULL值。

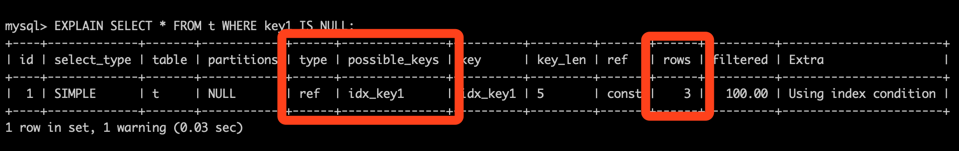

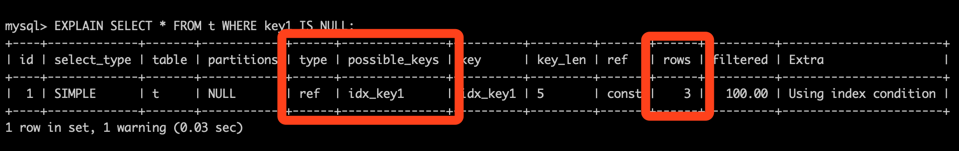

优化器经过调查得知,需要扫描的二级索引记录占总记录条数的比例是3/16,它觉得这个查询使用二级索引来执行比较靠谱,所以在执行计划中就显示使用这个idx_key1来执行查询:

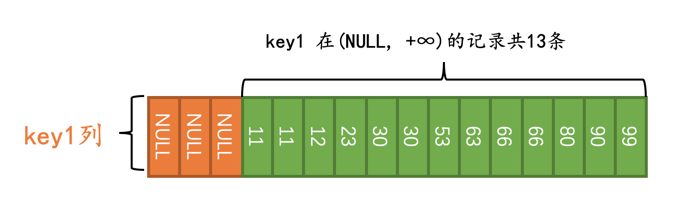

IS NOT NULL的情况

比方说这个查询:

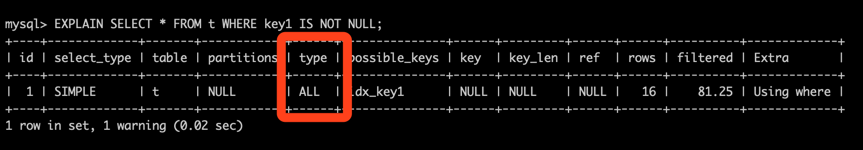

SELECT * FROM t WHERE key1 IS NOT NULL;

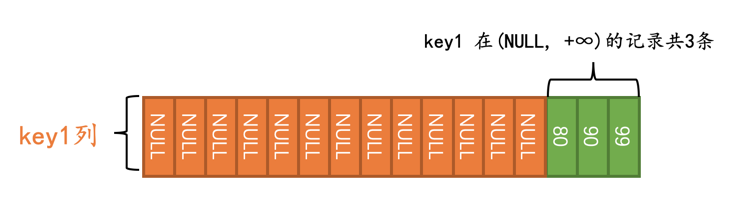

优化器在真正执行查询前,会首先少量的访问一下索引,调查一下key1在(NULL, +∞)这个区间内记录有多少条:

小贴士:

我们这里把NULL当作是最小值对待,你可以认为它比-∞都小。另外注意区间(NULL, +∞)是开区间,也就意味这不包括NULL值。

优化器经过调查得知,需要扫描的二级索引记录占总记录条数的比例是13/16,跟显然这个比例已经非常大了,所以优化器决定使用全表扫描的方式来执行查询:

那怎么才能让使用IS NOT NULL条件的查询使用到二级索引呢?这还不简单,让表中符合IS NOT NULL条件的记录少不就行了,我们可以执行一下:

UPDATE t SET key1 = NULL WHERE key1 < 80;

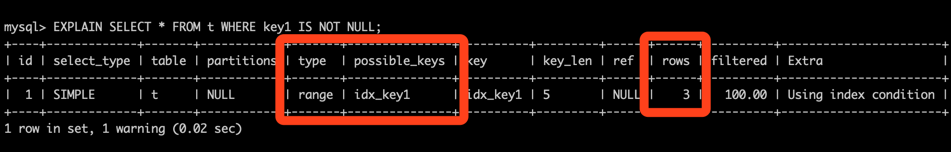

这样再去执行这个查询:

SELECT * FROM t WHERE key1 IS NOT NULL;

优化器在真正执行查询前,会首先少量的访问一下索引,调查一下key1在(NULL, +∞)这个区间内记录有多少条::

优化器经过调查得知,需要扫描的二级索引记录占总记录条数的比例是3/16,它觉得这个查询使用二级索引来执行比较靠谱,所以在执行计划中就显示使用这个idx_key1来执行查询:

!= 的情况

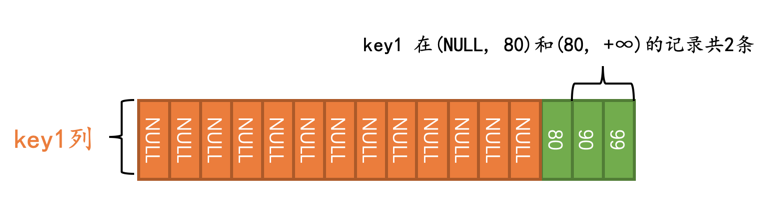

比方说这个查询:

SELECT * FROM t WHERE key1 != 80;

优化器在真正执行查询前,会首先少量的访问一下索引,调查一下key1在(NULL, 80)和(80, +∞)这两个区间内记录有多少条:

优化器经过调查得知,需要扫描的二级索引记录占总记录条数的比例是2/16,它觉得这个查询使用二级索引来执行比较靠谱,所以在执行计划中就显示使用这个idx_key1来执行查询:

且慢!为啥执行计划的rows列的值为3呢???这是个什么鬼,明明只有2条记录符合条件嘛。哈哈,我们罗列一下每个区间找到的符合条件的记录数量:

(NULL, 80)区间中有0条记录满足条件key1 != 80。(80, +∞)区间中有2条记录满足条件key1 != 80。

可是设计优化器的大叔在这里有个规定:当某个扫描区间符合给定条件的记录数量为0时,硬生生的把它掰成1。也就是说实际优化器认为在(NULL, 80)这个扫描区间中有1条记录符合条件key1 != 80。所以执行计划的rows列才显示了3。

小贴士:

下边是设计优化器的大叔自己对当某个扫描区间符合给定条件的记录数量为0时硬生生的把它掰成1的解释(能看懂的就看,看不懂赶紧跳过):

The MySQL optimizer seems to believe an estimate of 0 rows is always accurate and may return the result 'Empty set' based on that. The accuracy is not guaranteed, and even if it were, for a locking read we should anyway perform the search to set the next-key lock. Add 1 to the value to make sure MySQL does not make the assumption!

总结

至此,我们分别分析了拥有IS NULL、IS NOT NULL、!=这三个条件的查询是在什么情况下使用二级索引来执行的,核心结论就是:成本决定执行计划,跟使用什么查询条件并没有什么关系。优化器会首先针对可能使用到的二级索引划分几个扫描区间,然后分别调查这些区间内有多少条记录,在这些扫描区间内的二级索引记录的总和占总共的记录数量的比例达到某个值时,优化器将放弃使用二级索引执行查询,转而采用全表扫描。

小贴士:

其实扫描区间划分的太多也会影响优化器的决策,比方说IN条件中有太多个参数,将会降低优化器决定使用二级索引执行查询的几率。

另外,优化器调查在某个扫描区间内的索引记录的条数的方式有两种,一种是所谓的index dive(这种方式在数据少的时候是精确的,在数据多时会有些偏差),一种是依赖index statistics,也就是统计数据来做调查(这种方式的统计是很不精确的,有时候偏差是超级巨大的),反正不论采用哪种方式,优化器都会将各个扫描区间中的索引记录数量给计算出来。关于这两种调查方式在《MySQL是怎样运行:从根儿上理解MySQL》中都给出了详细的算法,当然都占用了相当大的篇幅,写在公众号文章里就有点杀鸡用牛刀了。

听说有一个最左原则?这回终于讲清楚了

标签: 公众号文章

准备工作

为了故事的顺利发展,我们需要先建立一个表:

CREATE TABLE single_table (id INT NOT NULL AUTO_INCREMENT,key1 VARCHAR(100),key2 INT,key3 VARCHAR(100),key_part1 VARCHAR(100),key_part2 VARCHAR(100),key_part3 VARCHAR(100),common_field VARCHAR(100),PRIMARY KEY (id),KEY idx_key1 (key1),UNIQUE KEY uk_key2 (key2),KEY idx_key3 (key3),KEY idx_key_part(key_part1, key_part2, key_part3)) Engine=InnoDB CHARSET=utf8;

我们为这个single_table表建立了1个聚簇索引和4个二级索引,分别是:

为id列建立的聚簇索引。

为key1列建立的idx_key1二级索引。

为key2列建立的uk_key2二级索引,而且该索引是唯一二级索引。

为key3列建立的idx_key3二级索引。

为key_part1、key_part2、key_part3列建立的idx_key_part二级索引,这也是一个联合索引。

然后我们需要为这个表插入10000行记录,除id列外其余的列都插入随机值就好了,具体的插入语句我就不写了,自己写个程序插入吧(id列是自增主键列,不需要我们手动插入)。

我们画一下single_table表的聚簇索引的示意图:

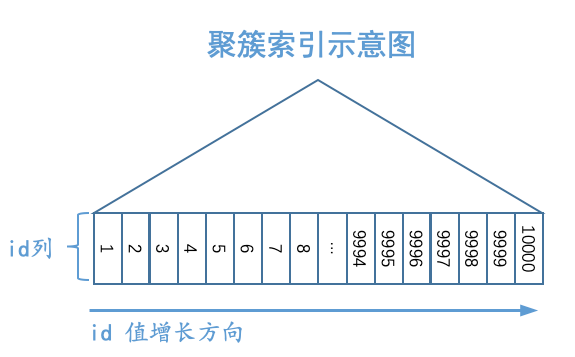

如图所示,我们把聚簇索引对应的复杂的B+树结构搞了一个极度精简版。可以看到,我们忽略掉了页的结构,直接把所有的叶子节点中的记录都放在一起展示,为了方便,我们之后就把聚簇索引叶子节点中的记录称为聚簇索引记录。虽然这个图很简陋,但是我们还是突出了聚簇索引一个非常重要的特点:聚簇索引记录是按照主键值由小到大的顺序排序的。当然,追求视觉上极致简洁的我们觉得图中的“其他列”也可以被略去,只需要保留id列即可,再次简化的B+树示意图就如下所示:

好了,再不能简化了,再简化就要把id列也删去了,就剩一个三角形了,那就真尴尬了。

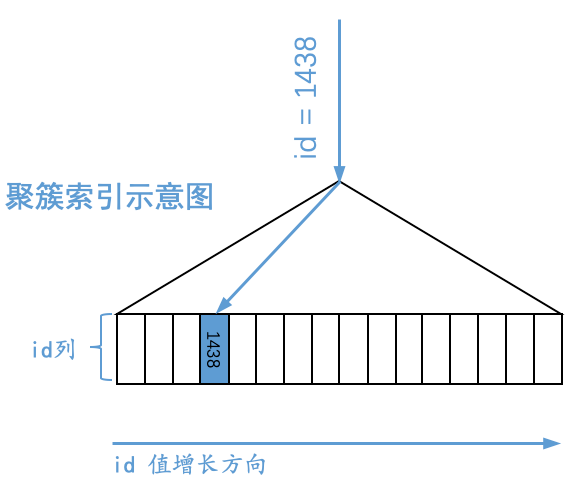

通过聚簇索引对应的B+树,我们可以很容易的定位到主键值等于某个值的聚簇索引记录,比方说我们想通过这个B+树定位到id值为1438的记录,那么示意图就如下所示:

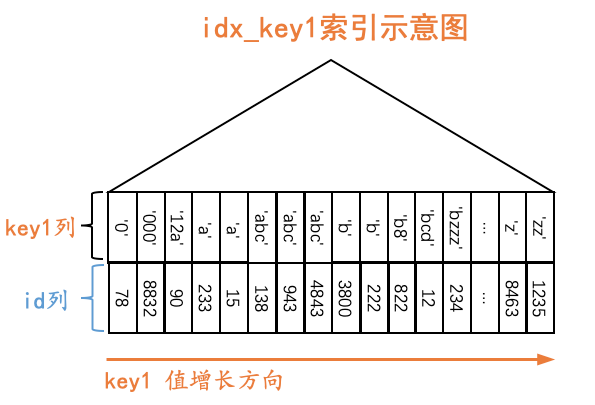

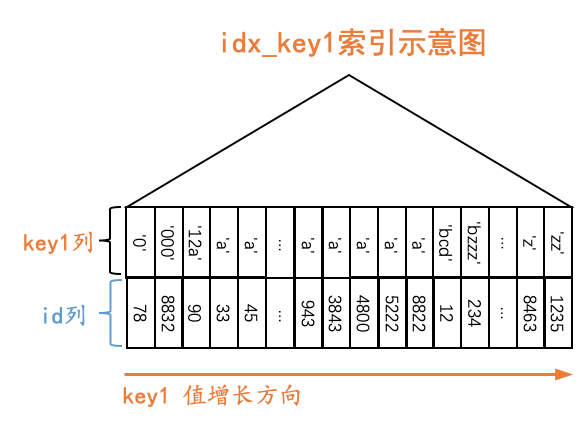

下边以二级索引idx_key1为例,画一下二级索引简化后的B+树示意图:

如图所示,我们在二级索引idx_key1对应的B+树中保留了叶子节点的记录,这些记录包括key1列以及id列,这些记录是按照key1列的值由小到大的顺序排序的,如果key1列的值相同,则按照id列的值进行排序。为了方便,我们之后就把二级索引叶子节点中的记录称为二级索引记录。

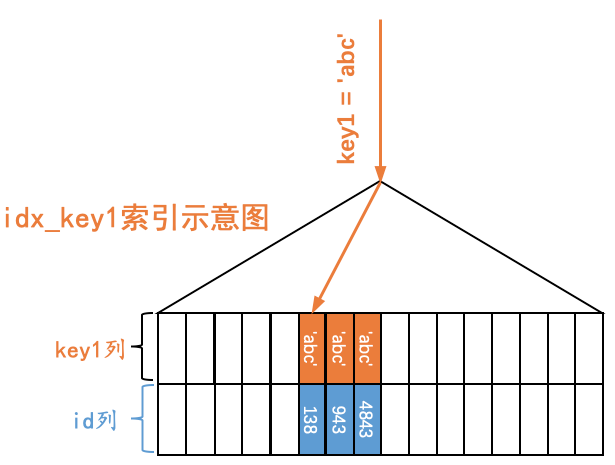

如果我们想查找key1值等于某个值的二级索引记录,那么可以通过idx_key1对应的B+树,很容易的定位到第一条key1列的值等于某个值的二级索引记录,然后沿着记录所在单向链表向后扫描即可。比方说我们想通过这个B+树定位到第一条key1值为'abc'的记录,那么示意图就如下所示:

扫描区间和边界条件

对于某个查询来说,最粗暴的执行方案就是扫描表中的所有记录,针对每一条记录都判断一下该记录是否符合搜索条件,如果符合的话就将其发送到客户端,否则就跳过该记录。这种执行方案也被称为全表扫描。对于使用InnoDB存储引擎的表来说,全表扫描意味着从聚簇索引第一个叶子节点的第一条记录开始,沿着记录所在的单向链表向后扫描,直到最后一个叶子节点的最后一条记录为止。虽然全表扫描是一种很笨的执行方案,但却是一种万能的执行方案,所有的查询都可以使用这种方案来执行。

我们之前介绍了利用B+树查找索引列值等于某个值的记录,这样可以明显减少需要扫描的记录数量。其实由于B+树的叶子节点中的记录是按照索引列值由小到大的顺序排序的,所以我们只扫描在某个区间或者某些区间中的记录也可以明显减少需要扫描的记录数量。比方说对于下边这个查询语句来说:

SELECT * FROM single_table WHERE id >= 2 AND id <= 100;

这个语句其实是想查找所有id值在[2, 100]这个区间中的聚簇索引记录,那么我们就可以通过聚簇索引对应的B+树快速地定位到id值为2的那条聚簇索引记录,然后沿着记录所在的单向链表向后扫描,直到某条聚簇索引记录的id值不在[2, 100]这个区间中为止(其实也就是直到id值不符合id<=100这个条件为止)。与扫描全部的聚簇索引记录相比,扫描id值在[2, 100]这个区间中的记录已经很大程度的减少了需要扫描的记录数量,所以提升了查询效率。为简便起见,我们把这个例子中需要扫描的记录的id值所在的区间称为扫描区间,把形成这个扫描区间的查询条件,也就是id >= 2 AND id <= 100称为形成这个扫描区间的边界条件。

小贴士:其实对于全表扫描来说,相当于我们需要扫描id值在(-∞, +∞)这个区间中的记录,也就是说全表扫描对应的扫描区间就是(-∞, +∞)。

对于下边这个查询:

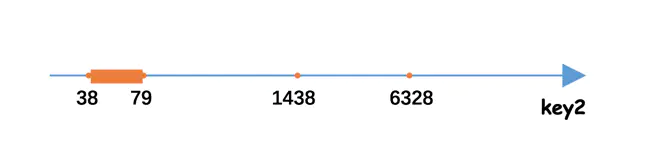

SELECT * FROM single_table WHERE key2 IN (1438, 6328) OR (key2 >= 38 AND key2 <= 79);

我们当然可以直接使用全表扫描的方式执行该查询,但是观察到该查询的搜索条件涉及到了key2列,而我们又正好为key2列建立了uk_key2索引,如果我们使用uk_key2索引执行这个查询的话,那么相当于从下边的三个扫描区间中获取二级索引记录:

- [1438, 1438],对应的边界条件就是key2 IN (1438)

- [6328, 6328],对应的边界条件就是key2 IN (6328)

- [38, 79],对应的边界条件就是key2 >= 38 AND key2 <= 79

这些扫描区间对应到数轴上的示意图就如下图所示:

为方便起见,我们把像[1438, 1438]、[6328, 6328]这样只包含一个值的扫描区间称为单点扫描区间,把[38, 79]这样包含多个值的扫描区间称为范围扫描区间。另外,由于我们的查询列表是*,也就是需要读取完整的用户记录,所以从上述的扫描区间中每获取一条二级索引记录时,就需要根据该二级索引记录的id列的值执行回表操作,也就是到聚簇索引中找到相应的聚簇索引记录。

小贴士:其实我们不仅仅可以使用uk_key2执行上述查询,使用idx_key1、idx_key3、idx_keypart都可以执行上述查询。以idx_key1为例,很显然我们无法通过搜索条件形成合适的扫描区间来减少需要扫描的idx_key二级索引记录数量,只能扫描idx_key1的全部二级索引记录。针对获取到的每一条二级索引记录,都需要执行回表操作来获取完整的用户记录。我们也可以说此时使用idx_key1执行查询时对应的扫描区间就是(-∞, +∞)。这样子虽然行得通,但我们图啥呢?最粗暴的全表扫描方式已经要扫描全部的聚簇索引记录了,你这里除了要访问全部的聚簇索引记录,还要扫描全部的idx_key1二级索引记录,这不是费力不讨好么。在这个过程中没有减少需要扫描的记录数量,反而效率比全表扫描更差,所以如果我们想使用某个索引来执行查询,但是又无法通过搜索条件形成合适的扫描区间来减少需要扫描的记录数量时,那么我们是不考虑使用这个索引执行查询的。

并不是所有的搜索条件都可以成为边界条件,比方说下边这个查询:

SELECT * FROM single_table WHERE key1 < 'a' AND key3 > 'z' AND common_field = 'abc';

那么:

如果我们使用idx_key1执行查询的话,那么相应的扫描区间就是(-∞, 'a'),形成该扫描区间的边界条件就是key1 < 'a',而key3 > 'z' AND common_field = 'abc'就是普通的搜索条件,这些普通的搜索条件需要在获取到idx_key1的二级索引记录后,再执行回表操作,获取到完整的用户记录后才能去判断它们是否成立。

如果我们使用idx_key3执行查询的话,那么相应的扫描区间就是('z', +∞),形成该扫描区间的边界条件就是key3 > 'z',而key1 < 'a' AND common_field = 'abc'就是普通的搜索条件,这些普通的搜索条件需要在获取到idx_key3的二级索引记录后,再执行回表操作,获取到完整的用户记录后才能去判断它们是否成立。

使用联合索引执行查询时对应的扫描区间

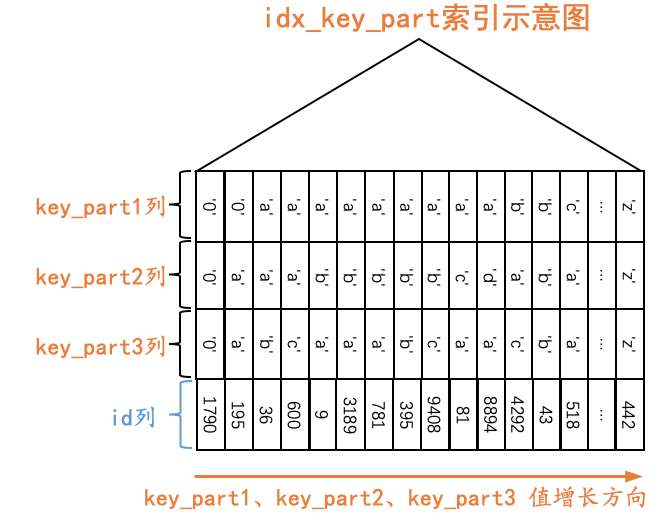

联合索引的索引列包含多个列,B+树每一层页面以及每个页面中的记录采用的排序规则较为复杂,以single_table表的idx_key_part联合索引为例,它采用的排序规则如下所示:

- 先按照key_part1列的值进行排序。

- 在key_part1列的值相同的情况下,再按照key_part2列的值进行排序。

- 在key_part1和key_part2列的值都相同的情况下,再按照key_part3列的值进行排序。

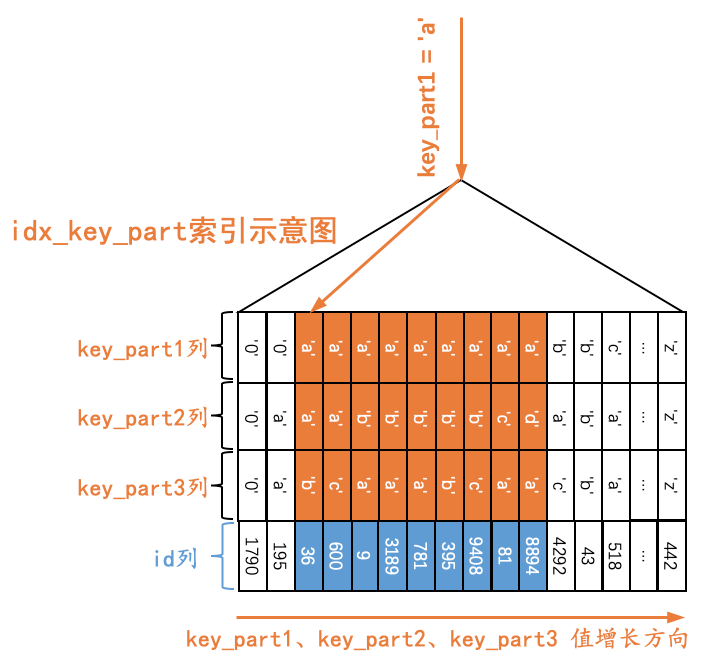

我们画一下idx_key_part索引的示意图:

对于下边这个查询Q1来说:

Q1:SELECT * FROM single_table WHERE key_part1 = 'a';

由于二级索引记录是先按照key_part1列的值进行排序的,所以所有符合key_part1 = 'a'条件的记录肯定是相邻的,我们可以定位到第一条符合key_part1 = 'a'条件的记录,然后沿着记录所在的单向链表向后扫描,直到某条记录不符合key_part1 = 'a'条件为止(当然,对于获取到的每一条二级索引记录都要执行回表操作,我们这里就不展示回表操作了),如下图所示。

也就是说,如果我们使用idx_key_part索引执行查询Q1时,对应的扫描区间就是['a', 'a'],形成这个扫描区间的条件就是key_part1 = 'a'。

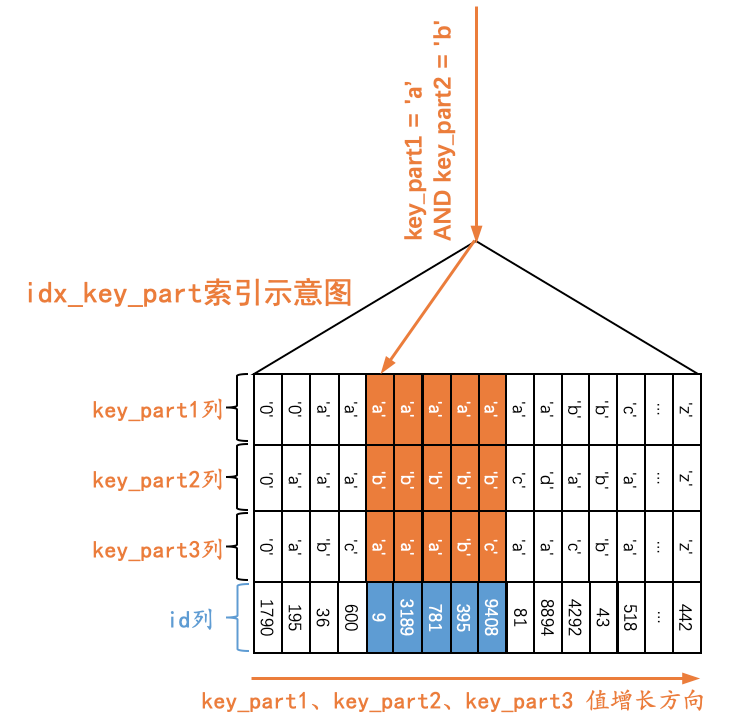

对于下边这个查询Q2来说:

Q2:SELECT * FROM single_table WHERE key_part1 = 'a' AND key_part2 = 'b';

由于二级索引记录是先按照key_part1列的值进行排序的;在key_part1列的值相等的情况下,再按照key_part2列进行排序。所以符合key_part1 = 'a' AND key_part2 = 'b'条件的二级索引记录肯定是相邻的,我们可以定位到第一条符合key_part1='a' AND key_part2='b'条件的记录,然后沿着记录所在的单向链表向后扫描,直到某条记录不符合key_part1='a'条件或者key_part2='b'条件为止(当然,对于获取到的每一条二级索引记录都要执行回表操作,我们这里就不展示回表操作了),如下图所示。

也就是说,如果我们使用idx_key_part索引执行查询Q2时,可以形成扫描区间[('a', 'b'), ('a', 'b')],形成这个扫描区间的条件就是key_part1 = 'a' AND key_part2 = 'b'。

对于下边这个查询Q3来说:

Q3:SELECT * FROM single_table WHERE key_part1 = 'a' AND key_part2 = 'b' AND key_part3 = 'c';

由于二级索引记录是先按照key_part1列的值进行排序的;在keypart1列的值相等的情况下,再按照key_part2列进行排序;在key_part1和key_part2列的值都相等的情况下,再按照key_part3列进行排序。所以符合key_part1 = 'a' AND key_part2 = 'b' AND key_part3 = 'c'条件的二级索引记录肯定是相邻的,我们可以定位到第一条符合key_part1='a' AND key_part2='b' AND key_part3='c'条件的记录,然后沿着记录所在的单向链表向后扫描,直到某条记录不符合key_part1='a'条件或者key_part2='b'条件或者key_part3='c'条件为止(当然,对于获取到的每一条二级索引记录都要执行回表操作),我们就不画示意图了。如果我们使用idx_key_part索引执行查询Q3时,可以形成扫描区间[('a', 'b', 'c'), ('a', 'b', 'c')],形成这个扫描区间的条件就是key_part1 = 'a' AND key_part2 = 'b' AND key_part3 = 'c'。

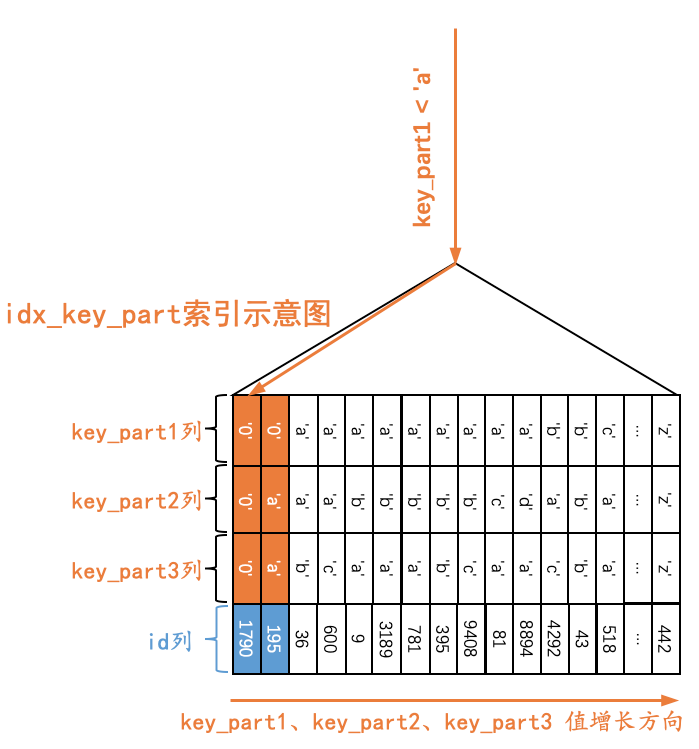

对于下边这个查询Q4来说:

Q4:SELECT * FROM single_table WHERE key_part1 < 'a';

由于二级索引记录是先按照key_part1列的值进行排序的,所以所有符合key_part1 < 'a'条件的记录肯定是相邻的,我们可以定位到第一条符合key_part1 < 'a'条件的记录(其实就是idx_key_part索引第一个叶子节点的第一条记录),然后沿着记录所在的单向链表向后扫描,直到某条记录不符合key_part1 < 'a'为止(当然,对于获取到的每一条二级索引记录都要执行回表操作,我们这里就不展示回表操作了),如下图所示。

也就是说,如果我们使用idx_key_part索引执行查询Q4时,可以形成扫描区间(-∞, 'a'),形成这个扫描区间的条件就是key_part1 < 'a'。

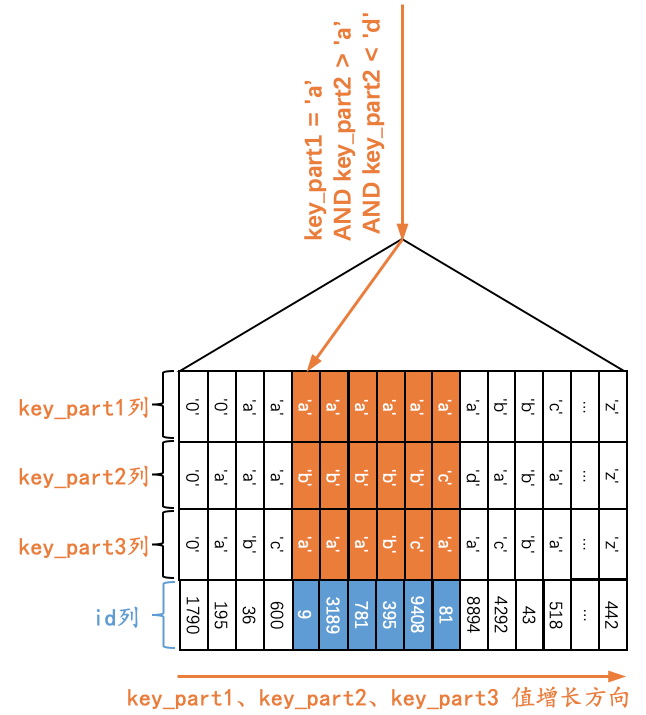

对于下边这个查询Q5来说:

Q5:SELECT * FROM single_table WHERE key_part1 = 'a' AND key_part2 > 'a' AND key_part2 < 'd';

由于二级索引记录是先按照key_part1列的值进行排序的;在key_part1列的值相等的情况下,再按照key_part2列进行排序。也就是说在符合key_part1 = 'a'条件的二级索引记录中,是按照key_part2列的值进行排序的,那么此时符合key_part1 = 'a' AND key_part2 > 'a' AND key_part2 < 'd'条件的二级索引记录肯定是相邻的。我们可以定位到第一条符合key_part1='a' AND key_part2 > 'a' AND key_part2 < 'c'条件的记录,然后沿着记录所在的单向链表向后扫描,直到某条记录不符合key_part1='a'条件或者key_part2 > 'a'条件或者key_part2 < 'd'条件为止(当然,对于获取到的每一条二级索引记录都要执行回表操作,我们这里就不展示回表操作了),如下图所示。

也就是说,如果我们使用idx_key_part索引执行查询Q5时,可以形成扫描区间(('a', 'a'), ('a', 'd')),形成这个扫描区间的条件就是key_part1 = 'a' AND key_part2 > 'a' AND key_part2 < 'd'。

对于下边这个查询Q6来说:

Q6:SELECT * FROM single_table WHERE key_part2 = 'a';

由于二级索引记录不是直接按照key_part2列的值排序的,所以符合key_part2 = 'a'的二级索引记录可能并不相邻,也就意味着我们不能通过这个key_part2 = 'a'搜索条件来减少需要扫描的记录数量。在这种情况下,我们是不会使用idx_key_part索引执行查询的。

对于下边这个查询Q7来说:

Q7:SELECT * FROM single_table WHERE key_part1 = 'a' AND key_part3 = 'c';

由于二级索引记录是先按照key_part1列的值进行排序的,所以符合key_part1 = 'a'条件的二级索引记录肯定是相邻的,但是对于符合key_part1 = 'a'条件的二级索引记录来说,并不是直接按照key_part3列进行排序的,也就是说我们不能根据搜索条件key_part3 = 'c'来进一步减少需要扫描的记录数量。那么如果我们使用idx_key_part索引执行查询的话,可以定位到第一条符合key_part1='a'条件的记录,然后沿着记录所在的单向链表向后扫描,直到某条记录不符合key_part1 = 'a'条件为止。所以在使用idx_key_part索引执行查询Q7的过程中,对应的扫描区间其实是['a', 'a'],形成该扫描区间的搜索条件是key_part1 = 'a',与key_part3 = 'c'无关。

小贴士:针对获取到的每一条二级索引记录,如果没有开启索引条件下推特性的话,则必须先进行回表操作,获取到完整的用户记录后再判断key_part3 = 'c'这个条件是否成立;如果开启了索引条件下推特性的话,可以立即判断该二级索引记录是否符合key_part3 = 'c'这个条件,如果符合则再进行回表操作,如果不符合则不进行回表操作,直接跳到下一条二级索引记录。索引条件下推特性是在MySQL 5.6中引入的,默认是开启的。

对于下边这个查询Q8来说:

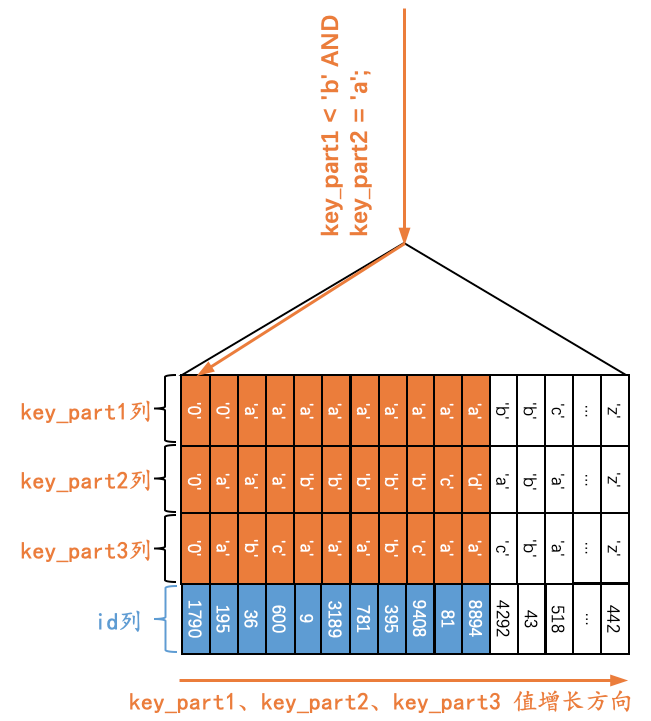

Q8:SELECT * FROM single_table WHERE key_part1 < 'b' AND key_part2 = 'a';

由于二级索引记录是先按照key_part1列的值进行排序的,所以符合key_part1 < 'b'条件的二级索引记录肯定是相邻的,但是对于符合key_part1 < 'b'条件的二级索引记录来说,并不是直接按照key_part2列进行排序的,也就是说我们不能根据搜索条件key_part2 = 'a'来进一步减少需要扫描的记录数量。那么如果我们使用idx_key_part索引执行查询的话,可以定位到第一条符合key_part1<'b'条件的记录(其实就是idx_key_part索引第一个叶子节点的第一条记录),然后沿着记录所在的单向链表向后扫描,直到某条记录不符合key_part1 < 'b'条件为止,如下图所示。

所以在使用idx_key_part索引执行查询Q8的过程中,对应的扫描区间其实是[-∞, 'b'),形成该扫描区间的搜索条件是key_part1 < 'b',与key_part2 = 'a'无关。

对于下边这个查询Q9来说:

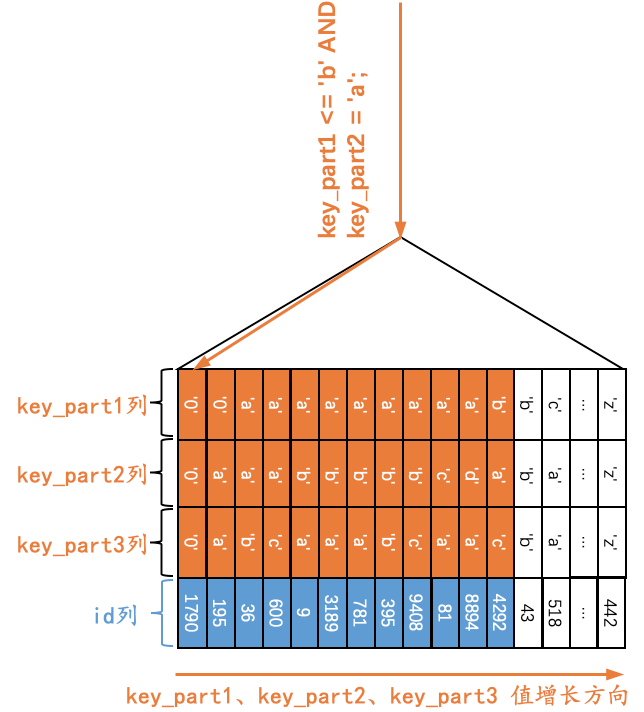

Q9:SELECT * FROM single_table WHERE key_part1 <= 'b' AND key_part2 = 'a';

很显然Q8和Q9长得非常像,只不过在涉及key_part1的条件中,Q8中的条件是key_part1 < 'b',Q9中的条件是key_part1 <= 'b'。很显然符合key_part1 <= 'b'条件的二级索引记录是相邻的,但是对于符合key_part1 <= 'b'条件的二级索引记录来说,并不是直接按照key_part2列进行排序的。但是,我这里说但是哈,对于符合key_part1 = 'b'的二级索引记录来说,是按照key_part2列的值进行排序的。那么我们在确定需要扫描的二级索引记录的范围时,当二级索引记录的key_part1列值为'b'时,我们也可以通过key_part2 = 'a'这个条件来减少需要扫描的二级索引记录范围,也就是说当我们扫描到第一条不符合 key_part1 = 'b' AND key_part2 = 'a'条件的记录时,就可以结束扫描,而不需要将所有key_part1列值为'b'的记录扫描完,示意图如下:

也就是说,如果我们使用idx_key_part索引执行查询Q9时,可以形成扫描区间((-∞, -∞), ('b', 'a')),形成这个扫描区间的条件就是key_part1 <= 'b' AND key_part2 = 'a'。对比查询Q8,我们必须将所有符合key_part1 < 'b'的记录都扫描完,key_part2 = 'a'这个条件在查询Q8中并不能起到减少需要扫描的二级索引记录范围的作用。

可能将查询Q9转换为下边的这个形式后更容易理解使用idx_key_part索引执行它时对应的扫描区间以及形成扫描区间的条件:

SELECT * FROM single_table WHERE (key_part1 < 'b' AND key_part2 = 'a') OR (key_part1 = 'b' AND key_part2 = 'a');

设计MySQL的大叔为何偏爱ref

标签(空格分隔): 公众号文章

回忆一下查询成本

对于一个查询来说,有时候可以通过不同的索引或者全表扫描来执行它,MySQL优化器会通过事先生成的统计数据,或者少量访问B+树索引的方式来分析使用各个索引时都需要扫描多少条记录,然后计算使用不同索引的查询成本,最后选择成本最低的那个来执行查询。

小贴士:我们之前称那种通过少量访问B+树索引来分析需要扫描的记录数量的方式称为index dive,不知道大家还有没有印象。

一个很简单的思想就是:使用某个索引执行查询时,需要扫描的记录越少,就越可能使用这个索引来执行查询。

创建场景

假如我们现在有一个表t,它的表结构如下所示:

CREATE TABLE t (id INT NOT NULL AUTO_INCREMENT PRIMARY KEY,key1 VARCHAR(100),common_field VARCHAR(100),INDEX idx_key1 (key1)) ENGINE=InnoDB CHARSET=utf8;

这个表包含3个列:

- id列是自增主键

- key1列用于存储字符串,我们为key1列建立了一个普通的二级索引

- common_field列用于存储字符串

现在该表中共有10000条记录:

mysql> SELECT COUNT(*) FROM t;+----------+| COUNT(*) |+----------+| 10000 |+----------+1 row in set (2.65 sec)

其中key1列为'a'的记录有2310条:

mysql> SELECT COUNT(*) FROM t WHERE key1 = 'a';+----------+| COUNT(*) |+----------+| 2310 |+----------+1 row in set (0.83 sec)

key1列在'a'到'i'之间的记录也有2310条:

mysql> SELECT COUNT(*) FROM t WHERE key1 > 'a' AND key1 < 'i';+----------+| COUNT(*) |+----------+| 2310 |+----------+1 row in set (1.31 sec)

现在我们有如下两个查询:

查询1:SELECT * FROM t WHERE key1 = 'a';查询2:SELECT * FROM t WHERE key1 > 'a' AND key1 < 'i';

按理说上边两个查询需要扫描的记录数量是一样的,MySQL查询优化器对待它们的态度也应该是一样的,也就是要么都使用二级索引idx_key1执行它们,要么都使用全表扫描的方式来执行它们。不过现实是貌似查询优化器更喜欢查询1,而比较讨厌查询2。查询1的执行计划如下所示:

# 查询1的执行计划mysql> EXPLAIN SELECT * FROM t WHERE key1 = 'a'\G*************************** 1. row ***************************id: 1select_type: SIMPLEtable: tpartitions: NULLtype: refpossible_keys: idx_key1key: idx_key1key_len: 303ref: constrows: 2310filtered: 100.00Extra: NULL1 row in set, 1 warning (0.04 sec)

查询2的执行计划如下所示:

# 查询2的执行计划mysql> EXPLAIN SELECT * FROM t WHERE key1 > 'a' AND key1 < 'i'\G*************************** 1. row ***************************id: 1select_type: SIMPLEtable: tpartitions: NULLtype: ALLpossible_keys: idx_key1key: NULLkey_len: NULLref: NULLrows: 9912filtered: 23.31Extra: Using where1 row in set, 1 warning (0.03 sec)

很显然,查询优化器决定使用idx_key1二级索引执行查询1,而使用全表扫描来执行查询2。

为什么?凭什么?同样是扫描相同数量的记录,凭什么我range访问方法就要比你ref低一头?设计MySQL的大叔,你为何这么偏心...

解密偏心原因

世界上没有无缘无故的爱,也没有无缘无故的恨。这事儿还得从索引结构说起。比方说idx_key1二级索引结构长这样:

原谅我们把索引对应的B+树结构弄了一个极度精简版,我们忽略掉了页的结构,只保留了叶子节点的记录。虽然极度精简,但是我们还是保留了一个极其重要的特性:B+树叶子节点中的记录是按照索引列的值从小到大排序的。对于二级索引idx_key1来说:

- 二级索引叶子节点的记录只保留key1列和id列

- 二级索引记录是先按照key1列的值从小到大的顺序进行排序的。

- 如果key1列的值相同,则按照主键值,也就是id列的值从小到大的顺序进行排序。

也就是说,对于所有key1值为'a'的二级索引记录来说,它们都是按照id列的值进行排序的。对于查询1:

查询1: SELECT * FROM t WHERE key1 = 'a';

由于查询列表是* ,也就是说我们需要通过读取到的二级索引记录的id值执行回表操作,到聚簇索引中找到完整的用户记录(为了去获取common_field列的值)后才可以将记录发送到客户端。对于所有key1列值等于'a'的二级索引记录,由于它们是按照id列的值排序的,所以:

前一次回表的id值所属的聚簇索引记录和下一次回表的id值所属的聚簇索引记录很大可能在同一个数据页中

即使前一次回表的id值所属的聚簇索引记录和下一次回表的id值所属的聚簇索引记录不在同一个数据页中,由于回表的id值是递增的,所以我们很大可能通过顺序I/O的方式找到下一个数据页,也就是说这个过程中很大可能不需要很大幅度的移动磁头就可以找到下一个数据页。这可以减少很多随机I/O带来的性能开销。

综上所属,执行语句1时,回表操作带来的性能开销较小。

而对于查询2来说:

查询2: SELECT * FROM t WHERE key1 > 'a' AND key1 < 'i';

由于需要扫描的二级索引记录对应的id值是无序的,所以执行回表操作时,需要访问的聚簇索引记录所在的数据页很大可能就是无序的,这样会造成很多随机I/O。所以如果使用idx_key1来执行查询1和查询2,执行查询1的成本很显然会比查询2低,这也是设计MySQL的大叔更钟情于ref而不是range的原因。

MySQL的内部实现

MySQL优化器在计算回表的成本时,在使用二级索引执行查询并且需要回表的情境下,对于ref和range是很明显的区别对待的:

对于range来说,需要扫描多少条二级索引记录,就相当于需要访问多少个页面。每访问一个页面,回表的I/O成本就加1。

比方对于查询2来说,需要回表的记录数是2310,因为回表操作而计算的I/O成本就是2310。

对于ref来说,回表开销带来的I/O成本存在天花板,也就是定义了一个上限值:

double worst_seeks;

这个上限值的取值是从下边两个值中取较小的那个:

- 全表记录数的十分之一(此处的全表记录数属于统计数据,是一个估计值)

- 聚簇索引所占页面的3倍

比方对于查询1来说,回表的记录数是2310,按理说计算因回表操作带来的I/O成本也应该是2310。但是由于对于ref访问方法,计算回表操作时带来的I/O成本时存在天花板,会从全表记录的十分之一(也就是9912/10=991,9912为估计值)以及聚簇索引所占页面的3倍(本例中聚簇索引占用的页面数就是97,乘以3就是291)选择更小的那个,本例中也就是291。

小贴士:在成本分析的代码中,range和index、all是被分到一类里的,ref是亲儿子,单独分析了一波。不过我们也可以看到,设计MySQL的大叔在计算range访问方法的代价时,直接认为每次回表都需要进行一次页面I/O,这是十分粗暴的,何况我们的实际聚簇索引总共才97个页面,它却将回表成本计算为2310,这也是很不精确的。当然,由于目前的算法无法预测哪些页面在内存中,哪些不在,所以也就将就将就用吧~

MySQL中NULL值引起的小锅

标签: 公众号文章

这一系列文章主要说明了一个道理:MySQL查询优化器决策是否使用某个索引执行查询时的依据是使用该索引的成本是否足够低,而成本很大程度上取决于需要扫描的二级索引记录数量占表中所有记录数量的比例。

innodb_stats_method的作用

我们知道索引列不重复的值的数量这个统计数据对于MySQL查询优化器十分重要,因为通过它可以计算出在索引列中平均一个值重复多少行,它的应用场景主要有两个:

单表查询中单点区间太多,比方说这样:

SELECT * FROM tbl_name WHERE key IN ('xx1', 'xx2', ..., 'xxn');

当

IN里的参数数量过多时,采用index dive的方式直接访问B+树索引去同步统计每个单点区间对应的记录的数量就太耗费性能了,所以直接依赖统计数据中的平均一个值重复多少行来计算单点区间对应的记录数量。连接查询时,如果有涉及两个表的等值匹配连接条件,该连接条件对应的被驱动表中的列又拥有索引时,则可以使用

ref访问方法来对被驱动表进行查询,比方说这样:SELECT * FROM t1 JOIN t2 ON t1.column = t2.key WHERE ...;

在真正执行对

t2表的查询前,t1.comumn的值是不确定的,所以我们也不能通过index dive的方式直接访问B+树索引去同步统计每个单点区间对应的记录的数量,所以也只能依赖统计数据中的平均一个值重复多少行来计算单点区间对应的记录数量。

在统计索引列不重复的值的数量时,有一个比较烦的问题就是索引列中出现NULL值怎么办,比方说某个索引列的内容是这样:

+------+| col |+------+| 1 || 2 || NULL || NULL |+------+

此时计算这个col列中不重复的值的数量就有下边的分歧:

有的人认为

NULL值代表一个未确定的值,所以设计MySQL的大叔才认为任何和NULL值做比较的表达式的值都为NULL,就是这样:mysql> SELECT 1 = NULL;+----------+| 1 = NULL |+----------+| NULL |+----------+1 row in set (0.00 sec)mysql> SELECT 1 != NULL;+-----------+| 1 != NULL |+-----------+| NULL |+-----------+1 row in set (0.00 sec)mysql> SELECT NULL = NULL;+-------------+| NULL = NULL |+-------------+| NULL |+-------------+1 row in set (0.00 sec)mysql> SELECT NULL != NULL;+--------------+| NULL != NULL |+--------------+| NULL |+--------------+1 row in set (0.00 sec)

所以每一个

NULL值都是独一无二的,也就是说统计索引列不重复的值的数量时,应该把NULL值当作一个独立的值,所以col列的不重复的值的数量就是:4(分别是1、2、NULL、NULL这四个值)。有的人认为其实

NULL值在业务上就是代表没有,所有的NULL值代表的意义是一样的,所以col列不重复的值的数量就是:3(分别是1、2、NULL这三个值)。有的人认为这

NULL完全没有意义嘛,所以在统计索引列不重复的值的数量时压根儿不能把它们算进来,所以col列不重复的值的数量就是:2(分别是1、2这两个值)。

设计MySQL的大叔蛮贴心的,他们提供了一个名为innodb_stats_method的系统变量,相当于在计算某个索引列不重复值的数量时如何对待NULL值这个锅甩给了用户,这个系统变量有三个候选值:

nulls_equal:认为所有NULL值都是相等的。这个值也是innodb_stats_method的默认值。如果某个索引列中

NULL值特别多的话,这种统计方式会让优化器认为某个列中平均一个值重复次数特别多,所以倾向于不使用索引进行访问。nulls_unequal:认为所有NULL值都是不相等的。如果某个索引列中

NULL值特别多的话,这种统计方式会让优化器认为某个列中平均一个值重复次数特别少,所以倾向于使用索引进行访问。nulls_ignored:直接把NULL值忽略掉。

反正这个锅是甩给用户了,当你选定了innodb_stats_method值之后,优化器即使选择了不是最优的执行计划,那也跟设计MySQL的大叔们没关系了哈~ 当然对于用户的我们来说,最好不在索引列中存放NULL值才是正解。

两种不同的统计数据存储方式

InnoDB提供了两种存储统计数据的方式:

永久性的统计数据

这种统计数据存储在磁盘上,也就是服务器重启之后这些统计数据还在。

非永久性的统计数据

这种统计数据存储在内存中,当服务器关闭时这些这些统计数据就都被清除掉了,等到服务器重启之后,在某些适当的场景下才会重新收集这些统计数据。

设计MySQL的大叔们给我们提供了系统变量innodb_stats_persistent来控制到底采用哪种方式去存储统计数据。在MySQL 5.6.6之前,innodb_stats_persistent的值默认是OFF,也就是说InnoDB的统计数据默认是存储到内存的,之后的版本中innodb_stats_persistent的值默认是ON,也就是统计数据默认被存储到磁盘中。

不过InnoDB默认是以表为单位来收集和存储统计数据的,也就是说我们可以把某些表的统计数据(以及该表的索引统计数据)存储在磁盘上,把另一些表的统计数据存储在内存中。怎么做到的呢?我们可以在创建和修改表的时候通过指定STATS_PERSISTENT属性来指明该表的统计数据存储方式:

CREATE TABLE 表名 (...) Engine=InnoDB, STATS_PERSISTENT = (1|0);ALTER TABLE 表名 Engine=InnoDB, STATS_PERSISTENT = (1|0);

当STATS_PERSISTENT=1时,表明我们想把该表的统计数据永久的存储到磁盘上,当STATS_PERSISTENT=0时,表明我们想把该表的统计数据临时的存储到内存中。如果我们在创建表时未指定STATS_PERSISTENT属性,那默认采用系统变量innodb_stats_persistent的值作为该属性的值。

问题

有同学在小册群中反应在使用基于磁盘的统计数据时,将innodb_stats_method系统变量设置成不同的值,但是发现对应的统计数据却并未发生预想的变化(可以通过SHOW INDEX FROM tbl_name或者查看mysql数据库下的innodb_index_stats表),这到底是因为啥呢?

原因

我一开始也对这个现象有点儿疑惑🤔,于是不得不再次打开看吐了的源码来看。

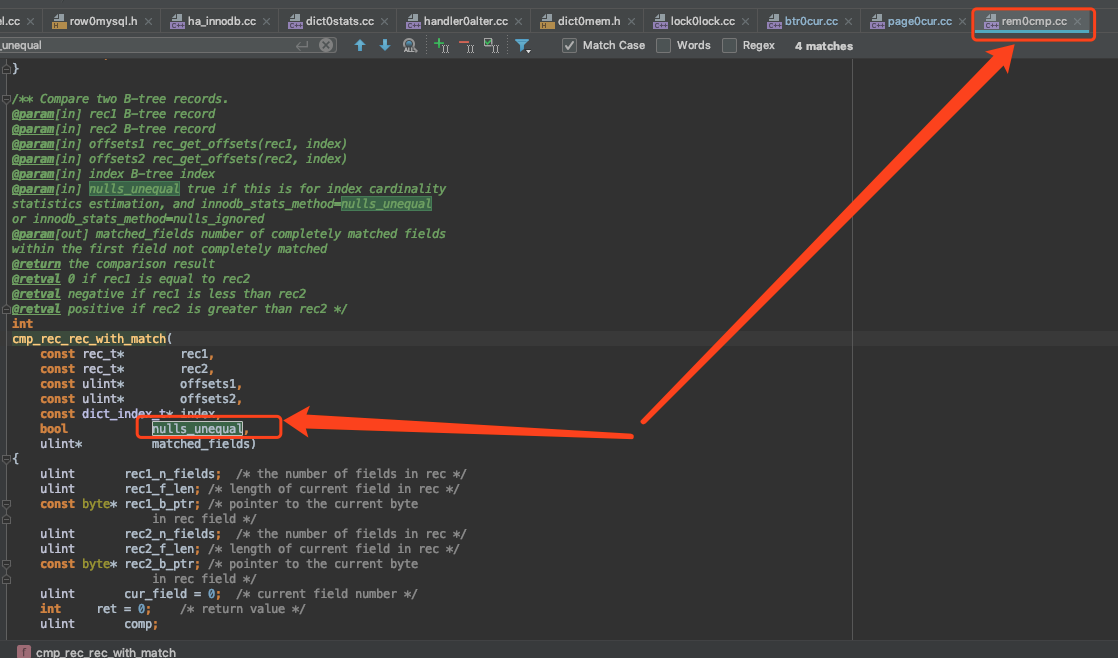

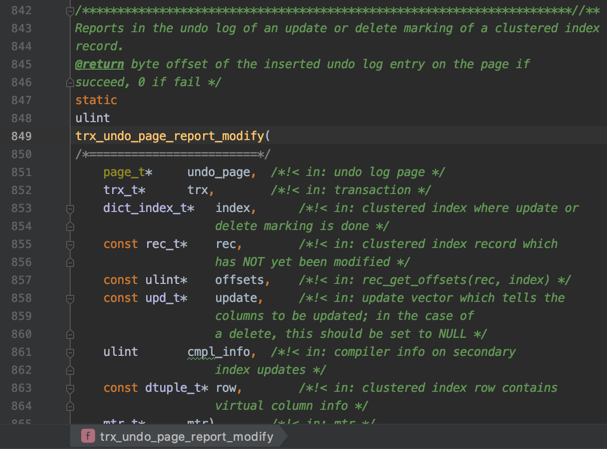

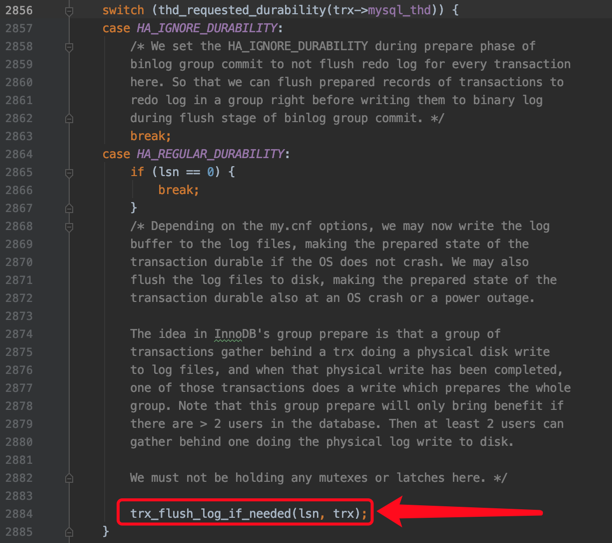

比较两条记录是否相同的函数是

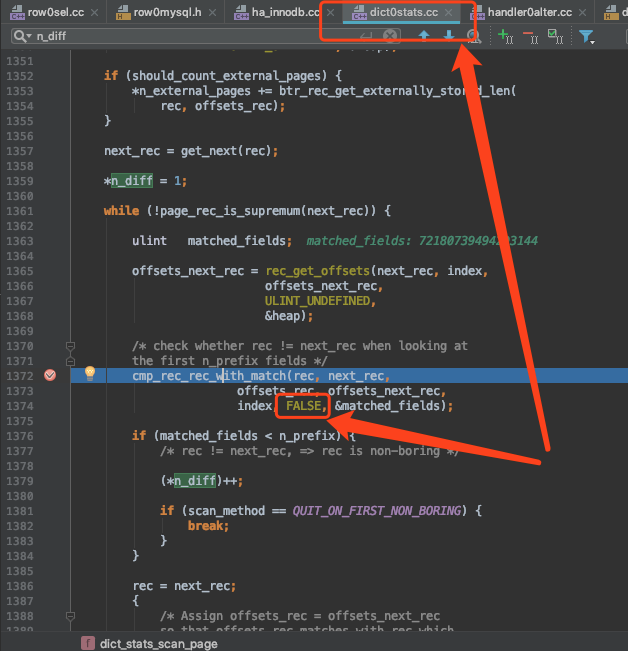

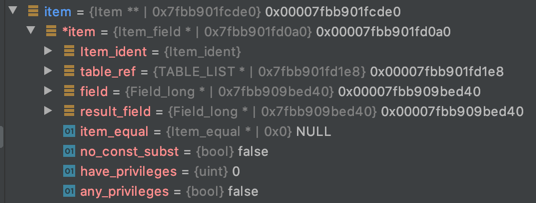

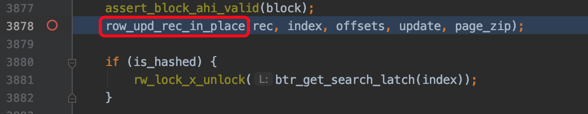

cmp_rec_rec_with_match,如下图所示:

其中的

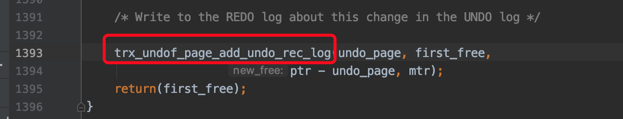

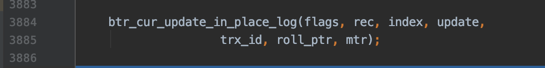

nulls_unequal参数是用来区别是否将两个null值认为是相等的。在计算基于磁盘的统计数据时,是这样调用该函数的:

可以看到

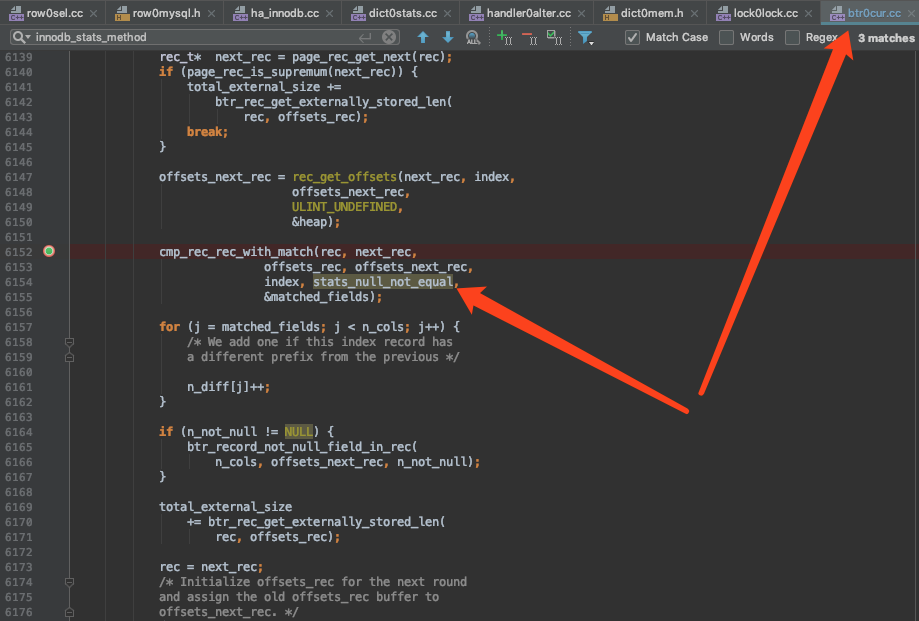

nulls_unequal参数是硬编码为FALSE。在计算基于内存的统计数据时,是这样调用该函数的:

可以看到这种调用的方式就是正常的。

从实践来看,在计算基于内存的统计数据时,改变系统变量innodb_stats_method的值是起作用的,但是在计算基于磁盘的统计数据时,改变该系统变量的值是无效的。我也并不知道设计InnoDB的大叔为什么这么写,翻了翻代码也没看见这么写有什么特别的注释,之后还特意去看了MySQL文档中关于统计数据收集的相关章节,也没发现有特别声明这两者的区别。可能是一个bug?或者有啥深层次的含义?有知道的同学可以留言哈~

MySQL使用索引执行IN子句

标签: 公众号文章

对于开发小伙伴来说,对MySQL中的包含IN子句的语句肯定熟悉的不能再熟悉了,几乎天天用,时时用。可是很多小伙伴不知道包含IN子句的语句是怎样执行的,在一些查询优化的场景中就开始找不着北了,本篇文章就来唠叨一下MySQL中的IN语句是怎样执行的(以MySQL 5.7的InnoDB存储引擎为例)。

准备工作

为了故事的顺利发展,我们先创建一个表:

CREATE TABLE t (id INT NOT NULL AUTO_INCREMENT,key1 VARCHAR(100),common_field VARCHAR(100),PRIMARY KEY (id),KEY idx_key1 (key1)) Engine=InnoDB CHARSET=utf8;

可以看到表t中包含两个索引:

- 以

id列为主键的聚簇索引 - 为

key1列建立的二级索引

这个表里边现在有10000条数据:

mysql> SELECT COUNT(*) FROM t;+----------+| COUNT(*) |+----------+| 10000 |+----------+1 row in set (0.00 sec)

从B+树中定位记录

我们现在想执行下边这个语句:

SELECT * FROM t WHEREkey1 >= 'b' AND key1 <= 'c';

假设优化器选择使用二级索引来执行查询,那么查询语句的执行示意图就如下图所示:

小贴士:原谅我把索引对应的复杂的B+树结构搞了一个极度精简版,为了突出重点,我们忽略掉了页的结构,直接把所有的叶子节点的记录都放在一起展示。我们想突出的重点就是:B+树叶子节点中的记录是按照索引列值大小排序的,对于的聚簇索引来说,它对应的B+树叶子节点中的记录就是按照id列排序的,对于idx_key1二级索引来说,它对应的B+树叶子节点中的记录就是按照key1列排序的。

我们想查询key1列的值在['b', 'c']这个区间中的记录,那么就需要:

先通过

idx_key1索引对应的B+树快速定位到key1列值为'b'、并且最靠左的那条二级索引记录,该二级索引记录中包含着对应的主键值,根据这个主键值再到聚簇索引中定位到完整的记录(这个过程称之为回表),将其返回给server层,server层再发送给客户端。记录按照键值由小到大的顺序排列成一个单链表的形式,所以我们可以沿着这个单链表接着定位到下一条二级索引记录,并且执行回表操作,将完整的记录交给server层之后发送给客户端。

继续沿着记录的单向链表查找,重复上述过程,直到找到的二级索引记录的key1列的值不满足

key1 <= 'c'的这个条件,如图所示,也就是当我们在idx_key1二级索引中找到了key1='ca'的那条记录后,发现它不符合key1 <= 'c'的条件,所以就停止查找。

上述过程就是通过B+树查找一个键值在某一个范围区间的记录的过程。

包含IN子句的执行过程

如果我们想执行下边这个语句:

SELECT * FROM t WHEREkey1 IN ('b', 'c');

如果优化器选择使用二级索引执行上述语句,那它是如何执行的呢?

优化器会将IN子句中的条件看成是2个范围区间(虽然这两个区间中都仅仅包含一个值):

['b', 'b']['c', 'c']

那么在语句执行过程中就需要通过B+树去定位两次记录所在的位置:

先定位键值在范围区间

['b', 'b']的记录:先通过

idx_key1索引对应的B+树快速定位到key1列值为'b'、并且最靠左的那条二级索引记录,之后回表将其发送给server 层后再发送给客户端。再沿着记录组成的单链表把符合

key1=b的二级索引记录找到,并且回表后发送给server层,之后再发送给客户端。重复上述过程,直到找到的二级索引记录的key1列的值不满足

key1 = 'b'的这个条件为止。

再定位键值在范围区间

['c', 'c']的记录:查找过程类似,就不多赘述了。

所以如果你写的IN语句中的参数越多,意味着需要通过B+树定位记录的次数就越多。

IN子句中参数值重复的情况

比方说下边这条语句:

SELECT * FROM t WHEREkey1 IN ('b', 'b', 'b', 'b', 'b', 'b', 'b', 'b', 'b');

虽然IN子句中包含好多个参数,但MySQL在语法解析的时候只会为其生成一个范围区间,那就是:['b', 'b']。

IN子句的参数顺序问题

比方说下边这条语句:

SELECT * FROM t WHERE key1 IN ('c', 'b');

IN ('c', 'b')和IN ('b', 'c')有啥差别么?也就是存储引擎在对待IN ('c', 'b')子句时,会先去找key1 = 'c'的记录,再去找key1 = 'b'的记录么?如果是这样的话,下边两条语句岂不是可能发生死锁:

事务T1中的语句一:SELECT * FROM t WHEREkey1 IN ('b', 'c') FOR UPDATE;事务T2中的语句二:SELECT * FROM t WHEREkey1 IN ('c', 'b') FOR UPDATE;

放心,在生成范围区间的时候,自然是将范围区间排了序,也就是即使条件是IN ('c', 'b'),那优化器也会先让存储引擎去找键值在['b', 'b']这个范围区间中的记录,然后再去找键值在['c', 'c']这个范围区间中的记录。

系统变量eq_range_index_dive_limit对IN子句的影响

大家一定要记着:MySQL优化器决定使用某个索引执行查询的仅仅是因为:使用该索引时的成本足够低。也就是说即使我们有下边的语句:

SELECT * FROM t WHEREkey1 IN ('b', 'c');

MySQL优化器需要去分析一下如果使用二级索引idx_key1执行查询的话,键值在['b', 'b']和['c', 'c']这两个范围区间的记录共有多少条,然后通过一定方式计算出成本,与全表扫描的成本相对比,选取成本更低的那种方式执行查询。

在计算查询成本的这一步骤中大家需要注意,对于包含IN子句条件的查询来说,需要依次分析一下每一个范围区间中的记录数量是多少。MySQL优化器针对IN子句对应的范围区间的多少而指定了不同的策略:

如果IN子句对应的范围区间比较少,那么将率先去访问一下存储引擎,看一下每个范围区间中的记录有多少条(如果范围区间的记录比较少,那么统计结果就是精确的,反之会采用一定的手段计算一个模糊的值,当然算法也比较麻烦,我们就不展开说了,小册里有说),这种在查询真正执行前优化器就率先访问索引来计算需要扫描的索引记录数量的方式称之为index dive。

如果IN子句对应的范围区间比较多,这样就不能采用index dive的方式去真正的访问二级索引idx_key1(因为那将耗费大量的时间),而是需要采用之前在背地里产生的一些统计数据去估算匹配的二级索引记录有多少条(很显然根据统计数据去估算记录条数比index dive的方式精确性差了很多)。

那什么时候采用index dive的统计方式,什么时候采用index statistic的统计方式呢?这就取决于系统变量eq_range_index_dive_limit的值了,我们看一下在我的机器上该系统变量的值:

mysql> SHOW VARIABLES LIKE 'eq_range_index_dive_limit';+---------------------------+-------+| Variable_name | Value |+---------------------------+-------+| eq_range_index_dive_limit | 200 |+---------------------------+-------+1 row in set (0.20 sec)

可以看到它的默认值是200,这也就意味着当范围区间个数小于200时,将采用index dive的统计方式,否则将采用index statistic的统计方式。

不过这里需要大家特别注意,在MySQL 5.7.3以及之前的版本中,eq_range_index_dive_limit的默认值为10。所以如果大家采用的是5.7.3以及之前的版本的话,很容易采用索引统计数据而不是index dive的方式来计算查询成本。当你的查询中使用到了IN查询,但是却实际没有用到索引,就应该考虑一下是不是由于 eq_range_index_dive_limit 值太小导致的。

MySQL的COUNT语句是怎么执行的

标签: 公众号文章

众多开发小伙伴在写业务逻辑的时候都会有一个统计行数的需求,此时COUNT函数便成为了首选。但是大家发现,随着数据量的增长,COUNT执行的越来越慢,本文从源码的角度来帮助小伙伴们分析一下MySQL中的COUNT函数是如何执行的。

需要声明一点,本文所使用的MySQL源码版本是5.7.22,并且只针对InnoDB存储引擎。在深入介绍之前需要大家具有一些前置知识,才可以顺利讨论。

前置知识1——InnoDB的B+树索引

为了故事的顺利发展,我们引入一个表:

CREATE TABLE t (id INT UNSIGNED NOT NULL AUTO_INCREMENT,key1 INT,common_field VARCHAR(100),PRIMARY KEY (id),KEY idx_key1 (key1)) Engine=InnoDB CHARSET=utf8;

这个表就包含2个索引(也就是2棵B+树):

以

id列为主键对应的聚簇索引。为

key1列建立的二级索引idx_key1。

我们向表中插入一些记录:

INSERT INTO t VALUES(1, 30, 'b'),(2, 80, 'b'),(3, 23, 'b'),(4, NULL, 'b'),(5, 11, 'b'),(6, 53, 'b'),(7, 63, 'b'),(8, NULL, 'b'),(9, 99, 'b'),(10, 12, 'b'),(11, 66, 'b'),(12, NULL, 'b'),(13, 66, 'b'),(14, 30, 'b'),(15, 11, 'b'),(16, 90, 'b');

所以现在t表的聚簇索引示意图就是这样:

t表的二级索引示意图就是这样:

小贴士:

原谅我们画了一个极度简化版的B+树:我们省略了B+树中的页面节点,省略了每层页面节点之间的双向链表,省略了页面中记录的单向链表,省略了页面中的页目录结构,还有省略了好多东西。但是我们保留B+树最为核心的一个特点:记录是按照键值大小进行排序的。即对于聚簇索引来说,记录是按照id列进行排序的;对于二级索引idx_key1来说,记录是按照key1列进行排序的,在key1列相同时再按照id列进行排序。

从上边聚簇索引和二级索引的结构中大家可以发现:每一条聚簇索引记录都可以在二级索引中找到唯一的一条二级索引记录与其相对应。

前置知识2——server层和存储引擎的交互

以下边这个查询为例:

SELECT * FROM t WHERE key1 > 70 AND common_field != 'a';

假设优化器认为通过扫描二级索引idx_key1中key1值在(70, +∞)这个区间中的二级索引记录的成本更小,那么查询将以下述方式执行:

server层先让InnoDB去查在key1值在(70, +无穷)区间中的第一条记录。

InnoDB通过二级索引idx_key1对应的B+树,从B+树根页面一层一层向下定位,快速找到(70, +无穷)区间的第一条二级索引记录,然后根据该二级索引记录进行回表操作,找到完整的聚簇索引记录,然后返回给server层。

server层判断InnoDB返回的记录符不符合搜索条件

key1 > 70 AND common_field != 'a',如果不符合的话就跳过该记录,否则将其发送到客户端。

小贴士:

此处将记录发送给客户端其实是发送到本地的网络缓冲区,缓冲区大小由net_buffer_length控制,默认是16KB大小。等缓冲区满了才真正发送网络包到客户端。

然后server层向InnoDB要下一条记录。

InnoDB根据上一次找到的二级索引记录的next_record属性,获取到下一条二级索引记录,回表后将完整的聚簇索引记录返回给server层。

server继续判断,不符合搜索条件即跳过该记录,否则发送到客户端。

... 一直循环上述过程,直到InnoDB找不到下一条记录,则向server层报告查询完毕。

server层收到InnoDB报告的查询完毕请求,停止查询。

可见,一般情况下server层和存储引擎层是以记录为单位进行交互的。

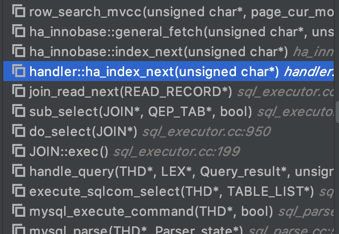

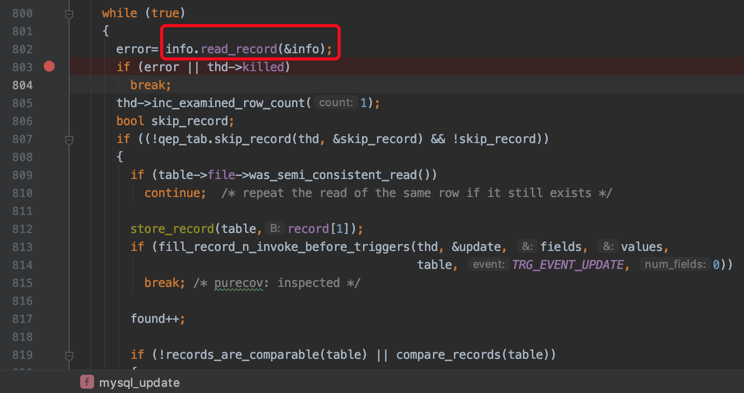

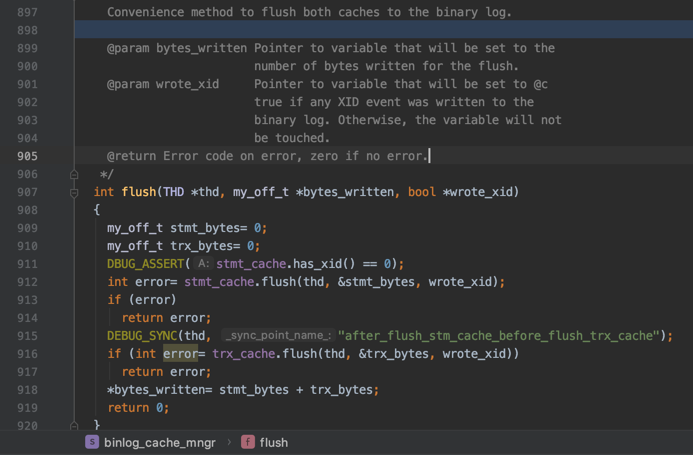

我们看一下源码中读取一条记录的函数调用栈:

其中的handler::ha_index_next便是server层向存储引擎要下一条记录的接口。

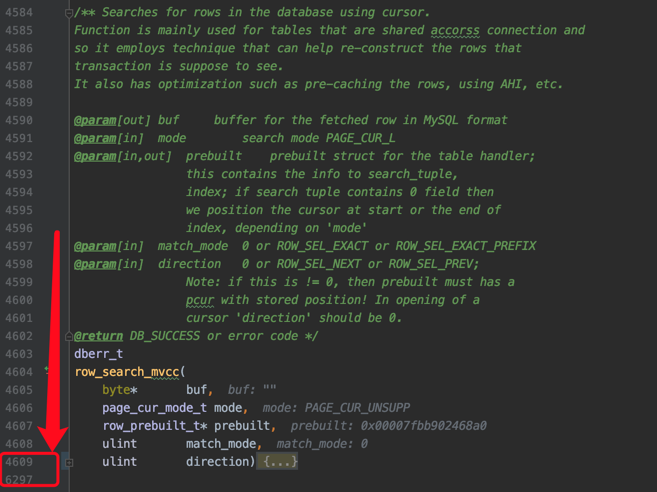

其中的row_search_mvcc是读取一条记录最重要的函数,这个函数长的吓人,有一千多行:

每读取一条记录,都要做非常多的工作,诸如进行多版本的可见性判断,要不要对记录进行加锁的判断,要是加锁的话加什么锁的选择,完成记录从InnoDB的存储格式到server层存储格式的转换等等等等十分繁杂的工作。

小贴士:

不知道你们公司有没有写这么长函数的同学,如果有的话你想不想打他。

前置知识3——COUNT是个啥

COUNT是一个汇总函数(聚集函数),它接收1个表达式作为参数:

COUNT(expr)

COUNT函数用于统计在符合搜索条件的记录中,指定的表达式expr不为NULL的行数有多少。这里需要特别注意的是,expr不仅仅可以是列名,其他任意表达式都是可以的。

比方说:

SELECT COUNT(key1) FROM t;

这个语句是用于统计在single_table表的所有记录中,key1列不为NULL的行数是多少。

再看这个:

SELECT COUNT('abc') FROM t;

这个语句是用于统计在single_table表的所有记录中,'abc'这个表达式不为NULL的行数是多少。很显然,'abc'这个表达式永远不是NULL,所以上述语句其实就是统计single_table表里有多少条记录。

再看这个:

SELECT COUNT(*) FROM t;

这个语句就是直接统计single_table表有多少条记录。

总结+注意:COUNT函数的参数可以是任意表达式,该函数用于统计在符合搜索条件的记录中,指定的表达式不为NULL的行数有多少。

MySQL中COUNT是怎样执行的

做了那么多铺垫,终于到了MySQL中COUNT是怎样执行的了。

以下边这个语句为例:

SELECT COUNT(*) FROM t;

这个语句是要去查询表t中共包含多少条记录。由于聚簇索引和二级索引中的记录是一一对应的,而二级索引记录中包含的列是少于聚簇索引记录的,所以同样数量的二级索引记录可以比聚簇索引记录占用更少的存储空间。如果我们使用二级索引执行上述查询,即数一下idx_key1中共有多少条二级索引记录,是比直接数聚簇索引中共有多少聚簇索引记录可以节省很多I/O成本。所以优化器会决定使用idx_key1执行上述查询:

mysql> EXPLAIN SELECT COUNT(*) FROM t;+----+-------------+-------+------------+-------+---------------+----------+---------+------+------+----------+-------------+| id | select_type | table | partitions | type | possible_keys | key | key_len | ref | rows | filtered | Extra |+----+-------------+-------+------------+-------+---------------+----------+---------+------+------+----------+-------------+| 1 | SIMPLE | t | NULL | index | NULL | idx_key1 | 5 | NULL | 16 | 100.00 | Using index |+----+-------------+-------+------------+-------+---------------+----------+---------+------+------+----------+-------------+1 row in set, 1 warning (0.02 sec)

在执行上述查询时,server层会维护一个名叫count的变量,然后:

server层向InnoDB要第一条记录。

InnoDB找到idx_key1的第一条二级索引记录,并返回给server层(注意:由于此时只是统计记录数量,所以并不需要回表)。

由于COUNT函数的参数是

*,MySQL会将*当作常数0处理。由于0并不是NULL,server层给count变量加1。server层向InnoDB要下一条记录。

InnoDB通过二级索引记录的next_record属性找到下一条二级索引记录,并返回给server层。

server层继续给count变量加1。

... 重复上述过程,直到InnoDB向server层返回没记录可查的消息。

server层将最终的count变量的值发送到客户端。

我们看一下源码里给count变量加1的代码是怎么写的:

其大意就是判断一下COUNT里的表达式是不是NULL,如果不是NULL的话就给count变量加1。

我们再来看一下arg_is_null的实现:

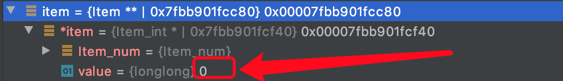

其中最重要的是我们标蓝的那一行,item[i]表示的就是COUNT函数中的参数,我们调试一下对于COUNT(*)来说,表达式*的值是什么:

可以看到,*表达式的类型其实是Item_int,这表示MySQL其实会把*当作一个整数处理,它的值是0(见图中箭头)。也就是说我们在判断表达式*是不是为NULL,也就是在判断整数0是不是为NULL,很显然不为NULL。

那COUNT(1),COUNT(id),COUNT(非主键列)呢?

那在执行COUNT(1)呢?比方说下边这个语句:

SELECT COUNT(1) FROM t;

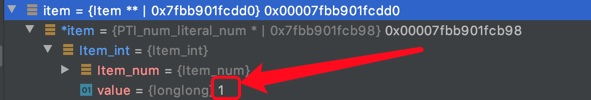

我们看一下:

可以看到,常数1对应的类型其实是PTI_num_literal_num,它其实是Item_int的一个包装类型,本质上还是代表一个整数,它的值是1(见图中箭头)。也就是说我们其实是在判断表达式1是不是为NULL,很显然不为NULL。

再看一下COUNT(id):

SELECT COUNT(id) FROM t;

我们看一下:

可以看到,id对应的类型是Item_field,代表一个字段。

对于COUNT(*)、COUNT(1)或者任意的COUNT(常数)来说,读取哪个索引的记录其实并不重要,因为server层只关心存储引擎是否读到了记录,而并不需要从记录中提取指定的字段来判断是否为NULL。所以优化器会使用占用存储空间最小的那个索引来执行查询。

对于COUNT(id)来说,由于id是主键,不论是聚簇索引记录,还是任意一个二级索引记录中都会包含主键字段,所以其实读取任意一个索引中的记录都可以获取到id字段,此时优化器也会选择占用存储空间最小的那个索引来执行查询。

而对于COUNT(非主键列)来说,我们指定的列可能并不会包含在每一个索引中。这样优化器只能选择包含我们指定的列的索引去执行查询,这就可能导致优化器选择的索引并不是最小的那个。

总结一下

对于COUNT(*)、COUNT(常数)、COUNT(主键)形式的COUNT函数来说,优化器可以选择最小的索引执行查询,从而提升效率,它们的执行过程是一样的,只不过在判断表达式是否为NULL时选择不同的判断方式,这个判断为NULL的过程的代价可以忽略不计,所以我们可以认为COUNT(*)、COUNT(常数)、COUNT(主键)所需要的代价是相同的。

而对于COUNT(非主键列)来说,server层必须要从InnoDB中读到包含非主键列的记录,所以优化器并不能随心所欲的选择最小的索引去执行。

我想改进一下?

我们知道,InnoDB的记录都是存储在数据页中的(页面大小默认为16KB),而每个数据页的Page Header部分都有一个统计当前页面中记录数量的属性PAGE_N_RECS。那有的同学说了:在执行COUNT函数的时候直接去把各个页面的这个PAGE_N_RECS属性加起来不就好了么?

答案是:行不通的!对于普通的SELECT语句来说,每次查询都要从记录的版本链上找到可见的版本才算是读到了记录;对于加了FOR UPDATE或LOCK IN SHARE MODE后缀的SELECT语句来说,每次查询都要给记录添加合适的锁。所以这个读取每一条记录的过程(就是上边给出的row_search_mvcc函数)在InnoDB的目前实现中是无法跳过的,InnoDB还是得老老实实的读一条记录,返给server层一条记录。

那如果我的业务中有COUNT需求,但是由于数据量太大导致即使优化器即使通过扫描二级索引记录的方式也还是太慢怎么办?既然业务上有需求,当然还是业务第一喽,我们可以在另一个地方存储一份待统计数据的行数,每次增删改记录都维护一下。

这样的解决方案显著增加了开发小伙伴的工作量,部分开发小伙伴肯定不太乐意,那就去怼你的产品经理吧:这么大数据量要TM什么精确值,你来告诉我这么大数据量要TM什么的TM的精确值?

MySQL的LIMIT这么差劲的吗

标签: 公众号文章

最近有多个小伙伴在答疑群里问了小孩子关于LIMIT的一个问题,下边我来大致描述一下这个问题。

问题

为了故事的顺利发展,我们得先有个表:

CREATE TABLE t (id INT UNSIGNED NOT NULL AUTO_INCREMENT,key1 VARCHAR(100),common_field VARCHAR(100),PRIMARY KEY (id),KEY idx_key1 (key1)) Engine=InnoDB CHARSET=utf8;

表t包含3个列,id列是主键,key1列是二级索引列。表中包含1万条记录。

当我们执行下边这个语句的时候,是使用二级索引idx_key1的:

mysql> EXPLAIN SELECT * FROM t ORDER BY key1 LIMIT 1;+----+-------------+-------+------------+-------+---------------+----------+---------+------+------+----------+-------+| id | select_type | table | partitions | type | possible_keys | key | key_len | ref | rows | filtered | Extra |+----+-------------+-------+------------+-------+---------------+----------+---------+------+------+----------+-------+| 1 | SIMPLE | t | NULL | index | NULL | idx_key1 | 303 | NULL | 1 | 100.00 | NULL |+----+-------------+-------+------------+-------+---------------+----------+---------+------+------+----------+-------+1 row in set, 1 warning (0.00 sec)

这个很好理解,因为在二级索引idx_key1中,key1列是有序的。而查询是要取按照key1列排序的第1条记录,那MySQL只需要从idx_key1中获取到第一条二级索引记录,然后直接回表取得完整的记录即可。

但是如果我们把上边语句的LIMIT 1换成LIMIT 5000, 1,则却需要进行全表扫描,并进行filesort,执行计划如下:

mysql> EXPLAIN SELECT * FROM t ORDER BY key1 LIMIT 5000, 1;+----+-------------+-------+------------+------+---------------+------+---------+------+------+----------+----------------+| id | select_type | table | partitions | type | possible_keys | key | key_len | ref | rows | filtered | Extra |+----+-------------+-------+------------+------+---------------+------+---------+------+------+----------+----------------+| 1 | SIMPLE | t | NULL | ALL | NULL | NULL | NULL | NULL | 9966 | 100.00 | Using filesort |+----+-------------+-------+------------+------+---------------+------+---------+------+------+----------+----------------+1 row in set, 1 warning (0.00 sec)

有的同学就很不理解了:LIMIT 5000, 1也可以使用二级索引idx_key1呀,我们可以先扫描到第5001条二级索引记录,对第5001条二级索引记录进行回表操作不就好了么,这样的代价肯定比全表扫描+filesort强呀。

很遗憾的告诉各位,由于MySQL实现上的缺陷,不会出现上述的理想情况,它只会笨笨的去执行全表扫描+filesort,下边我们唠叨一下到底是咋回事儿。

server层和存储引擎层

大家都知道,MySQL内部其实是分为server层和存储引擎层的:

server层负责处理一些通用的事情,诸如连接管理、SQL语法解析、分析执行计划之类的东西

存储引擎层负责具体的数据存储,诸如数据是存储到文件上还是内存里,具体的存储格式是什么样的之类的。我们现在基本都使用InnoDB存储引擎,其他存储引擎使用的非常少了,所以我们也就不涉及其他存储引擎了。

MySQL中一条SQL语句的执行是通过server层和存储引擎层的多次交互才能得到最终结果的。比方说下边这个查询:

SELECT * FROM t WHERE key1 > 'a' AND key1 < 'b' AND common_field != 'a';

server层会分析到上述语句可以使用下边两种方案执行:

方案一:使用全表扫描

方案二:使用二级索引idx_key1,此时需要扫描key1列值在('a', 'b')之间的全部二级索引记录,并且每条二级索引记录都需要进行回表操作。

server层会分析上述两个方案哪个成本更低,然后选取成本更低的那个方案作为执行计划。然后就调用存储引擎提供的接口来真正的执行查询了。

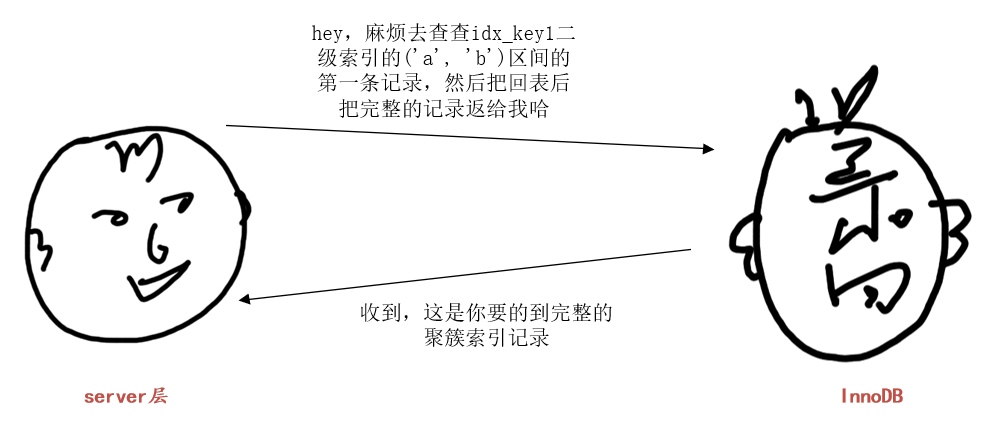

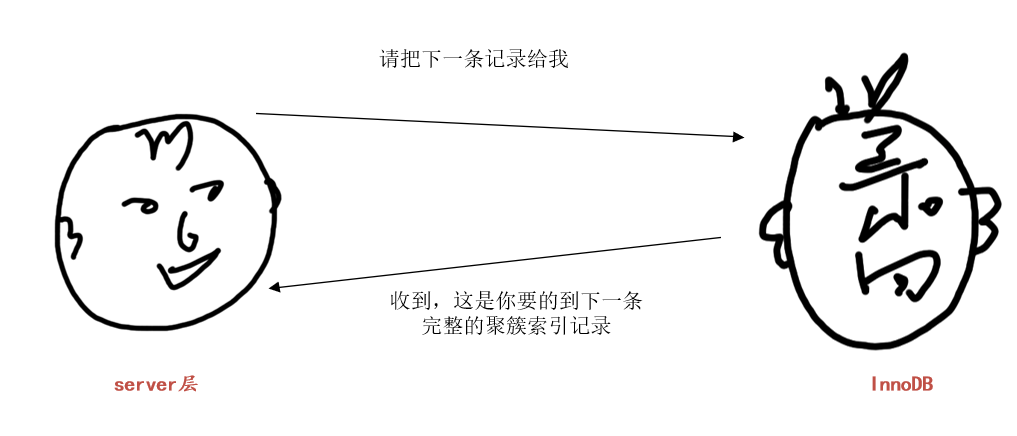

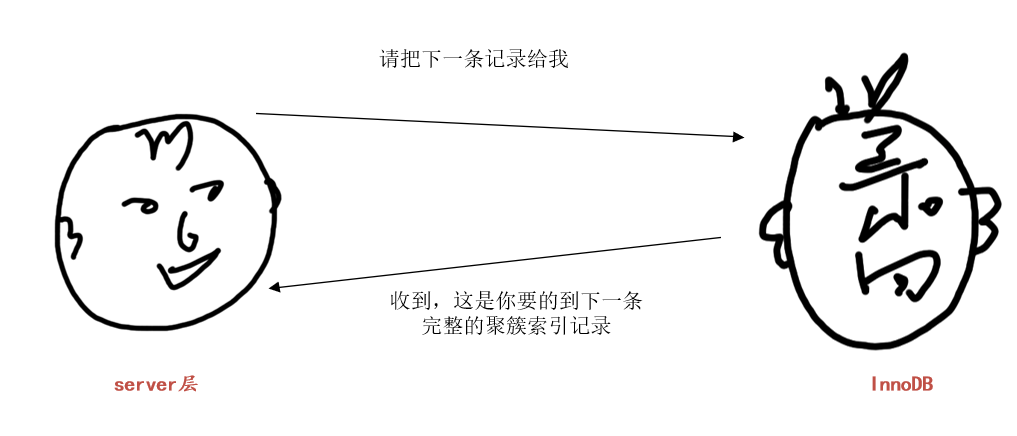

这里假设采用方案二,也就是使用二级索引idx_key1执行上述查询。那么server层和存储引擎层的对话可以如下所示:

server层:“hey,麻烦去查查idx_key1二级索引的('a', 'b')区间的第一条记录,然后把回表后把完整的记录返给我哈”

InnoDB:“收到,这就去查”,然后InnoDB就通过idx_key1二级索引对应的B+树,快速定位到扫描区间('a', 'b')的第一条二级索引记录,然后进行回表,得到完整的聚簇索引记录返回给server层。

server层收到完整的聚簇索引记录后,继续判断common_field!='a'条件是否成立,如果不成立则舍弃该记录,否则将该记录发送到客户端。然后对存储引擎说:“请把下一条记录给我哈”

小贴士:

此处将记录发送给客户端其实是发送到本地的网络缓冲区,缓冲区大小由net_buffer_length控制,默认是16KB大小。等缓冲区满了才真正发送网络包到客户端。

InnoDB:“收到,这就去查”。InnoDB根据记录的next_record属性找到idx_key1的('a', 'b')区间的下一条二级索引记录,然后进行回表操作,将得到的完整的聚簇索引记录返回给server层。

小贴士:

不论是聚簇索引记录还是二级索引记录,都包含一个称作next_record的属性,各个记录根据next_record连成了一个链表,并且链表中的记录是按照键值排序的(对于聚簇索引来说,键值指的是主键的值,对于二级索引记录来说,键值指的是二级索引列的值)。

server层收到完整的聚簇索引记录后,继续判断common_field!='a'条件是否成立,如果不成立则舍弃该记录,否则将该记录发送到客户端。然后对存储引擎说:“请把下一条记录给我哈”

... 然后就不停的重复上述过程。

直到:

也就是直到InnoDB发现根据二级索引记录的next_record获取到的下一条二级索引记录不在('a', 'b')区间中,就跟server层说:“好了,('a', 'b')区间没有下一条记录了”

server层收到InnoDB说的没有下一条记录的消息,就结束查询。

现在大家就知道了server层和存储引擎层的基本交互过程了。

那LIMIT是什么鬼?

说出来大家可能有点儿惊讶,MySQL是在server层准备向客户端发送记录的时候才会去处理LIMIT子句中的内容。拿下边这个语句举例子:

SELECT * FROM t ORDER BY key1 LIMIT 5000, 1;

如果使用idx_key1执行上述查询,那么MySQL会这样处理:

server层向InnoDB要第1条记录,InnoDB从idx_key1中获取到第一条二级索引记录,然后进行回表操作得到完整的聚簇索引记录,然后返回给server层。server层准备将其发送给客户端,此时发现还有个

LIMIT 5000, 1的要求,意味着符合条件的记录中的第5001条才可以真正发送给客户端,所以在这里先做个统计,我们假设server层维护了一个称作limit_count的变量用于统计已经跳过了多少条记录,此时就应该将limit_count设置为1。server层再向InnoDB要下一条记录,InnoDB再根据二级索引记录的next_record属性找到下一条二级索引记录,再次进行回表得到完整的聚簇索引记录返回给server层。server层在将其发送给客户端的时候发现limit_count才是1,所以就放弃发送到客户端的操作,将limit_count加1,此时limit_count变为了2。

... 重复上述操作

直到limit_count等于5000的时候,server层才会真正的将InnoDB返回的完整聚簇索引记录发送给客户端。

从上述过程中我们可以看到,由于MySQL中是在实际向客户端发送记录前才会去判断LIMIT子句是否符合要求,所以如果使用二级索引执行上述查询的话,意味着要进行5001次回表操作。server层在进行执行计划分析的时候会觉得执行这么多次回表的成本太大了,还不如直接全表扫描+filesort快呢,所以就选择了后者执行查询。

怎么办?

由于MySQL实现LIMIT子句的局限性,在处理诸如LIMIT 5000, 1这样的语句时就无法通过使用二级索引来加快查询速度了么?其实也不是,只要把上述语句改写成:

SELECT * FROM t, (SELECT id FROM t ORDER BY key1 LIMIT 5000, 1) AS dWHERE t.id = d.id;

这样,SELECT id FROM t ORDER BY key1 LIMIT 5000, 1作为一个子查询单独存在,由于该子查询的查询列表只有一个id列,MySQL可以通过仅扫描二级索引idx_key1执行该子查询,然后再根据子查询中获得到的主键值去表t中进行查找。

这样就省去了前5000条记录的回表操作,从而大大提升了查询效率!

吐个槽

设计MySQL的大叔啥时候能改改LIMIT子句的这种超笨的实现呢?还得用户手动想欺骗优化器的方案才能提升查询效率~

MySQL:为什么查询列表中多了它,GROUP BY语句就会报错呢?

标签: 公众号文章

事前准备

为了故事的顺利发展,我们先得建一个表:

CREATE TABLE student_score (number INT(11) NOT NULL,name VARCHAR(30) NOT NULL,subject VARCHAR(30) NOT NULL,score TINYINT(4) DEFAULT NULL,PRIMARY KEY (number,subject)) ENGINE=InnoDB DEFAULT CHARSET=utf8;

这个student_score表是用来存储学生成绩的,我们为这个条填充一些数据,填充后的效果就像这样:

mysql> SELECT * FROM student_score;+----------+-----------+-----------------------------+-------+| number | name | subject | score |+----------+-----------+-----------------------------+-------+| 20180101 | 杜子腾 | 母猪的产后护理 | 78 || 20180101 | 杜子腾 | 论萨达姆的战争准备 | 88 || 20180102 | 杜琦燕 | 母猪的产后护理 | 100 || 20180102 | 杜琦燕 | 论萨达姆的战争准备 | 98 || 20180103 | 范统 | 母猪的产后护理 | 59 || 20180103 | 范统 | 论萨达姆的战争准备 | 61 || 20180104 | 史珍香 | 母猪的产后护理 | 55 || 20180104 | 史珍香 | 论萨达姆的战争准备 | 46 |+----------+-----------+-----------------------------+-------+8 rows in set (0.00 sec)

GROUP BY是在干什么?

我们知道MySQL提供了一系列的聚集函数,诸如:

COUNT:统计记录数。MAX:查询某列的最大值。MIN:查询某列的最小值。SUM:某列数据的累加总和。AVG:某列数据的平均数。

比方说我们想查看一下student_score表中所有人成绩的平均数就可以这么写:

mysql> SELECT AVG(score) FROM student_score;+------------+| AVG(score) |+------------+| 73.1250 |+------------+1 row in set (0.00 sec)

如果我们只想查看《母猪的产后护理》这个科目的平均成绩,那加个WHERE子句就好了:

mysql> SELECT AVG(score) FROM student_score WHERE subject = '母猪的产后护理';+------------+| AVG(score) |+------------+| 73.0000 |+------------+1 row in set (0.00 sec)

同理,我们也可以单独查看《论萨达姆的战争准备》这门课程的平均成绩:

mysql> SELECT AVG(score) FROM student_score WHERE subject = '论萨达姆的战争准备';+------------+| AVG(score) |+------------+| 73.2500 |+------------+1 row in set (0.00 sec)

这时候问题来了,如果这个student_score表中存储了20门科目的成绩信息,那我们怎么单独的得到这20门课程的平均成绩呢?单独写20个查询语句?那要是有100门课呢?

很显然,不能傻兮兮的写一百个语句,设计MySQL的大叔给我们提供了分组的概念。我们可以按照某个列将表中的数据进行分组,比方说我们现在按照subject列对表中数据进行分组,那么所有的记录就会被分成2组,如图所示:

让MySQL产生这样子的分组的语句就是GROUP BY子句,我们只要在GROUP BY后边把需要分组的列写上就好,然后在查询列表处就可以针对每一个分组来写相应的聚集函数去统计该分组,就像这样:

mysql> SELECT subject, AVG(score) FROM student_score GROUP BY subject;+-----------------------------+------------+| subject | AVG(score) |+-----------------------------+------------+| 母猪的产后护理 | 73.0000 || 论萨达姆的战争准备 | 73.2500 |+-----------------------------+------------+2 rows in set (0.00 sec)

报错

可以从上边带有GROUP BY子句的查询语句中看出来,我们只在查询列表处放了分组列subject以及对该分组中的记录调用的聚集函数AVG,那如果我们把不是分组列的字段也放到查询列表中会出现啥情况:

mysql> SELECT subject, name, AVG(score) FROM student_score GROUP BY subject;ERROR 1055 (42000): Expression #2 of SELECT list is not in GROUP BY clause and contains nonaggregated column 'dahaizi.student_score.name' which is not functionally dependent on columns in GROUP BY clause; this is incompatible with sql_mode=only_full_group_bymysql>

可以看到报错了,为啥会报错呢?回想一下我们使用GROUP BY子句的初衷,我们只是想把记录分为若干组,然后再对各个组分别调用聚集函数去做一些统计工作。本例中的查询列表处放置了既非分组列、又非聚集函数的name列,那我们想表达啥意思呢?从各个分组中的记录中取一个记录的name列?该取哪条记录为好呢?比方说对于'母猪的产后护理'这个分组中的记录来说,name列的值应该取杜子腾,还是杜琦燕,还是范统,还是史珍香呢?这个我们也不知道,所以把非分组列放到查询列表中会引起争议,导致结果不确定,所以设计MySQL的大叔才会为上述语句报错。

不过有的同学会说,假如分组后的某个分组的某个非分组列的值都一样,那我把该非分组列加入到查询列表中也没啥问题呀。比方说按照subject列进行分组后,假如在'母猪的产后护理'的分组中各条记录的name列的值都相同,在'论萨达姆的战争准备'的分组中各条记录的name列的值也都相同,那么我们把name列放在查询列表中也没啥问题。可能设计MySQL的大叔觉得这种说法也有点儿道理,他们竟然同意在一些情况下把非分组列也放到查询列表中,这就设计到一个称之为sql_mode的系统变量,我们先看一下在我的电脑上这个系统变量的值:

mysql> SHOW VARIABLES LIKE 'sql_mode';+---------------+-------------------------------------------------------------------------------------------------------------------------------------------+| Variable_name | Value |+---------------+-------------------------------------------------------------------------------------------------------------------------------------------+| sql_mode | ONLY_FULL_GROUP_BY,STRICT_TRANS_TABLES,NO_ZERO_IN_DATE,NO_ZERO_DATE,ERROR_FOR_DIVISION_BY_ZERO,NO_AUTO_CREATE_USER,NO_ENGINE_SUBSTITUTION |+---------------+-------------------------------------------------------------------------------------------------------------------------------------------+1 row in set (0.02 sec)

哇唔,好长的一段。不过大家不必在意,我们只关心其中一个称之为ONLY_FULL_GROUP_BY的家伙。只要sql_mode的值里边有这个东东,MySQL服务器就“比较正常”(也就是不允许非分组列放到查询列表中),但是如果我们把这个东东从sql_mode系统变量中移除(移除这个东东只要重新设置一下这个系统变量,把这个东东从值里边去除掉就好,我们现在不必要关心值里边儿后边那一坨东西是干嘛的,照着抄下来就好):

mysql> set sql_mode='STRICT_TRANS_TABLES,NO_ZERO_IN_DATE,NO_ZERO_DATE,ERROR_FOR_DIVISION_BY_ZERO,NO_AUTO_CREATE_USER,NO_ENGINE_SUBSTITUTION';Query OK, 0 rows affected (0.00 sec)

然后再执行上边那个曾经报错的语句:

mysql> SELECT subject, name, AVG(score) FROM student_score GROUP BY subject;+-----------------------------+-----------+------------+| subject | name | AVG(score) |+-----------------------------+-----------+------------+| 母猪的产后护理 | 杜子腾 | 73.0000 || 论萨达姆的战争准备 | 杜子腾 | 73.2500 |+-----------------------------+-----------+------------+2 rows in set (0.00 sec)

看,这回就不会报错了。但这是个好事儿么?个人觉得不是,因为MySQL服务器也不能保证结果集中的name列的值到底是分组中的哪条记录的。大家在日常工作中,也希望尽量不要用这个投机取巧的功能,没啥乱用,而且容易产生错误。

小贴士:不同MySQL版本中sql_mode的值可能默认包含ONLY_FULL_GROUP_BY这个家伙,也可能不包含ONLY_FULL_GROUP_BY这个家伙,也就是说不同MySQL版本中可能默认不支持查询列表中包含非分组列,也可能默认支持查询列表中包含非分组列。

MySQL冷知识:t1.id=t2.id=t3.id看着咋这么怪呢?

标签: 公众号文章

为了故事的顺利发展,我们先创建几个表:

CREATE TABLE t1 (id INT);CREATE TABLE t2 (id INT);CREATE TABLE t3 (id INT);

然后往这些表里插入一些数据(具体的插入语句就不写了),达到的效果就是这样:

mysql> SELECT * FROM t1;+----+| id |+----+| 1 || 2 || 3 |+----+3 rows in set (0.00 sec)mysql> SELECT * FROM t2;+----+| id |+----+| 1 || 2 || 3 |+----+3 rows in set (0.00 sec)mysql> SELECT * FROM t3;+----+| id |+----+| 1 || 2 || 3 |+----+3 rows in set (0.00 sec)

如果我们想对这三个表执行连接操作,把三个表中id列相同的记录都拿出来,有的同学可能会这样写:

SELECT t1.id AS t1_id, t2.id AS t2_id, t3.id AS t3_idFROM t1, t2, t3WHERE t1.id = t2.id = t3.id;

这样写会得到啥效果呢?我们看一下:

mysql> SELECT t1.id AS t1_id, t2.id AS t2_id, t3.id AS t3_id-> FROM t1, t2, t3-> WHERE t1.id = t2.id = t3.id;+-------+-------+-------+| t1_id | t2_id | t3_id |+-------+-------+-------+| 1 | 1 | 1 || 2 | 2 | 1 || 3 | 3 | 1 |+-------+-------+-------+3 rows in set (0.00 sec)mysql>

噫,发生了奇怪的事情,结果集中的第一条记录是符合我们预期的,但是剩下两条记录不符合我们预期,其中t3.id的值和t1.id、t2.id是不一样的,这是什么鬼呢?

哈哈,其实条件t1.id = t2.id = t3.id的真实含义是这样的:

(t1.id = t2.id) = t3.id

也就是说我们需要分两步理解这个表达式:

先运算

t1.id = t2.id,它其实是一个布尔表达式,得到的结果是0或者1。上一步骤得到的结果(也就是0或者1)再和

t3.id做比较。

让我们再分析一下上边的例子:

对于结果集的第一条记录来说,

t1.id的值为1、t2.id的值为1、t3.id的值为1。先比较

t1.id = t2.id是否成立,很显然1 = 1的结果是TRUE,MySQL中用1表示这个布尔表达式的结果。然后通过布尔表达式的结果

1再和t3.id比较,很显然1 = 1成立。

对于结果集的第二条记录来说,

t1.id的值为2、t2.id的值为2、t3.id的值为1。先比较

t1.id = t2.id是否成立,很显然2 = 2的结果是TRUE,MySQL中用1表示这个布尔表达式的结果。然后通过布尔表达式的结果

1再和t3.id比较,很显然1 = 1成立。

对于结果集的第三条记录来说,

t1.id的值为3、t2.id的值为3、t3.id的值为1。先比较

t1.id = t2.id是否成立,很显然3 = 3的结果是TRUE,MySQL中用1表示这个布尔表达式的结果。然后通过布尔表达式的结果

1再和t3.id比较,很显然1 = 1成立。

噫,原来t1.id = t2.id = t3.id是这个意思呀,那我们想要实现把三个表中id列值相同的记录取出来的效果该咋写?这么写:

SELECT t1.id AS t1_id, t2.id AS t2_id, t3.id AS t3_idFROM t1, t2, t3WHERE t1.id = t2.id AND t1.id = t3.id;

我们看下效果:

mysql> SELECT t1.id AS t1_id, t2.id AS t2_id, t3.id AS t3_id-> FROM t1, t2, t3-> WHERE t1.id = t2.id AND t1.id = t3.id;+-------+-------+-------+| t1_id | t2_id | t3_id |+-------+-------+-------+| 1 | 1 | 1 || 2 | 2 | 2 || 3 | 3 | 3 |+-------+-------+-------+3 rows in set (0.00 sec)

这样的话,MySQL才会把三个表中id列值相同的记录取出来呢~ 一定要记住这个知识点喔,小心哪天写三表连接的时候写错了还找不到原因呢~

小贴士:本文的这个问题是有《MySQL是怎样运行的:从根儿上理解MySQL》的微信讨论群里昵称为“白衬衫老胡同”的同学提问的,说实话我也把这个知识点忘掉了,在此感谢他的问题~

MySQL乱码

标签: 公众号文章

字符集转换概述

我们有必要说明一下,字符其实是面向人类的一个概念,计算机可并不关心字符是什么,它只关心这个字符对应的字节编码是什么。对于一个字节序列,计算机怎么知道它是使用什么字符集编码的呢?计算机不知道,所以其实在计算机中表示一个字符串时,都需要附带上它对应的字符集是什么,就像这样(以C++语言为例):

class String {byte* content;CHARSET_INFO* charset;}

比方说我们现在有一个以utf8字符集编码的汉字'我',那么意味着计算机中不仅仅要存储'我'的utf8编码0xE68891,还需要存储它是使用什么字符集编码的信息,就像这样:

{content: 0xE68891;charset: utf8;}

计算机内部包含将一种字符集转换成另一种字符集的函数库,也就是某个字符在某种字符集下的编码可以很顺利的转换为另一种字符集的编码,我们将这个过程称之为字符集转换。比方说我们可以将上述采用utf8字符集编码的字符'我',转换成gbk字符集编码的形式,就变成了这样:

{content: 0xCED2;charset: gbk;}

小贴士:我们上边所说的'编码'可以当作动词,也可以当作名词来理解。当作动词的话意味着将一个字符映射到一个字节序列的过程,当作名词的话意味着一个字符对应的字节序列。大家根据上下文理解'编码'的含义。

MySQL客户端和服务器是怎么通信的

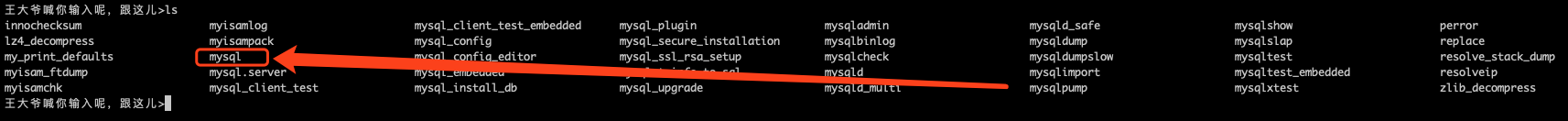

MySQL客户端发送给服务器的请求以及服务器发送给客户端的响应其实都是遵从一定格式的,我们把它们通信过程中事先规定好的数据格式称之为MySQL通信协议,这个协议是公开的,我们可以简单的使用wireshark等截包软件十分方便的分析这个通信协议。在了解了这个通信协议之后,我们甚至可以动手制作自己的客户端软件。市面上的MySQL客户端软件多种多样,我们并不想各个都分析一下,现在只选取在MySQL安装目录的bin目录下自带的mysql程序(此处的mysql程序指的是名字叫做mysql的一个可执行文件),如图所示:

我们在计算机的黑框框中执行该可执行文件,就相当于启动了一个客户端,就像这样:

小贴士:我们这里的'黑框框'指的是Windows操作系统中的cmd.exe或者UNIX系统中的Shell。

我们通常是按照下述步骤使用MySQL的:

- 启动客户端并连接到服务器

- 客户端发送请求。

- 服务器接收到请求

- 服务器处理请求

- 服务器处理请求完毕生成对该客户端的响应

- 客户端接收到响应

下边我们就详细分析一下每个步骤中都影响到了哪些字符集。

启动客户端并连接到服务器过程

每个MySQL客户端都维护者一个客户端默认字符集,这个默认字符集按照下边的套路进行取值:

自动检测操作系统使用的字符集

MySQL客户端会在启动时检测操作系统当前使用的字符集,并按照一定规则映射成为MySQL支持的一些字符集(通常是操作系统当前使用什么字符集,就映射为什么字符集,有一些特殊情况,比方说如果操作系统当前使用的是ascii字符集,会被映射为latin1字符集)。

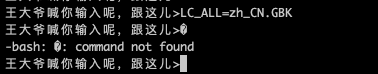

当我们使用UNIX操作系统时

此时会调用操作系统提供的

nl_langinfo(CODESET)函数来获取操作系统当前正在使用的字符集,而这个函数的结果是依赖LC_ALL、LC_CTYPE、LANG这三个环境变量的。其中LC_ALL的优先级比LC_CTYPE高,LC_CTYPE的优先级比LANG高。也就是说如果设置了LC_ALL,不论有没有设置LC_CTYPE或者LANG,最终都以LC_ALL为准;如果没有设置LC_ALL,那么就以LC_CTYPE为准;如果既没有设置LC_ALL也没有设置LC_CTYPE,就以LANG为准。比方说我们将环境变量LC_ALL设置为zh_CN.UTF-8,就像这样:export LC_ALL=zh_CN.UTF-8

那么我们在黑框框里启动MySQL客户端时,MySQL客户端就会检测到这个操作系统使用的是

utf8字符集,并将客户端默认字符集设置为utf8。当然,如果这三个环境变量都没有设置,那么

nl_langinfo(CODESET)函数将返回操作系统默认的字符集,比方说在我的macOS 10.15.3操作系统中,该默认字符集为:US-ASCII

此时MySQL客户端的默认字符集将会被设置为

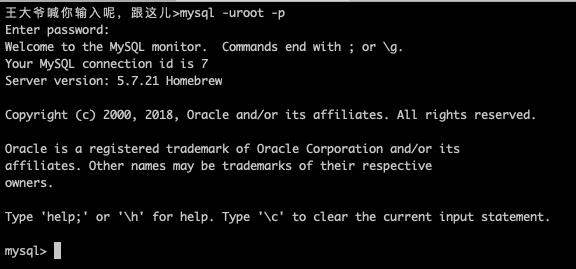

latin1。另外,我们这里还需要强调一下,我们使用的黑框框展示字符的时候有一个自己特有的字符集,比如在我的mac上使用

iTerm2作为黑框框,我们可以打开:Preferences->Profiles->Terminal选项卡,可以看到iTerm2使用utf8来展示字符:

我们一般要把黑框框展示字符时采用的编码和操作系统当前使用的编码保持一致,如果不一致的话,我们敲击的字符可能都无法显示到屏幕上。比方说如果我此时把LC_ALL属性设置成GBK,那么我们再向黑框框上输入汉字的话,屏幕都不会显示了,就像这样(如下图所示,我敲击了汉字'我'的效果):

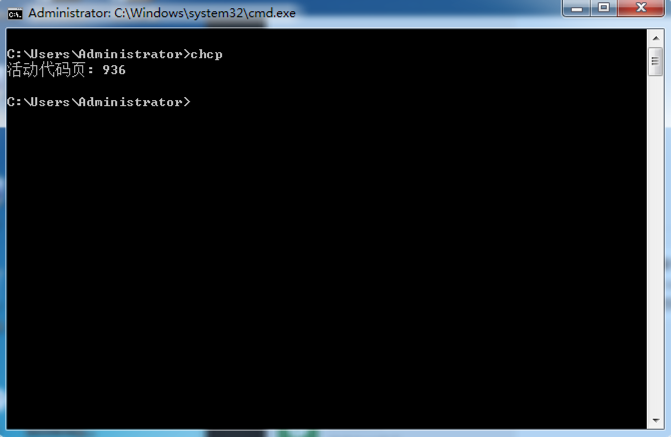

当我们使用Windows操作系统时

此时会调用操作系统提供的

GetConsoleCP函数来获取操作系统当前正在使用的字符集。在Windows里,会把当前cmd.exe使用的字符集映射到一个数字,称之为代码页(英文名:code page),我们可以通过右键点击cmd.exe标题栏,然后点击属性->选项,如下图所示,当前代码页的值是936,代表当前cmd.exe使用gbk字符集:

更简便一点,我们可以运行chcp命令直接看到当前code page是什么:

这样我们在黑框框里启动MySQL客户端时,MySQL客户端就会检测到这个操作系统使用的是gbk字符集,并将客户端默认字符集设置为gbk。我们前边提到的utf8字符集对应的代码页为65001,如果当前代码页的值为65001,之后再启动MySQL客户端,那么客户端的默认字符集就会变成utf8。

如果MySQL不支持自动检测到的操作系统当前正在使用的字符集,或者在某些情况下不允许自动检测的话,MySQL会使用它自己的内建的默认字符集作为客户端默认字符集。这个内建的默认字符集在

MySQL 5.7以及之前的版本中是latin1,在MySQL 8.0中修改为了utf8mb4。使用了

default-character-set启动参数如果我们在启动MySQL客户端是使用了

default-character-set启动参数,那么客户端的默认字符集将不再检测操作系统当前正在使用的字符集,而是直接使用启动参数default-character-set所指定的值。比方说我们使用如下命令来启动客户端:mysql --default-character-set=utf8

那么不论我们使用什么操作系统,操作系统目前使用的字符集是什么,我们都将会以utf8作为MySQL客户端的默认字符集。

在确认了MySQL客户端默认字符集之后,客户端就会向服务器发起登陆请求,传输一些诸如用户名、密码等信息,在这个请求里就会包含客户端使用的默认字符集是什么的信息,服务器收到后就明白了稍后客户端即将发送过来的请求是采用什么字符集编码的,自己生成的响应应该以什么字符集编码了(剧透一下:其实服务器在明白了客户端使用的默认字符集之后,就会将character_set_client、character_set_connection以及character_set_result这几个系统变量均设置为该值)。

客户端发送请求

登陆成功之后,我们就可以使用键盘在黑框框中键入我们想要输入的MySQL语句,输入完了之后就可以点击回车键将该语句当作请求发送到服务器,可是客户端发送的语句(本质是个字符串)到底是采用什么字符集编码的呢?这其实涉及到应用程序和操作系统之间的交互,我们的MySQL客户端程序其实是一个应用程序,它从黑框框中读取数据其实是要调用操作系统提供的读取接口。在不同的操作系统中,调用的读取接口其实是不同的,我们还得分情况讨论一下:

对于UNIX操作系统来说

在我们使用某个输入法软件向黑框框中输入字符时,该字符采用的编码字符集其实是操作系统当前使用的字符集。比方说当前

LC_ALL环境变量的值为zh_CN.UTF-8,那么意味着黑框框中的字符其实是使用utf8字符集进行编码。稍后MySQL客户端程序将调用操作系统提供的read函数从黑框框中读取数据(其实就是所谓的从标准输入流中读取数据),所读取的数据其实就是采用utf8字符集进行编码的字节序列,稍后将该字节序列作为请求内容发送到服务器。这样其实会产生一个问题,如果客户端的默认字符集和操作系统当前正在使用的字符集不同,那么将产生比较尴尬的结果。比方说我们在启动客户端是携带了

--default-character-set=gbk的启动参数,那么客户端的默认字符集将会被设置成gbk,而如果操作系统此时采用的字符集是utf8。比方说我们的语句中包含汉字'我',那么客户端调用read函数读到的字节序列其实是0xE68891,从而将0xE68891发送到服务器,而服务器认为客户端发送过来的请求都是采用gbk进行编码的,这样就会产生问题(当然,这仅仅是发生乱码问题的前奏,并不意味着产生乱码,乱码只有在最后一步,也就是客户端应用程序将服务器返回的数据写到黑框框里时才会发生)。对于Windows操作系统来说

在Windows操作系统中,从黑框框中读取数据调用的是Windows提供的

ReadConsoleW函数。在该函数执行后,MySQL客户端会得到一个宽字符数组(其实就是一组16位的UNICODE),然后客户端需要把该宽字符数组再次转换成客户端使用的默认字符集编码的字节序列,然后才将该字节序列作为请求的内容发送到服务器。这样在UNIX操作系统中可能产生的问题,在Windows系统中却可以避免。比方说我们在启动客户端是携带了

--default-character-set=gbk的启动参数,那么客户端的默认字符集将会被设置成gbk,假如此时操作系统采用的字符集是utf8。比方说我们的语句中包含汉字'我',那么客户端调用ReadConsoleW函数先读到一个代表着我字的宽字符数组,之后又将其转换为客户端的默认字符集,也就是gbk字符集编码的数据0xCED2,然后将0xCED2发送到服务器。此时服务器也认为客户端发送过来的请求就是采用gbk进行编码的,这样就完全正确了~

服务器接收请求

服务器接收到到的请求本质上就是一个字节序列,服务器将其看作是采用系统变量character_set_client代表的字符集进行编码的字节序列。character_set_client是一个SESSION级别的系统变量,也就是说每个客户端和服务器建立连接后,服务器都会为该客户端维护一个单独的character_set_client变量,每个客户端在登录服务器的时候都会将客户端的默认字符集通知给服务器,然后服务器设置该客户端专属的character_set_client。

我们可以使用SET命令单独修改character_set_client对应的值,就像这样:

SET character_set_client=gbk;

需要注意的是,character_set_client对应的字符集一定要包含请求中的字符,比方说我们把character_set_client设置成ascii,而请求中发送了一个汉字'我',将会发生这样的事情:

mysql> SET character_set_client=ascii;Query OK, 0 rows affected (0.00 sec)mysql> SHOW VARIABLES LIKE 'character%';+--------------------------+------------------------------------------------------+| Variable_name | Value |+--------------------------+------------------------------------------------------+| character_set_client | ascii || character_set_connection | utf8 || character_set_database | utf8 || character_set_filesystem | binary || character_set_results | utf8 || character_set_server | utf8 || character_set_system | utf8 || character_sets_dir | /usr/local/Cellar/mysql/5.7.21/share/mysql/charsets/ |+--------------------------+------------------------------------------------------+8 rows in set (0.00 sec)mysql> SELECT '我';+-----+| ??? |+-----+| ??? |+-----+1 row in set, 1 warning (0.00 sec)mysql> SHOW WARNINGS\G*************************** 1. row ***************************Level: WarningCode: 1300Message: Invalid ascii character string: '\xE6\x88\x91'1 row in set (0.00 sec)

如图所示,最后提示了'E6、88、91'并不是正确的ascii字符。

小贴士:可以将character_set_client设置为latin1,看看还会不会报告WARNINGS,以及为什么~

服务器处理请求

服务器在处理请求时会将请求中的字符再次转换为一种特定的字符集,该字符集由系统变量character_set_connection表示,该系统变量也是SESSION级别的。每个客户端在登录服务器的时候都会将客户端的默认字符集通知给服务器,然后服务器设置该客户端专属的character_set_connection。

不过我们之后可以通过SET命令单独修改这个character_set_connection系统变量。比方说客户端发送给服务器的请求中包含字节序列0xE68891,然后服务器针对该客户端的系统变量character_set_client为utf8,那么此时服务器就知道该字节序列其实是代表汉字'我',如果此时服务器针对该客户端的系统变量character_set_connection为gbk,那么在计算机内部还需要将该字符转换为采用gbk字符集编码的形式,也就是0xCED2。

有同学可能会想这一步有点儿像脱了裤子放屁的意思,但是大家请考虑下边这个查询语句:

mysql> SELECT 'a' = 'A';

请问大家这个查询语句的返回结果应该是TRUE还是FALSE?其实结果是不确定。这是因为我们并不知道比较两个字符串的大小到底比的是什么!我们应该从两个方面考虑:

考虑一:这些字符串是采用什么字符集进行编码的呢?

考虑二:在我们确定了编码这些字符串的字符集之后,也就意味着每个字符串都会映射到一个字节序列,那么我们怎么比较这些字节序列呢,是直接比较它们二进制的大小,还是有别的什么比较方式?比方说

'a'和'A'在utf8字符集下的编码分别为0x61和0x41,那么'a' = 'A'是应该直接比较0x61和0x41的大小呢,还是将0x61减去32之后再比较大小呢?其实这两种比较方式都可以,每一种比较方式我们都称作一种比较规则(英文名:collation)。

MySQL中支持若干种字符集,我们可以使用SHOW CHARSET命令查看,如下图所示(太多了,只展示几种,具体自己运行一下该命令):

mysql> SHOW CHARSET;+----------+---------------------------------+---------------------+--------+| Charset | Description | Default collation | Maxlen |+----------+---------------------------------+---------------------+--------+| big5 | Big5 Traditional Chinese | big5_chinese_ci | 2 || latin1 | cp1252 West European | latin1_swedish_ci | 1 || latin2 | ISO 8859-2 Central European | latin2_general_ci | 1 || ascii | US ASCII | ascii_general_ci | 1 || gb2312 | GB2312 Simplified Chinese | gb2312_chinese_ci | 2 || gbk | GBK Simplified Chinese | gbk_chinese_ci | 2 || utf8 | UTF-8 Unicode | utf8_general_ci | 3 || utf8mb4 | UTF-8 Unicode | utf8mb4_general_ci | 4 || utf16 | UTF-16 Unicode | utf16_general_ci | 4 || utf16le | UTF-16LE Unicode | utf16le_general_ci | 4 || utf32 | UTF-32 Unicode | utf32_general_ci | 4 || binary | Binary pseudo charset | binary | 1 || gb18030 | China National Standard GB18030 | gb18030_chinese_ci | 4 |+----------+---------------------------------+---------------------+--------+41 rows in set (0.04 sec)

其中每一种字符集又对应着若干种比较规则,我们以utf8字符集为例(太多了,也只展示几个):

mysql> SHOW COLLATION WHERE Charset='utf8';+--------------------------+---------+-----+---------+----------+---------+| Collation | Charset | Id | Default | Compiled | Sortlen |+--------------------------+---------+-----+---------+----------+---------+| utf8_general_ci | utf8 | 33 | Yes | Yes | 1 || utf8_bin | utf8 | 83 | | Yes | 1 || utf8_unicode_ci | utf8 | 192 | | Yes | 8 || utf8_icelandic_ci | utf8 | 193 | | Yes | 8 || utf8_latvian_ci | utf8 | 194 | | Yes | 8 || utf8_romanian_ci | utf8 | 195 | | Yes | 8 |+--------------------------+---------+-----+---------+----------+---------+27 rows in set (0.00 sec)

其中utf8_general_ci是utf8字符集默认的比较规则,在这种比较规则下是不区分大小写的,不过utf8_bin这种比较规则就是区分大小写的。

在我们将请求中的字节序列转换为character_set_connection对应的字符集编码的字节序列后,也要配套一个对应的比较规则,这个比较规则就由collation_connection系统变量来指定。我们现在通过SET命令来修改一下 和

collation_connection的值分别设置为utf8和utf8_general_ci,然后比较一下'a'和'A':

mysql> SET character_set_connection=utf8;Query OK, 0 rows affected (0.00 sec)mysql> SET collation_connection=utf8_general_ci;Query OK, 0 rows affected (0.00 sec)mysql> SELECT 'a' = 'A';+-----------+| 'a' = 'A' |+-----------+| 1 |+-----------+1 row in set (0.00 sec)

可以看到在这种情况下这两个字符串就是相等的。

我们现在通过SET命令来修改一下 和

collation_connection的值分别设置为utf8和utf8_bin,然后比较一下'a'和'A':

mysql> SET character_set_connection=utf8;Query OK, 0 rows affected (0.00 sec)mysql> SET collation_connection=utf8_bin;Query OK, 0 rows affected (0.00 sec)mysql> SELECT 'a' = 'A';+-----------+| 'a' = 'A' |+-----------+| 0 |+-----------+1 row in set (0.00 sec)

可以看到在这种情况下这两个字符串就是不相等的。

当然,如果我们并不需要单独指定将请求中的字符串采用何种字符集以及比较规则的话,并不用太关心character_set_connection和collation_connection设置成啥,不过需要注意一点,就是character_set_connection对应的字符集必须包含请求中的字符。

服务器处理请求完毕生成对该客户端的响应

为了故事的顺利发展,我们先创建一个表:

CREATE TABLE t (c VARCHAR(100)) ENGINE=INNODB CHARSET=utf8;

然后向这个表插入一条记录:

INSERT INTO t VALUE('我');

现在这个表中的数据就如下所示:

mysql> SELECT * FROM t;+------+| c |+------+| 我 |+------+1 row in set (0.00 sec)

我们可以看到该表中的字段其实是使用utf8字符集编码的,所以底层存放格式是:0xE68891,将它读出后需要发送到客户端,是不是直接将0xE68891发送到客户端呢?这可不一定,这个取决于character_set_result系统变量的值,该系统变量也是一个SESSION级别的变量。服务器会将该响应转换为character_set_result系统变量对应的字符集编码后的字节序列发送给客户端。每个客户端在登录服务器的时候都会将客户端的默认字符集通知给服务器,然后服务器设置该客户端专属的character_set_result。

我们也可以使用SET命令来设置character_set_result的值。不过也需要注意,character_set_result对应的字符集应该包含响应中的字符。

这里再强调一遍,character_set_client、character_set_connection和character_set_result这三个系统变量是服务器的系统变量,每个客户端在与服务器建立连接后,服务器都会为这个连接维护这三个变量,如图所示(我们假设连接1的这三个变量均为utf8,连接1的这三个变量均为gbk,连接1的这三个变量均为ascii,):

一般情况下character_set_client、character_set_connection和character_set_result这三个系统变量应该和客户端的默认字符集相同,SET names命令可以一次性修改这三个系统变量:

SET NAMES 'charset_name'

该语句和下边三个语句等效:

SET character_set_client = charset_name;SET character_set_results = charset_name;SET character_set_connection = charset_name;

不过这里需要大家特别注意,SET names语句并不会改变客户端的默认字符集!

客户端接收到响应

客户端收到的响应其实仍然是一个字节序列。客户端是如何将这个字节序列写到黑框框中的呢,这又涉及到应用程序和操作系统之间的一次交互。

对于UNIX操作系统来说,MySQL客户端向黑框框中写入数据使用的是操作系统提供的

fputs、putc或者fwrite函数,这些函数基本上相当于直接就把接收到的字节序列写到了黑框框中(请注意我们用词:'基本上相当于',其实内部还会做一些工作,但是我们这里就不想再关注这些细节了)。此时如果该字节序列实际的字符集和黑框框展示字符所使用的字符集不一致的话,就会发生所谓的乱码(大家注意,这个时候和操作系统当前使用的字符集没啥关系)。比方说我们在启动MySQL客户端的时候使用了

--default-character-set=gbk的启动参数,那么服务器的character_set_result变量就是gbk。然后再执行SELECT * FROM t语句,那么服务器就会将字符'我'的gbk编码,也就是0xCDE2发送到客户端,客户端直接把这个字节序列写到黑框框中,如果黑框框此时采用utf8字符集展示字符,那自然就会发生乱码。对于Windows操作系统来说,MySQL客户端向黑框框中写入数据使用的是操作系统提供的

WriteConsoleW函数,该函数接收一个宽字符数组,所以MySQL客户端调用它的时候需要显式地将它从服务器收到的字节序列按照客户端默认的字符集转换成一个宽字符数组。正因为这一步骤的存在,所以可以避免上边提到的一个问题。比方说我们在启动MySQL客户端的时候使用了

--default-character-set=gbk的启动参数,那么服务器的character_set_result变量就是gbk。然后再执行SELECT * FROM t语句,那么服务器就会将字符'我'的gbk编码,也就是0xCDE2发送到客户端,客户端将这个字节序列先从客户端默认字符集,也就是gbk的编码转换成一个宽字符数组,然后再调用WriteConsoleW函数写到黑框框,黑框框自然可以把它显示出来。

乱码问题应该如何分析

好了,介绍了各个步骤中涉及到的各种字符集,大家估计也看的眼花缭乱了,下边总结一下我们遇到乱码的时候应该如何分析,而不是胡子眉毛一把抓,随便百度一篇文章,然后修改某个参数,运气好修改了之后改对了,运气不好改了一天也改不好。知其然也要知其所以然,在学习了本篇文章后,大家一定要有节奏的去分析乱码问题:

我使用的是什么操作系统

对于UNIX系统用户来说,要搞清楚我使用的黑框框到底是使用什么字符集展示字符,就像是

iTerm2中的character encoding属性:

同样还要搞清楚操作系统当前使用什么字符集,运行locale命令查看:王大爷喊你输入呢,跟这儿>localeLANG=""LC_COLLATE="zh_CN.UTF-8"LC_CTYPE="zh_CN.UTF-8"LC_MESSAGES="zh_CN.UTF-8"LC_MONETARY="zh_CN.UTF-8"LC_NUMERIC="zh_CN.UTF-8"LC_TIME="zh_CN.UTF-8"LC_ALL="zh_CN.UTF-8"王大爷喊你输入呢,跟这儿>

没有什么特别极端的特殊需求的话,一定要保证上述两个字符集是相同的,否则可能连汉字都输入不进去!

对于Windows用户来说

搞清楚自己使用的黑框框的代码页是什么,也就是操作系统当前使用的字符集是什么。

搞清楚客户端的默认字符集是什么

启动MySQL客户端的时候有没有携带

--default-character-set参数,如果携带了,那么客户端默认字符集就以该参数指定的值为准。否则分析自己操作系统当前使用的字符集是什么。搞清楚客户端发送请求时是以什么字符集编码请求的

对于UNIX系统来说,我们可以认为请求就是采用操作系统当前使用的字符集进行编码的。

对于Windows系统来说,我们可以认为请求就是采用客户端默认字符集进行编码的。

通过执行

SHOW VARIABLES LIKE 'character%'命令搞清楚:character_set_client:服务器是怎样认为客户端发送过来的请求是采用何种字符集编码的character_set_connection:服务器在运行过程中会采用何种字符集编码请求中的字符character_set_result:服务器会将响应使用何种字符集编码后再发送给客户端的

客户端收到响应之后:

对于服务器发送过来的字节序列来说:

在UNIX操作系统上,可以认为会把该字节序列直接写到黑框框里。此时应该搞清楚我们的黑框框到底是采用何种字符集展示数据。

在Windows操作系统上,该字节序列会被认为是由客户端字符集编码的数据,然后再转换成宽字符数组写入到黑框框中。

请认真分析上述的每一个步骤,然后发出惊呼:小样,不就是个乱码嘛,还治不了个你!

字符从UTF-8转成GBK发生了什么?

标签: 公众号文章

字符是什么

字符是面向人类的概念,大致可分为两种,一种叫可见字符,一种叫不可见字符。

顾名思义,可见字符就是打印出来后能看见的字符。比如a、b、我这样的人眼能看见的单个国家文字、标点符号、图形符号、数字等这样的东东,我们就叫做一个可见字符。

不可见字符也好理解,就是之前打印机或者在黑框框里打印字符的时候有时候需要换行,打个制表符啥的,或者在输出某个字符的时候就发出嘟地一声,这种我们看不到,只是为了控制输出效果的字符叫做不可见字符。

注意,字符都是单个的喔!。把字符连起来叫做字符串,比如abc,就是由a、b、c三个字符连起来的一个字符串。

计算机怎么表示字符

计算机只能处理二进制数据,它并不认识字符。为了让计算机能处理字符,人们人为地在字符和二进制数字之间建立起了映射关系,映射的过程可以被称作编码,字符和二进制数字的映射关系也可以被称作编码方案。由于谁都可以制作编码方案,不同地人制作出了不同地编码方案。制作一种编码方案说清楚两个事就可以:

- 要对哪些字符进行编码

- 具体地每个字符和哪个二进制数字关联起来

虽然说谁都可以制作编码方案,但随着时间的流逝,只有为数不多的编码方案流行起来,比方说:

ASCII:收录128个字符,用7个二进制位就可以进行编码。但通常计算机以字节作为基本的存储空间分配单位,所以在ASCII编码方案中,通常使用1个字节对1个字符进行编码。

ISO 8859-1:收录256个字符,可用1个字节进行编码,兼容ASCII编码方案。

GBK:收录21886个字符,用

1~2个字节进行编码,兼容ASCII编码方案。UNICODE:收录目前世界上各式各样的字符。每个字符都对应一个数字,被称作Unicode值。该Unicode值可以被表示为多种形式,称作Unicode Transformation Formats,简称UTF。比方说:

- UTF-8:目前采用1~4个字节来表示一个Unicode值(随着Unicode中字符的扩充,可能使用更多的字节编码一个字符),并且兼容ASCII编码方案。

- UTF-16:目前采用2个或4个字节来表示一个Unicode值。

- UTF-32:目前采用4个字节来表示一个Unicode值

由于我们之前详细唠叨过不同编码方案是如何编码字符的,所以本文就不再赘述了。本文来唠叨一下不同字符编码方案之间是如何相互转换的。

字符编码方案的转换

对于字符'我'来说:

- 在

UTF-8中的编码值的二进制形式为:

11100110 10001000 10010001

共3个字节,写成十六进制的形式就是:0xE68891。

- 在

GBK中的编码值的二进制形式为:

11001110 11010010

共2字节,写成十六进制的形式就是:0xCED2

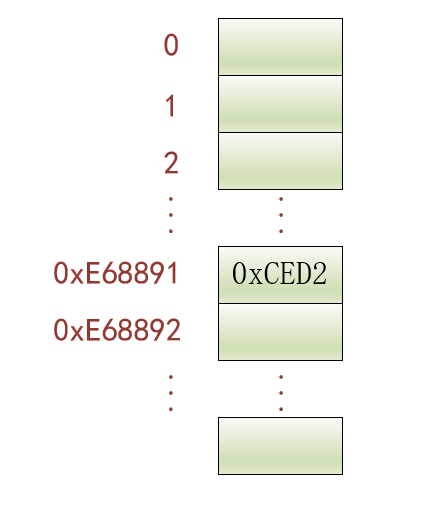

在某个需要将字符串的字符编码方案从UTF-8转成GBK的场景中,怎么把0xE68891转换成0xCED2呢?

解决这个问题其实很简单,我们可以制作一个大型数组, 数组大小就是源编码方案中包含的字符数量,这样在源编码方案中的每个字符的编码值都对应数组的一个下标。这样每个数组下标都对应一个字符,我们只需要将相应字符的目标编码方案的编码值填入到该下标对应的数组元素中。比方说:

也就是说对于某个字符来说,数组下标就是源编码方案的编码值,数组元素值就是目标编码方案的编码值。这样就可以很轻松的完成某个字符的编码方案转换功能。

这个方案是有很大缺点的,因为UTF-8中包含的字符数量是远超GBK的,这就导致我们申请的数组的存储空间有绝大部分是被浪费掉的。其实数组里只需要把GBK编码方案中的字符编码都存储上即可,这样可以显著减小数组大小,但是由于我们又要要求根据字符的UTF-8编码值作为下标找到对应的GBK编码值,这时候就有点儿犯难。。。

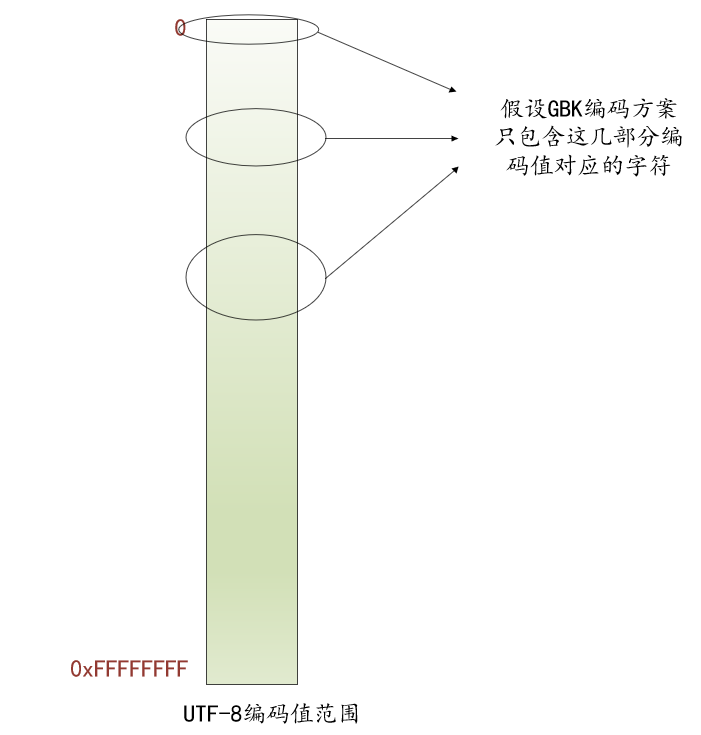

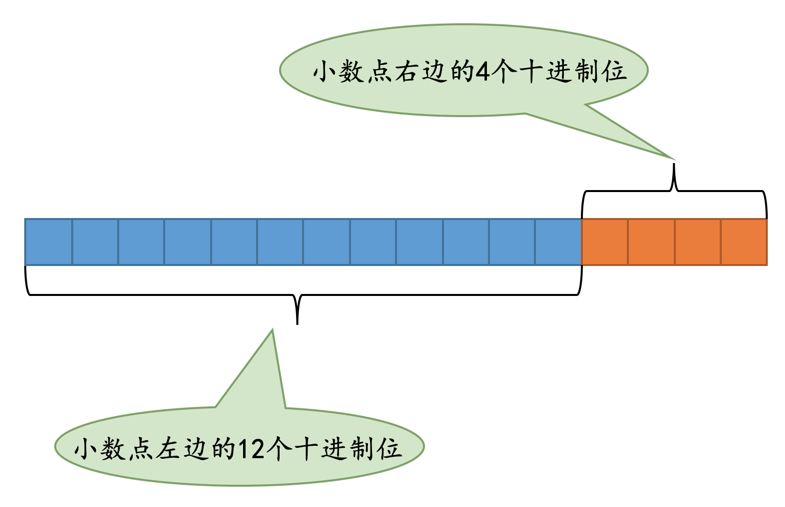

其实GBK编码方案中包含的字符只会被包含在UTF-8编码方案的几部分中:

如上图所示,画圈部分的UTF-8编码值对应的字符就已经可以覆盖GBK编码方案中的字符了。当然,画圈部分的UTF-8编码值对应的某些字符也可能GBK编码方案并不包含,但这并不会有什么大问题,只是在申请数组的存储空间的时候浪费掉一些而已。

这样针对每一个圈,我们都可以建立一个数组,数组大小就是圈中UTF-8编码值的数量,每个圈对应数组的下标0都对应该圈包含的第1个UTF-8编码值,数组元素值就是相应下标对应的UTF-8编码值对应字符的GBK编码值。这样就可以极大程度减少数组占用的存储空间大小了。

那如果是UTF-16转GBK呢?

简单,再仿造上述步骤建立从UTF-16的编码值映射到GBK编码值的数组呗!

那如果是BIG5转GBK呢?

简单,再仿造上述步骤建立从BIG5的编码值映射到GBK编码值的数组呗!

那如果是UTF-16转BIG5呢?

还得建立相应的数组...

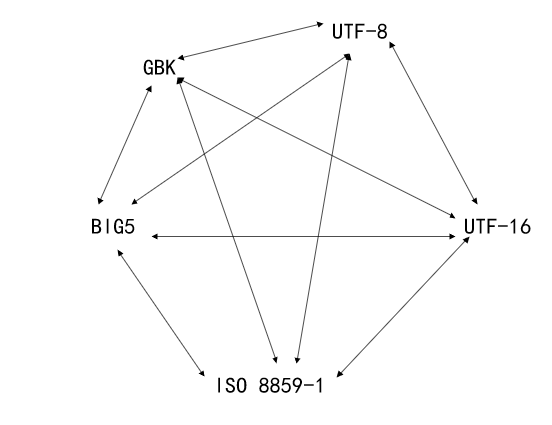

好像很烦噢,字符编码方案多种多样,想实现任意两个编码方案都可以相互转换的话,那我们得建立多少数组呀!如下图所示:

而且编码方案也可以随时增加,没新增一种编码方案都要考虑到与其他编码方案如何相互转换的问题实在太繁琐了。有没有什么好的方案呢?

有!比方有5个人分别会说汉语、英语、法语、俄语、阿拉伯语,如果想让他们之间任意两个人可以相互沟通,其实也没必要让每个人都学会其他4种语言,只需要规定大家都会同一门语言,比方说汉语!这样大家只需要学习一门外语即可相互沟通(会汉语的甚至都不用再学一遍外语了)!

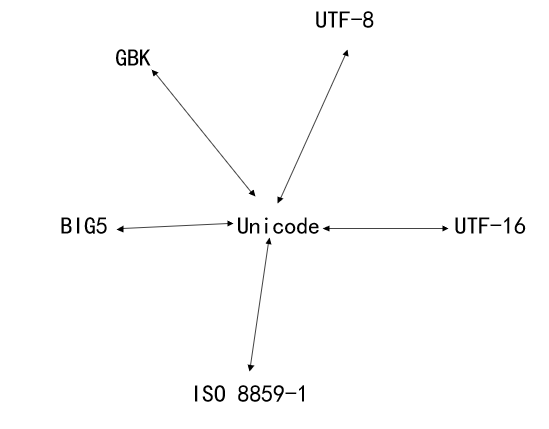

在将某个字符从一种编码方案转换成另一种编码方案时,我们不必单独维护从源编码方案到目标编码方案的转换数组,只需要先将源编码方案转换成一种中间编码方案,再将中间编码方案转换成目标编码方案。这样对于任何一种编码方案来说,仅需维护它与中间编码方案的转换数组即可。这个中间编码方案指的就是Unicode!如下图所示:

这样在将UTF-8编码值转换为GBK编码值时,需完成两步:

- 先将UTF-8编码值转换为Unicode值

- 再将Unicode值转换为GBK编码值

MySQL的实现

不像我们应用程序员直接调用某个库的进行字符编码转换的函数,MySQL为了尽量减少依赖,自己实现了各种字符编码方案以及它们之间的转换。我们下边以'我'字为例,看一下它是怎么实现从UTF-8编码方案转换成GBK编码方案的。

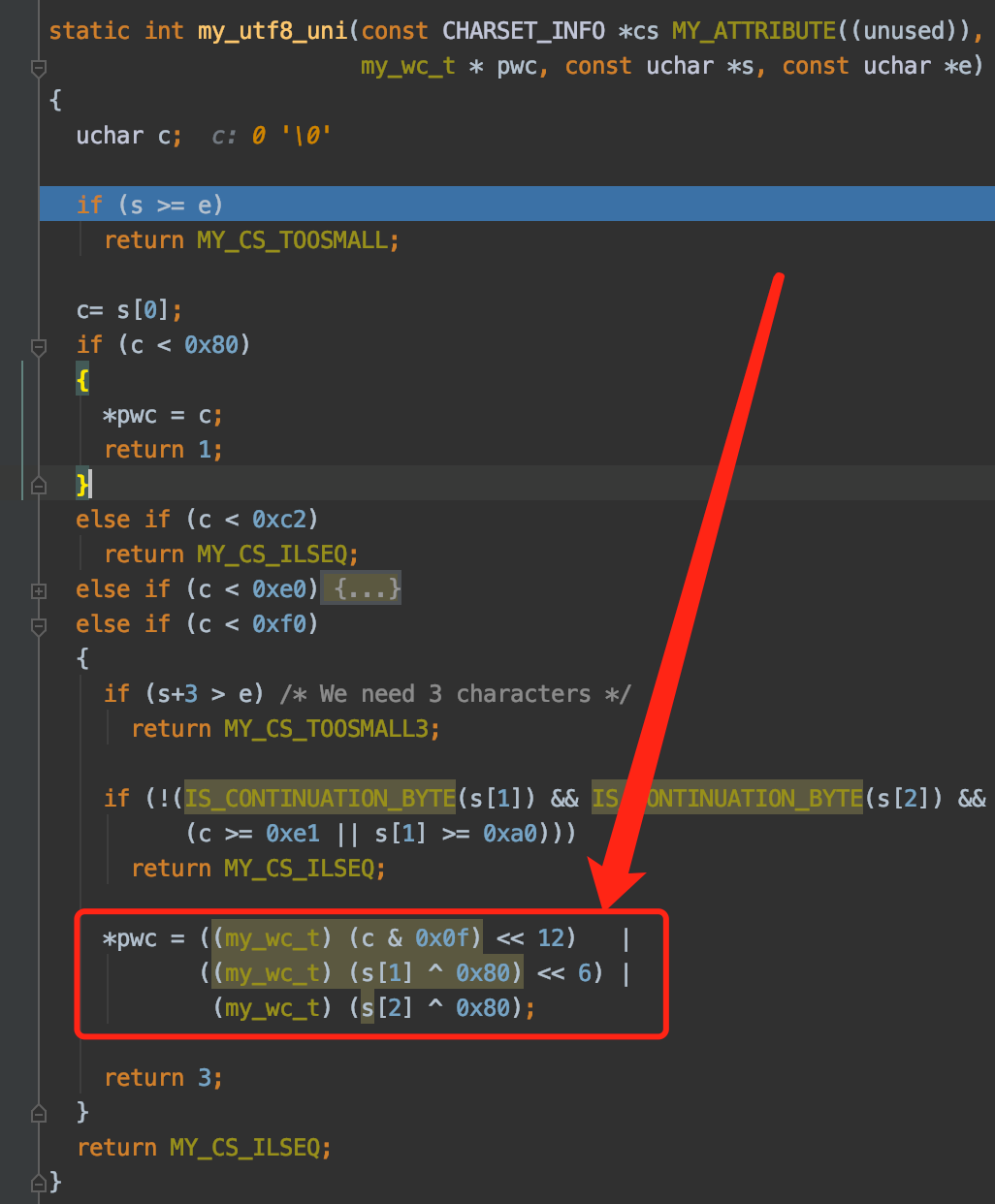

从UTF-8编码值获取对应的Unicode值

my_utf8_uni是用于获取UTF-8编码字符对应的Unicode值的函数,红色箭头指向的是实际操作过程。比方说字符'我'的UTF-8编码值是0xE68891,那就需要做如下操作:

((0xE6 & 0x0f) << 12) |((0x88 ^ 0x80) << 6) |(0x91 ^ 0x80)

得到的结果是十进制的25105,这个25105就是字符'我'对应的Unicode值

从Unicode值获取对应GBK编码值

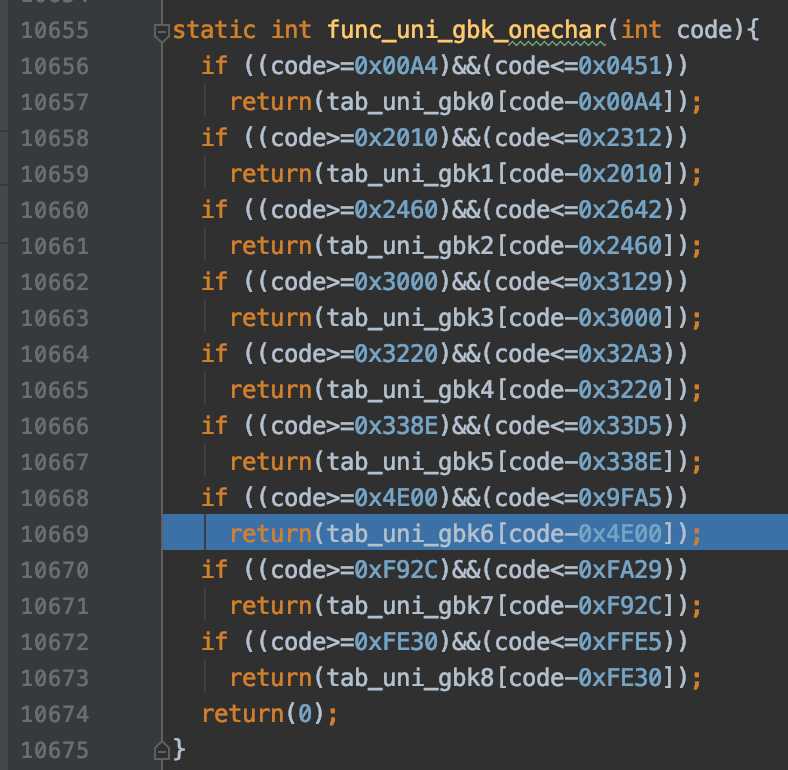

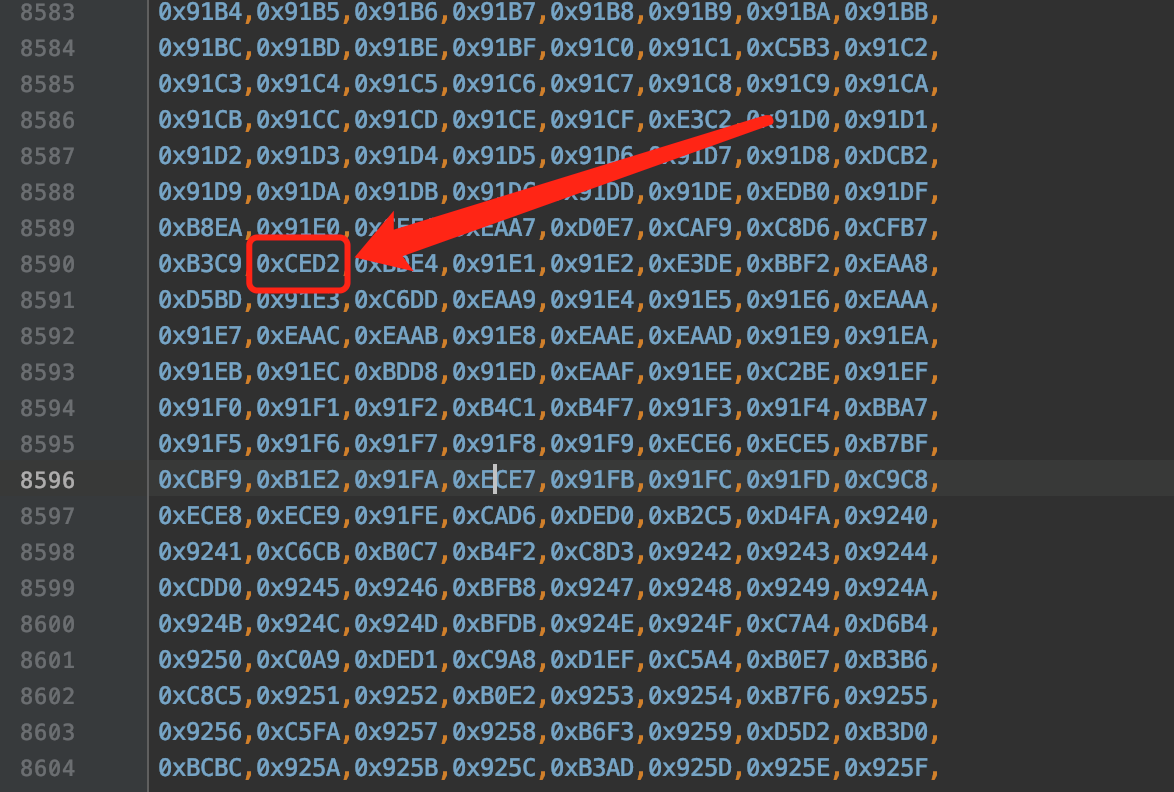

func_uni_gbk_onechar是根据Unicode值获取对应的GBK编码值的函数。从该函数的实现中可以看到,设计MySQL的大叔把包含在GBK编码方案中的字符对应的Unicode值分成了9个组,分别是tab_uni_gbk0~tab_uni_gbk8,当然,这些组中也包含了一些不属于GBK编码方案的字符对应的Unicode值,比方说第一个组tab_uni_gbk0:

其中值为0的元素对应的字符就是不包含在GBK编码方案中的。

如果让每一个组中仅包含GBK字符的话,这会导致组划分的过多。出于在组的数量和浪费的存储空间方面做出取舍,就形成了现在这种划分了9个组的方案。

由于字符'我'对应的Unicode值25105其实是在tab_uni_gbk6中的,我们看一下数组tab_uni_gbk6的下标为25105-0x4E00,也就是5137的元素的值是什么:

是他!是他!就是他!就是我们的0xCED2!

MySQL的定点数类型

标签: 公众号文章

上一篇文章我们唠叨了浮点数,知道了浮点数存储小数是不精确的。本篇继续唠叨一下MySQL中的另一种存储小数的方式 —— 定点数。

定点数类型

正因为用浮点数表示小数可能会有不精确的情况,在一些情况下我们必须保证小数是精确的,所以设计MySQL的大叔们提出一种称之为定点数的数据类型,它也是存储小数的一种方式:

| 类型 | 占用的存储空间(单位:字节) | 取值范围 |

|---|---|---|

DECIMAL(M, D) |

取决于M和D | 取决于M和D |

其中:

M表示该小数最多需要的十进制有效数字个数。注意是

有效数字个数,比方说对于小数-2.3来说有效数字个数就是2,对于小数0.9来说有效数字个数就是1。D表示该小数的小数点后的十进制数字个数。这个好理解,小数点后有几个十进制数字,

D的值就是什么。

举个例子看一下,设置了M和D的单精度浮点数的取值范围的变化:

| 类型 | 取值范围 |

|---|---|

DECIMAL(4, 1) |

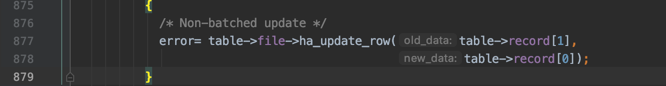

-999.9~999.9 |

DECIMAL(5, 1) |

-9999.9~9999.9 |

DECIMAL(6, 1) |

-99999.9~99999.9 |

DECIMAL(4, 0) |

-9999~9999 |

DECIMAL(4, 1) |

-999.9~999.9 |

DECIMAL(4, 2) |

-99.99~99.99 |

可以看到,在D相同的情况下,M越大,该类型的取值范围越大;在M相同的情况下,D越大,该类型的取值范围越小。当然,M和D的取值也不是无限大的,M的取值范围是1~255,D的取值范围是0~30,而且D的值必须不大于M。M和D都是可选的,如果我们省略了它们,那它们的值按照机器支持的最大值来存储。

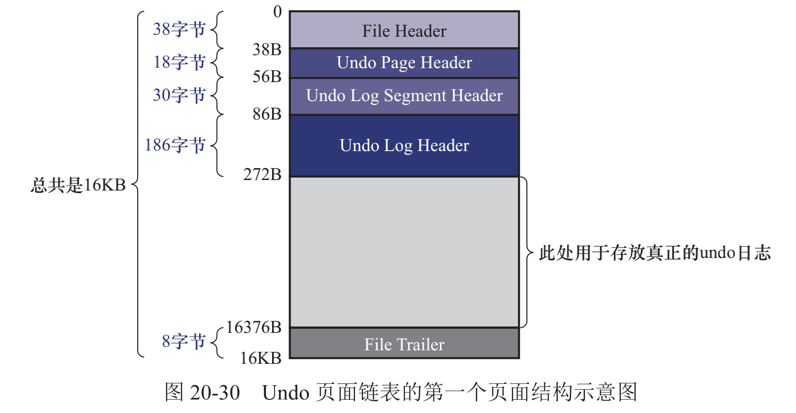

我们说定点数是一种精确的小数,为了达到精确的目的我们就不能把它转换成二进制小数之后再存储(因为有很多十进制小数转为二进制小数后需要进行舍入操作,导致二进制小数表示的数值是不精确的)。其实转念一想,所谓的小数只是把两个十进制整数用小数点分割开来而已,我们只要把小数点左右的两个十进制整数给存储起来,那不就是精确的了么。比方说对于十进制小数2.38来说,我们可以把这个小数的小数点左右的两个整数,也就是2和38分别保存起来,那么不就相当于保存了一个精确的小数么,这波操作是不是很6。

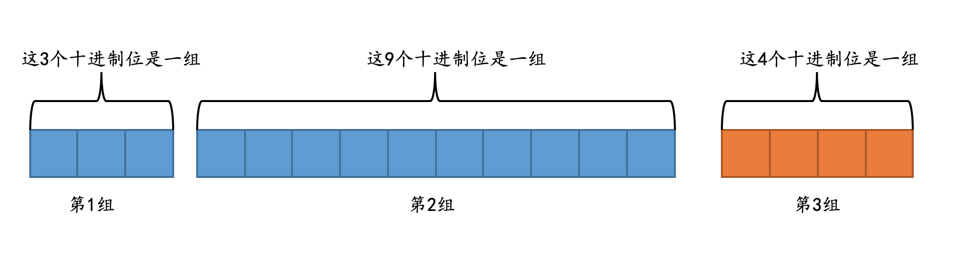

当然事情并没有这么简单,对于给定M、D值的DECIMAL(M, D)类型,比如DEMCIMAL(16, 4)来说:

首先确定小数点左边的整数最多需要存储的十进制位数是12位,小数点右边的整数需要存储的十进制位数是4位,如图所示:

从小数点位置出发,每个整数每隔9个十进制位划分为1组,效果就是这样:

从图中可以看出,如果不足9个十进制位,也会被划分成一组。

针对每个组中的十进制数字,将其转换为二进制数字进行存储,根据组中包含的十进制数字位数不同,所需的存储空间大小也不同,具体见下表:

组中包含的十进制位数 占用存储空间大小(单位:字节) 1或2 1 3或4 2 5或6 3 7或8或9 4 所以

DECIMAL(16, 4)共需要占用8个字节的存储空间大小,这8个字节由下边3个部分组成:- 第1组包含3个十进制位,需要使用2个字节存储。

- 第2组包含9个十进制位,需要使用4个字节存储。

- 第3组包含4个十进制位,需要使用2个字节存储。

将转换完成的比特位序列的最高位设置为1。

这些步骤看的有一丢丢懵逼吧,别着急,举个例子就都清楚了。比方说我们使用定点数类型DECIMAL(16, 4)来存储十进制小数1234567890.1234,这个小数会被划分成3个部分:

1 234567890 1234

也就是:

- 第1组中包含整数

1。 - 第2组中包含整数

234567890。 - 第3组中包含整数

1234。

然后将每一组中的十进制数字转换成对应的二进制数字:

第1组占用2个字节,整数

1对应的二进制数就是(字节之间实际上没有空格,只不过为了大家理解上的方便我们加了一个空格):00000000 00000001

二进制看起来太难受,我们还是转换成对应的十六进制看一下:

0x0001

第2组占用4个字节,整数

234567890对应的十六进制数就是:0x0DFB38D2

第3组占用2个字节,整数

1234对应的十六进制数就是:0x04D2

所以将这些十六进制数字连起来之后就是:

0x00010DFB38D204D2

最后还要将这个结果的最高位设置为1,所以最终十进制小数1234567890.1234使用定点数类型DECIMAL(16, 4)存储时共占用8个字节,具体内容为:

0x80010DFB38D204D2

有的同学会问,如果我们想使用定点数类型DECIMAL(16, 4)存储一个负数怎么办,比方说-1234567890.1234,这时只需要将0x80010DFB38D204D2中的每一个比特位都执行一个取反操作就好,也就是得到下边这个结果:

0x7FFEF204C72DFB2D

从上边的叙述中我们可以知道,对于DECIMAL(M, D)类型来说,给定的M和D的值不同,所需的存储空间大小也不同。可以看到,与浮点数相比,定点数需要更多的空间来存储数据,所以如果不是在某些需要存储精确小数的场景下,一般的小数用浮点数表示就足够了。

对于定点数类型DECIMAL(M, D)来说,M和D都是可选的,默认的M的值是10,默认的D的值是0,也就是说下列等式是成立的:

DECIMAL = DECIMAL(10) = DECIMAL(10, 0)DECIMAL(n) = DECIMAL(n, 0)

另外M的范围是1~65,D的范围是0~30,且D的值不能超过M。

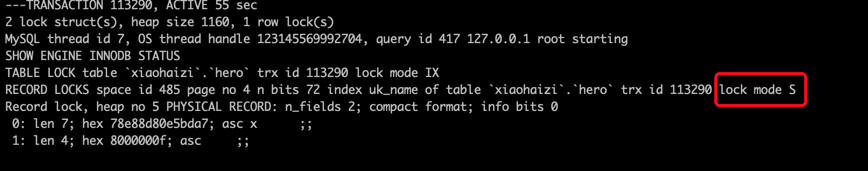

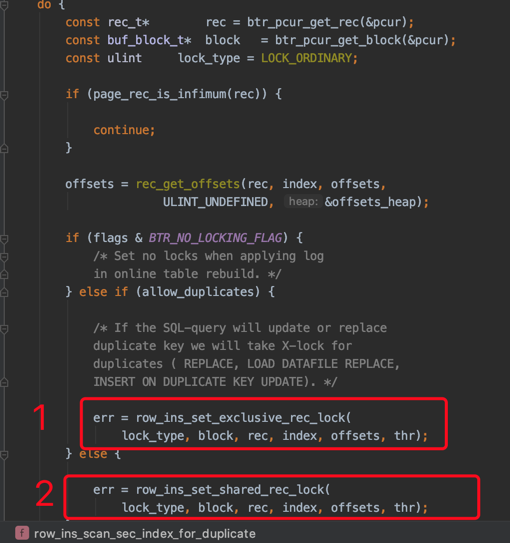

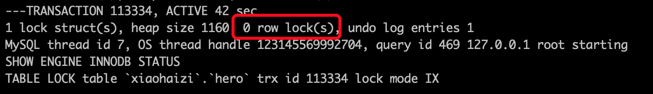

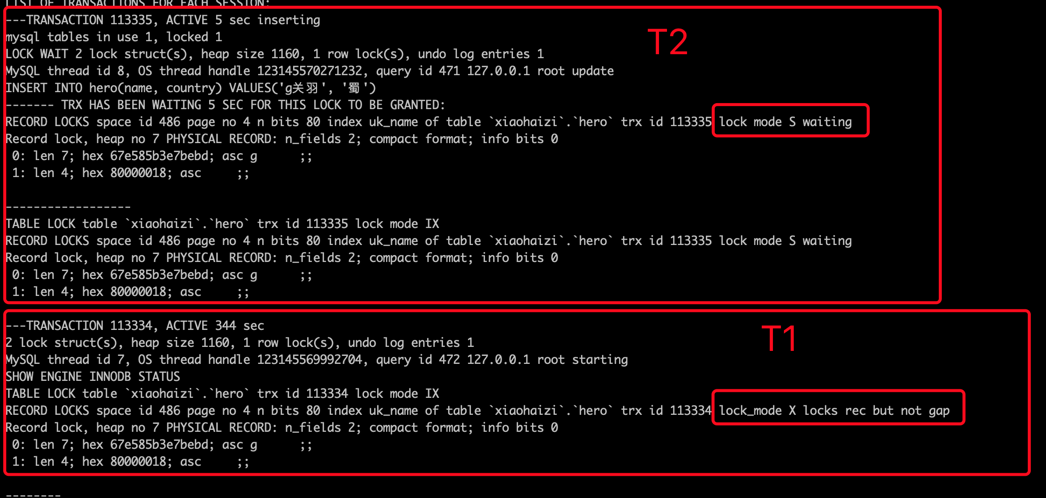

Innodb到底是怎么加锁的

标签: 公众号文章

上一篇文章中缺失一点儿东西,再补全一下。

学完本文后:妈妈再也不用担心我不知道InnoDB是怎么加锁的了!

流传较广,但是错误的一个观点

不知道从什么时候开始,下边这个错误的观点开始被广泛的流传:

在使用加锁读的方式读取使用InnoDB存储引擎的表时,当在执行查询时没有使用到索引时,行锁会被转换为表锁。

这里强调一点,对于任何INSERT、DELETE、UPDATE、SELECT ... LOCK IN SHARE MODE、SELECT ... FOR UPDATE语句来说,InnoDB存储引擎都不会加表级别的S锁或者X锁(我们这里不讨论表级意向锁的添加),只会加行级锁。所以即使对于全表扫描的加锁读语句来说,也只会对表中的记录进行加锁,而不是直接加一个表锁。

另外,很多小伙伴都会问:“这个语句加什么锁”,其实这是一个伪命题,因为一个语句需要加什么锁受到很多方面的影响,如果有人问你某某语句会加什么锁,那你可以直接回怼:真不专业!

我们稍后给大家详细分析一下影响加锁的因素都有哪些,以及从源码的角度看一下InnoDB到底是如何加锁的,希望小伙伴看完后会惊呼:真tm的简单!

不过在进行讨论前我们需要申明一下,我们讨论的只是InnoDB加的事务锁,即为了避免脏写、脏读、不可重复读、幻读这些现象带来的一致性问题而加的锁,并不是为了在多线程访问共享内存区域时而加的锁(比方说两个不同事务所在的线程想读写同一个页面时,需要进行加锁保护),也不包括server层添加的MDL锁。

本文所参考的源码版本为5.7.22。

事务锁到底是什么

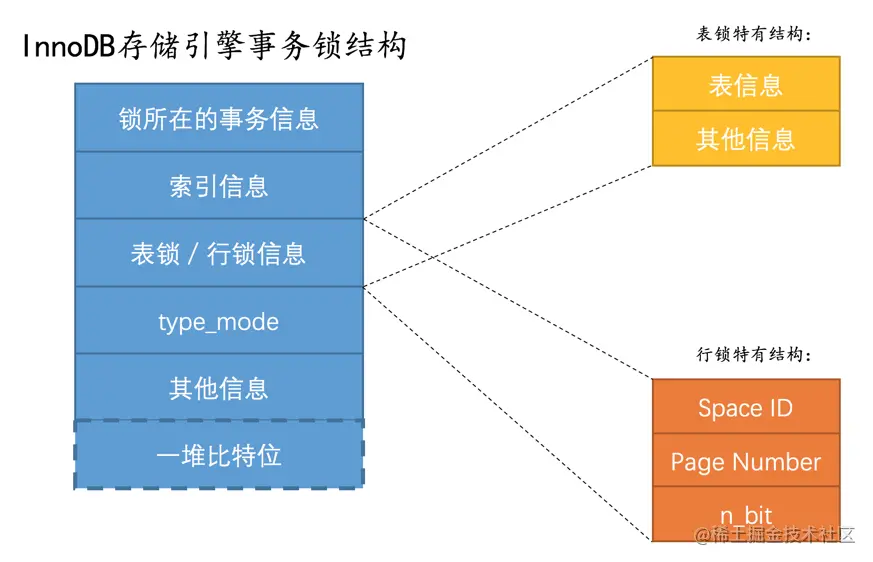

锁是一个内存结构,InnoDB中用lock_t这个结构来定义:

不论是行锁,还是表锁都用这个结构来表示。我们给大家画个图:

其中的type_mode是用于区分这个锁结构到底是行锁还是表锁,如果是表锁的话是意向锁、直接对表加锁、还是AUTO-INC锁,如果是行锁的话,具体是正经记录锁、gap锁还是next-key锁。

小贴士:

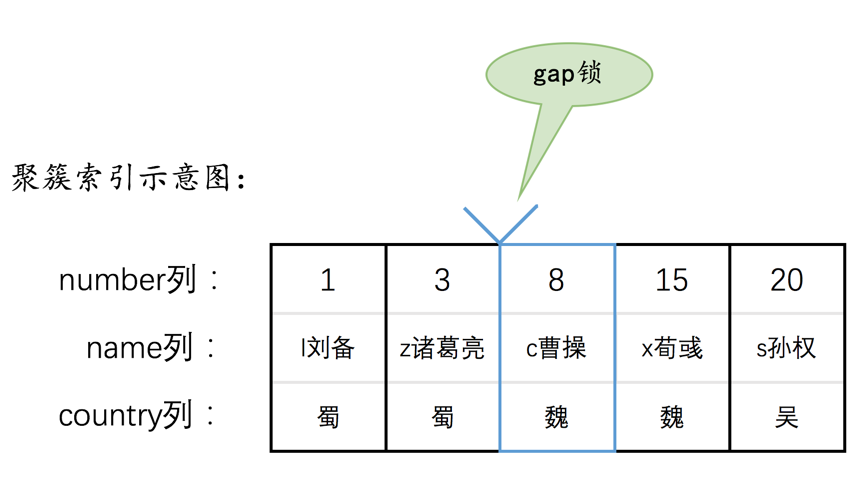

在InnoDB的实现中,InnoDB的行锁是与记录一一对应的。即使是对于gap锁来说,在实现上也是为某条记录生成一个锁结构,然后该锁结构的类型是gap锁而已,并不是专门为某个区间生成一个锁结构。该gap锁的功能就是每当有别的事务插入记录时,会检查一下待插入记录的下一条记录上是否已经有一个gap锁的锁结构,如果有的话就进入阻塞状态。

我们平时所说的加锁就是在内存中生成这样的一个锁结构(除了生成锁结构,还有一种称作隐式锁的加锁方式,不用生成锁结构)。当然,如果为1条记录加锁就要生成一个锁结构,那岂不是太浪费了!设计InnoDB的大叔提出了一种优化方案,即同一个事务,在同一个页面上加的相同类型的锁都放在同一个锁结构里。

各种类型的锁是如果通过type_mode区分、各种锁都有什么作用,以及如何减少生成锁结构的细节我们这里就不展开了,那又要花费超长的篇幅,大家可以到《MySQL是怎样运行的:从根儿上理解MySQL》书籍中查看,我们下边来看具体的加锁细节。

准备工作

为了故事的顺利发展,我们先创建一个表hero:

CREATE TABLE hero (number INT,name VARCHAR(100),country varchar(100),PRIMARY KEY (number),KEY idx_name (name)) Engine=InnoDB CHARSET=utf8;

然后向这个表里插入几条记录:

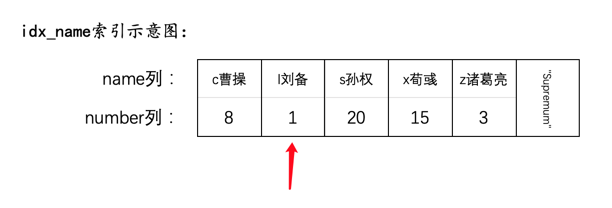

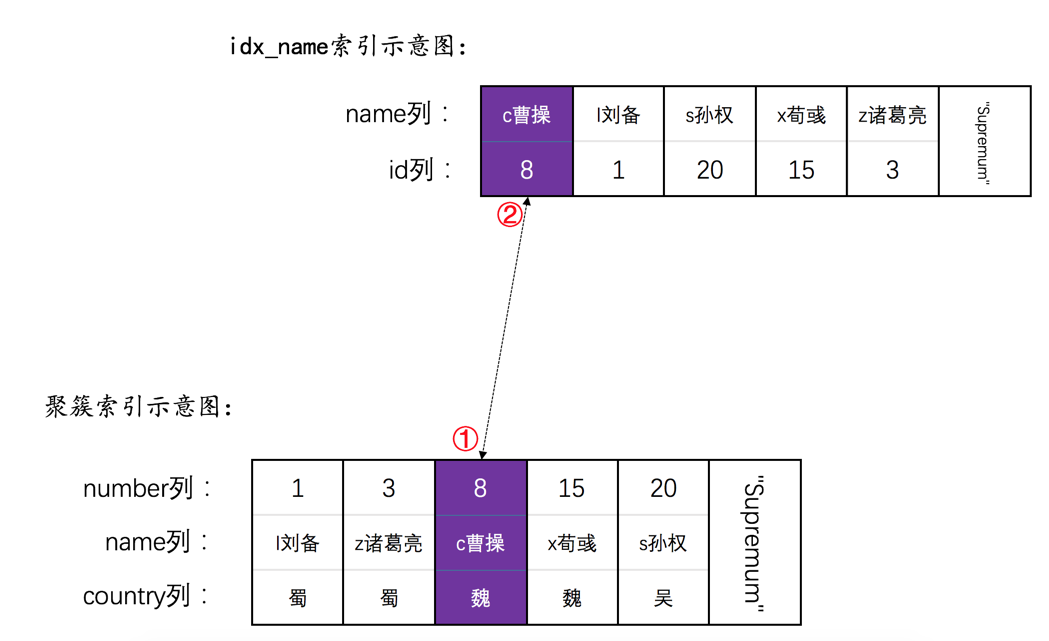

INSERT INTO hero VALUES(1, 'l刘备', '蜀'),(3, 'z诸葛亮', '蜀'),(8, 'c曹操', '魏'),(15, 'x荀彧', '魏'),(20, 's孙权', '吴');

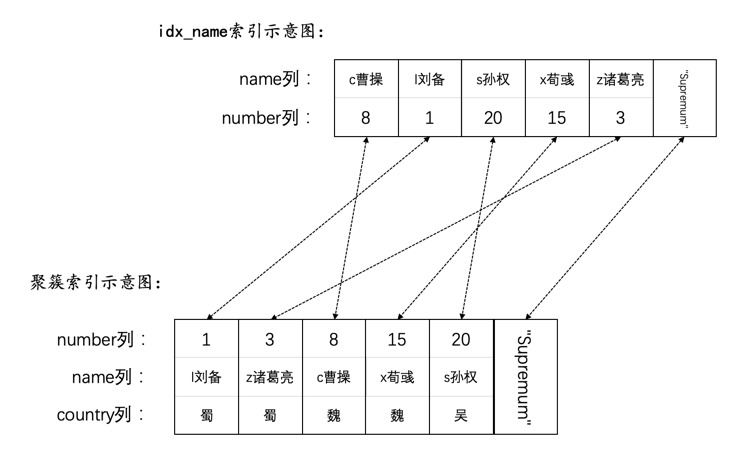

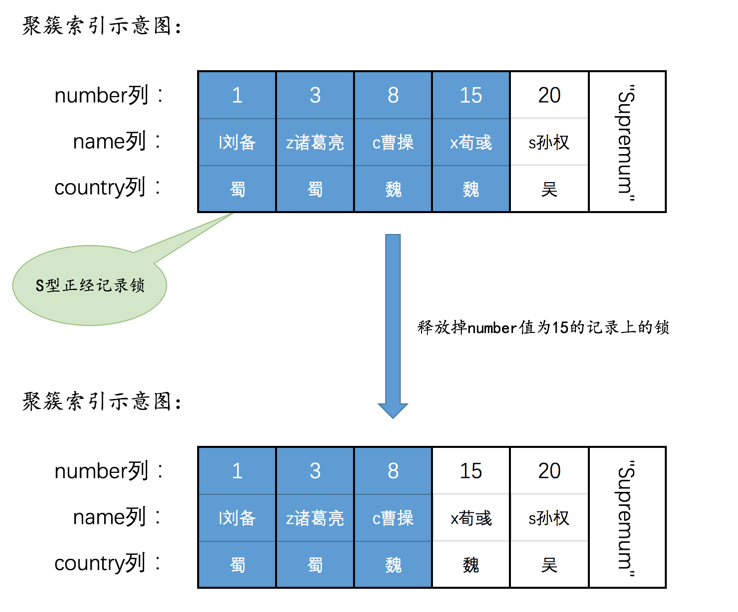

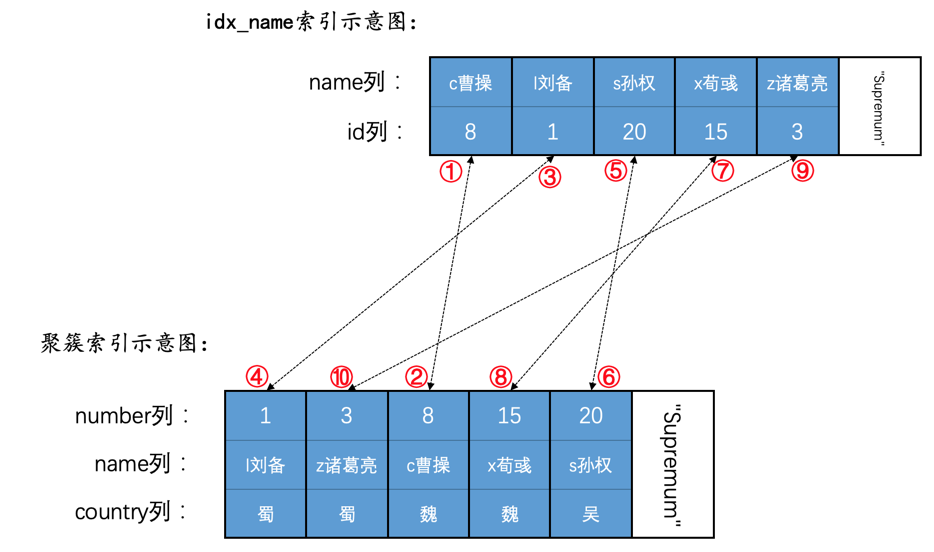

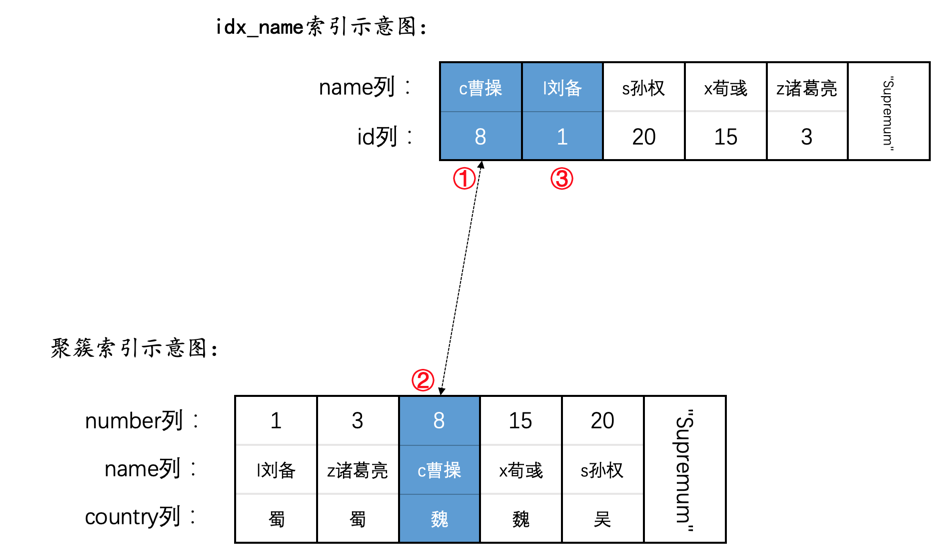

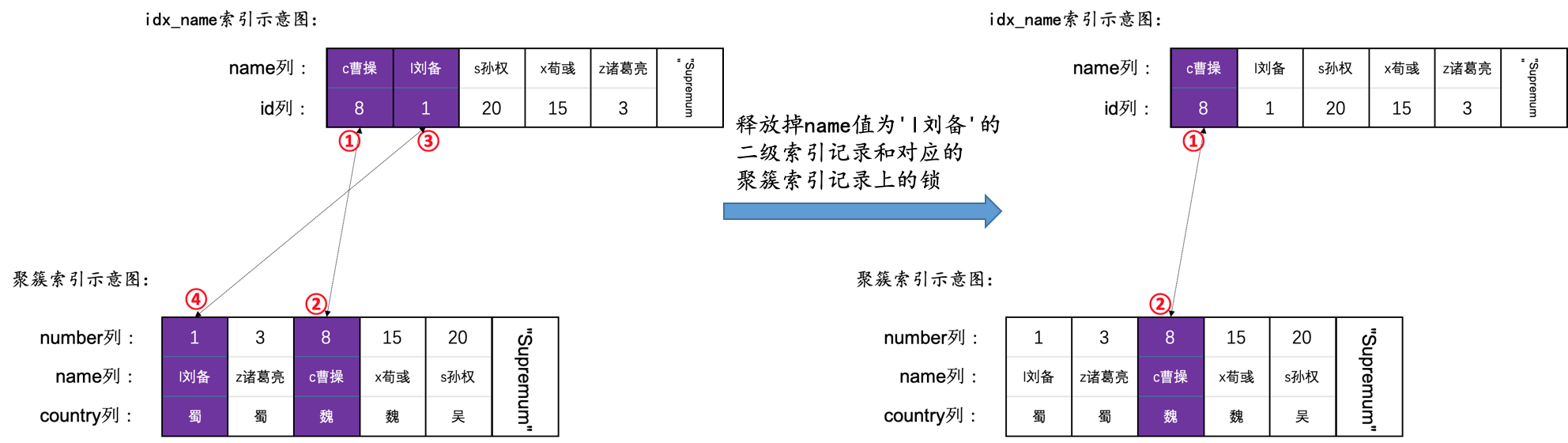

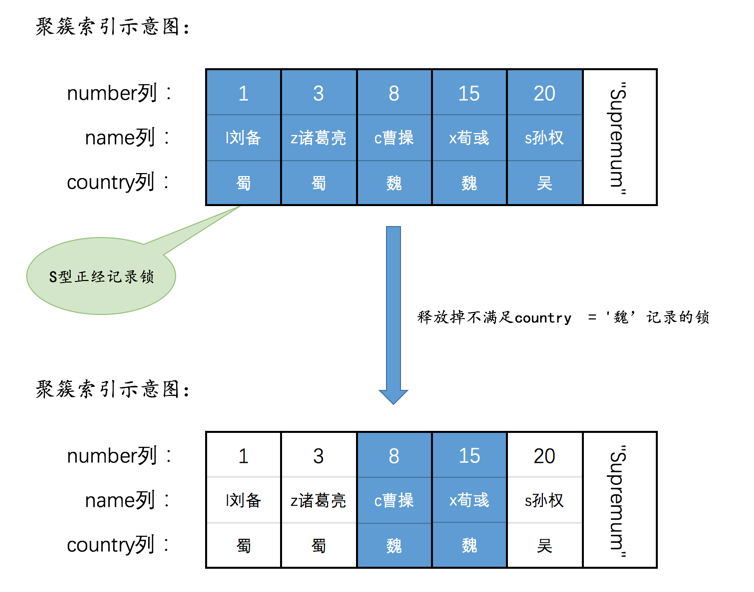

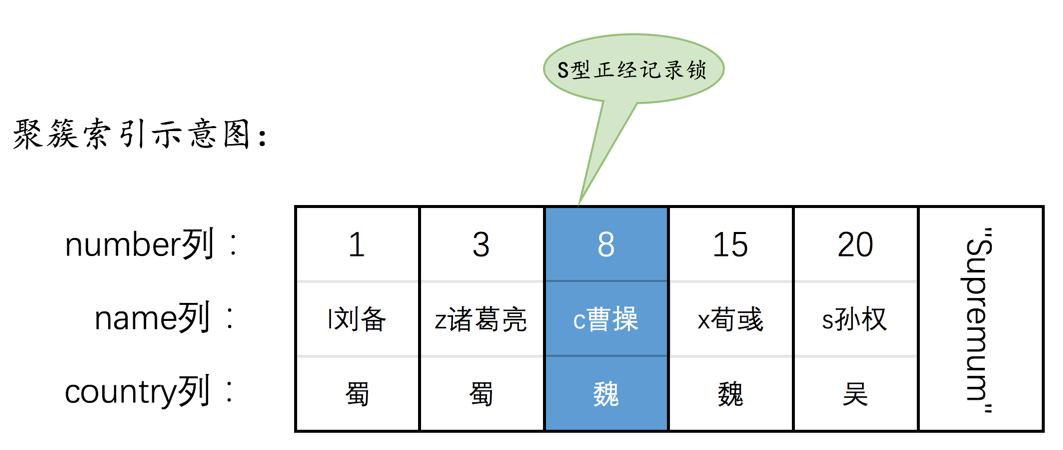

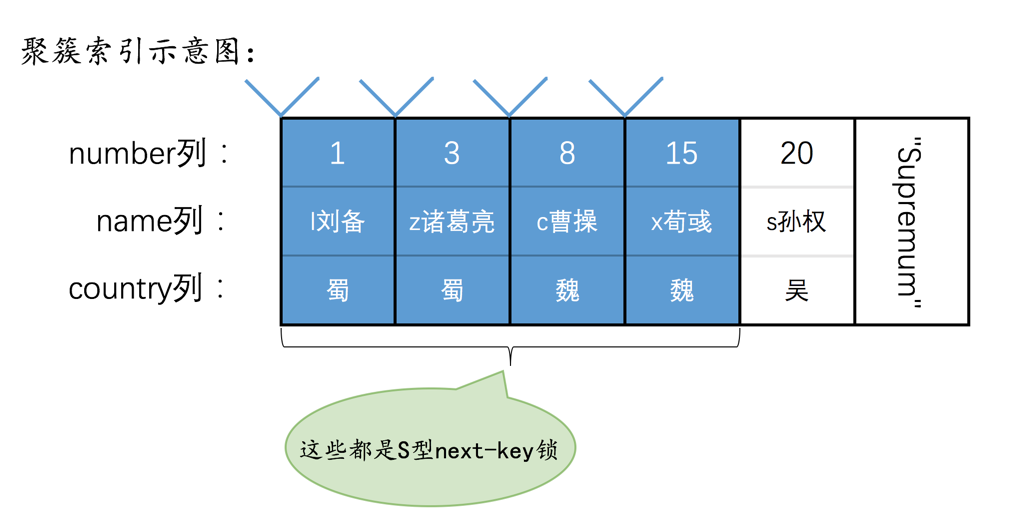

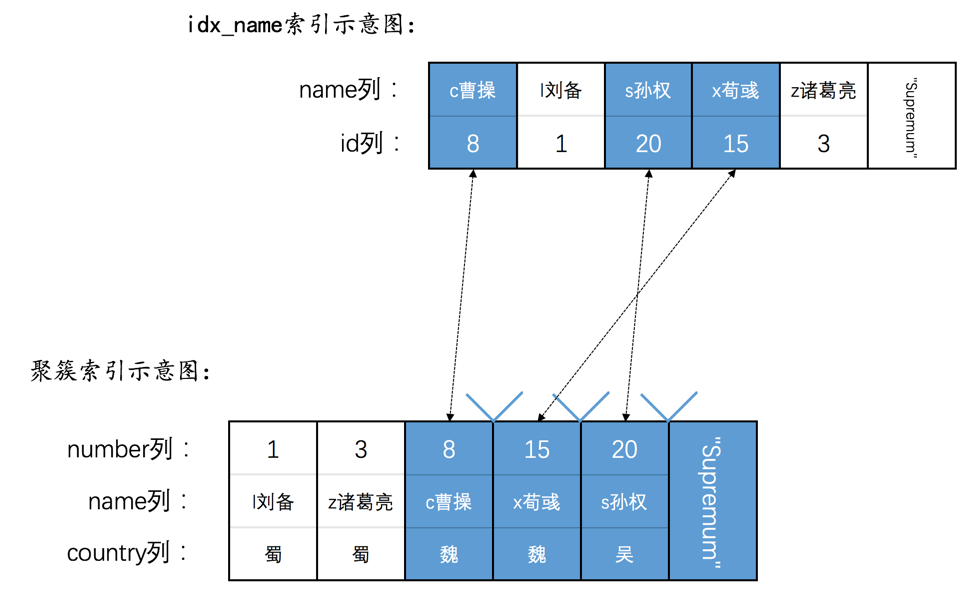

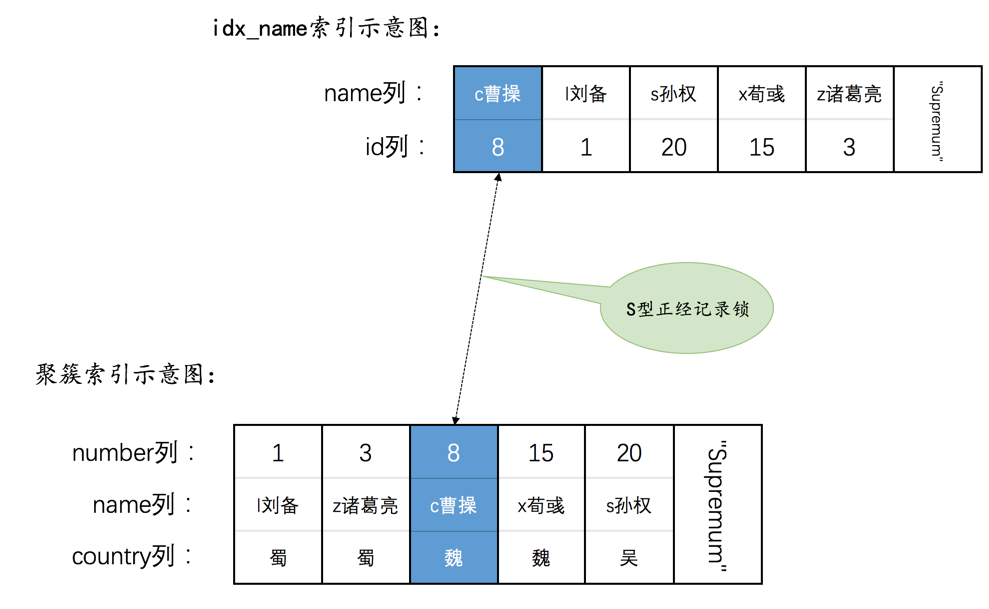

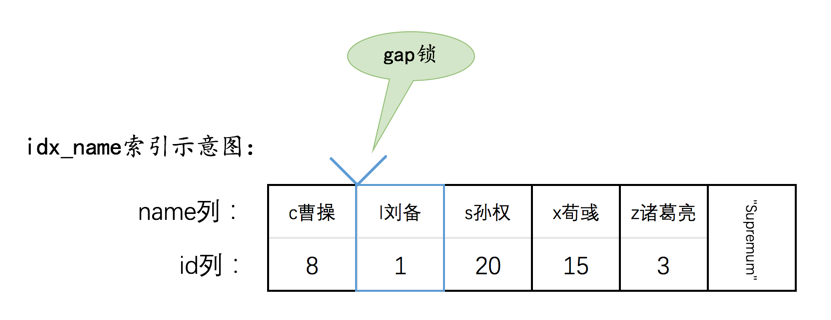

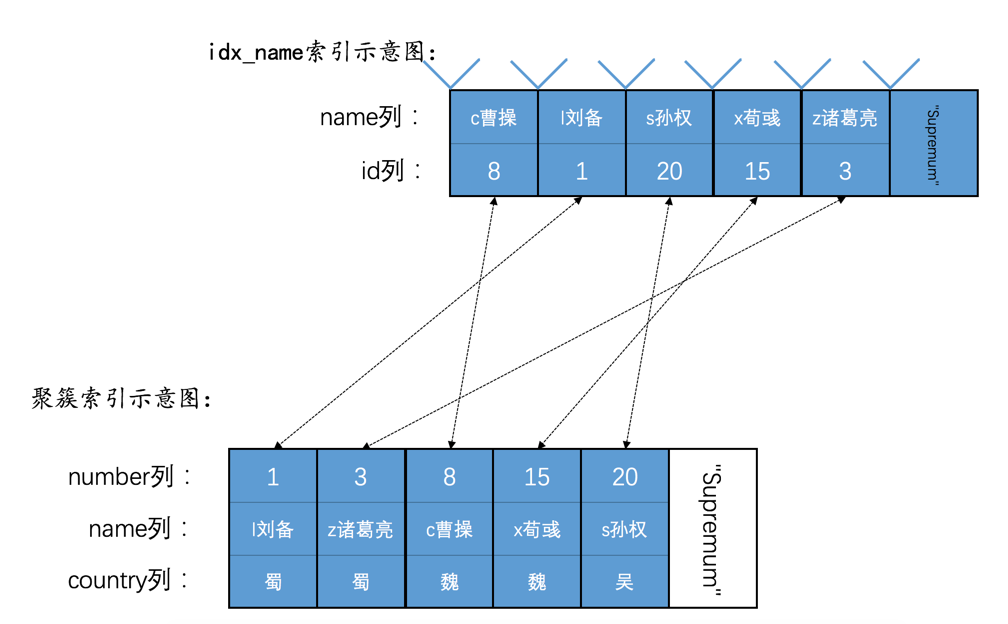

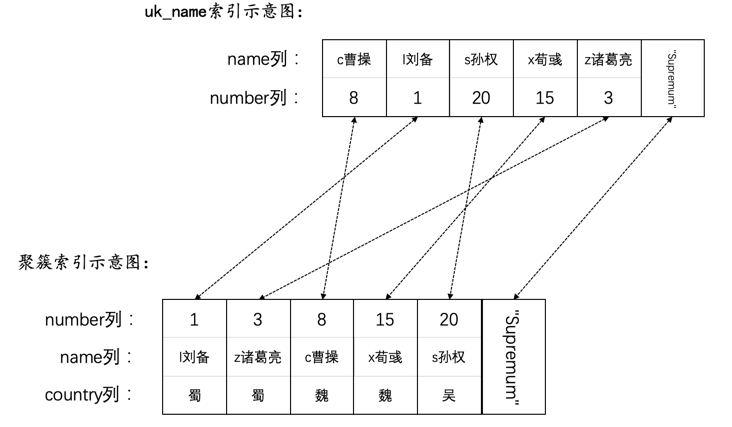

然后现在hero表就有了两个索引(一个二级索引,一个聚簇索引),示意图如下:

加锁受哪些因素影响

一条语句加什么锁受多种因素影响,如果你不能确认下边这些因素的时候,最好不要抢先发言说"XXX语句对XXX记录加了什么锁":

- 事务的隔离级别

- 语句执行时使用的索引类型(比如聚簇索引、唯一二级索引、普通二级索引)

- 是否是精确匹配

- 是否是唯一性搜索

- 具体执行的语句类型(SELECT、INSERT、DELETE、UPDATE)

- 是否开启innodb_locks_unsafe_for_binlog系统变量

- 记录是否被标记删除

这里边有几个概念大家可能不是很清楚,我们先解释一下。

扫描区间

比方说下边这个查询:

SELECT * FROM hero WHERE name <= 'l刘备' AND country = '魏';

MySQL可以使用下边两种方式来执行上述查询:

使用二级索引idx_name执行上述查询,那么就需要扫描name值在

(-∞, 'l刘备']这个区间中的所有二级索引记录,针对获取到的每一条二级索引记录,都需要执行回表操作来获取相应的聚簇索引记录。直接扫描所有的聚簇索引记录,即进行全表扫描。此时相当于扫描number值在

(-∞, +∞)这个区间中的所有聚簇索引记录。

优化器会计算上述二种方式哪个成本更低,选用成本更低的那种来执行查询。

当优化器使用二级索引执行查询时,我们把(-∞, 'l刘备']称作扫描区间,意味着需要扫描name列值在这个区间中的所有二级索引记录,我们也可以把形成这个扫描区间的条件name <= 'l刘备'称作是形成这个扫描区间的边界条件;当优化器使用全表扫描执行查询时,我们把(-∞, +∞)称作扫描区间,意味着需要扫描number值在这个区间中的所有聚簇索引记录。

在执行一个查询的过程中,可能会用到多个扫描区间,如下所示:

SELECT * FROM hero WHERE name < 'l刘备' OR name > 'x荀彧';

如果优化器采用二级索引idx_name执行上述查询时,那么对应的扫描区间就是(-∞, l刘备)以及('x荀彧', +∞),即需要扫描name值在上述两个扫描区间中的记录。

每当InnoDB需要扫描一个扫描区间中的记录时,都需要分两步:

先通过索引对应的B+树,从根页面开始一路向下定位,直到定位到叶子节点中在扫描区间中的第一条记录。

之后就可以不需要继续从根节点定位了,而是通过记录的

next_record属性直接找到扫描区间的下一条记录即可(页面之间通过双向链表连接,找完一个页面中的记录后,可以顺着双向链表再去下一个页面中去找属于同一个扫描区间的记录)。

也就是说在扫描某个扫描区间的记录时,只有定位第1条记录的时候稍微麻烦点儿,其他记录只需要顺着链表(单个页面中的记录连成一个单向链表,不同的页面之间是双向链表)扫描即可。

精确匹配

对于形成扫描区间的边界条件来说,如果是等值匹配的条件,我们就把对这个扫描区间的匹配模式称作精确匹配。比方说:

SELECT * FROM hero WHERE name = 'l刘备' AND country = '魏';

如果使用二级索引idx_name执行上述查询时,扫描区间就是['l刘备', 'l刘备'],形成这个扫描区间的边界条件就是name = 'l刘备'。我们就把在使用二级索引idx_name执行上述查询时的匹配模式称作精确匹配。

而对于下边这个查询来说

SELECT * FROM hero WHERE name <= 'l刘备' AND country = '魏';

显然就不是精确匹配了。

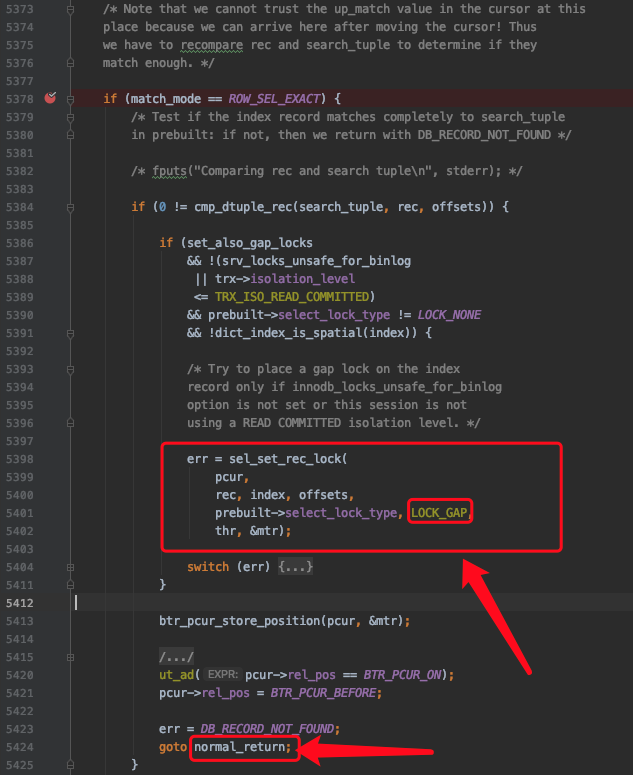

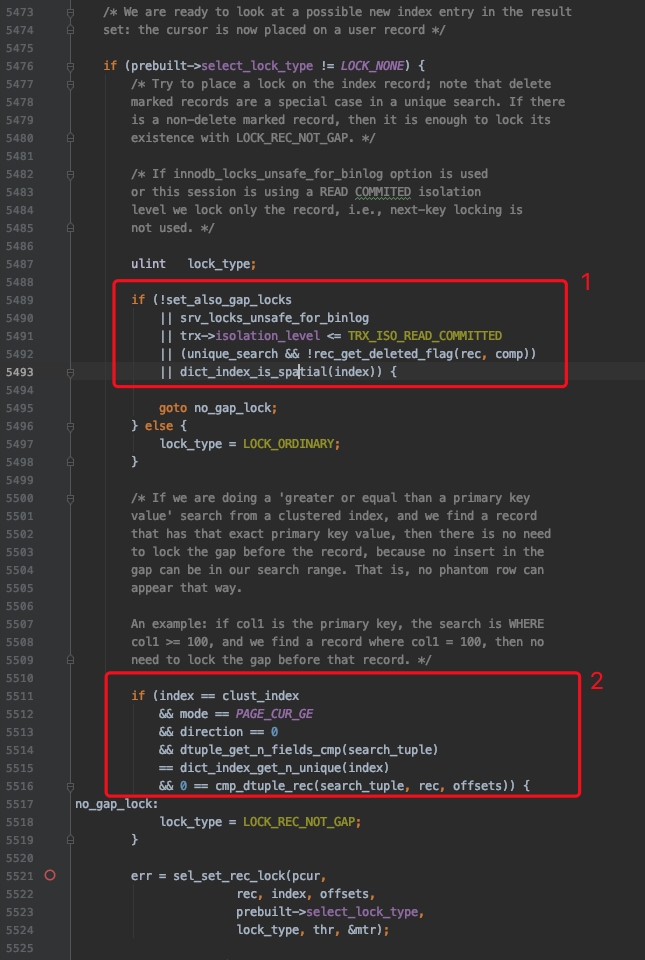

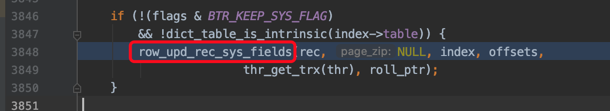

唯一性搜索

如果在扫描某个扫描区间的记录前,就能事先确定该扫描区间最多只包含1条记录的话,那么就把这种情况称作唯一性搜索。我们看一下代码中判定扫描某个扫描区间的记录是否是唯一性搜索的代码是怎么写的:

其中:

- 匹配模式是精确匹配

- 使用的索引是聚簇索引或唯一二级索引

- 如果索引中包含多个列,则每个列在生成扫描区间时都应该被用到

- 如果使用的索引是唯一二级索引,那么在搜索时不能搜索某个索引列为NULL的记录(因为对于唯一二级索引来说,是可以存储多个值为NULL的记录的)。

上边几点都比较好理解,我们稍微解释一下第3点。比方说我们为某个表的a、b两列建立了一个唯一二级索引uk_a_b(a, b),那么对于搜索条件a=1形成的扫描区间来说,不能保证该扫描区间最多只包含一条记录;对于搜索条件a=1 AND b= 1形成的扫描区间来说,才可以保证该扫描区间中仅包含1条记录(不包括记录的delete_flag=1的记录)。

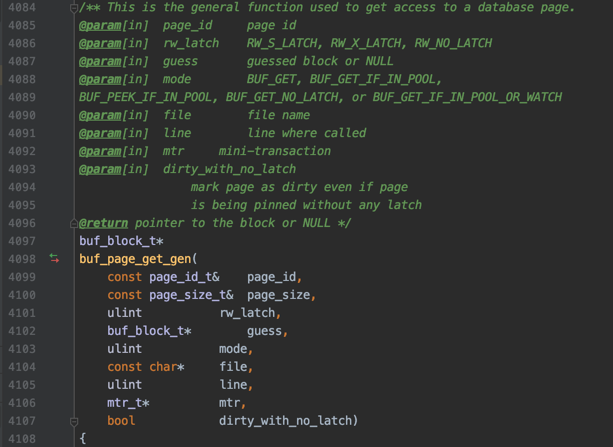

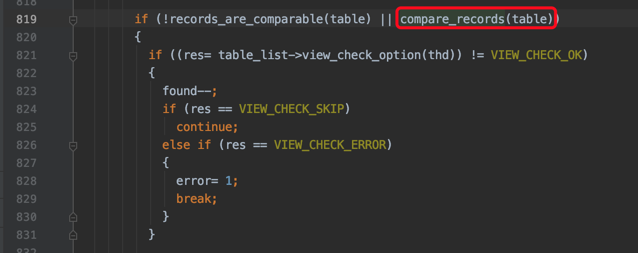

row_search_mvcc

我们知道MySQL其实是分成server层和存储引擎层两部分,每当执行一个查询时,server层负责生成执行计划,即选取即将使用的索引以及对应的扫描区间。我们这里以InnoDB为例,针对每一个扫描区间,都会:

server层向InnoDB要扫描区间的第1条记录

InnoDB通过B+树定位到扫描区间的第1条记录(如果定位的是二级索引记录并有回表需求则回表获取完整的聚簇索引记录),然后返回给server层

server层判断记录是否符合搜索条件,如果符合则发送给客户端,不符合则跳过。继续向InnoDB要下一条记录。

小贴士:

此处将记录发送给客户端其实是发送到本地的网络缓冲区,缓冲区大小由net_buffer_length控制,默认是16KB大小。等缓冲区满了才真正发送网络包到客户端。

InnoDB根据记录的单向链表以及页面之间的双向链表找到下一条记录(如果定位的是二级索引记录并有回表需求则回表获取完整的聚簇索引记录),返回给server层。

server层处理该记录,并向InnoDB要下一条记录

... 不停执行上述过程,直到InnoDB读到一条不符合边界条件的记录为止

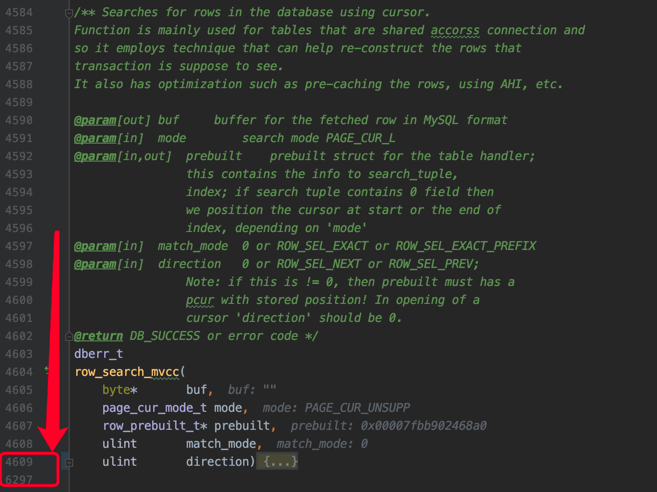

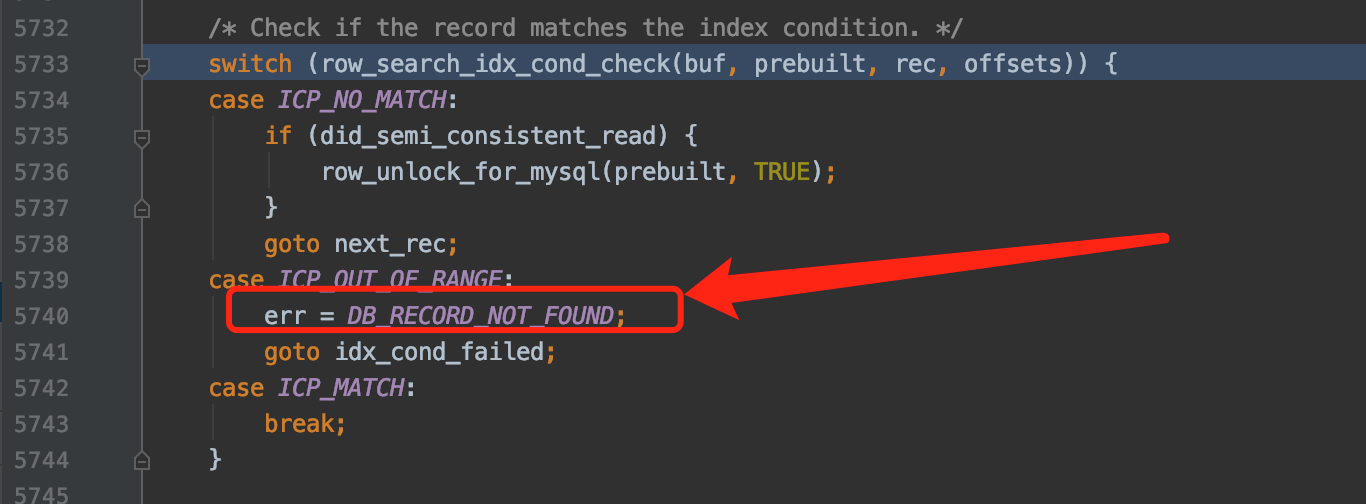

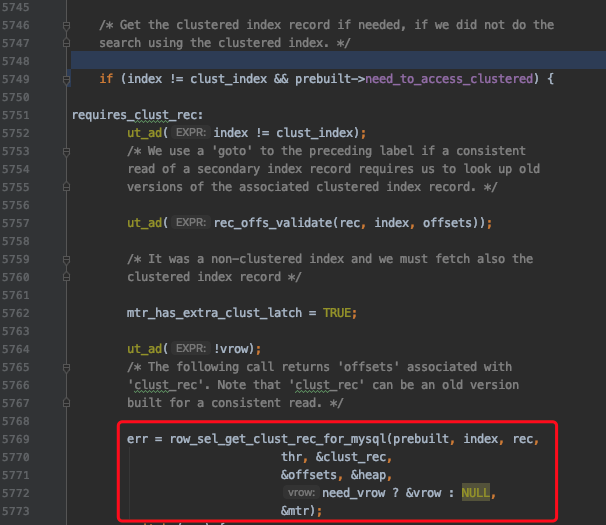

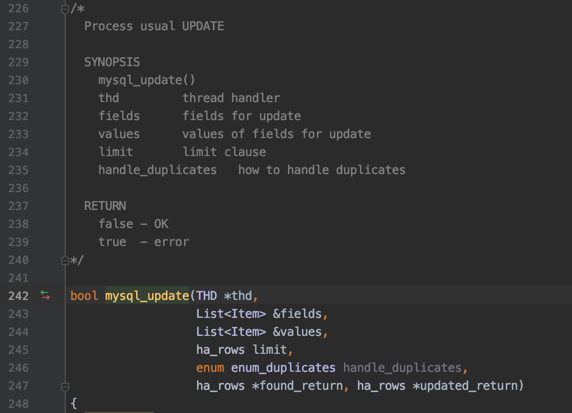

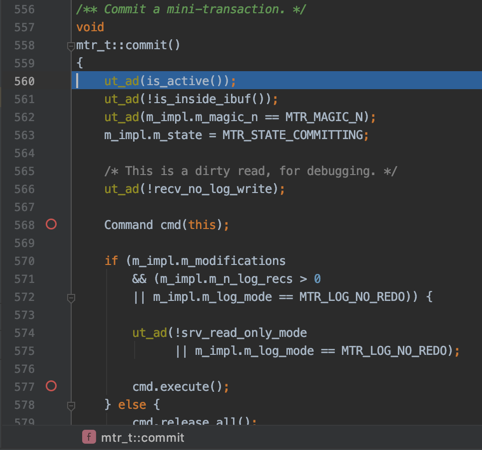

可见一般情况下,server层和存储引擎层是以记录为单位进行通信的,而InnoDB读取一条记录最重要的函数就是row_search_mvcc:

可以看到这个函数长到吓人,有一千多行。

小贴士:

不知道你们公司有没有在一个函数中把业务逻辑写到一千多行的同事,如果有的话你想不想打他。

在row_search_mvcc里,对一条记录进行诸如多版本的可见性判断,要不要对记录进行加锁的判断,要是加锁的话加什么锁的选择,完成记录从InnoDB的存储格式到server层存储格式的转换等等等等十分繁杂的工作。

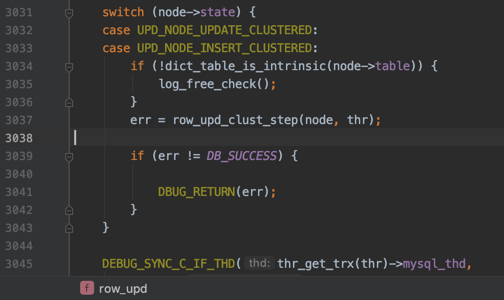

其实对于UPDATE、DELETE语句来说,执行它们前都需要先在B+树中定位到相应的记录,所以它们也会调用row_search_mvcc。

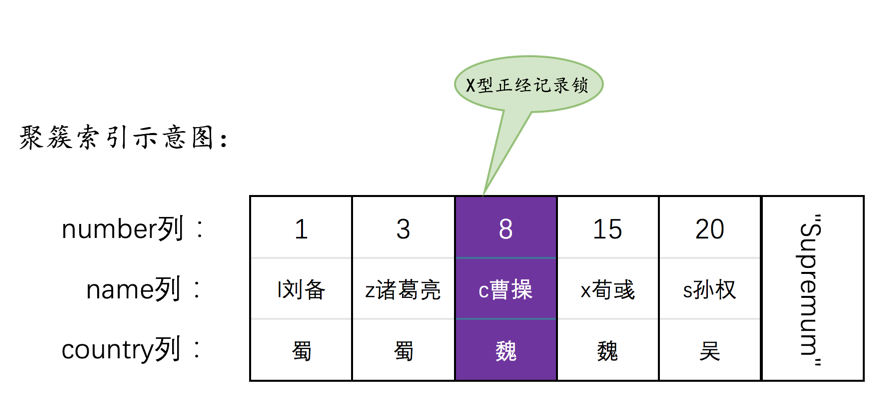

InnoDB对记录的加锁操作主要是在row_search_mvcc中的,像SELECT ... LOCK IN SHARE MODE、SELECT ... FOR UPDATE、UPDATE、DELETE这样的语句都会调用row_search_mvcc完成加锁操作。SELECT ... LOCK IN SHARE MODE会为记录添加S型锁,SELECT ... FOR UPDATE、UPDATE、DELETE会为记录添加X型锁。

InnoDB每当读取一条记录时,都会调用一次row_search_mvcc,在做了足够长的铺垫之后,我们终于可以看一下在row_search_mvcc函数中是怎么对某条记录进行加锁的。

语句到底是怎么加锁的

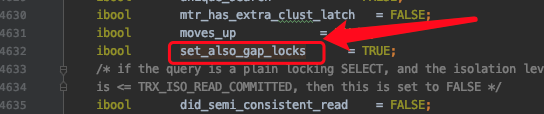

首先看一个十分重要的变量:

set_also_gap_locks表示是否要给记录添加gap锁(next-key锁可以看成是正经记录锁和gap锁的组合),它的默认值是TRUE,表示默认会给记录添加gap锁。

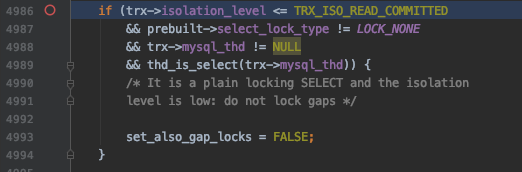

set_also_gap_locks可能会在下边这个地方发生变化:

即如果当前执行的是SELECT ... LOCK IN SHARE MODE或者SELECT ... FOR UPDATE这样的加锁读语句(非DELETE或UPDATE语句),并且隔离级别不大于READ COMMITTED 时,将set_also_gap_locks设置为FALSE。

其中prebuilt->select_lock_type表示加锁的类型,LOCK_NONE表示不加锁,LOCK_S表示加S锁(比方说执行SELECT ... LOCK IN SHARE MODE时),LOCK_X表示加X锁(比方说执行SELECT ... FOR UPDATE、DELETE、UPDATE时)。

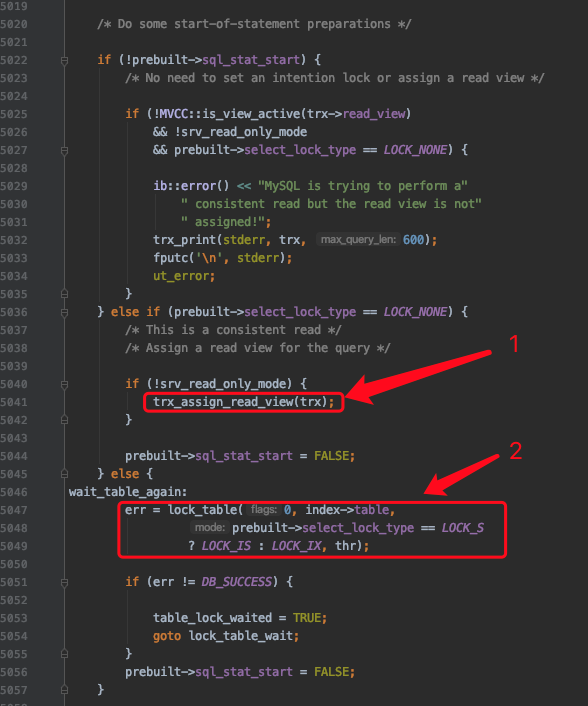

对普通的SELECT的处理和意向锁的添加

再往后看:

其中:

- 标号1的箭头是对普通的SELECT的处理,在查询开启前需要生成ReadView。

小贴士:

具体的讲就是对于Repeatable Read隔离级别来说,只在首次执行SELECT语句时生成Readview,之后的SELECT语句都复用这个ReadView;对于Read Committed隔离级别来说,每次执行SELECT语句时都会生成一个ReadView。这一点并不是在上边截图中的代码里实现的。

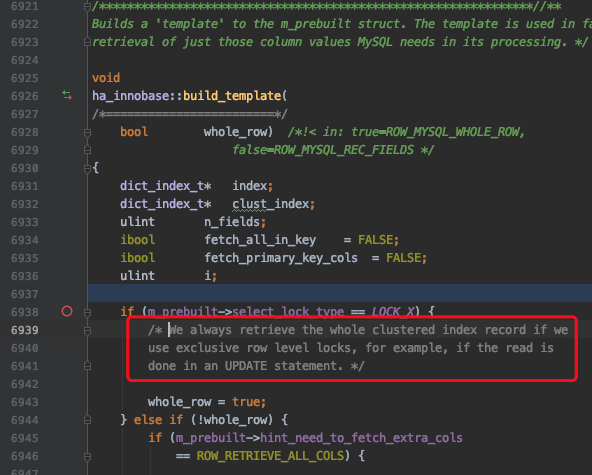

- 标号2的箭头是对加锁读的语句的处理,在首次读取记录(prebuilt->sql_stat_start表示是否是首次读取)前,需要添加表级别的意向锁(IS或IX锁)。

下边是真正处理记录并给记录加锁的流程,我们给这些流程编个号。

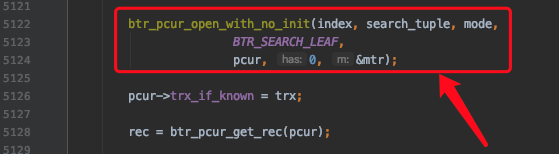

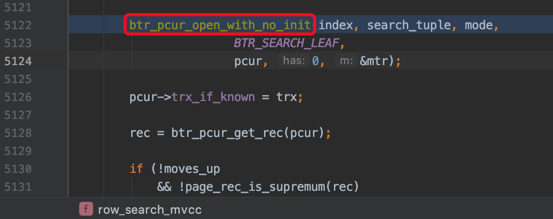

1. 定位扫描区间的第一条记录

下边开始通过B+树定位某个扫描区间中的第一条记录了(对于一个扫描区间来说,只执行一次下述函数,因为只要定位到扫描区间的第一条记录之后,就可以沿着记录所在的单向链表进行查询了):

其中btr_pcur_open_with_no_init是用于定位扫描区间中的第一条记录的函数。

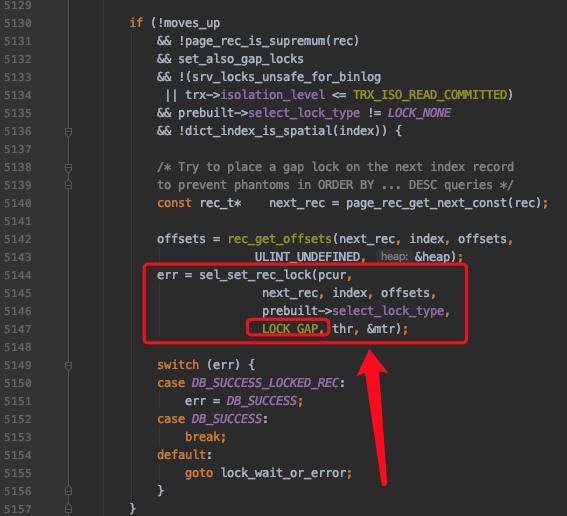

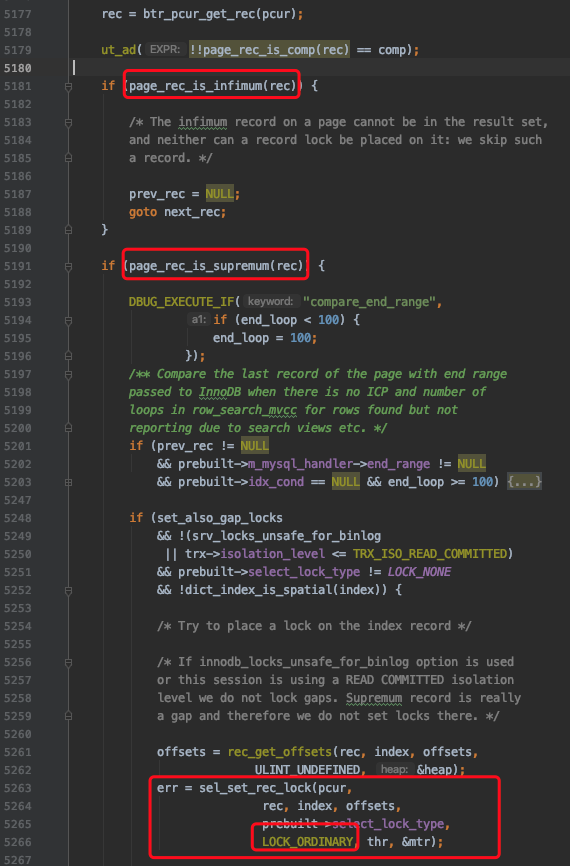

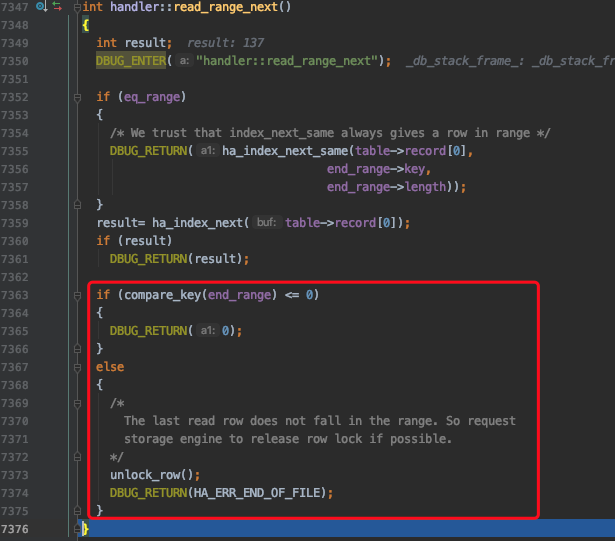

2. 对于ORDER BY ... DESC条件形成的扫描区间的第一条记录的处理

在B+树的每层节点中,记录是按照键值从小到大的方式进行排序的。对于某个扫描区间来说,InnoDB通常是定位到扫描区间中最左边的那条记录,也就是键值最小的那条记录,然后沿着从左往右的方式向后扫描。

但是对于下边这个查询来说:

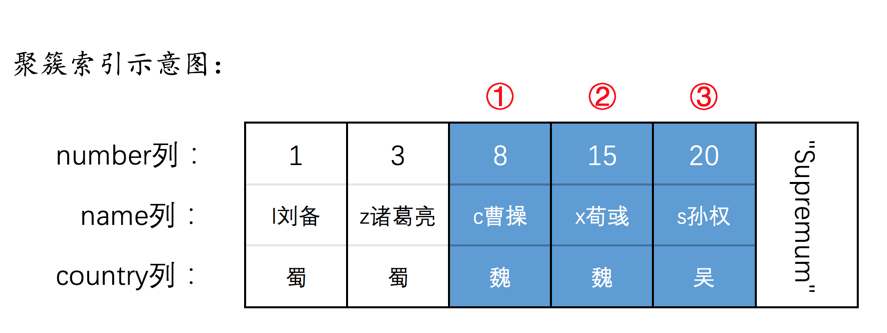

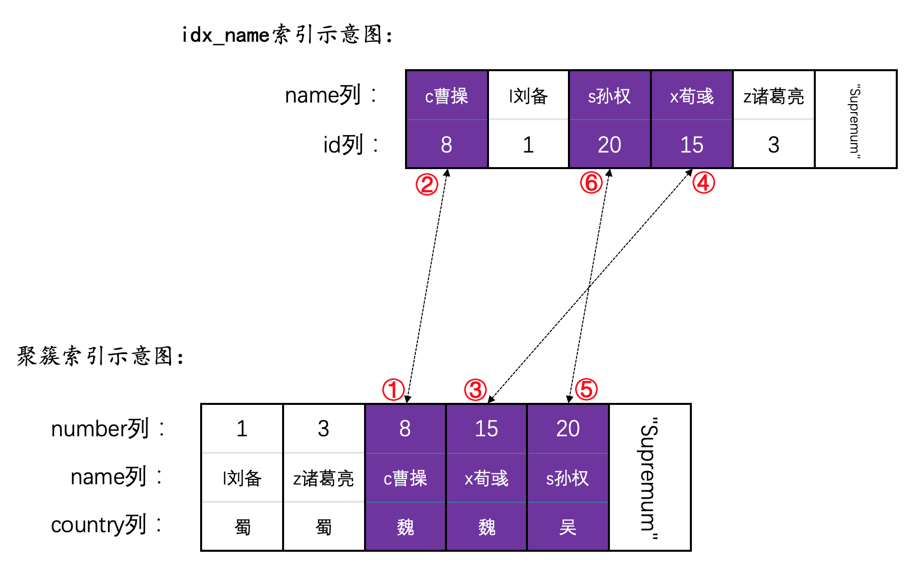

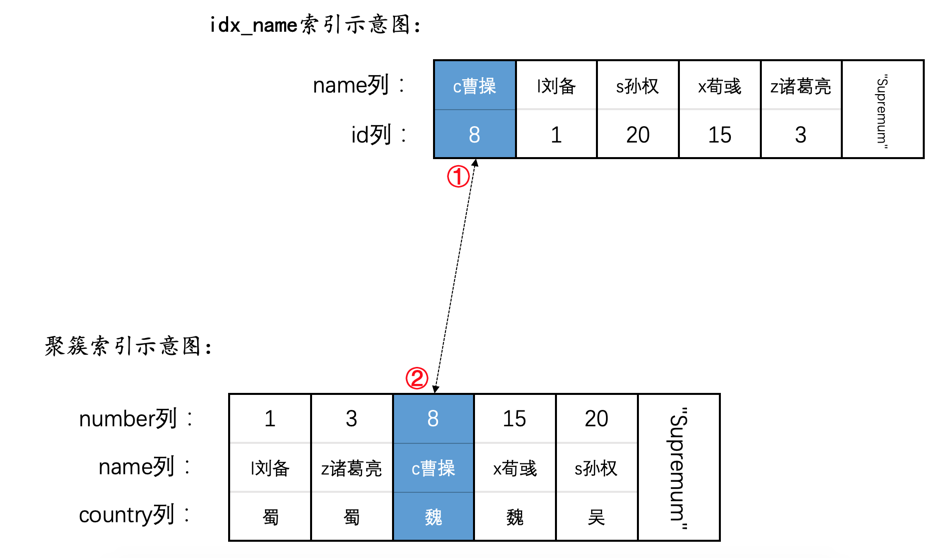

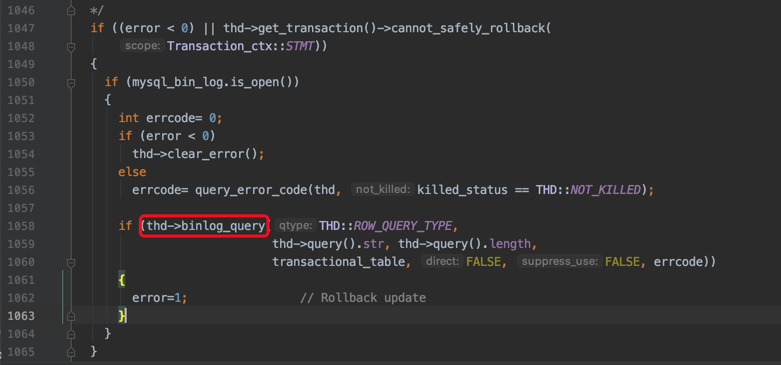

SELECT * FROM hero WHERE name < 's孙权' AND country = '魏' ORDER BY name DESC FOR UPDATE ;