@Arbalest-Laevatain

2018-08-16T09:54:03.000000Z

字数 875

阅读 1363

Python 爬虫 实战一 爬取电影天堂的下载链接

Python 爬虫

爬虫的基本概念

爬虫就是模拟客户端或者浏览器发送网络请求已获取响应,然后按照一定的规则来获取数据的程序

搜索引擎就是一个功能强大的爬虫

import requests #网络请求模块import re #提取数据import time #time.sleep#用pip install requests#python的for循环#for n in [1,2,3,4,5]for n in range(1,169): #循环的范围要大1a_url='http://www.ygdy8.net/html/gndy/dyzz/list_23_'+str(n)+'.html'#网址变量print(a_url)#打印链接html_1 = requests.get(a_url)print(html_1.status_code) #请求状态的标志量html_1.encoding='gb2312' #为了防止出现乱码,所以解码#print(html_1.text)#findall函数返回的是一个列表detail_list = re.findall('<a href="(.*?)" class="ulink',html_1.text)#print(detail_list)for m in detail_list:b_url = 'http://www.ygdy8.net' + m#print(b_url)html_2 = requests.get(b_url)html_2.encoding='gb2312'ftp = re.findall('<a href="(.*?)">.*?</a></td>',html_2.text)print(ftp)# 写入桌面的一个txt文件with open(r'C:\Users\Administrator\Desktop\爬虫\dytt.txt','a',encoding='utf-8') as ff:ff.write(ftp[0]+'\n')

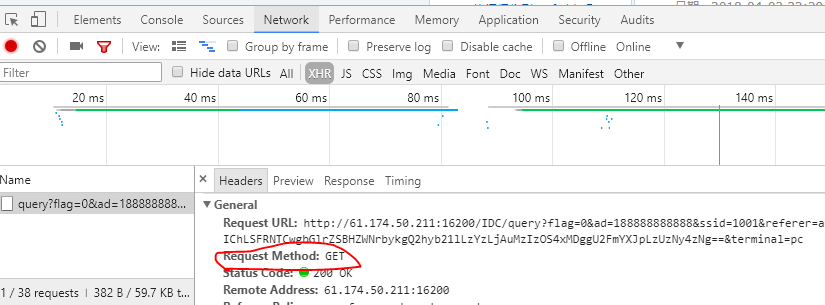

如何确定requests的方法:

在Chrome浏览器(其他浏览器都大同小异)中找到下面这个: