@BrandonLin

2016-11-03T07:39:16.000000Z

字数 2374

阅读 4642

Hue 3.9 安装

Hue

Hue是Cloudera开源的一个Hadoop UI,由Cloudera Desktop演化而来。面向用户提供方便的UI用于平时的Hadoop操作中。Apache Ambari面向的是管理员,用于安装、维护集群,而不是使用集群。两者针对的是不同需求。

Hue安装:

官网教程:http://gethue.com/hadoop-hue-3-on-hdp-installation-tutorial/

依赖安装:

yum -y install gcc-c++ asciidoc cyrus-sasl-devel cyrus-sasl-gssapi krb5-devel libxml2-devel libxslt-devel mysql-devel openldap-devel python-devel sqlite-devel openssl-devel gmp-devel

(不同环境的依赖包参考这里)

Maven和Ant安装

Hue的安装过程需要依赖于Maven和Ant,按常规方法安装Maven和Ant,配置MAVEN_HOME,ANT_HOME,并将bin目录加入PATH。具体步骤略。

下载

wget https://dl.dropboxusercontent.com/u/730827/hue/releases/3.9.0/hue-3.9.0.tgztar zxvf hue-3.9.0.tgzcd hue-3.9.0#安装make apps

安装过程需要下载的东西比较多,如果网络不好,可能需要等一段时间。make操作没有报错之后,就算安装成功。

配置Hue

Hue的配置集中在$HUE_HOME/desktop/conf/hue.ini文件,针对不同的Hadoop组件分段配置。详细配置文件参考这里。下面是我的配置示例:

Hue

secret_key=jFE93j;2[290-eiw.KEiwN2s3['d;/.q[eIW^y#e=+Iei*@Mn<qW5ohttp_host=0.0.0.0http_port=8888server_user=rootserver_group=rootdefault_user=rootdefault_hdfs_superuser=root

Hadoop/HDFS

fs_defaultfs=hdfs://master:9000webhdfs_url=http://master:50070/webhdfs/v1hadoop_conf_dir=/home/hadoop-2.6.0/etc/hadoop

YARN

resourcemanager_host=masterresourcemanager_port=8032resourcemanager_api_url=http://master:18088proxy_api_url=http://master:18088history_server_api_url=http://master:19888

HBase

hbase_clusters=(Cluster|master:9090)hbase_conf_dir=/home/hbase-1.2.2/conf

Hive

hive_server_host=masterhive_server_port=10000hive_conf_dir=/home/hive-2.0.0/conf

Pig

# Location of piggybank.jar on local filesystem.## local_sample_dir=/usr/share/hue/apps/pig/examples# Location piggybank.jar will be copied to in HDFS.## remote_data_dir=/user/hue/pig/examples

Sqoop2

server_url=http://master:12000/sqoopsqoop_conf_dir=/home/sqoop-1.99.6/conf

启动及界面

启动

首先启动Hadoop集群中的HDFS,YARN,HBase等相关组件。

然后在$HUE_HOME目录下:

nohup build/env/bin/supervisor &

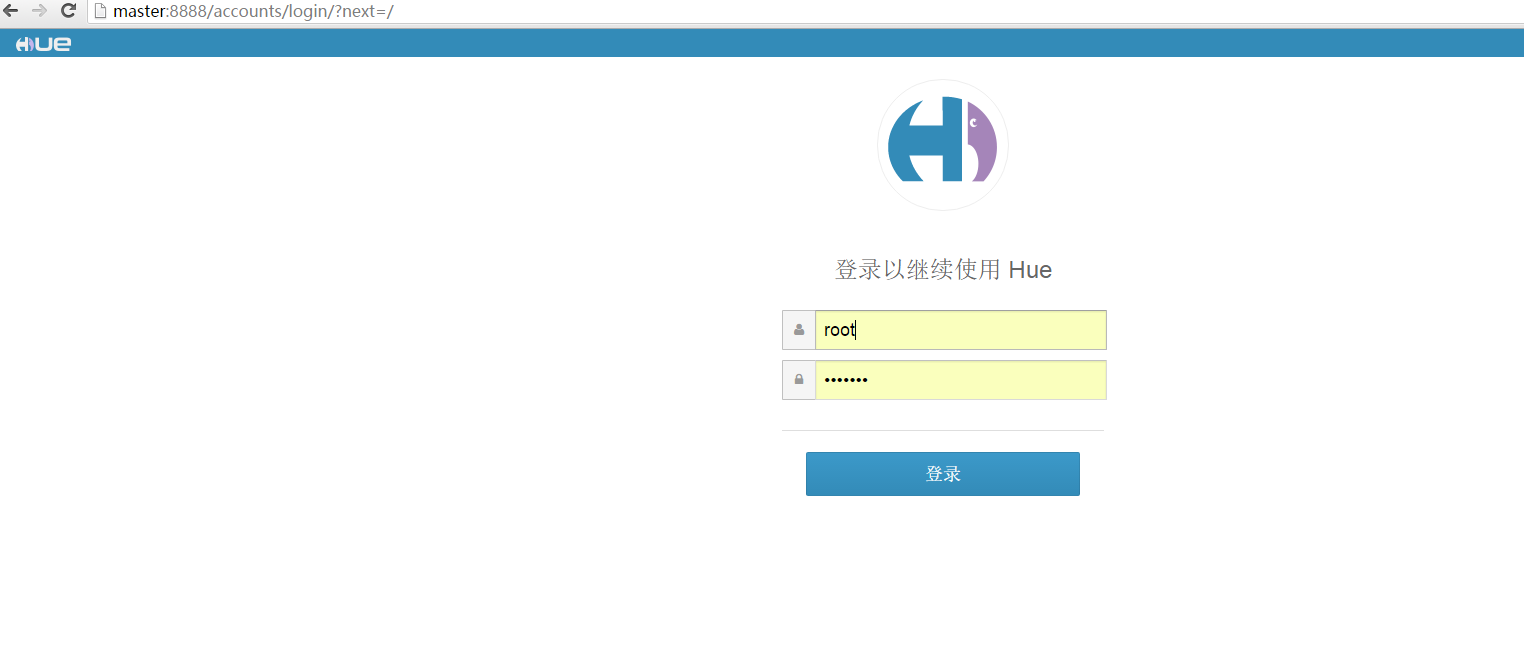

根据配置的端口访问,我这里是8888端口:

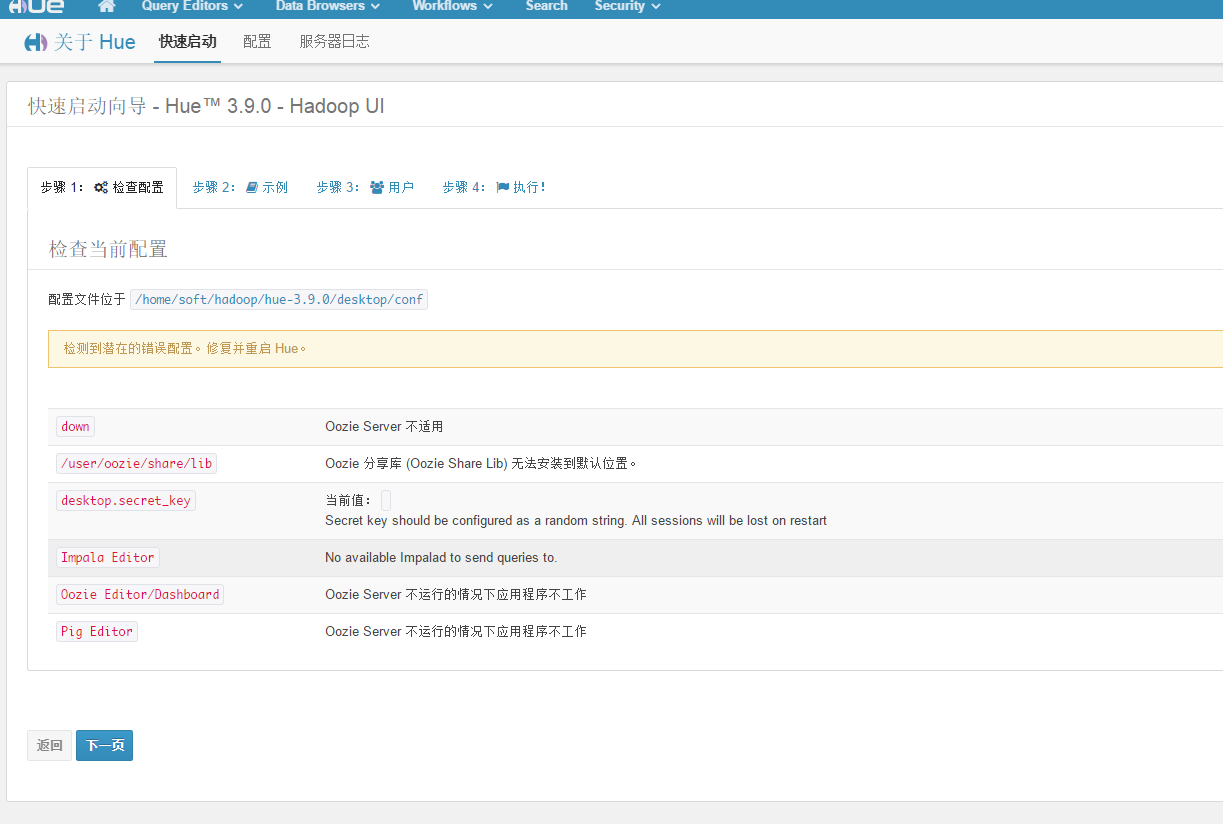

首次访问时,会让你设置用户名和密码,这个是超级管理账号。登陆后:

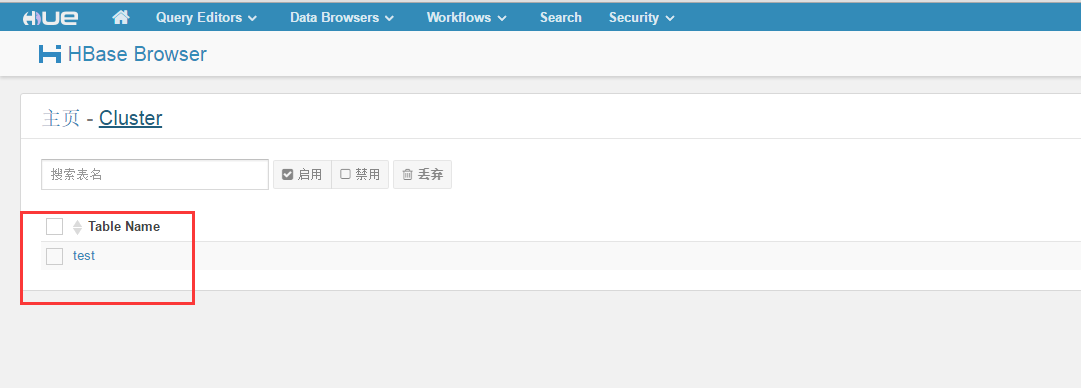

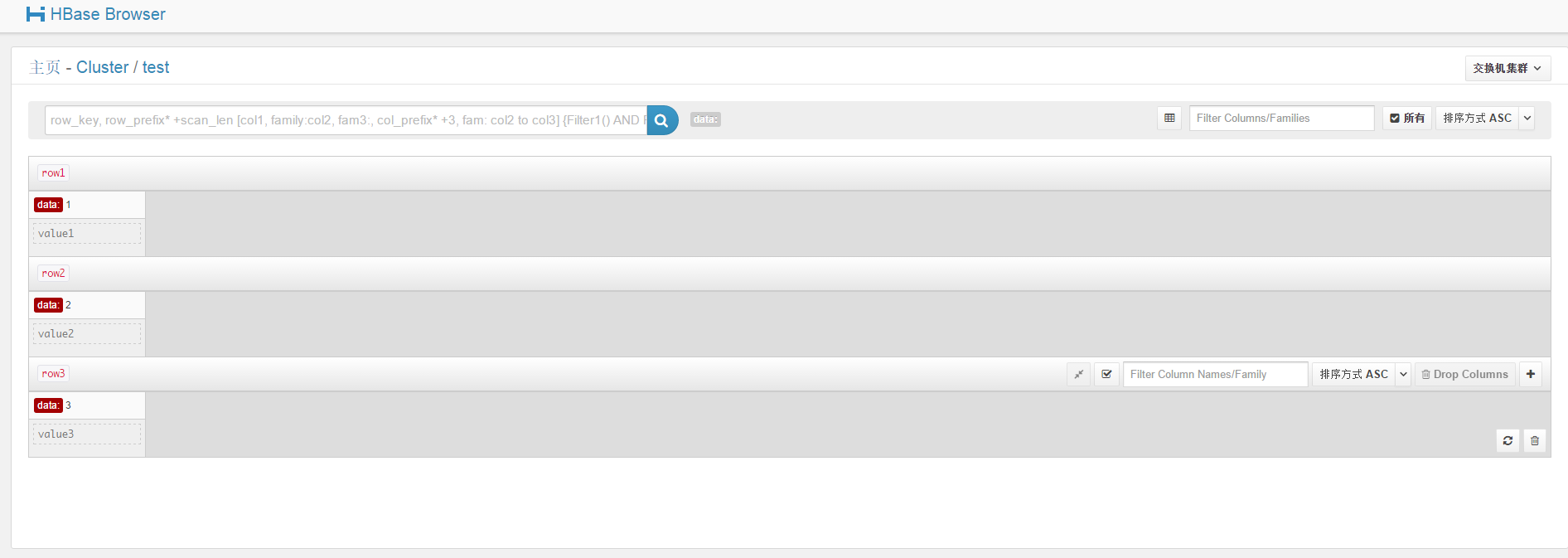

HBase界面

先要启动HBase的Thrift Server:

% start-hbase.sh% hbase thrift -p 9090

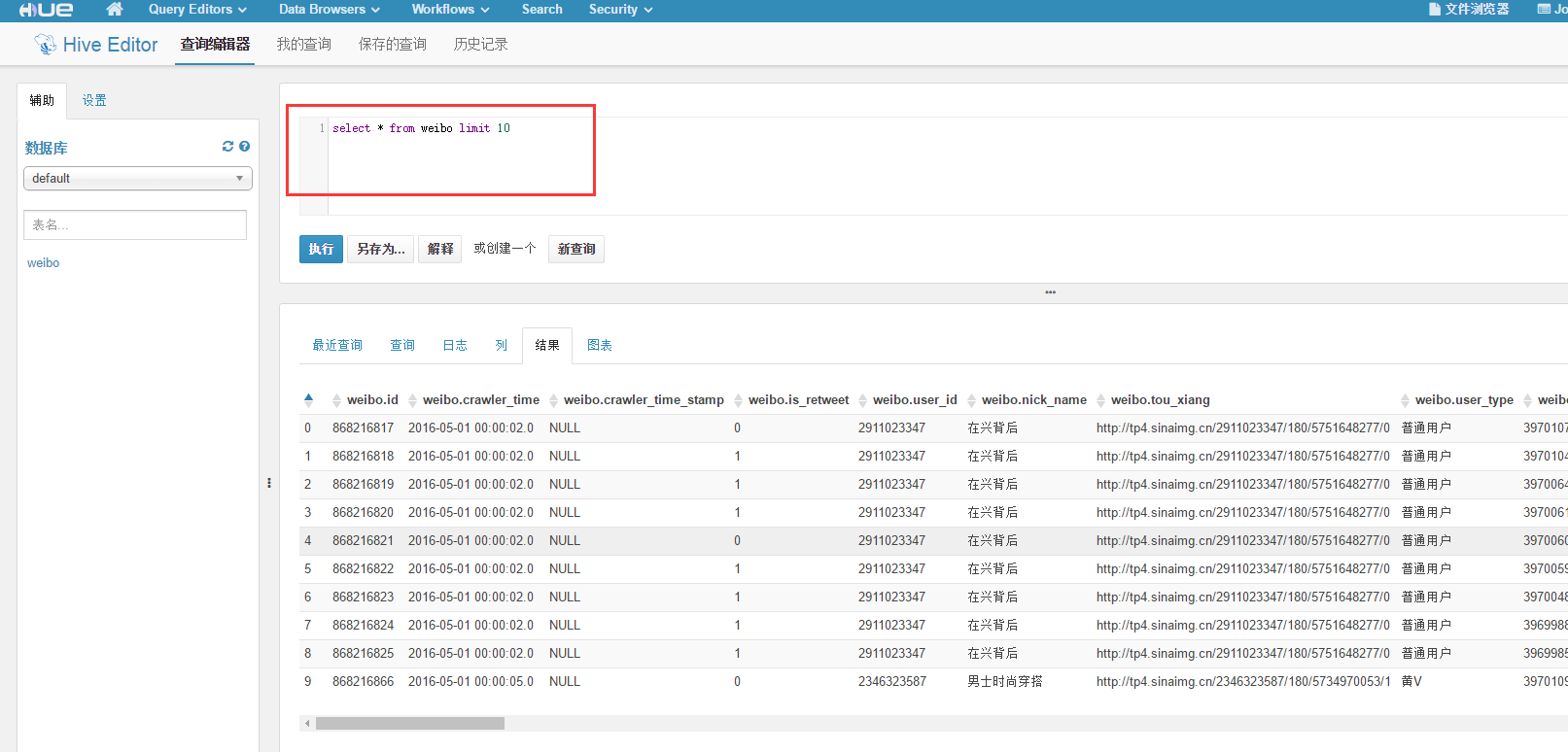

Hive界面

首先要启动HiverServer2

% hiveserver2

Hive查询:

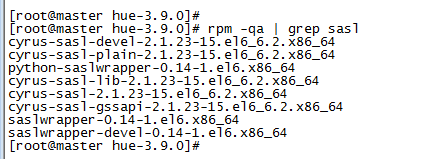

异常情况:

Hive metastore异常:Could not start SASL: Error in sasl_client_start (-4) SASL(-4): no mechanism available: No worthy mechs found

解决方案:安装sasl缺失的依赖,确保安装了以下依赖:

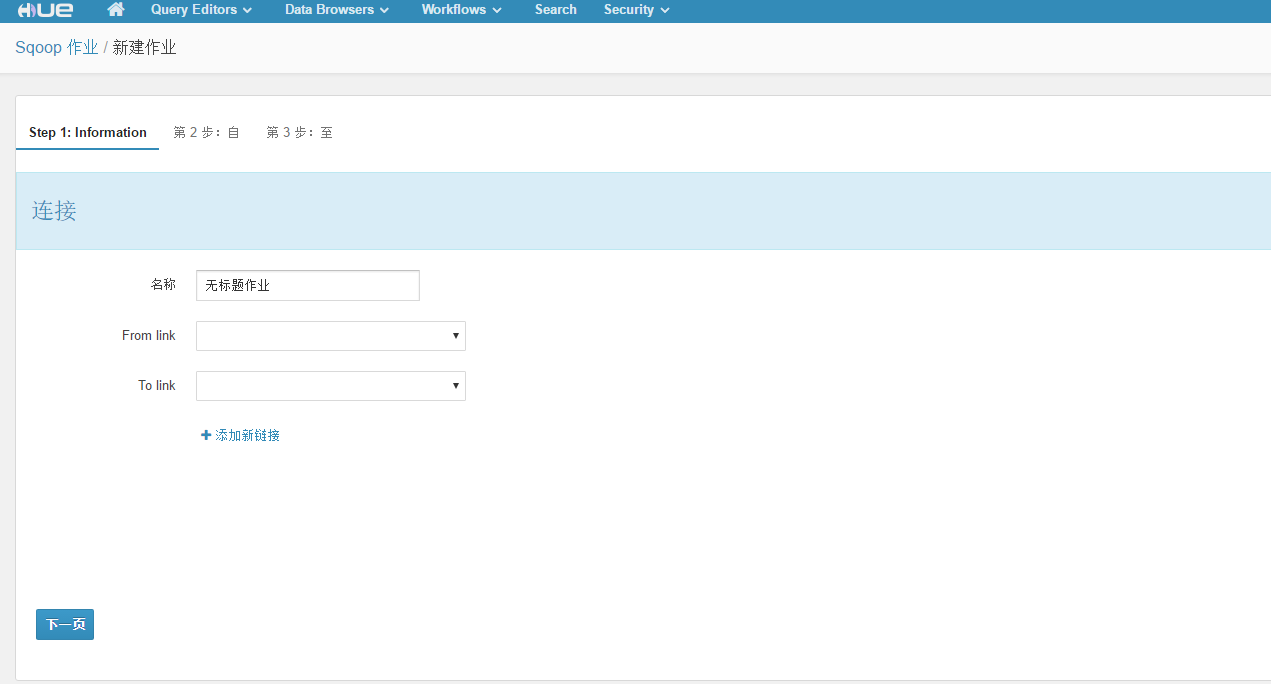

Sqoop作业

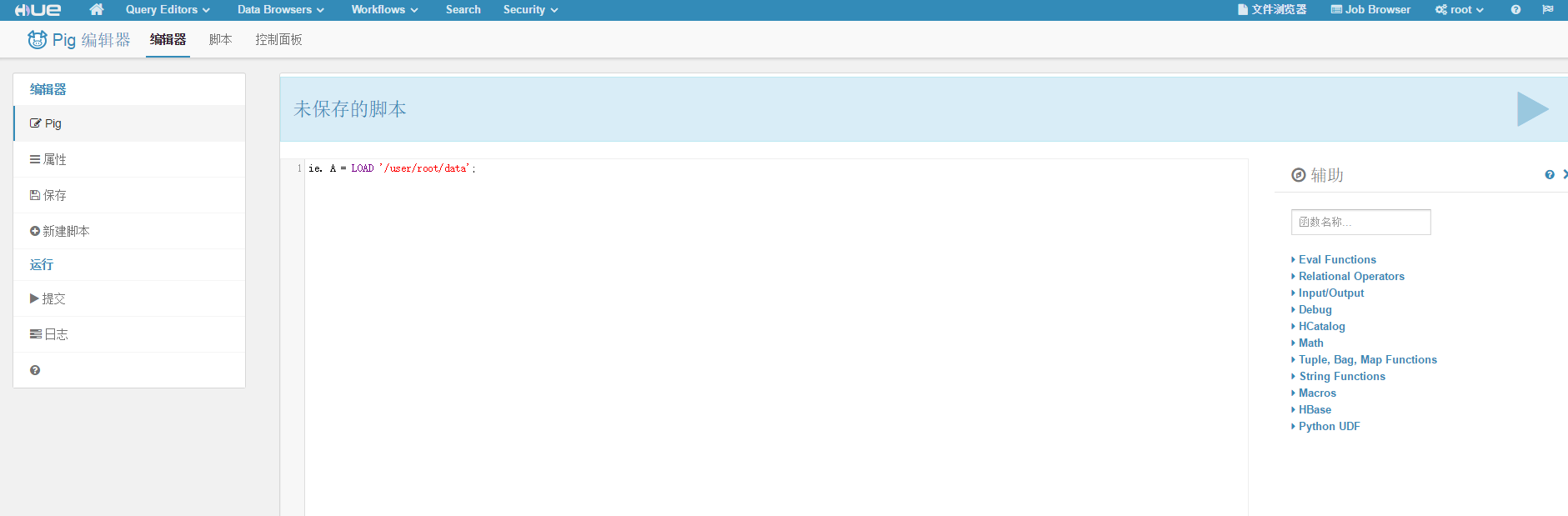

Pig脚本

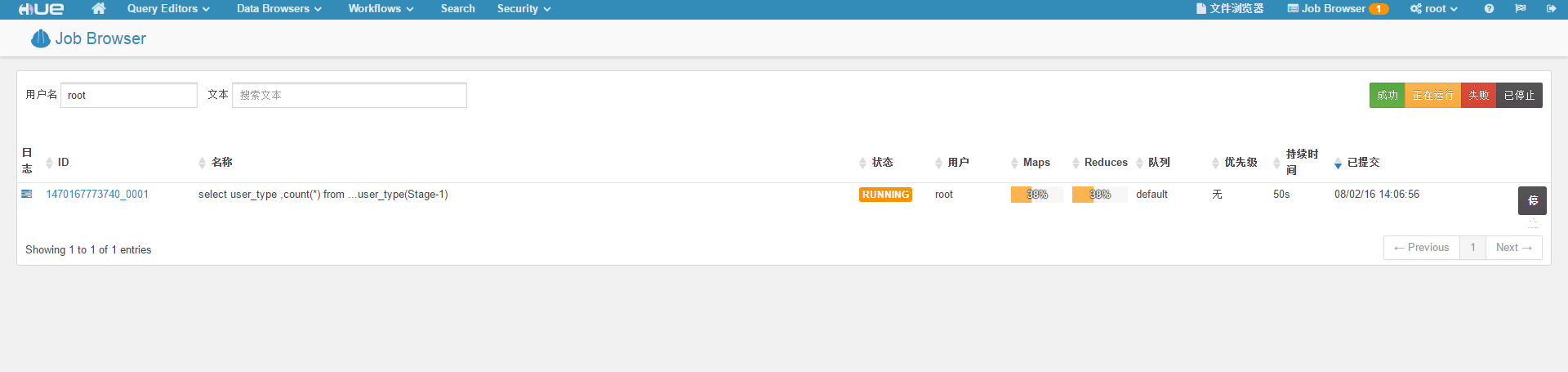

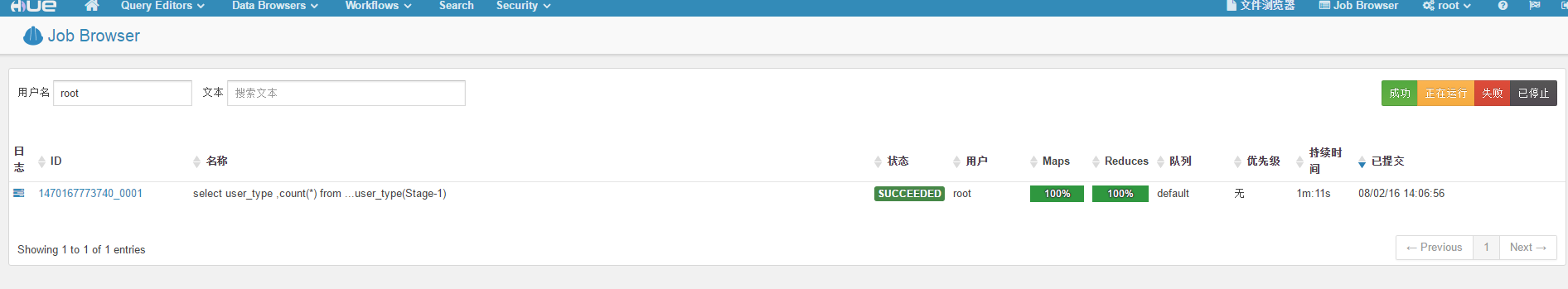

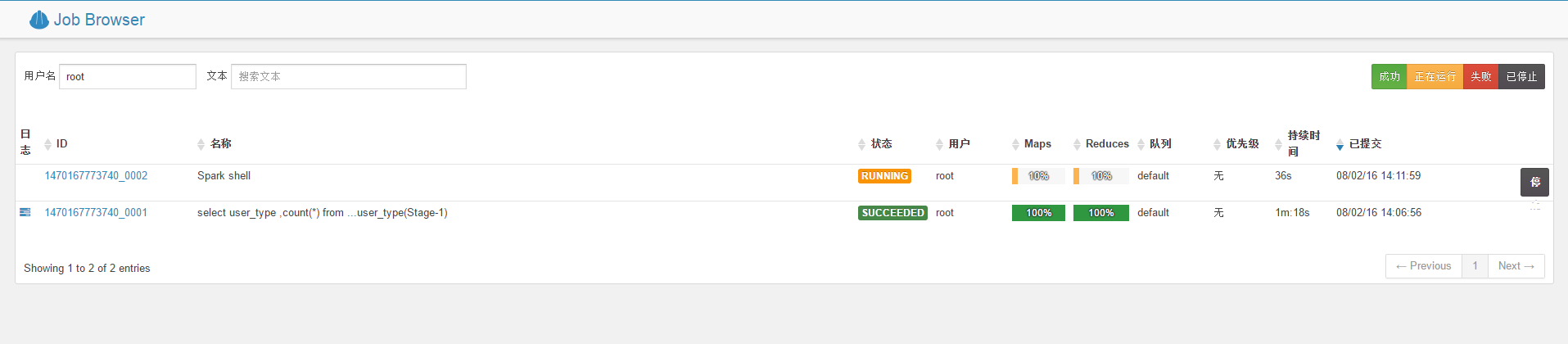

作业执行情况

启动Spark-shell后:

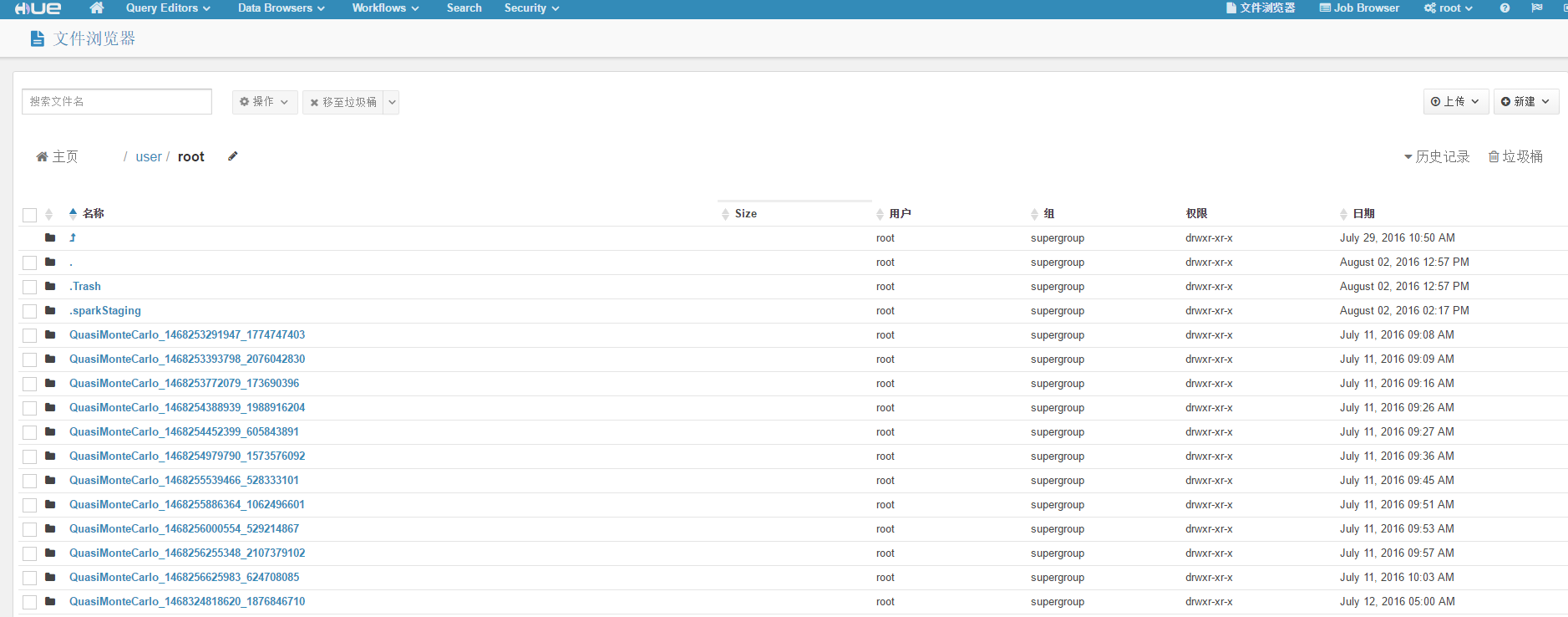

文件浏览

参考资料

Hue项目:

http://gethue.com/

https://github.com/cloudera/hue

Hue安装配置实践:

http://www.tuicool.com/articles/zIrqemB

Hue3.9 Tarball安装:

http://blog.csdn.net/bluishglc/article/details/48393291

Hue安装及问题:

http://blog.csdn.net/wenlong237/article/details/19735603 http://blog.csdn.net/zhoujj303030/article/details/44832363

(完)