@songhanshi

2021-05-10T08:42:23.000000Z

字数 303941

阅读 1662

Link

1234

- Link

- improve

- 1-base

- 2-concurrent

- 3-jvm

- ※ 3-JVM(Java Virtual Machine)※

- 4-mysql

- 5-redis

- 8-redis分布式锁

- 5-os&net

- 6-Spring

- mybatis

- 9-中间件

- 0-项目

https://www.nowcoder.com/discuss/594676?source_id=discuss_experience_nctrack&channel=-1

负载均衡--https://blog.csdn.net/My_Way666/article/details/91433816

zk -- https://www.jianshu.com/p/30f3c0ce2c5b

加一个

improve

名词

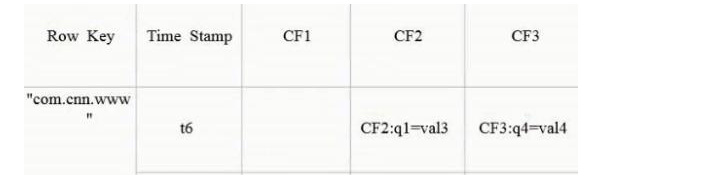

- 吞吐量:

吞吐量就是处理器用于运行用户代码的时间与处理器总消耗时间的比值:

- DDL:

操作数据库、表、列等(这些对象进行操作),使用的关键字:CREATE、 ALTER、DROP。 - DML:

对表中的数据进行增、删、改的操作,使用的关键字:INSERT 、UPDATE、 DELETE。 - TPS:

TPS(Transactions Per Second,每秒事务处理量)

Transactions Per Second(每秒传输的事务处理个数),即服务器每秒处理的事务数。TPS包括一条消息入和一条消息出,加上一次用户数据库访问。(业务TPS = CAPS × 每个呼叫平均TPS) - QPS:

QPS(Queries Per Second,每秒查询次数)

对应fetches/sec,即每秒的响应请求数,也即是最大吞吐能力。 - IOPS:

简单的理解就是每秒的磁盘操作次数 - Rt(ResponseTime响应时间)

测试工具

性能

- 1 性能方面的三个重要度量指标?

吞吐量、延迟和并发量。

--吞吐量:指的是单位时间内能处理的请求数量。吞吐量越高,说明性能越好。

--延迟:指的是从发出请求到收到响应的时间。延迟越小,说明性能越好。

--并发量:指的是能同时处理的请求数量,一般来说随着并发量的增加、延迟也会增加。所以延迟这个指标,一般都会是基于并发量来说的。例如并发量是 1000 的时候,延迟是 50 毫秒。 - 2 多线程--延迟、吞吐量

--同等条件下,延迟越短,吞吐量越大

--多线程的使用:从度量的角度,主要是降低延迟,提高吞吐量。

怎么降低延迟,提高吞吐量呢?

--“降低延迟,提高吞吐量”的2个方向,一是优化算法,二是将硬件的性能发挥到极致。前者属于算法范畴,后者则是和并发编程相关。

--计算机主要有哪些硬件呢?主要是两类:一个是I/O,一个是CPU。

--简言之,在并发编程领域,提升性能本质上就是提升硬件的利用率,再具体点来说,就是提升 I/O 的利用率和 CPU 的利用率。

--操作系统不是已经解决了硬件的利用率问题了吗?

① 操作系统--解决硬件利用率问题的对象往往是单一的硬件设备。例如操作系统已经解决了磁盘和网卡的利用率问题,利用中断机制还能避免 CPU 轮询 I/O 状态,也提升了CPU的利用率。

② 并发程序--往往需要CPU和I/O设备相互配合工作,即,多线程需要解决CPU和I/O设备综合利用率的问题。

高可用

监控

- 进程监控

- 进程监控:

对于日志监控来说,最见的需求就是收集、存储、查询、展示,开源社区正好有相对应的开源项目: logstash(收集) + elasticsearch(存储+搜索) + kibana(展示) - 项目中:kibana 邮件通知 微信报警通知

1-base

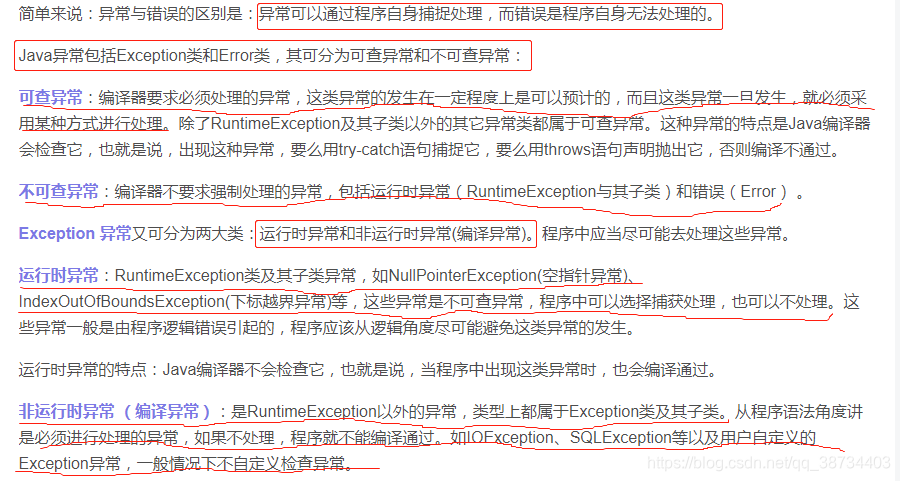

异常

- 异常√|异常

是什么:

-程序运行过程中可以中断程序指令正常执行的事件2种分类:

-Error、Exception

-父类都是java.lang.Throwable

-Error 系统错误 rd无法处理

-Exception rd可捕获异常可查异常和不可查异常

生产中:

-空指针

-下标越界

泛型

- Java泛型

- 定义:

-JavaSE1.5的新特性

-本质:参数化类型,即把所操作的类型被指定为一个参数 - 问题:

-类型转换

解决:强转、泛型 - 用法:

-可以使用在类、接口和方法,称为泛型类、泛型接口、泛型方法

-List list = new ArrayList()

改为

List list = new ArrayList();

-只在编译阶段有效,即:

编译过程,程序会正确的检验泛型结果;编译成功后,class文件不包含任何泛型信息

-用?代替任意类型

反射

- Java反射_YSO|反射_zejian

- 定义:

任意类->获取类的所有属性、方法

任意对象->调用它任意属性、方法,并能改变它的属性 - 反射原理

-方法区主要用来存储被加载的类的类型信息->当jvm加载某个类型时,需要类加载器定位到相应的class文件,将其读入jvm,然后jvm提取class中的类型信息,存储到方法区。

-class类

每加载一个新类型,jvm会在堆创建对应的Calss实例,该实例代表此类型,通过Class实例就可以访问到该类型的基本信息。(方法区存储的被加载类的类型信息)

-类型信息在Class中都有对应方法

如,类的全限定名 -> getName()可以获取

-反射机制的实现借助4个类:

class-类的对象

Constructor-类的构造器对象,可以在运行时动态创建对象

Field-类的属性对象,可以在运行时动态修改成员变量的属性值(包含private)

Method-类的方法对象,可以动态调用对象的方法(包含private) - 优缺点:

优:灵活

缺:消耗性能、增加复杂度 应用:

Hibernate怎样知道他要存的某个对象都有什么属性呢?这些属性都是什么类型呢?

应用1 反射原理

1)反射的概念

--概念:运行时,而非编译

2)反射机制的作用

--在运行时判断任意一个对象所属的类

--在运行时获取类的对象

--在运行时访问Java对象的属性,方法,构造方法等

3)实现依赖:reflect&Class

1> java.lang.reflect类库里面主要的类

File:表示类中的成员变量

Method:表示类中的方法

Constructor:表示类的构造方法

Array:该类提供了创建数组和访问数组元素的静态方法

2> 反射依赖的Class类

--概念:用来表示运行时类型信息的对应类

每个类都有唯一一个与之相对应的Class对象。

Class类为类类型,而Class对象为类类型对象。

--Class类的特点:

Class类也是类的一种,class是关键字。

Class类只有一个私有的构造函数,只有JVM能够创建Class类是实例。(只有一个私有构造函数,无法new)

JVM中只有唯一一个和类相对应的Class对象来描述其类型信息。

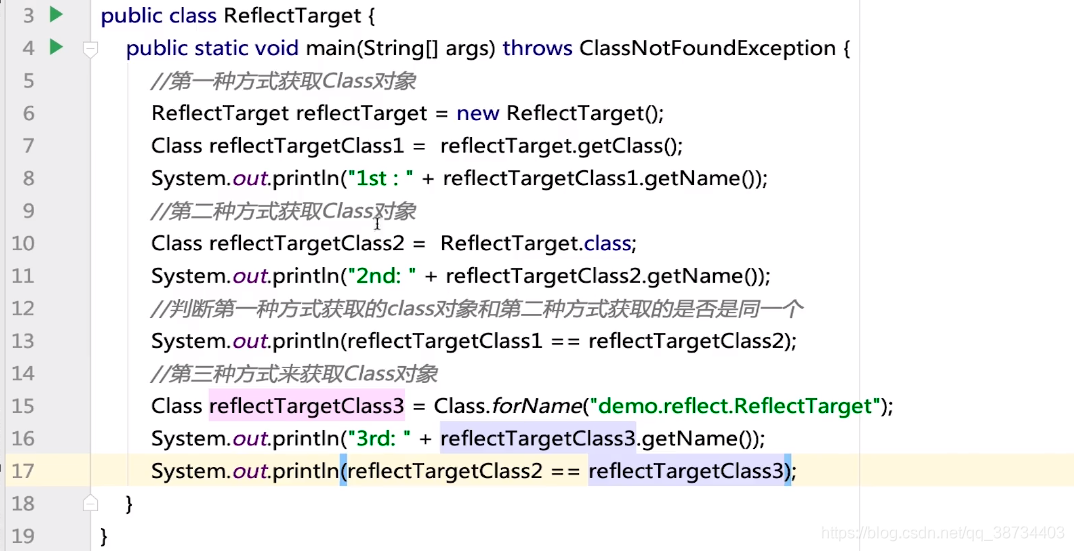

--获取Class对象的三种方式:

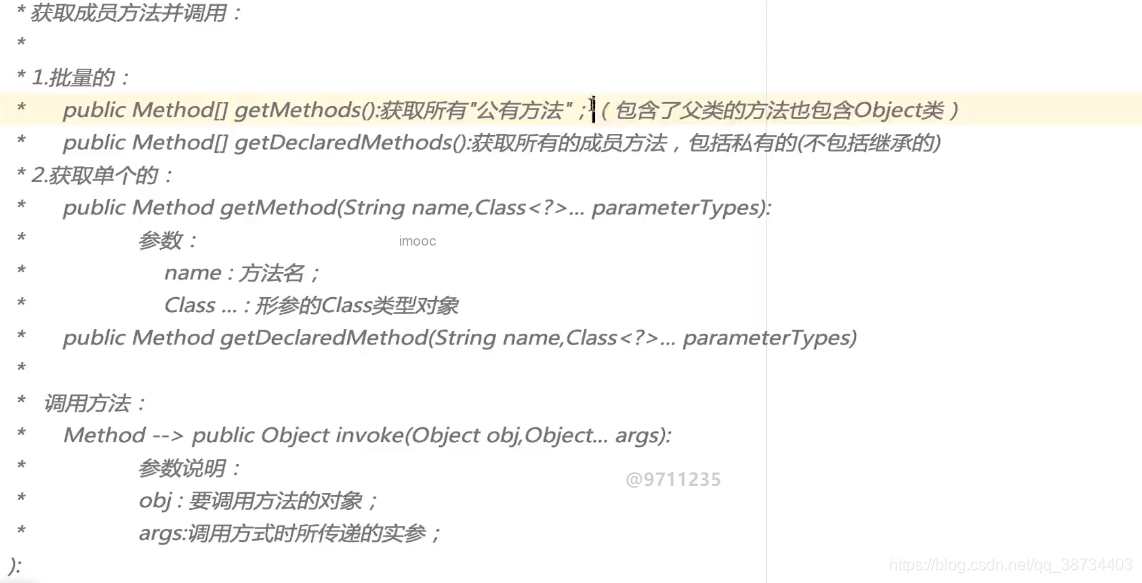

- 2 获取构造方法、成员变量、成员方法

补充:...私有的,或保护、默认、共有;

序列化与反序列化

- 序列化&反序列化

- 序列化:

-是 堆中的对象数据->某种方式->存储到磁盘文件中或传递给其他网络节点的过程。

即,将数据结构或对象转换成二进制的过程 - 反序列化:

-磁盘文件中或网络节点上的对象数据,恢复成Java对象模型的过程。

即,将序列化过程生成的二进制串转换成数据结构或对象 - 存在原因:

-分布式 网络传输对象数据

-服务器钝化:节省内存

对象很久没动,持久化在本地磁盘

需要活动了,先内存,找不到再去磁盘恢复 - 怎么进行序列化?

-① 类 实现序列化接口Serializable 如Integer、String等大多数已实现

-② 判断当前对象是Serializable的实例,允许序列化

-③ Java中使用对象流完成序列化反序列化

序列化ObjectOutputStream:writeObject()

反序列化ObjectInputStream:readObject() - 问题:

① 一些属性不序列化:加 transient

② 序列化版本问题:反序列化出错

对象中增加一个serialVersionUID

深拷贝与浅拷贝

- 深拷贝和浅拷贝

- 创建对象的5种方式

①、通过 new 关键字

②、通过 Class 类的 newInstance() 方法

③、通过 Constructor类的newInstance 方法

④、利用 Clone 方法

⑤、反序列化 - Object类的clone()方法

- 浅拷贝:

-调用对象的clone():Person类必须是实现Cloneable接口并覆写clone()

-P1,P2clone()后,复制了引用,P1某一属性改变,即堆中数据改变,P2也改变

-当前对象的非静态字段复制到新对象

值类型->复制字段

引用类型->复制引用不复制引用的对象;引用同一个对象 - 深拷贝:

-将当前对象的非静态字段复制到该新对象

-值类型、引用类型,都复制独立的一份。

修改其中一个对象的任何内容时,不会影响另一个对象的内容。 - 深拷贝实现:

-Object.clone()只能实现浅拷贝

-2种:

让每个引用类型属性内部重写clone()

弊端:可能嵌套

-利用序列化 实现Serializable接口

设计模式

- 中英文对照

- 观察者模式

- 建造者模式

- 生产者消费者

- https://www.cnblogs.com/chentingk/p/6497107.html

- https://www.cnblogs.com/chentingk/p/6497107.html

https://www.cnblogs.com/conswin/p/6754085.html - 代理模式

- 装饰器模式

- https://www.cnblogs.com/xrq730/p/4908940.html

- 工厂模式

--[简单工厂:https://www.cnblogs.com/java-my-life/archive/2012/03/22/2412308.html

--[工厂方法:https://www.cnblogs.com/java-my-life/archive/2012/03/25/2416227.html

--[抽象工厂:https://www.cnblogs.com/java-my-life/archive/2012/03/28/2418836.html - 适配器模式

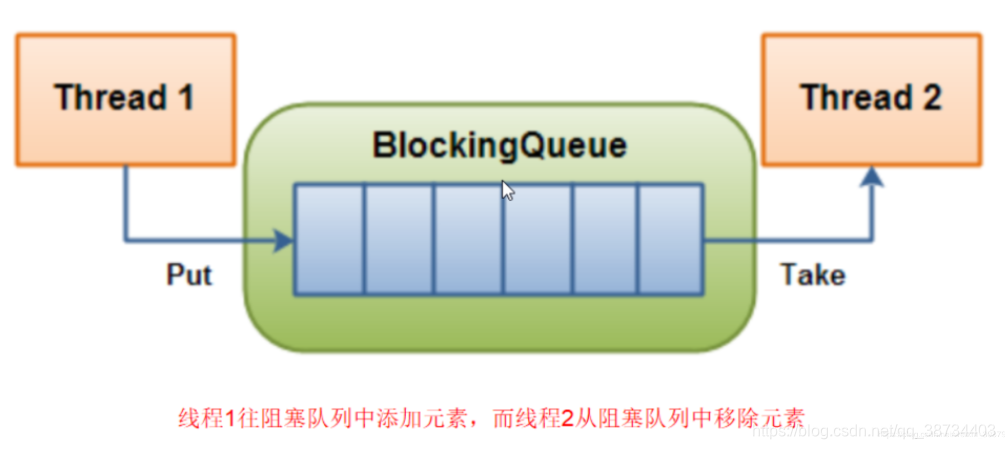

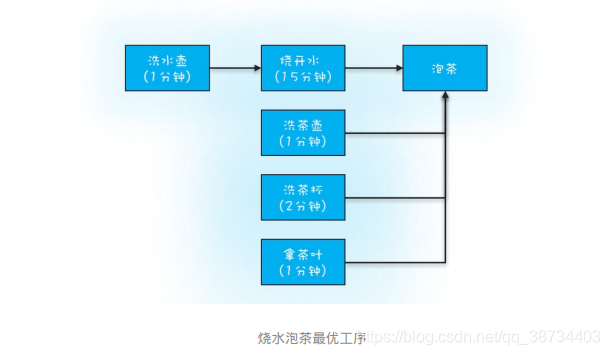

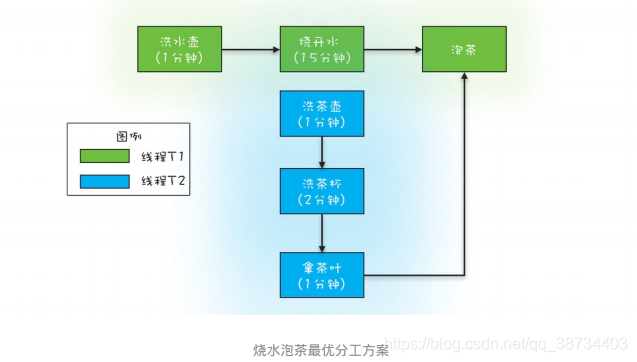

生产者-消费者

生产者-消费者模式实现批量执行SQL:

将原来直接INSERT数据到数据库的线程作为生产者线程,生产者线程只需将数据添加到任务队列,然后消费者线程负责将任务从任务队列中批量取出并批量执

行。

--示例:创建了5个消费者线程负责批量执行SQL,

5个消费者线程以 while(true){}循环方式批量地获取任务并批量地执行。

需要注意的是,从任务队列中获取批量任务的方法pollTasks()中,

首先是以阻塞方式获取任务队列中的一条任务,而后则是以非阻塞的方式获取任务;

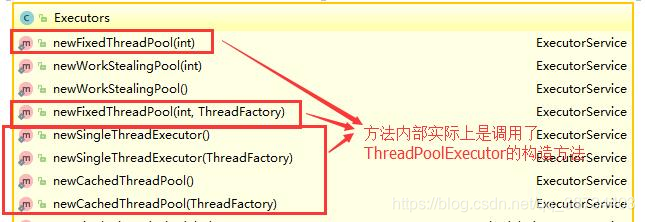

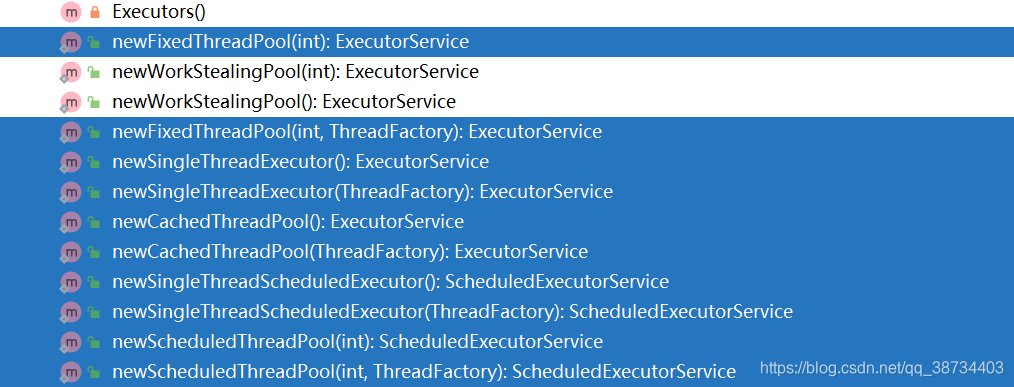

之所以首先采用阻塞方式,是因为如果任务队列中没有任务,这样的方式能够避免无谓的循环。//任务队列BlockingQueue<Task> bq=new LinkedBlockingQueue<>(2000);//启动5个消费者线程//执行批量任务void start() {ExecutorService es=xecutors.newFixedThreadPool(5);for (int i=0; i<5; i++) {es.execute(()->{try {while (true) {//获取批量任务List<Task> ts=pollTasks();//执行批量任务execTasks(ts);}}catch(Exception e){e.printStackTrace();}});}}//从任务队列中获取批量任务List<Task> pollTasks() throws InterruptedException{List<Task> ts=new LinkedList<>();//阻塞式获取一条任务Task t = bq.take();while(t != null){ts.add(t);//非阻塞式获取一条任务t = bq.poll();}return ts;}//批量执行任务execTasks(List<Task> ts) {//省略具体代码无数}

4.如何实现一个生产者和消费者模型。

3. 消费者重平衡(高可用性、伸缩性)

4. 那些情景下会造成消息漏消费?

5. 如何保证消息不被重复消费(幂等性)

8. 消费者与生产者的工作流程:

单例模式

- 单例模式-YSO|me

- 单例模式特点:

-类只能有一个实例

-类必须自己创建自己的实例

-类必须提供外界获取这个实例的方法 - 懒汉模式-双重校验

-创建变量的2步:(编译优化可调换)

①申请一块内存,用构造方法初始化

②分配指针一个指针指向该内存

-问题:

A线程开始创建Singleton实例(Singleton singleton = null;),已经把instance指向那块内存,还未调用构造方法进行初始化;

此时B已经调用了getInstance,首先判断instance是否为空,A已指向,不为空,B直接吧instance返回。

问题:instance不为null,但A并没有构造完成。

-解决

volatile Singleton singleton = null;/内部静态类

基本类型分类

- 4类8种类型

1)四种整数类型(byte、short、int、long)

2)两种浮点数类型(float、double)

3)一种字符类型(char)

4)一种布尔类型(boolean) - 占位

byte:2个字节 16位

char:2个字节 16位

short :2个字节 16位

int :4个字节 32位

long:8个字节 64位

float:4个字节 32 位

double :8个字节 64位 - 默认值

-byte,short,int类型的默认值为0

-float,double默认值为0.0

-char等价于short其默认值也为0

-boolean的默认值为false。

-java中基本类型的默认值是0,引用类型会默认为null。

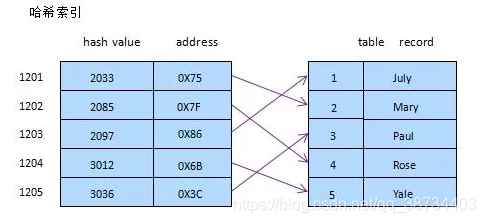

哈希表

接口和抽象类

Object-equal、hashcode

- object源码解析_YSO|

- equals()

-equals与==

-Object中的equals 无区别

==比较两个对象在栈中引用地址是否相等

-String重写实现:会获取字符串的内容进行比较

-重写时也需要重写hashcode

保证声明相等对象具有相同哈希代码 - getClass()

-native修饰 操作系统实现 - hashCode()

-native

-作用:返回对象的散列码

-存在意义:往集合中增加元素,equals判断相等,若已存在n个,将会判断n次,效率低

-哈希表 O(1) 比较减少

-应用:

如需存在Map中为key,不重写可能会和对象hash值不一致 - toString()

- notify()/notifyAll()/wait()

- finalize()

-一般jvm自动调用,不需要rd手动调 - registerNatives

- equals和hashCode

两个对象相等,其 hashCode 一定相同;

两个对象不相等,其 hashCode 有可能相同;

hashCode 相同的两个对象,不一定相等;

hashCode 不相同的两个对象,一定不相等;

Integer

- Integer的源码|拆装箱

- 装箱

-直接创建:Integer a=128;

-反编译 Integer a=Integer.valueOf(128);

-valueOf(i)实现

---128 <= i <= 127 返回缓存类中的对象,并没new新的对象

--最后返回new Integer(i); - 拆箱

-实现 intValue() - equals

-先判断比较两个对象的关系

再强转Integer型,拆箱后,转换成两个int,用==比较 - hashcode

直接返回int 数据 return value - compareTo()内部调用compare

-(x < y) ? -1 : ((x == y) ? 0 : 1);

-x < y 返回 -1

x == y 返回 0

x > y 返回 1

String

- String源码_YSO|hashcode乘积因子31?

- public final calss String{

-final修饰,不被任何类继承 - char value[]

一个String字符串->一个char数组 - equals()

equals重写,比较 组成字符串的每一个字符是否相同,相同true,否则false - hashcode

-计算

使用for循环:val[i]和31的幂连乘

for(){h = 31 * h + val[i];}

-为什么是31

@选择奇质数

偶数在乘法运算中会产生溢出,导致信息丢失,*2相当于移位。奇质数优势并不明显,传统。

太大或太小导致分布不佳,冲突率上升

@多奇质数,如,33,41..为什么31

能被jvm优化,乘法运算转移位和减法

31 * i = (i << 5) - i - 常量池

-声明字符串对象的2种形式

①字面量形式直接赋值

String str = "hello";

②new调用构造函数创建对象

String str = new String("hello");

-区别:

字面量/拼接,先在StringTable找,没有 在StringTable创建

new,直接在堆中创建新对象

变量所引用的都是这个新对象的地址,新对象的字符串在StringTable存在,堆指向StringTable对应字符串,不存在,在堆中创建,StringTable不维护 - intern()

public native String intern()

String str1 = "hello";//字面量 只会在常量池中创建对象

String str2 = str1.intern();

-调用intern 常量池中有该对象了,直接返回该字符串的引用(存在堆中就返回堆中,存在池中就返回池中),如果没有,则将该对象添加到池中,并返回池中的引用。 - 不可变?

-可变

private final char value[]

final保证引用不被改变,真实数据为value指向的堆中的数组,操作这个数组便能改变数据。

value基本类型构成,可变,即使private,也可以反射改变。但开发中基本不会 反射机制 操作String

-保证不可变

①public final calss String{

final修饰,不被任何类继承

②private final char value[]

final保证引用不被改变

private不对外界提供修改value数组值的方法。 - 为什么要不可变

①安全

-引发安全问题。

如,数据库的用户名、密码都是以字符串的形式传入来获得数据库的连接。

字符串不可变,值不可改变,否则黑客攻击,改变字符串指向对象值,安全漏洞

-线程安全

并发,多线程同时读写,引发竞态条件,String不可变,线程安全

-HashCode

String不可变,value不变,hashcode固定。Map、Set 等,键值需要保证唯一性和一致性,String更适合。

②性能

当字符串是不可变时,字符串常量池才有意义。

字符串常量池,可以减少创建相同字面量的字符串,让不同的引用指向池中同一个字符串,为运行时节约很多的堆内存。每次创建新的 String不用在堆内开辟出新的空间,占据更多内存。 - 常用方法

charAt(int index)--由下标获取 字符

split--str.split(",", 2)-分为给定正则的匹配

substring--截取一段字符串

intern() --避免在堆中创建字符串 - 为什么String用char数组存储?

理解:

-基本字符类型只有char

-equals对比每个字符

-hashcode循环计算

-charAt()直接获取

-compareTo逐个比较 - Person person = new Person();

Person类的 .class 信息存放在方法区中

person 变量存放在 Java 栈的局部变量表中

真正的 person 对象存放在 Java 堆中

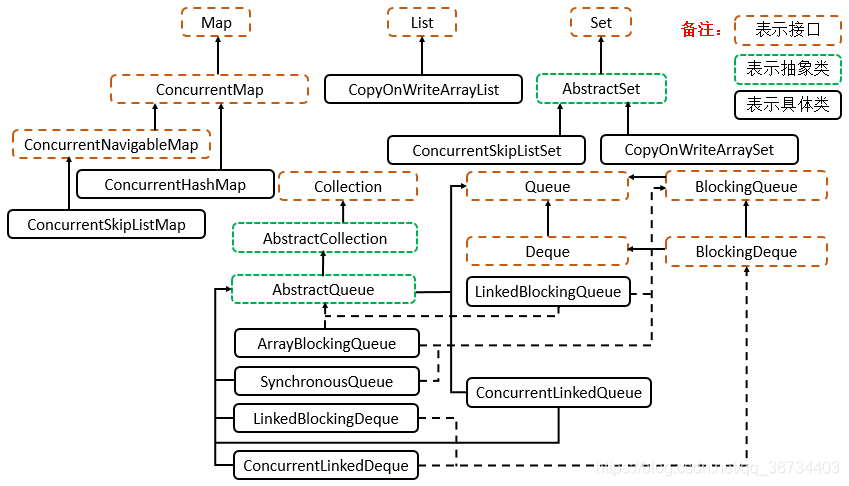

集合概述

- |基础源码解析|

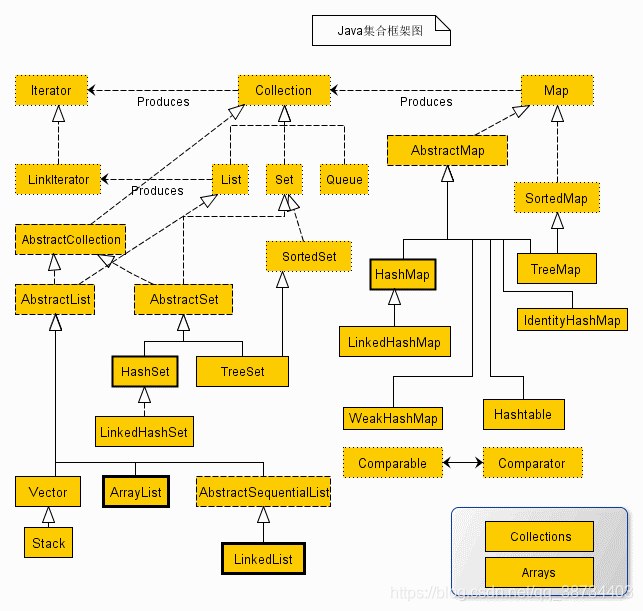

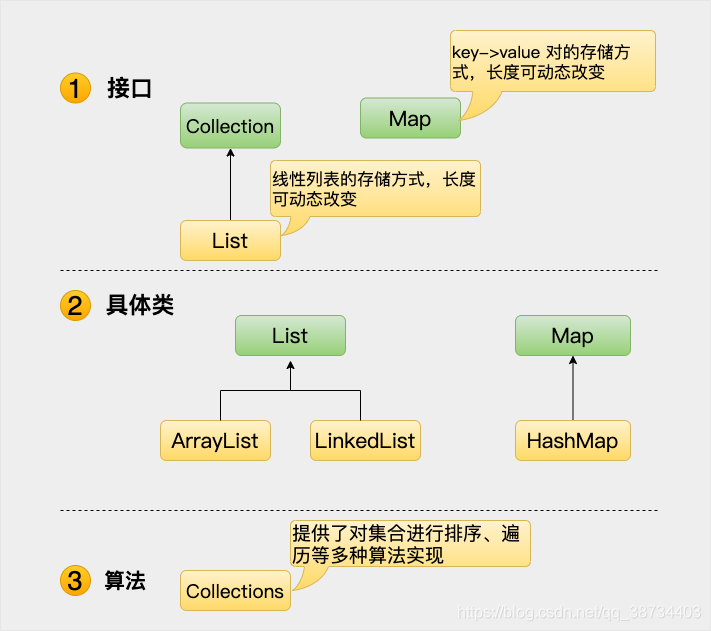

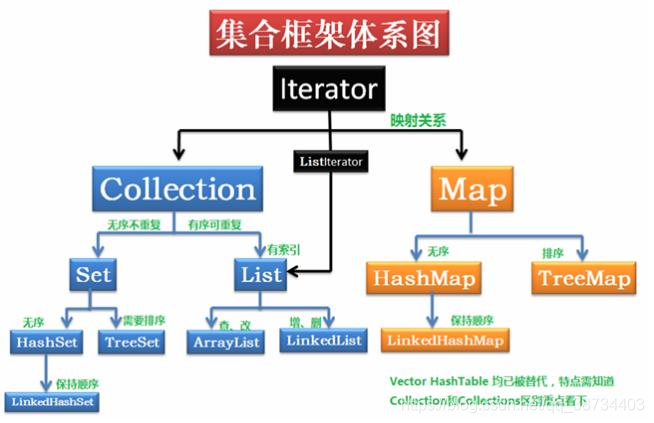

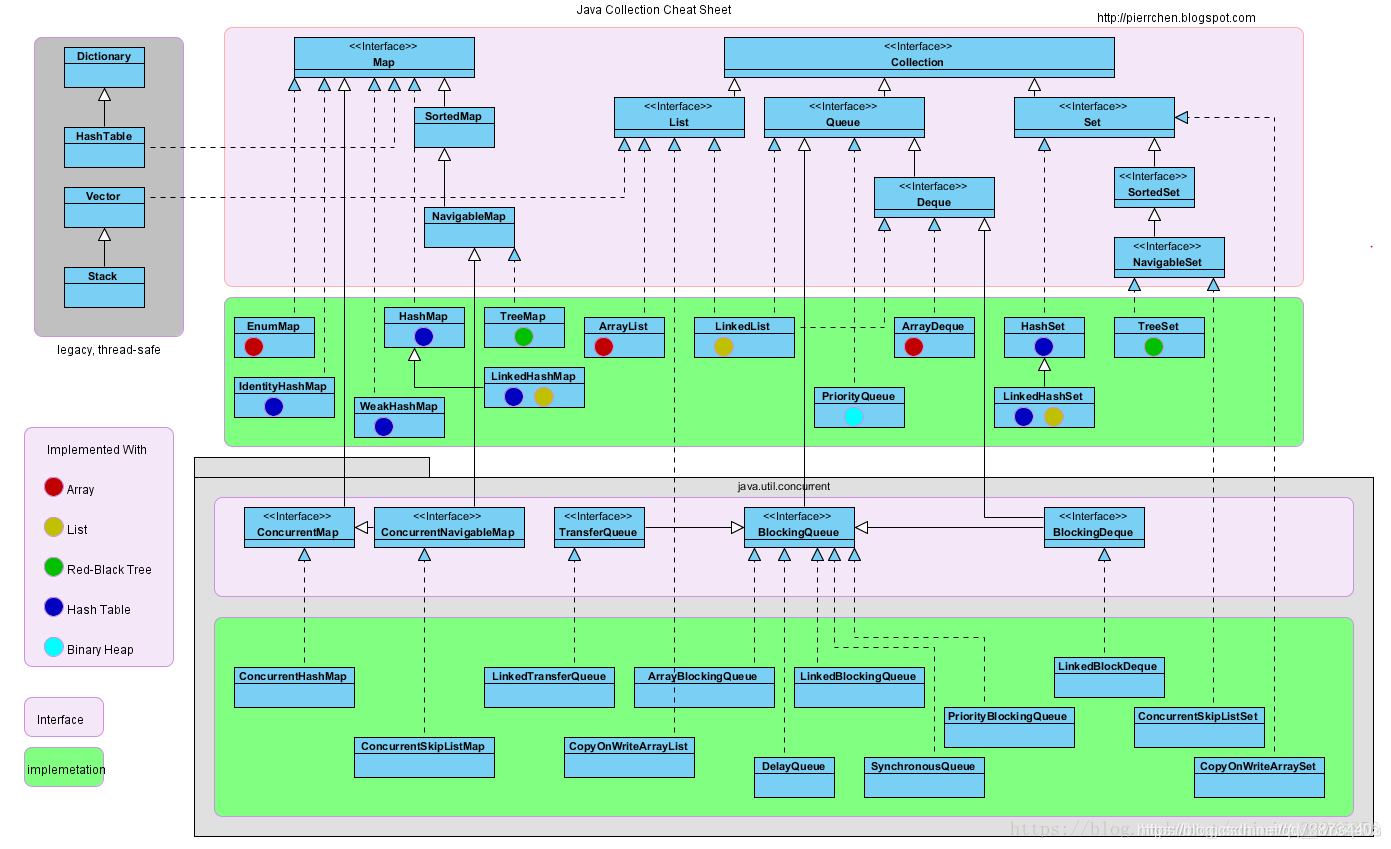

- 1 集合框架概述 /集合架构/集合体系

--参考

--Java 集合框架主要包括2种类型的容器:

① 集合(Collection):存储一个元素集合;

② 图(Map):存储键/值对映射。

Collection 接口又有 3种子类型,List、Set和Queue,再下面是一些抽象类,最后是具体实现类,常用的有 ArrayList、LinkedList、HashSet、LinkedHashSet、HashMap、LinkedHashMap 等等。

2 集合框架内容

集合框架是一个用来代表和操纵集合的统一架构。所有的集合框架都包含如下内容:

• 接口:是代表集合的抽象数据类型。

例如Collection、List、Set、Map等。之所以定义多个接口,是为了以不同的方式操作集合对象

• 实现(类):是集合接口的具体实现。从本质上讲,它们是可重复使用的数据结构,例如:ArrayList、LinkedList、HashSet、HashMap。

• 算法:是实现集合接口的对象里的方法执行的一些有用的计算,例如:搜索和排序。这些算法被称为多态,那是因为相同的方法可以在相似的接口上有着不同的实现。

--除了集合,该框架也定义了几个Map接口和类。Map 里存储的是键/值对。尽管Map不是集合,但是它们完全整合在集合中。

--java集合框架位于java.util包中,所以当使用集合框架的时候需要进行导包。

3 List和Set的区别

List 可重复,顺序存储,数组或者链表

Set 不可重复,无序,使用Map来存储数据

Map 键值对,key到value的映射- Key 唯一 无序

- value 不唯一 无序

tips:

list可以插入多个null元素,而set只允许插入一个null元素;

list是一个有序的容器,保持了每个元素的插入顺序。即输出顺序就是输入顺序,而set方法是无序容器,无法保证每个元素的存储顺序,TreeSet通过 Comparator 或者 Comparable 维护了一个排序顺序

4 了解的List和Map

| 接口 | 实现类 |

|---|---|

| List | ArrayList、LinkedList |

| Set | HashSet、TreeSet、LinkedHashSet |

| Map | HashMap、TreeMap、LinkedHashMap、HashTable |

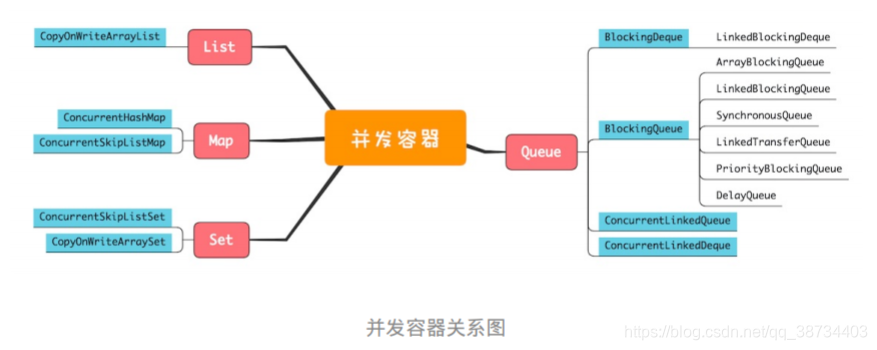

- 5 线程安全的集合

- 线程安全的集合:

Vector | HashTable | StringBuffer - 非线程安全的:

ArrayList|LinkedList|HashMap|HashSet|TreeMap|TreeSet|StringBulider

ArrayList和LinkedList区别

- Arraylist 与 LinkedList 区别? |7

1> 是否保证线程安全:都不安全

2> 底层数据结构:

-Arraylist 底层使用的是Object[]数组;

-LinkedList底层使用的是双向链表数据结构(JDK1.6之前为循环链表,JDK1.7取消了循环。)

3> 插入和删除是否受元素位置的影响: ①ArrayList采用数组存储,所以插入和删除元素的时间复杂度受元素位置的影响。

②LinkedList 采用链表存储,插入删除不受元素位置的影响,但插入和删除指定位置会先移动。

4> 是否支持快速随机访问:

ArrayList 支持。

LinkedList 不支持。

5> 内存空间占用:

ArrayList 的空间浪费体现在列表的结尾会预留一定的容量空间,

LinkedList 的空间花费则体现在它的每一个元素都需要消耗比ArrayList 更多的空间。

ArrayList->CopyOnWriteArrayList

- |1.8ArrayList源码|ArrayList_JG|1.8Arrays源码|for循环删除问题|快速失败安全失败

- 特点:ArrayList 用数组实现的集合,支持随机访问,元素有序且可以重复。

1 实现接口:

public class ArrayList<E> extends AbstractList<E>implements List<E>, RandomAccess, Cloneable, java.io.Serializable{private static final long serialVersionUID = 8683452581122892189L;private static final int DEFAULT_CAPACITY = 10;private static final Object[] EMPTY_ELEMENTDATA = {};private static final Object[] DEFAULTCAPACITY_EMPTY_ELEMENTDATA = {};transient Object[] elementData;private int size;

-Cloneable接口

--Object.clone() 浅拷贝调用 调用的对象必须要实现Cloneable接口,CloneNoSupportException异常

-List接口

--定义了实现该接口的类都必须要实现的一组方法 即平时用到的那些方法2 字段属性

//集合的默认大小private static final int DEFAULT_CAPACITY = 10;//空的数组实例private static final Object[] EMPTY_ELEMENTDATA = {};//这也是一个空的数组实例,和EMPTY_ELEMENTDATA空数组相比是用于了解添加元素时数组膨胀多少private static final Object[] DEFAULTCAPACITY_EMPTY_ELEMENTDATA = {};//存储 ArrayList集合的元素,集合的长度即这个数组的长度//1、当 elementData == DEFAULTCAPACITY_EMPTY_ELEMENTDATA 时将会清空 ArrayList//2、当添加第一个元素时,elementData 长度会扩展为 DEFAULT_CAPACITY=10transient Object[] elementData;//表示集合的长度rivate int size;

3 构造函数

-无参:创建初始容量为0的数组public ArrayList() {this.elementData = DEFAULTCAPACITY_EMPTY_ELEMENTDATA;}

-参数->初始大小n:

public ArrayList(int initialCapacity) {if (initialCapacity > 0) {this.elementData = new Object[initialCapacity];} else if (initialCapacity == 0) {this.elementData = EMPTY_ELEMENTDATA;} else {throw new IllegalArgumentException("Illegal Capacity: "+initialCapacity);}}

n>0 大小为n的数组

=0 空数组实例 <0 异常

-参数->集合:将集合复制到ArrayList集合中

-new ArrayList()--elementData赋值为DEFAULTCAPACITY_EMPTY_ELEMENTDATA,

new ArrayList(0)--elementData 赋值为 EMPTY_ELEMENTDATA,EMPTY_ELEMENTDATA添加元素会扩容到容量为1,而DEFAULTCAPACITY_EMPTY_ELEMENTDATA扩容之后容量为10

-elementData

transient修饰,JDK不想将整个elementData都序列化或者反序列化,而只是将size和实际存储的元素序列化或反序列化,节省空间和时间。- 4 add

-扩容实现:Arrays.copyOf(),创建一个更大的数组,将原数组元素拷贝过去

-扩容规则:((旧容量 * 3) / 2) + 1 原数组被抛弃,会被GC回收。

-add(e)

1 确认集合大小,满了,扩容

ensureCapacityInternal(size+1) 集合大小+1后判断

2 将元素加入elementData[size++]

-add(e)实现

1)无参构造一个空集合 初始长度 0

2)第1个add(a) 会创建一个长度10的数组,a在第一个位置

3)第2个add(b) 集合不为空 且集合长度size+1<数组长度10 添加 无需扩容

4)第11个add(c)

size+1=11 数组长度10 创建10+10*0.5=15的数组(1,5倍) Arrays.copyOf将原数组元素引用拷贝到新数组 c添加到index为10的位置

5)原容量的1.5倍比minCapacity小,那么就扩容到minCapacity,即size+1

5)第Integer.MAX_VALUE-8= 2147483639个,然后 2147483639%1.5=1431655759(这个数是要进行扩容) 次添加元素,为了防止溢出,此时会直接创建一个 1431655759+1 大小的数组,这样一直,每次添加一个元素,都只扩大一个范围。

6)Integer.MAX_VALUE - 7个

创建大小为Integer.MAX_VALUE的数组,再进行元素添加。

MAX_ARRAY_SIZE = Integer.MAX_VALUE - 8

7)第Integer.MAX_VALUE + 1个

抛出OutOfMemoryError 异常。 5 remove

-单个元素的删除:后续元素左移 引用置空GC回收

-for问题:删除某个元素后,list的大小size发生了变化,而索引也在变化,所以会导致你在遍历的时候漏掉某些元素。

如,删除第1个元素后,继续根据索引访问第2个元素时,因为删除的关系后面的元素都往前移动了一位,所以实际访问的是第3个元素。不会报出异常,只会出现漏删的情况;6 迭代器

-类实现了List接口,而List接口又继承了Collection接口,Collection接口又继承了Iterable接口

-删除

*迭代器初始化过程中会将modCount这个值赋给迭代器的expectedModCount

*Itr的next()迭代的时候,被遍历期间如果内容发生变化,就会改变modCount的值,会校验modCount是否等于expectedModCount

*Itr的remove()移除之后将modCount重新赋值给 expectedModCount(不是ArrayList的remove)

-缺点:迭代器只能向后遍历,不能向前遍历,能够删除元素,但是不能新增元素- 7 trimToSize()

确定不再新增元素 复制 - 8 线程不安全

①多线程add发生覆盖

-添加元素2步:

1 计入元素 2移动标志位

elementData[index] = element;

size++;

单线程:i=0,add元素在位置0,size=1

多线程:size=0,A将元素放到位置0挂起,B获取cpu,size=0,元素存储在0位置,AB对size都+1,size=2,但只有一个元素

②扩容发生越界

数组大小为10,add(e),A添加第10个元素,判断容量不需扩容,挂起,B判断不需扩容,添加元素,移动标志位,此时A继续,但已越界 9 modCount

-父类AbstractList modCount属性--记录数组修改次数(可查看源码865行)

-ConcurrentModification Exception。即并发修改异常

-快速失败:

在使用迭代器对集合进行迭代的过程中,如果 A 线程正在对集合进行遍历,此时 B 线程对集合进行修改(增加、删除、修改),或者 A 线程在遍历过程中对集合进行修改,都会导致 A 线程抛出 ConcurrentModificationException 异常。

保证modCount在迭代期间不变

-安全失败:

采用安全失败机制的集合容器,在遍历时不是直接在集合内容上访问的,而是先复制原有集合内容,在拷贝的集合上进行遍历。

由于迭代时是对原集合的拷贝进行遍历,所以在遍历过程中对原集合所作的修改并不能被迭代器检测到,故不会抛 ConcurrentModificationException 异常- 内存够用情况下ArrayList插入10w条数据?优化?

LinkedList

- LinkedList

1 类

// 类public class LinkedList<E>extends AbstractSequentialList<E>implements List<E>, Deque<E>, Cloneable, java.io.Serializable{transient int size = 0;transient Node<E> first;transient Node<E> last;....// Node节点private static class Node<E> {E item;Node<E> next;Node<E> prev;Node(Node<E> prev, E element, Node<E> next) {this.item = element;this.next = next;this.prev = prev;}}

- 特点:

链表实现,有序且可重复

继承于AbstractSequentialList的双向链表 - Deque接口

-ArrayList多实现一个接口,双向队列

-栈、队列或双端队列

-队列:Queue queue = new LinkedList<>();

-双端队列:Deque deque = new LinkedList<>(); - 数据结构

双向链表:删除时不需要遍历就可以找到前后元素 - 内存分配

数组:确定大小,分配内存

链表:无确定大小,通过指针的移动指向下一个内存地址的分配 - 添加元素

添加元素,改变元素上下指针引用,无需扩容

modCount++ - 依次删除

-删除同时 下标会变 删错

-增删modCount++,抛出异常 - 迭代器遍历快

-游标记录当前访问元素的位置,遍历一个元素,记录一个位置。

HashMap->ConcurrentHashMap

1 HashMap实现原理

-- JDK1.6&1.7:位桶数组+链表

-- JDK1.8:位桶数组+链表+红黑树

遇到冲突时,HashMap是采用的链地址法/拉链法来解决;2 HashMap定义:

--散列表,存储键值对(key-value)映射,key和value都可为null

public class HashMap extends AbstractMap

implements Map, Cloneable, Serializable {

• Map接口,键值对映射通用的操作。

key有序,不重复;value无序,可重复

• 承抽象类 AbstractMap,可以不用实现所有的Map接口方法,选择性

• 继承了AbstractMap,实现了Map接口,是否多此一举?LinkedHashSet类似。3 字段属性

===初始化的数据值===

--serialVersionUID //序列化和反序列化 一致性

--DEFAULT_INITIAL_CAPACITY=1<<4; //默认集合初始容量为16(必须是2的倍数)

--MAXIMUM_CAPACITY = 1 << 30; //最大容量,带参超过此数,默认使用此数

--DEFAULT_LOAD_FACTOR = 0.75f; //默认的填充因子

==下三个是JDK1.8新增,进行红黑树和链表互相转换==

--TREEIFY_THRESHOLD = 8; //当桶(bucket)上的结点数大于8转成红黑树

--UNTREEIFY_THRESHOLD = 6; //桶(bucket)上节点数小于6转链表

--MIN_TREEIFY_CAPACITY = 64; //集合中的容量大于这个值时,桶才能进行树形化,否则桶内元素太多时会扩容,而不是树形化,为了避免进行扩容、树形化选择的冲突,这个值不能小于4*TREEIFY_THRESHOLD

===初始化结构和属性===

--Node[] table; //初始化长度默认是DEFAULT_INITIAL_CAPACITY= 16。长度总是 2的幂

--Set> entrySet; //保存缓存的entrySet()

--size; //集合中存放key-value 的实时数量

--modCount; //记录集合被修改的次数,用于迭代器中的快速失败

--threshold; //调整大小的下一个大小值(容量*加载因子)。capacity*loadFactor。capacity是桶的数量,即table的长度length。当前已占用数组长度的最大值。超过这个数目就重新resize(扩容),扩容后的HashMap容量是之前容量的两倍。

--loadFactor; //加载因子,用来衡量HashMap满的程度;实时装载因子的计算:size/capacity,loadFactor为什么默认的负载因子0.75

--泊松分布(tips:有点关系)|0.75

--默认负载因子(0.75)在时间和空间成本上提供了很好的折衷。较高的值会降低空间开销,但提高查找成本(体现在大多数的HashMap类的操作,包括get和put)。设置初始大小时,应该考虑预计的entry数在map及其负载系数,并且尽量减少rehash操作的次数。如果初始容量大于最大条目数除以负载因子,rehash操作将不会发生。

--为1:当负载因子是1.0时,也就意味着,只有当数组的值全部填充了,才会发生扩容。这就带来了很大的问题,因为Hash冲突时避免不了的。

后果:当负载因子是1.0的时候,意味着会出现大量的Hash的冲突,底层的红黑树变得异常复杂。对于查询效率极其不利。这种情况就是牺牲了时间来保证空间的利用率。

因此一句话总结就是负载因子过大,虽然空间利用率上去了,但是时间效率降低了。

--为0.5

后果:负载因子是0.5的时候,这也就意味着,当数组中的元素达到了一半就开始扩容,既然填充的元素少了,Hash冲突也会减少,那么底层的链表长度或者是红黑树的高度就会降低。查询效率就会增加。

但是,此时空间利用率就会大大的降低,原本存储1M的数据,现在就意味着需要2M的空间。

总之,就是负载因子太小,虽然时间效率提升了,但是空间利用率降低了。

--选择0.75作为默认的加载因子,完全是时间和空间成本上寻求的一种折衷选择。

--负载因子是0.75的时,空间利用率比较高,而且避免了相当多的Hash冲突,使得底层的链表或者是红黑树的高度比较低,提升了空间效率。4 构造函数

容量_ab

① 默认无参构造函数

无参构造器,初始化散列表的加载因子为0.75

this.loadFactor = DEFAULT_LOAD_FACTOR;

② 指定初始容量的构造函数

public HashMap(int initialCapacity, float loadFactor) {

->判断初始化容量initialCapacity,<0,异常,>max,赋值max

->判断加载因子,<0,或非数值,异常

->赋值:

this.loadFactor = loadFactor;

this.threshold = tableSizeFor(initialCapacity);

--tableSizeFor(cap)方法:

{

int n = cap - 1;

n |= n >>> 1;

n |= n >>> 2;

n |= n >>> 4;

n |= n >>> 8;

n |= n >>> 16;

return (n < 0) ? 1 : (n >= MAXIMUM_CAPACITY) ? MAXIMUM_CAPACITY : n + 1;

}

---这块右移的目的:对于一个数字的二进制,从第一个不为0的位开始,把后面的所有位都设置成1。

---几次无符号右移和按位或运算,把1100 1100 1100转换成了1111 1111 1111 ,再把1111 1111 1111加1,就得到了1 0000 0000 0000,这就是大于1100 1100 1100的第一个2的幂。

//返回大于等于initialCapacity的最小的二次幂数值。>>>操作符表示无符号右移,高位取0。|按位或运算5 hash算法

HashMap中的hash函数?Hash算法(扰动函数) |3

--散列函数|散列表:

哈希表通过把关键码值映射到表中一个位置来访问记录,以加快查找的速度。这个映射函数叫做散列函数,存放记录的数组叫做散列表。

散列函数的存在能够帮助我们更快的确定key和value的映射关系

--HashMap中的哈希算法:确定哈希桶数组索引位置

--三步:

①取hashCode值:key.hashCode()

②高位参与运算:h>>>16

③取模运算:(n-1)&hashstatic final int hash(Object key) {int h;return (key == null) ? 0 : (h = key.hashCode()) ^ (h >>> 16);}// 使用:这一步是在后面添加元素putVal()方法中进行位置的确定i = (table.length - 1) & hash(key);

--散列函数设计的越好,使得元素分布的越均匀。

hashmap容量为什么是2的幂次

-get()中,(table.length -1)&hash计算出key在table索引位置

-length是2的n次方时,(length-1)&hash等价于length取模,即hash%length,但是&比%具有更高的效率。比如 n % 32 =(32 -1)&n

--为什么?

n-1的二进制永远都是尾端以连续1的形式表示,当(n - 1) & hash会保留hash中后 x 位的 1

0&0 0&1 都为0

1&0 1&1 分布更均匀,减少碰撞几率,加快了查询的效率,空间浪费少。

1|26 put

//hash(key)就是上面讲的hash方法,对其进行了第一步和第二步处理public V put(K key, V value) {return putVal(hash(key), key, value, false, true);}/**** @param hash 索引的位置* @param key 键* @param value 值* @param onlyIfAbsent true 表示不要更改现有值* @param evict false表示table处于创建模式* @return*/final V putVal(int hash, K key, V value, boolean onlyIfAbsent,boolean evict) {Node<K,V>[] tab; Node<K,V> p; int n, i;//如果table为null或者长度为0,则进行初始化//resize()方法本来是用于扩容,由于初始化没有实际分配空间,这里用该方法进行空间分配,后面会详细讲解该方法if ((tab = table) == null || (n = tab.length) == 0)n = (tab = resize()).length;//注意:这里用到了前面讲解获得key的hash码的第三步,取模运算,下面的if-else分别是 tab[i] 为null和不为nullif ((p = tab[i = (n - 1) & hash]) == null)tab[i] = newNode(hash, key, value, null);//tab[i] 为null,直接将新的key-value插入到计算的索引i位置else {//tab[i] 不为null,表示该位置已经有值了Node<K,V> e; K k;if (p.hash == hash &&((k = p.key) == key || (key != null && key.equals(k))))e = p;//节点key已经有值了,直接用新值覆盖//该链是红黑树else if (p instanceof TreeNode)e = ((TreeNode<K,V>)p).putTreeVal(this, tab, hash, key, value);//该链是链表else {for (int binCount = 0; ; ++binCount) {if ((e = p.next) == null) {p.next = newNode(hash, key, value, null);//链表长度大于8,转换成红黑树if (binCount >= TREEIFY_THRESHOLD - 1) // -1 for 1sttreeifyBin(tab, hash);break;}//key已经存在直接覆盖valueif (e.hash == hash &&((k = e.key) == key || (key != null && key.equals(k))))break;p = e;}}if (e != null) { // existing mapping for keyV oldValue = e.value;if (!onlyIfAbsent || oldValue == null)e.value = value;afterNodeAccess(e);return oldValue;}}++modCount;//用作修改和新增快速失败if (++size > threshold)//超过最大容量,进行扩容resize();afterNodeInsertion(evict);return null;}

图示

put过程图

-为什么在1.8中链表大于8时会转红黑树?

因为泊松分布,拉链法哈希冲突累积到七个元素后,通过泊松分布计算得到第8个冲突元素出现的概率极低,几乎不可能出现,但只要出现了就树形化提高查询效率(前提是数组长度已经到了64,否则先扩容)

-为什么要用红黑树?而不用平衡二叉树? |2

--Java8之前,链表解决冲突的,产生碰撞,进行get时,两步的时间复杂度是O(1)+O(n)。因此,当碰撞很厉害的时候n很大,O(n)的速度显然是影响速度的。

--Java8中,红黑树替换链表,复杂度就变成了O(1)+O(logn)了,这样在n很大的时候,能够比较理想的解决这个问题

-如果两个键的hashcode相同,你如何获取值对象?

找到bucket位置之后,会调用keys.equals()方法去找到链表中正确的节点,最终找到要找的值对象。

-size:hashMap怎么获取有几个元素,底层实现public int size() {return size;}// 计算if (++size > threshold)//超过最大容量,进行扩容 -58resize(); -59

数组上有5个,某链表上3个,size是多大?

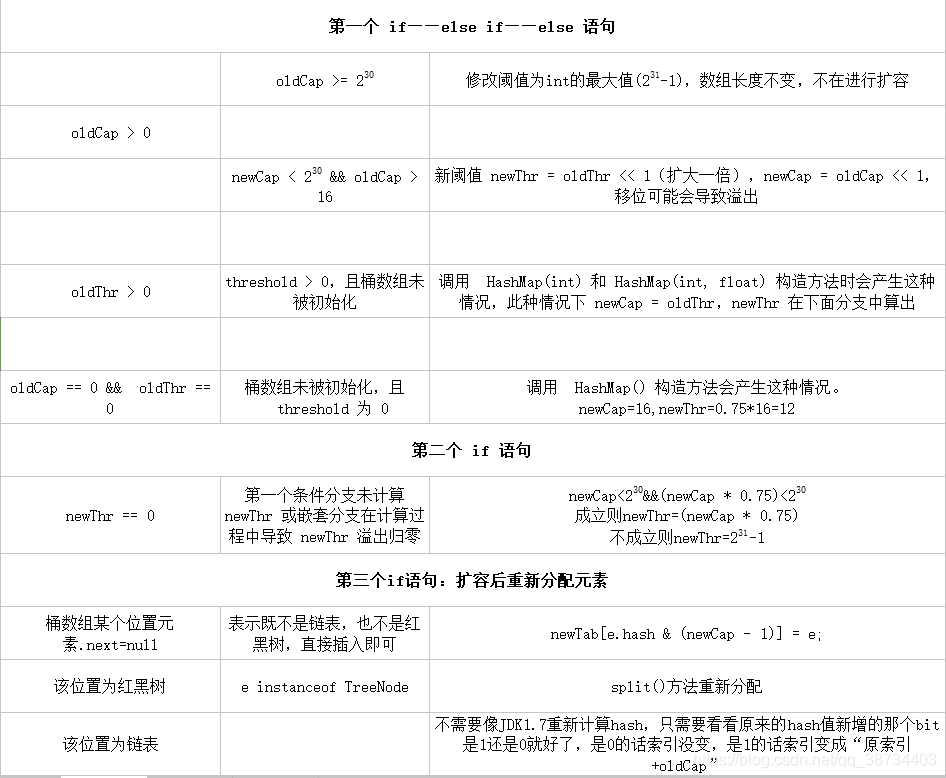

分析第58,59 行代码,调用put()方法添加元素,就会++size(这里有个例外是插入重复key的键值对,不会调用,但是重复key元素不会影响size),所以,上面是 7。7 resize

- 扩容机制

先介绍 JDK1.7的扩容源码,便于理解,然后在介绍JDK1.8的源码。

//参数 newCapacity 为新数组的大小void resize(int newCapacity) {Entry[] oldTable = table;//引用扩容前的 Entry 数组int oldCapacity = oldTable.length;if (oldCapacity == MAXIMUM_CAPACITY) {//扩容前的数组大小如果已经达到最大(2^30)了threshold = Integer.MAX_VALUE;///修改阈值为int的最大值(2^31-1),这样以后就不会扩容了return;}Entry[] newTable = new Entry[newCapacity];//初始化一个新的Entry数组transfer(newTable, initHashSeedAsNeeded(newCapacity));//将数组元素转移到新数组里面table = newTable;threshold = (int)Math.min(newCapacity * loadFactor, MAXIMUM_CAPACITY + 1);//修改阈值}void transfer(Entry[] newTable, boolean rehash) {int newCapacity = newTable.length;for (Entry<K,V> e : table) {//遍历数组while(null != e) {Entry<K,V> next = e.next;if (rehash) {e.hash = null == e.key ? 0 : hash(e.key);}int i = indexFor(e.hash, newCapacity);//重新计算每个元素在数组中的索引位置e.next = newTable[i];//标记下一个元素,添加是链表头添加newTable[i] = e;//将元素放在链上e = next;//访问下一个 Entry 链上的元素}}}

- 扩容机制

- JDK1.7中首先是创建一个新的大容量数组,然后依次重新计算原集合所有元素的索引,然后重新赋值。如果数组某个位置发生了hash冲突,使用的是单链表的头插入方法,同一位置的新元素总是放在链表的头部,这样与原集合链表对比,扩容之后的可能就是倒序的链表了。

1.8源码

final Node<K,V>[] resize() {Node<K,V>[] oldTab = table;int oldCap = (oldTab == null) ? 0 : oldTab.length;//原数组如果为null,则长度赋值0int oldThr = threshold;int newCap, newThr = 0;if (oldCap > 0) {//如果原数组长度大于0// 超过最大值就不再扩充了,就只好随你碰撞去吧if (oldCap >= MAXIMUM_CAPACITY) {//数组大小如果已经大于等于最大值(2^30)threshold = Integer.MAX_VALUE;//修改阈值为int的最大值(2^31-1),这样以后就不会扩容了return oldTab;}//原数组长度大于等于初始化长度16,并且原数组长度扩大1倍也小于2^30次方// 没超过最大值,就扩充为原来的2倍else if ((newCap = oldCap << 1) < MAXIMUM_CAPACITY &&oldCap >= DEFAULT_INITIAL_CAPACITY)newThr = oldThr << 1; // 阀值扩大2倍}else if (oldThr > 0) //旧阀值大于0,则将新容量直接等于就阀值newCap = oldThr;else {//阀值等于0,oldCap也等于0(集合未进行初始化)newCap = DEFAULT_INITIAL_CAPACITY;//数组长度初始化为16newThr = (int)(DEFAULT_LOAD_FACTOR * DEFAULT_INITIAL_CAPACITY);//阀值等于16*0.75=12}//计算新的阀值上限if (newThr == 0) {float ft = (float)newCap * loadFactor;newThr = (newCap < MAXIMUM_CAPACITY && ft < (float)MAXIMUM_CAPACITY ?(int)ft : Integer.MAX_VALUE);}threshold = newThr;@SuppressWarnings({"rawtypes","unchecked"})Node<K,V>[] newTab = (Node<K,V>[])new Node[newCap];table = newTab;if (oldTab != null) {//把每个bucket都移动到新的buckets中for (int j = 0; j < oldCap; ++j) {Node<K,V> e;if ((e = oldTab[j]) != null) {oldTab[j] = null;//元数据j位置置为null,便于垃圾回收if (e.next == null)//数组没有下一个引用(不是链表)newTab[e.hash & (newCap - 1)] = e;else if (e instanceof TreeNode)//红黑树((TreeNode<K,V>)e).split(this, newTab, j, oldCap);else { // preserve orderNode<K,V> loHead = null, loTail = null;Node<K,V> hiHead = null, hiTail = null;Node<K,V> next;do {next = e.next;//原索引if ((e.hash & oldCap) == 0) { //★if (loTail == null)loHead = e;elseloTail.next = e;loTail = e;}//原索引+oldCapelse {if (hiTail == null)hiHead = e;elsehiTail.next = e;hiTail = e;}} while ((e = next) != null);//原索引放到bucket里if (loTail != null) {loTail.next = null;newTab[j] = loHead;}//原索引+oldCap放到bucket里if (hiTail != null) {hiTail.next = null;newTab[j + oldCap] = hiHead;}}}}}return newTab;}

相比于JDK1.7,1.8使用的是2次幂的扩展(指长度扩为原来2倍),所以,元素的位置要么是在原位置,要么是在原位置再移动2次幂的位置。我们在扩充HashMap的时候,不需要像JDK1.7的实现那样重新计算hash,只需要看看原来的hash值新增的那个bit是1还是0就好了,是0的话索引没变,是1的话索引变成“原索引+oldCap”

8 线程安全

|线程不安全_ab|

** HashMap线程安全吗?为什么不安全?不安全怎么办? |3**

-线程不安全的,其主要体现:

1)在jdk1.7中,在多线程环境下,扩容时会造成死循环(环形链)或数据丢失。-头插

2)在jdk1.8中,在多线程环境下,会发生数据覆盖的情况。-尾插

-过程分析:线程不安全

分析过程结合阅读9 remove

-删除元素

首先,找到桶的位置,如果是链表,则进行链表遍历,找到需要删除的元素后,进行删除;如果是红黑树,也是进行树的遍历,找到元素删除后,进行平衡调节,

注意:红黑树的节点数小于 6 时,会转化成链表。

-遍历删除:

当遍历Map需要删除的时候,不可以for循环遍历,否则会产生并发修改异常CME,只能使用迭代器iterator.remove()来删除元素,或者使用线程安全的concurrentHashMap来删除Map中删除元素(concurrentHashMap和迭代器Iterator遍历删除)10 get

- 查找元素

①、通过 key 查找 value

首先通过 key 找到计算索引,找到桶位置,先检查第一个节点,如果是则返回,如果不是,则遍历其后面的链表或者红黑树。其余情况全部返回 null。

public V get(Object key) {Node<K,V> e;return (e = getNode(hash(key), key)) == null ? null : e.value;}final Node<K,V> getNode(int hash, Object key) {Node<K,V>[] tab; Node<K,V> first, e; int n; K k;if ((tab = table) != null && (n = tab.length) > 0 &&(first = tab[(n - 1) & hash]) != null) {//根据key计算的索引检查第一个索引if (first.hash == hash && // always check first node((k = first.key) == key || (key != null && key.equals(k))))return first;//不是第一个节点if ((e = first.next) != null) {if (first instanceof TreeNode)//遍历树查找元素return ((TreeNode<K,V>)first).getTreeNode(hash, key);do {//遍历链表查找元素if (e.hash == hash &&((k = e.key) == key || (key != null && key.equals(k))))return e;} while ((e = e.next) != null);}}return null;}

②、判断是否存在给定的 key 或者 value

public boolean containsKey(Object key) {return getNode(hash(key), key) != null;}public boolean containsValue(Object value) {Node<K,V>[] tab; V v;if ((tab = table) != null && size > 0) {//遍历桶for (int i = 0; i < tab.length; ++i) {//遍历桶中的每个节点元素for (Node<K,V> e = tab[i]; e != null; e = e.next) {if ((v = e.value) == value ||(value != null && value.equals(v)))return true;}}}return false;}

-HashMap没有直接提供getNode接口给用户调用,而提供的get函数,而get函数就是通过getNode来取得元素的。

- 查找元素

get(key)方法时获取key的hash值,计算hash&(n-1)得到在链表数组中的位置first=tab[hash&(n-1)],先判断first的key是否与参数key相等,不等就遍历后面的链表找到相同的key值返回对应的Value值即可

11 遍历

- equals()和hashCode()的都有什么作用?-

通过对key的hashCode()进行hashing,并计算下标( n-1 & hash),从而获得buckets的位置。如果产生碰撞,则利用key.equals()方法去链表或树中去查找对应的节点

- equals()和hashCode()的都有什么作用?-

12 1.7 1.8区别

- hashMap1.8有什么改动

HashTable

- 1 HashMap与HashTable区别

HashMap

-- 线程不安全;

-- 是一个接口,是 Map的一个子接口,

-- 是将键映射到值得对象,不允许键值重复,允许空键和空值;

-- 非线程安全, HashMap的效率要较 HashTable 的效率高一些.

HashTable

-- 线程安全的集合;

-- 不允许 null 值作为一个 key 值或者 Value 值;

*HashTable 是 sychronize(同步化),多个线程访问时不需要自己为它的方法实现同步,而HashMap在被多个线程访问的时候需要自己为它的方法实现同步;

区别 :

(1)HashMap方法没有synchronized修饰,线程非安全,HashTable线程安全;

(2)HashMap允许key和value为null,而HashTable不允许

2.底层实现:数组+链表实现

jdk8开始链表高度到8、数组长度超过64,链表转变为红黑树,元素以内部类Node节点存在计算key的hash值,二次hash然后对数组长度取模,对应到数组下标,如果没有产生hash冲突(下标位置没有元素),则直接创建Node存入数组,如果产生hash冲突,先进行equal比较,相同则取代该元素,不同,则判断链表高度插入链表,链表高度达到8,并且数组长度到64则转变为红黑树,长度低于6则将红黑树转回链表key为null,存在下标0的位置

数组扩容

HashSet

- |源码解析|

- 1 字段属性

--HashMap map; //HashSet集合中的内容是通过 HashMap 数据结构来存储的

--Object PRESENT = new Object();//向HashSet中添加数据,数据在上面的 map 结构是作为 key 存在的,而value统一都是 PRESENT - 2 add

public boolean add(E e) {return map.put(e, PRESENT)==null;} - 重复set

往set里面put一个学生对象,然后将这个学生对象的学号改了,再put进去,可以放进set么?并讲出为什么

不可以放进,hashcode不变

https://www.cnblogs.com/Spades7/p/8206671.html - 线程不安全

- hashset为什么不是线程安全的,描述场景

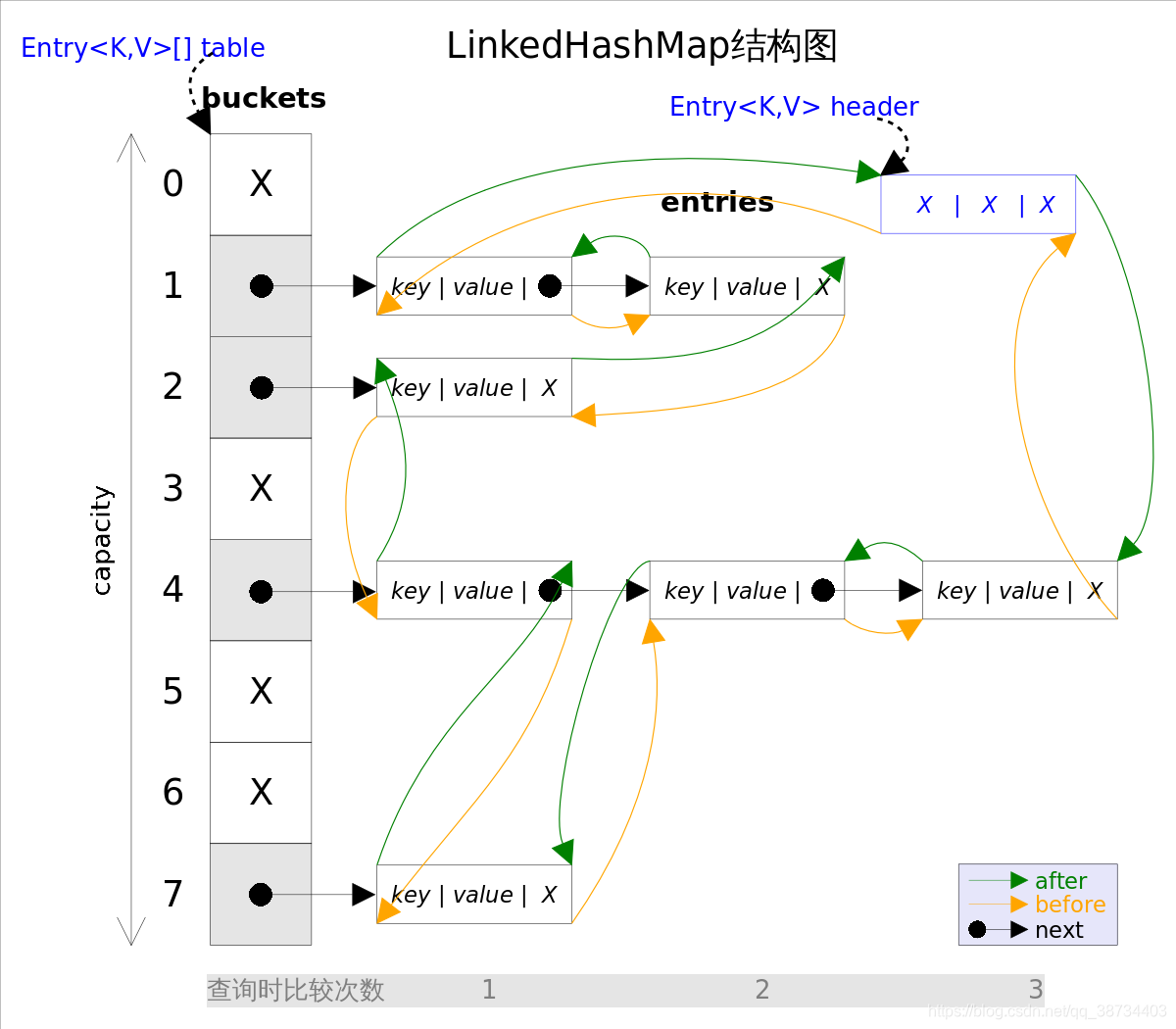

LinkedHashMap

-

public class LinkedHashMap<K,V>extends HashMap<K,V>implements Map<K,V>

- 有序

在HashMap基础上单独维护了一个具有所有数据的双向链表,链表保证了元素迭代的顺序。 - 应用

- 1 基本用法

--LinkedHashMap是HashMap的子类,但是内部还有一个双向链表维护键值对的顺序,每个键值对既位于哈希表中,也位于双向链表中。LinkedHashMap支持两种顺序插入顺序 、 访问顺序

① 插入顺序:先添加的在前面,后添加的在后面。修改操作不影响顺序

② 访问顺序:所谓访问指的是get/put操作,对一个键执行get/put操作后,其对应的键值对会移动到链表末尾,所以最末尾的是最近访问的,最开始的是最久没有被访问的,这就是访问顺序。

2 实现访问顺序排序

LinkedHashMap有5个构造方法,其中4个都是按插入顺序,只有一个是可以指定按访问顺序:public LinkedHashMap(int initialCapacity, float loadFactor, boolean accessOrder)

其中参数accessOrder就是用来指定是否按访问顺序,如果为true,就是访问顺序。

3 使用按访问有序实现缓存

在LinkedHashMap添加元素后,会调用removeEldestEntry防范,传递的参数时最久没有被访问的键值对,如果方法返回true,这个最久的键值对就会被删除。LinkedHashMap中的实现总返回false,该子类重写后即可实现对容量的控制public class LRUCache<K, V> extends LinkedHashMap<K, V> {private int maxEntries;public LRUCache(int maxEntries) {super(16, 0.75f, true);this.maxEntries = maxEntries;}@Overrideprotected boolean removeEldestEntry(Map.Entry<K, V> eldest) {return size() > maxEntries;}}

使用该缓存:

LRUCache<String,Object> cache = new LRUCache<>(3);cache.put("a","abstract");cache.put("b","basic");cache.put("c","call");cache.get("a");cache.put("d","滴滴滴");System.out.println(cache); // 输出为:{c=call, a=abstract, d=滴滴滴}

LinkedHashSet

-

public class LinkedHashSet<E>extends HashSet<E>implements Set<E>, Cloneable, java.io.Serializable {

- 有序且不能重复

- 底层是通过LinkedHashMap来实现的

public boolean add(E e) {

return map.put(e, PRESENT)==null;

}

通过 map.put() 方法来添加元素,说明了该方法如果新插入的key不存在,则返回null,如果新插入的key存在,则返回原key对应的value值(注意新插入的value会覆盖原value值)。

也就是说 add(E e) 方法,会将 e 作为 key,PRESENT 作为 value 插入到 map 集合中,如果 e 不存在,则插入成功返回 true;如果存在,则返回false。

TreeMap

- 1.8TreeMap源码|

- 红黑树实现的有序的 key-value 集合

- TreeMap按key|value排序

类

public class TreeMap<K,V>extends AbstractMap<K,V>implements NavigableMap<K,V>, Cloneable, java.io.Serializable

TreeSet

collections

- Arrays工具类怎么用?

- collections有哪些?

2-concurrent

线程、进程、程序

- os_JG|

- 1 概念

1)程序:

程序是计算机的一组指令,经过编译和执行才能最终完成程序设计的动作。

2)进程:一段程序的执行过程。

一个可执行的、具有独立功能的程序关于某个数据集合的一次执行过程,也是操作系统进行资源分配和调度的基本单位。

3)线程:程序执行的最小单元。

是操作系统能够进行运算调度的最小单位,被包含在进程之中,是进程中的实际运作单位。一条线程指的是进程中一个单一顺序的控制流,一个进程中可以并发多个线程,每条线程并行执行不同的任务 - 2 区别和关联

--关联:

一个进程中可以有多个线程,多个线程共享进程的堆和方法区(JDK1.8之后的元空间)资源,但是每个线程有自己的程序计数器、虚拟机栈 和 本地方法栈。

--区别:

线程和进程最大的不同在于基本上各进程是独立的,而各线程则不一定,因为同一进程中的线程极有可能会相互影响。线程执行开销小,但不利于资源的管理和保护;而进程正相反。 - 3 程序如何运行:

程序(源文件)在硬盘上,需要把程序加载进内存,然后由CPU去执行相应的指令去操作寄存器中的数据(从内存中装载进来),比如加减乘除什么的。

--写->硬盘;运行->内存;指令操作->cpu寄存器 4 进程间的通讯(IPC)

--共享内存是最快的IPC方式

--进程间通信(Java和os有区别):

① 消息队列(MessageQueue)

② 共享内存(SharedMemory) :实现

③ 信号量(Semphore)

④ 套接字(Socket)

⑤ 管道(PIPE)

⑥ 命名管道(FIFO)线程进程(协程)区别? |3 结合具体的操作系统windows/mac/linux?

- jg:从JVM的角度来说一下线程和进程之间的关系

缓存一致性

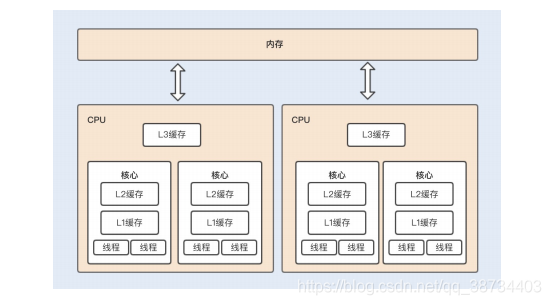

- 缓存的工作原理:

是当CPU要读取一个数据时,首先从缓存中查找,如果找到就立即读取并送给CPU处理;如果没有找到,就用相对慢的速度从内存中读取并送给CPU处理,同时把这个数据所在的数据块调入缓存中,可以使得以后对整块数据的读取都从缓存中进行,不必再调用内存。

--CPU缓存:是为了缓解CPU和内存之间速度的不匹配问题。

--这大大节省了CPU直接读取内存的时间,也使CPU读取数据时基本无需等待。总的来说,CPU读取数据的顺序是先缓存后内存。 CPU内存模型

--CPU缓存可以分为一级缓存(L1)、二级缓存(L2)和三级缓存(L3),每一级缓存中所储存的全部数据都是下一级缓存的一部分。当CPU要读取一个缓存数据时,首先会从一级缓存中查找;如果没有找到,再从二级缓存中查找;如果还是没有找到,就从三级缓存或内存中查找。

--单核CPU:

如果是单核CPU运行多线程,多个线程同时访问进程中的共享数据,CPU 将共享变量加载到高速缓存后,不同线程在访问缓存数据的时候,都会映射到相同的缓存位置,这样即使发生线程的切换,缓存仍然不会失效。

--多核CPU:

如果是多核CPU运行多线程,每个核都有一个L1缓存,如果多个线程运行在不同的内核上访问共享变量时,每个内核的 L1 缓存将会缓存一份共享变量。

缓存一致性协议

MESI是四种缓存段状态的首字母缩写,任何多核系统中的缓存段都处于这四种状态之一。我将以相反的顺序逐个讲解,因为这个顺序更合理:

失效(Invalid)缓存段,要么已经不在缓存中,要么它的内容已经过时。为了达到缓存的目的,这种状态的段将会被忽略。一旦缓存段被标记为失效,那效果就等同于它从来没被加载到缓存中。

共享(Shared)缓存段,它是和主内存内容保持一致的一份拷贝,在这种状态下的缓存段只能被读取,不能被写入。多组缓存可以同时拥有针对同一内存地址的共享缓存段,这就是名称的由来。

独占(Exclusive)缓存段,和S状态一样,也是和主内存内容保持一致的一份拷贝。区别在于,如果一个处理器持有了某个E状态的缓存段,那其他处理器就不能同时持有它,所以叫“独占”。这意味着,如果其他处理器原本也持有同一缓存段,那么它会马上变成“失效”状态。

已修改(Modified)缓存段,属于脏段,它们已经被所属的处理器修改了。如果一个段处于已修改状态,那么它在其他处理器缓存中的拷贝马上会变成失效状态,这个规律和E状态一样。此外,已修改缓存段如果被丢弃或标记为失效,那么先要把它的内容回写到内存中——这和回写模式下常规的脏段处理方式一样。一些问题:(多线程环境下尤其)

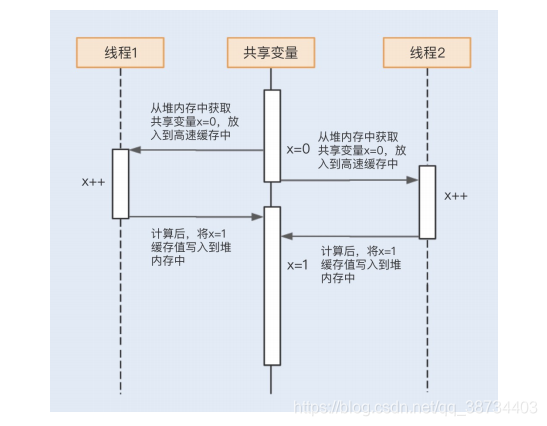

缓存一致性问题: 当多个处理器的运算任务都涉及同一块主内存区域时,将可能导致各自的缓存数据不一致的情况,如果真的发生这种情况,需要各个处理器访问缓存时都遵循一些协议,在读写时要根据协议来进行操作,这类协议有MSI、MESI等。

指令重排序问题: 为了使得处理器内部的运算单元能尽量被充分利用,处理器可能会对输入代码进行乱序执行(Out-Of-Order Execution)优化,处理器会在计算之后将乱序执行的结果重组,保证该结果与顺序执行的结果是一致的,但并不保证程序中各个语句计算的先后顺序与输入代码中的顺序一致。- CPU上的缓存是用来临时存储cpu和内存交换的数据的,硬盘上的缓存用来临时存储硬盘和内存交换的数据的。

缓存一致性问题?

问题:

假设有两个线程(线程1和线程2)分别执行下面的方法,x是共享变量:public class Example {int x = 0;public void count() {x++; //1System.out.println(x)//2}}

多核CPU:如果是多核CPU运行多线程,每个核都有一个L1缓存,如果多个线程运行在不同的内核上访问共享变量时,每个内核的L1缓存将会缓存一份共享变量。

1,1 的运行结果:

- 缓存一致性协议,CPU-Cache角度?

--解决缓存不一致问题

--是一种广泛使用的支持写回策略的缓存一致性协议,该协议被应用在Intel奔腾系列的CPU中;

-- MESI分别代表缓存行数据所处的四种状态,通过对这四种状态的切换,来达到对缓存数据进行管理的目的。 - 什么是强一致性?

结合Happens-before规则,可以将一致性分为以下几个级别:

严格一致性(强一致性):所有的读写操作都按照全局时钟下的顺序执行,且任何时刻线程读取到的缓存数据都是一样的,Hashtable 就是严格一致性;

顺序一致性:多个线程的整体执行可能是无序的,但对于单个线程而言执行是有序的,要保证任何一次读都能读到最近一次写入的数据,volatile可以阻止指令重排序,所以修饰的变量的程序属于顺序一致性;

弱一致性:不能保证任何一次读都能读到最近一次写入的数据,但能保证最终可以读到写入的数据,单个写锁+无锁读,就是弱一致性的一种实现。

并发安全、活跃、性能问题?

- ans:安全、活跃、性能

- 1-安全性:

-- 问题:会出现原子性问题、可见性问题和有序性问题线程不安全问题。

-- 有多个线程会同时读写同一数据,需要一一考虑原子性问题、可见性问题和有序性问题

-- 数据竞争:当多个线程同时访问同一数据,并且至少有一个线程会写这个数据的时候,如果我们不采取防护措施,那么就会导致并发Bug

-- 竞态条件:指的是程序的执行结果依赖线程执行的顺序

-- 解决:锁 - 2-活跃性:

-- 概念:指的是某个操作无法执行下去。

-- 活跃性问题:死锁、活锁、饥饿

① 死锁:发生“死锁”后,线程会互相等待,而且会一直等待下去,技术上表现形式是线程永久地“阻塞”了。

② 活锁:线程没发生阻塞,但仍存在执行不下去的情况。

解决:尝试等待等待一个随机时间

③ 饥饿:指的是线程因无法访问所需资源而无法执行下去的情况。

三种解决方案:

一是保证资源充足,二是公平地分配资源,三就是避免持有锁的线程长时间执行。

-- 一、三的适用场景比较有限,因为很多场景下,资源的稀缺无法解决的,持有锁的线程执行的时间也很难缩短。

-- 公平地分配资源

并发编程里,主要使用公平锁,一种先来后到的方案,线程的等待是有顺序的,排在等待队列前面的线程会优先获得资源。 - 3-性能问题

-- 衡量标准:吞吐量、延迟和并发量

-- 尽量减少串行

-- 避免锁带来的性能问题

线程安全

- 线程不安全:

1)《深入理解Java虚拟机》原文:

当多个线程访问同一个对象时,如果不用考虑这些线程在运行时环境下的调度和交替运行,也不需要进行额外的同步,或者在调用方进行任何其他的协调操作,调用这个对象的行为都可以获取正确的结果,那这个对象是线程安全的。

2)线程安全的问题原因

一般是主内存和工作内存数据不一致性、重排序导致。

3)例子

① 数据不一致

在i++一组指令执行过程中,cpu是有可能切换线程的,如果在当前线程t1被挂起之后其他线程修改了这个对象的a属性值,那么恢复线程执行时t1线程将会覆盖其他线程已经修改过的值。

https://blog.csdn.net/yongjie910203/article/details/79763382

② 指令重排 - java线程安全都体现在哪些方面

- ans:原子性、可见性、有序性

- 原子性:提供互斥访问,同一时刻只能有一个线程对数据进行操作,(atomic,synchronized);

- 可见性:一个线程对主内存的修改可以及时地被其他线程看到,(synchronized,volatile);

- 有序性:一个线程观察其他线程中的指令执行顺序,由于指令重排序,该观察结果一般杂乱无序,(happens-before原则)。

- java线程间通信? |2

- 线程间通信的模型有两种:共享内存和消息传递

- 共享内存:volatile 关键字、synchronized关键字同步、JUC工具类 CountDownLatch

- 消息传递:Object类的wait() 和 notify() 方法

待完善:https://aalion.github.io/2019/12/28/concurrency11/

https://blog.csdn.net/jisuanji12306/article/details/86363390

https://www.cnblogs.com/lgyxrk/p/10404839.html

- 说说java保证线程间同步的方法 | 2

使用同步方法 public synchronized void save(){}

使用同步代码块synchronized(object){}

使用特殊域变量(volatile)实现线程同步

使用重入锁ReetrantLock实现线程同步

使用局部变量实现线程同步 ThreadLocal

使用阻塞队列实现线程同步 LinkedBlockingQueue

使用原子变量实现线程同步AtomicInteger

线程间的同步的方式有哪些呢?

🙋 :线程同步是两个或多个共享关键资源的线程的并发执行。应该同步线程以避免关键的资源使用冲突。操作系统一般有下面三种线程同步的方式:

互斥量(Mutex):采用互斥对象机制,只有拥有互斥对象的线程才有访问公共资源的权限。因为互斥对象只有一个,所以可以保证公共资源不会被多个线程同时访问。比如 Java 中的 synchronized 关键词和各种 Lock 都是这种机制。

信号量(Semphares) :它允许同一时刻多个线程访问同一资源,但是需要控制同一时刻访问此资源的最大线程数量

事件(Event) :Wait/Notify:通过通知操作的方式来保持多线程同步,还可以方便的实现多线程优先级的比较操

- 说说java保证线程间同步的方法 | 2

JMM和volatile

谈谈JMM(sxt2) 参考:volitile部分

1 JMM基本概念 -P39

1) 概念

Java内存模型(Java Memory Model,JMM)本身是一种抽象的概念,并不真实存在,它描述的是一组规则或规范,通过这组规范定义了程序中各个变量(包括实例字段,静态字段和构成数组对象的元素)的访问方式。

-Java线程间的通信采用的是共享Java内存模型(简称JMM),JMM决定一个线程对共享变量的写入何时对另一个线程可见.

-JMM的必要性:线程安全

2)JMM三大特性:为线程安全得到保证

① 可见性:主内存有更改,工作内存第一时间被通知改变

② 原子性:

③ 有序性

3)JMM关于同步的规定

1、线程解锁前,必须把共享变量的值刷新回主内存;

2、线程加锁前,必须读取主内存的最新值到自己的工作内存;

3、加锁解锁是同一把锁;

4)Java内存模型把内存分成了两部分:线程栈区和堆区

5)由于JVM运行程序的实体是线程,而每个线程创建时JVM都会为其创建一个工作内存(有些地方称为栈空间),工作内存是每个线程的私有数据区域,而Java内存模型中规定所有的变量都存储在主内存,主内存是共享内存区域,所有的线程都可以访问,但线程对变量的操作(读取赋值等)必须在工作内存中进行,首先要将变量从主内存拷贝到自己的工作内存空间,然后对变量进行操作,操作完成后在将变量写回主内存,不能直接操作主内存中的变量,各个线程的工作内存中存储着主内存中的变量副本拷贝,因此不同的线程间无法访问对方的工作内存,线程间的通信必须通过主内存来完成。

-注:存储 硬盘<内存(<缓存Cache) 主内存、线程自己的工作内存

6)cpu缓存:

why:cpu在内部cpu寄存器中处理数据,cpu缓存在主内存、寄存器之间,空间小,访问速度比主内存快的多。解决:cpu操作主内存同一地址数据,内存处理数据慢,需要等待,可以在cpu缓存存储一份直接获取。

流程:cpu访问主存时,先读取一部分主存数据到CPU缓存(当然如果CPU缓存中存在需要的数据就会直接从缓存获取),进而在读取CPU缓存到寄存器,当CPU需要写数据到主存时,同样会先刷新寄存器中的数据到CPU缓存,然后再把数据刷新到主内存中。

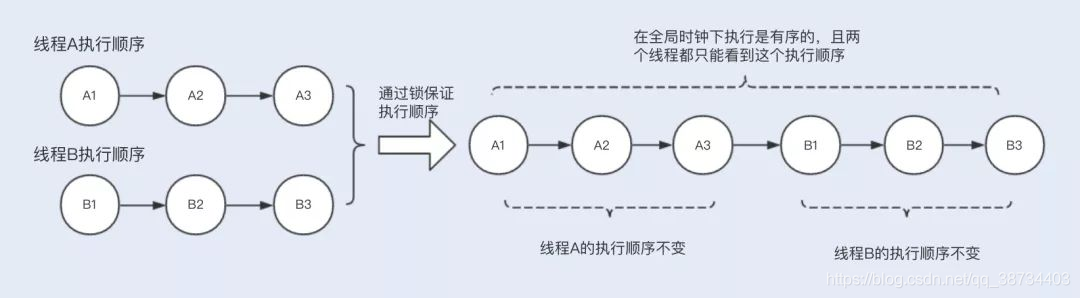

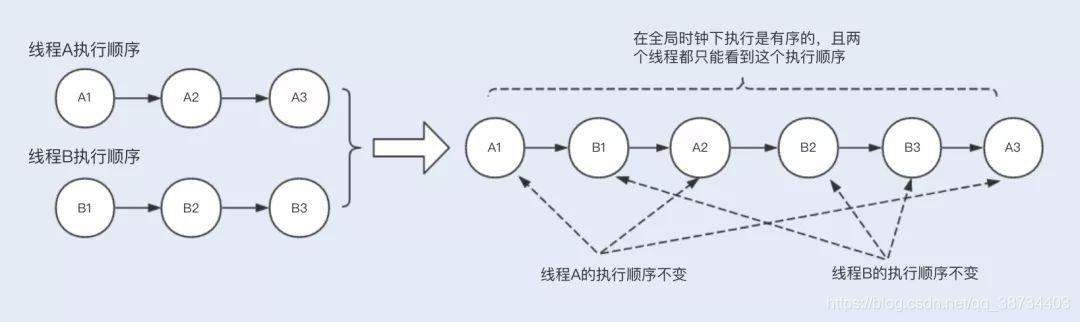

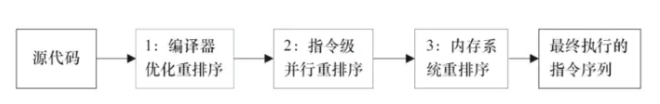

7)重排序类型以及可能带来的问题

编译器优化重排:不改变单线程语义下,语句执行顺序

指令并行重排:不存在数据依赖,机器指令执行顺序

内存系统重排:三级缓存,内存与缓存的数据同步存在时间差,加载(load)和存储(store)执行顺序

8)JMM解决方案:

①原子性:

JVM自身提供的对基本数据类型读写操作;

方法级别或者代码块级别--synchronized或重入锁(ReentrantLock)

②可见性:

synchronized或volatile

③指令重排导致的可见性和有序性:

volatile解决,其另外一个作用就是禁止重排序优化

④ happens-before:

JMM内部定义的happens-before原则保证多线程环境下两个操作间的原子性、可见性以及有序性。

9)happens-before原则:

①程序顺序原则

②锁规则 解锁(unlock)操作必然发生在后续的同一个锁的加锁(lock)之前。

③volatile规则 volatile变量的写,先发生于读,这保证了volatile变量的可见性。

④线程启动规则 线程的start()方法先于它的每一个动作,即如果线程A在执行线程B的start方法之前修改了共享变量的值,那么当线程B执行start方法时,线程A对共享变量的修改对线程B可见

⑤传递性 A先于B ,B先于C 那么A必然先于C

⑥线程终止规则 线程的所有操作先于线程的终结,Thread.join()等待当前执行的线程终止。

⑦线程中断规则

interrupt()的调用先行发生于被中断线程的代码检测到中断事件的发生,Thread.interrupted()检测线程是否中断。

⑧对象终结规则 对象的构造函数执行,结束先于finalize()方法2 说说volatile?(sxt2)

-volatile是Java提供的轻量级的同步机制(轻量级synchronized)

-三个特性:① 保证内存可见性 ② 不保证原子性 ③ 禁止指令重排序

(Volatile变量具有synchronized的可见性特性,但是不具备原子特性。防止指令重排。)Ⅰ 可见性

1.① 保证内存可见性(sxt2)volatile有什么特点,怎么保证可见性的

volatile可以保证可见性,及时通知其他线程,主物理内存的值已被修改。

1)可见性的保证是基于CPU的内存屏障指令,抽象为happens-before原则,确保一个线程的修改能对其他线程是可见的。

2)volatile保证了修饰的共享变量在转换为汇编语言时,会加上一个以lock为前缀的指令,当CPU发现这个指令时,立即会做两件事情:

① 将当前内核中线程工作内存中该共享变量刷新到主存;

② 通知其他内核里缓存的该共享变量内存地址无效;

3)happens-before

① 作用:指定两个操作之间的执行顺序。即:如果A线程的写操作a与B线程的读操作b之间存在happens-before关系,尽管a操作和b操作在不同的线程中执行,但JMM向程序员保证a操作将对b操作可见。

②示例:A happens-before B: A操作的结果将对B可见,且A的执行顺序排在B之前。

-线程修改了volatile变量,先写到工作内存还是主内存

volatile修饰的变量在被修改后会处理器直接将结果stroe和write进主内存,同时使得其他线程的工作内存缓存失效,实现可见性

https://www.sohu.com/a/399318783_120591934Ⅱ 非原子性

② 不保证原子性(sxt2)

1) 不保证原子性,会出现写丢失(写覆盖),线程太快

2)i++在多线程下是非线程安全的,如何不加synchronized解决?

volatile不保证原子性的原因?

例子:i++被拆分3个指令:(字节码)

Ⅰ 执行getfield拿到原始n;

Ⅱ 执行iadd进行加1;

Ⅲ 执行putfile写吧累加后的值写回

-写覆盖问题:拷贝回自己的内存空间,每个人都拿到0,写回到主内存时,线程1写回到的时候被挂起了,线程2歘的写回了。然后线程1恢复后又写回了一遍,把原来的1给覆盖了。

-解决:AtomicInteger 保证原子性

addAndget[++i]、getAndAdd[i++]

decrementAndGet、getAndDecrement【加1】

作用:

-volatile 的一个重要作用就是和CAS结合,保证了原子性,详细的可以参见 java.util.concurrent.atomic 包下的类,比如 AtomicInteger。

https://blog.csdn.net/weixin_40460171/article/details/106473323

多线程访问volatile long a变量?

--long存储的前32bit和后32bit可能不是同时更新

--volatile 除了保证可见性和有序性, 还解决了 long 类型和 double 类型数据的 8 字节赋值问题.

虚拟机规范中允许对 64 位数据类型, 分为 2 次 32 位的操作来处理, 当读取一个非 volatile 类型的 long 变量时,如果对该变量的读操作和写操作不在同一个线程中执行, 那么很有可能会读取到某个值得高 32 位和另一个值得低 32 位.

详细:Ⅲ 禁止指令重排

③ 禁止指令重排序(sxt2)

为了提高性能,编译器和处理器常常会对指令进行重排序。一般分为如下3种:

处理器在进行指令重排时,必须考虑指令之间的数据依赖(数据依赖不可重排)

--重排示例2:

多线程环境中线程交替执行,由于编译器优化重排的存在,两个线程中使用的变量能否保证一致性是无法确定的,结果无法预测。public class Test{int a = 0;boolean flag = flse;public void method1(){a = 1; // 这两个语句会发生编译器重排flag = true;}public void method2(){if(flag){a = a + 5;sout("retVale:" + a);}}}

volatile如何禁止指令重排(sxt2)

内存屏障

--volatile实现进制指令重排优化,从而避免多线程环境下程序出现乱序执行的现象。

--首先了解一个概念,内存屏障(Memory Barrier)又称内存栅栏,是一个CPU指令,它的作用有两个:

① 保证特定操作的顺序

② 保证某些变量的内存可见性(利用该特性实现volatile的内存可见性)

由于编译器和处理器都能执行指令重排的优化,如果在指令间插入一条Memory Barrier则会告诉编译器和CPU,不管什么指令都不能和这条Memory Barrier指令重排序,也就是说 通过插入内存屏障禁止在内存屏障前后的指令执行重排序优化。 内存屏障另外一个作用是刷新出各种CPU的缓存数,因此任何CPU上的线程都能读取到这些数据的最新版本。(注,即可见性)

即就是过在Volatile的写和读的时候,加入屏障,防止出现指令重排的

(

在每个volatile写操作的前面插入一个StoreStore屏障;

在每个volatile写操作的后面插入一个StoreLoad屏障;

在每个volatile读操作的后面插入一个LoadLoad屏障;

在每个volatile读操作的后面插入一个LoadStore屏障。

注意:volatile写是在前面和后面分别插入内存屏障,而volatile读操作是在后面插入两个内存屏障

)

--线程安全获得保证

① 工作内存与主内存同步延迟现象导致的可见性问题

可通过synchronized或volatile关键字解决,他们都可以使一个线程修改后的变量立即对其它线程可见

② 对于指令重排导致的可见性问题和有序性问题

可以使用volatile关键字解决,因为volatile关键字的另一个作用就是禁止重排序优化Ⅳ 怎么用

volatile在哪里使用(sxt2)

volatile 常用于多线程环境下的单次操作(单次读或者单次写)。

1) 双重检测(Double Check Lock,DCL):(https://blog.csdn.net/qq_38734403/article/details/106976266)- 问题:DCL机制不一定线程安全,原因是有指令重排序的存在,加入volatile可以禁止指令重排。

instance = new SingletonDemo();可以分为以下3步骤完成(伪代码)

memory = allocate(); //1.分配对象内存空间instance(memory); //2.初始化对象instance = memory; //3.设置instance指向刚分配的内存地址,此时instance != null

步骤2和步骤3 不存在数据依赖关系,而且无论重排前还是重排后程序的执行结果在单线程中没有改变,因此这种重排优化是允许的。

memory = allocate(); //1.分配对象内存空间instance = memory; //3.设置instance指向刚分配的内存地址,此时instance != null,但是对象还没有初始化完成!instance(memory); //2.初始化对象

但是指令重排只会保证穿行语义的执行的一致性(单线程),但并不会关心多线程间的语义一致性。所以当一条线程访问instance不为null时,由于instance实例未必已初始化完成,也就造成了线程安全问题。

- Volatile实现原理/底层实现? &作用

- 可见性的保证是基于 CPU 的内存屏障指令,抽象为happens-before原则

- volatile的一个重要作用就是和CAS结合,保证了原子性

- Volatile的写和读的时候,加入屏障,防止出现指令重排

synchronized

- Java性能调优_jk|synchronized_zejian|如何使用synchronized|

1 synchronized在1.6之后的改动?

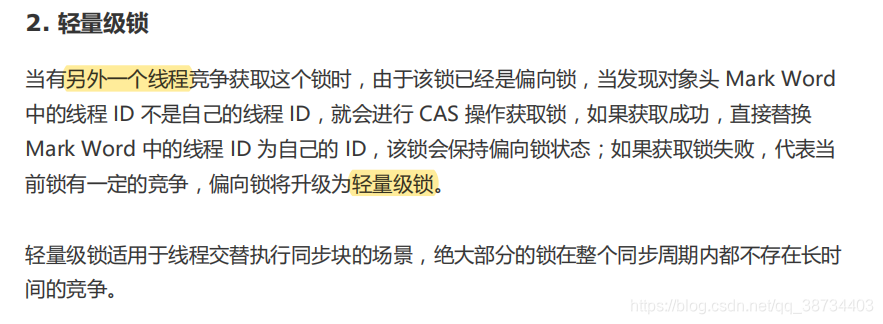

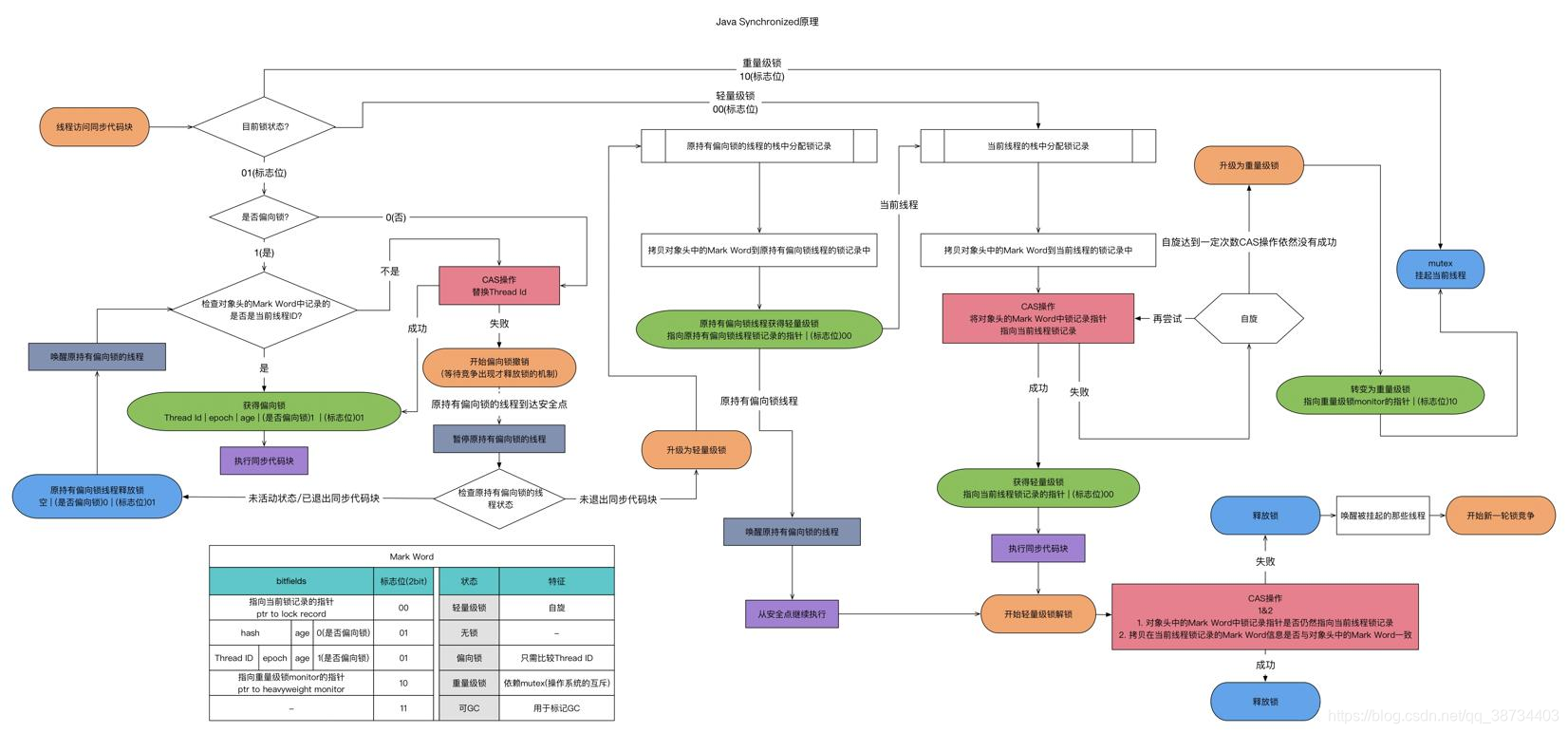

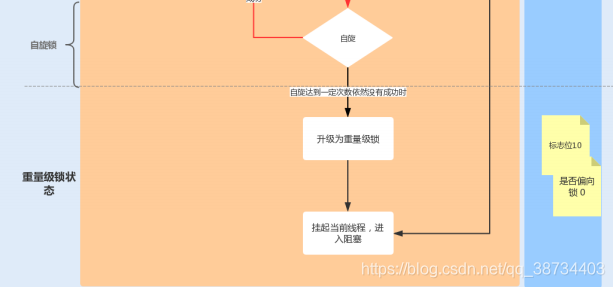

--JDK1.6 对锁的实现引入了大量的优化,如偏向锁、轻量级锁、自旋锁、适应性自旋锁、锁消除、锁粗化等技术来减少锁操作的开销。

--锁主要存在四种状态,依次是:无锁状态、偏向锁状态、轻量级锁状态、重量级锁状态,他们会随着竞争的激烈而逐渐升级。注意锁可以升级不可降级,这种策略是为了提高获得锁和释放锁的效率。2 4种用法

1)修饰一个代码块:同步代码块

① synchronized(this){

② synchronized(obj){//指定要给某个对象加锁,// 关键字在代码块上,锁为括号里面的对象

作用范围:大括号{}括起来的代码

作用对象:调用这个代码块的对象;

2)修饰一个方法:同步方法

写法1:synchronized void method(){

写法2:public void method(){

synchronized(this) {

作用范围:整个方法

作用对象:调用这个方法的所有对象;

非static方法时,获取的是对象锁(即类的实例对象) ,类的实例的锁。

3)修饰一个静态的方法:

synchronized static void method() {

作用范围:整个静态方法

作用对象:这个类的所有对象;

获取的是类锁(即Class本身,注意:不是实例),类的Class对象的锁。

4)修饰一个类:

synchronized(ClassName.class) {

作用范围:synchronized后面括号括起来的部分

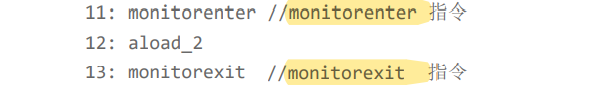

作用对象:这个类的所有对象。4 synchornized的底层原理

--Synchronized实现同步锁的方式有两种,一种是修饰方法,一种是修饰方法块

--Java虚拟机中的同步(Synchronization)基于进入和退出管程(Monitor)对象实现,无论是显式同步还是隐式同步都是如此。

-- 显式同步-同步代码块:有明确的 monitorenter 和 monitorexit 指令,即同步代码块

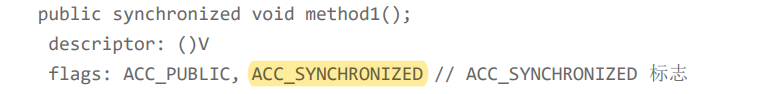

-- 隐式同步-同步方法:synchronized修饰的同步方法是Java中同步用的最多;由方法调用指令读取运行时常量池中方法的ACC_SYNCHRONIZED标志来隐式实现的显式同步-同步代码块

--由 monitorenter和 monitorexit 指令来实现同步的。

--进入 monitorenter 指令后,线程将持有 Monitor 对象,退出 monitorenter指令后,线程将释放该 Monitor 对象。

隐式同步-同步方法

--JVM使用了 ACC_SYNCHRONIZED访问标志来区分一个方法是否是同步方法。

--过程:当方法调用时,调用指令检查该方法是否被设置 ACC_SYNCHRONIZED 访问标志。

如果设置了该标志,执行线程将先持有 Monitor对象,然后再执行方法。在该方法运行期间,其它线程将无法获取到该Mointor 对象,当方法执行完成后,再释放该Monitor 对象。

Synchronized修饰方法是怎么实现锁原理

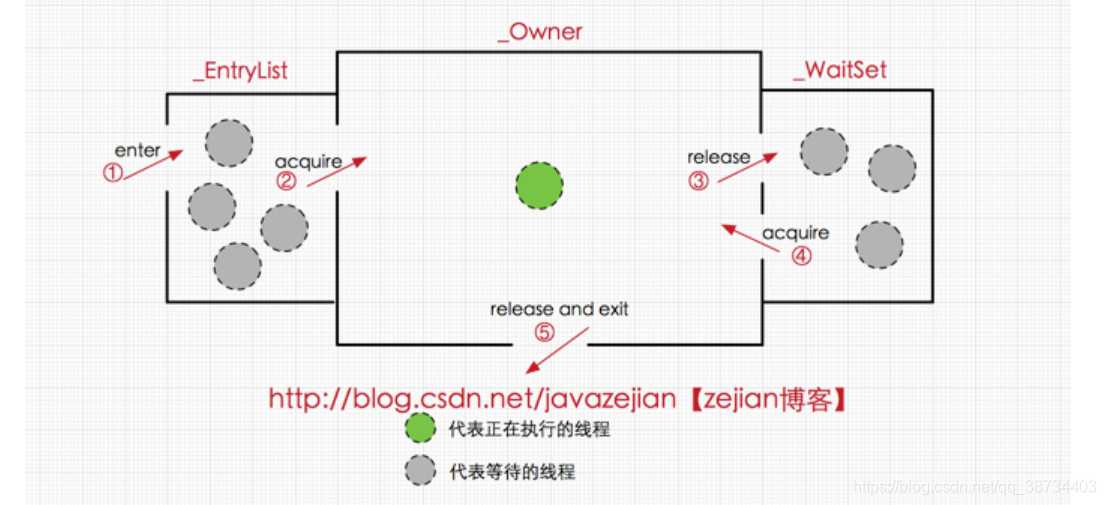

--JVM中的同步是基于进入和退出管程(Monitor)对象实现的。每个对象实例都会有一个Monitor,Monitor可以和对象一起创建、销毁。Monitor 是由 ObjectMonitor实现,而ObjectMonitor 是由 C++ 的 ObjectMonitor.hpp 文件实现。

--ObjectMonitor.hpp

ObjectMonitor() {

_header = NULL;

_count = 0; // 记录个数

_waiters = 0,

_recursions = 0;

_object = NULL;

_owner = NULL;

_WaitSet = NULL; // 处于 wait 状态的线程,会被加入到 _WaitSet

_WaitSetLock = 0 ;

_Responsible = NULL ;

_succ = NULL ;

_cxq = NULL ;

FreeNext = NULL ;

_EntryList = NULL ; // 处于等待锁 block 状态的线程,会被加入到该列表

_SpinFreq = 0 ;

_SpinClock = 0 ;

OwnerIsThread = 0 ;

}

1)变量

ObjectMonitor中有两个队列,_WaitSet 和 _EntryList,用来保存ObjectWaiter对象列表(每个等待锁的线程都会被封装成ObjectWaiter对象)

_owner指向持有ObjectMonitor对象的线程

2)流程

Monitor 是依靠底层操作系统的 Mutex Lock 来实现互斥的

--多个线程同时访问一段同步代码时,多个线程会先被存放在 EntryList集合中,处于block状态的线程,都会被加入到该列表。

--当线程获取到对象的Monitor后进入 _Owner区域并把monitor中的owner变量设置为当前线程同时monitor中的计数器count加1

①若线程申请 Mutex成功,则持有该Mutex,其它线程将无法获取到该Mutex。当前线程执行完毕也将释放monitor(锁)并复位变量的值,以便其他线程进入获取monitor(锁)

②若线程调用 wait()方法,将将释放当前持有的monitor,,释放当前持有的Mutex,owner变量恢复为null,count自减1,同时该线程会进入 WaitSet集合中,等待下一次被唤醒。如果当前线程顺利执行完方法,也将释放 Mutex。

3 synchronized可重入实现

--定义:当一个线程再次请求自己持有对象锁的临界资源时,这种情况属于重入锁。

--在一个线程调用synchronized方法的同时在其方法体内部调用该对象另一个synchronized方法,也就是说一个线程得到一个对象锁后再次请求该对象锁,是允许的,这就是synchronized的可重入性。

注意另外一种情况,当子类继承父类时,子类也是可以通过可重入锁调用父类的同步方法。

--实现:

synchronized是基于monitor实现的,因此每次重入,monitor中的计数器仍会加1。

每个锁关联一个线程持有者和一个计数器。当计数器为0时表示该锁没有被任何线程持有,那么任何线程都都可能获得该锁而调用相应方法。当一个线程请求成功后,JVM会记下持有锁的线程,并将计数器计为1。此时其他线程请求该锁,则必须等待。而该持有锁的线程如果再次请求这个锁,就可以再次拿到这个锁,同时计数器会递增。当线程退出一个synchronized方法/块时,计数器会递减,如果计数器为0则释放该锁。- volatile和synchronized的区别?

区别 - 其他重入锁

① synchronized

② java.util.concurrent.locks.ReentrantLock

synchronized锁升级

- Java性能调优_jk|synchronized_zejian

- Monitor是依赖于底层的操作系统实现,存在用户态与内核态之间的切换,所以增加了性能开销,因此引出锁升级

- 在JDK1.6以前,使用synchronized就只有一种方式即重量级锁,而在JDK1.6以后,引入了偏向锁,轻量级锁,重量级锁,来减少竞争带来的上下文切换。

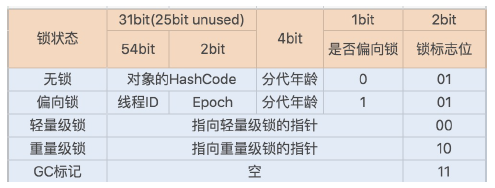

- 1 对象头

--对象实例(堆内存):对象头、实例数据、对齐填充。

--对象头:Mark Word、指向类的指针、数组长度 - 锁升级功能主要依赖于 Mark Word中的锁标志位和释放偏向锁标志位,

- 1)偏向锁

--在高并发场景下,当大量线程同时竞争同一个锁资源时,偏向锁就会被撤销,发生stop the word 后,通过添加JVM参数关闭偏向锁来调优系统性能,

-XX:-UseBiasedLocking // 关闭偏向锁(默认打开)

或

-XX:+UseHeavyMonitors // 设置重量级锁 - 2)轻量级锁

- 3)重量级锁

其他锁优化

1)动态编译实现锁消除 / 锁粗化

除了锁升级优化,Java 还使用了编译器对锁进行优化。

--JIT 编译器在动态编译同步块的时候,借助了一种被称为逃逸分析的技术

--JIT 编译器在编译这个同步块的时候不会生成 synchronized 所表示的锁的申请与释放的机器码,即消除了锁的使用。

--JIT 编译器将会把这几个同步块合并为一个大的同步块,从而避免一个线程“反

复申请、释放同一个锁“所带来的性能开销。

2) 减小锁粒度

--将一个数组和队列对象拆成多个小对象,来降低锁竞争,提升并行

度。

--最经典的减小锁粒度的案例就是 JDK1.8 之前实现的 ConcurrentHashMap 版本。

--ConcurrentHashMap 就很很巧妙地使用了分段锁 Segment 来降低锁资源竞争。

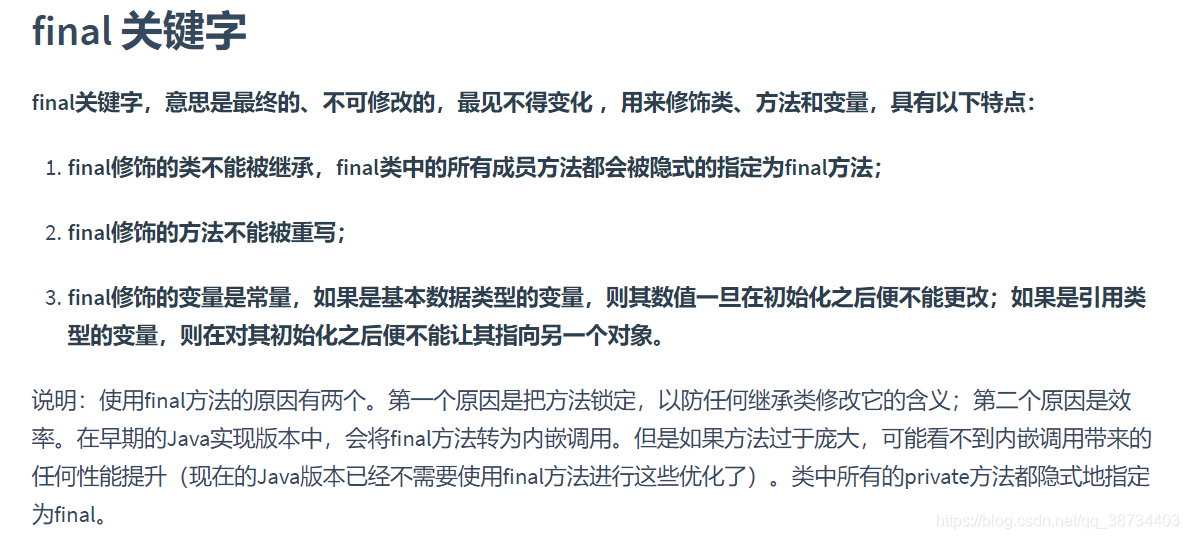

final

- final关键字

final、finally、finalize区别?

final

final修饰类,表示该类不可以被继承

final修饰变量,表示该变量不可以被修改,只允许赋值一次

final修饰方法,表示该方法不可以被重写

finally

finally是java保证代码一定要被执行的一种机制。

比如try-finally或try-catch-finally,用来关闭JDBC连接资源,用来解锁等等

finalize

finalize是Object的一个方法,它的目的是保证对象在被垃圾收集前完成特定资源的回收。- volatile和final的共同点

- 首先:对于一些需要快速读写的数据,可以从内存读取到CPU的寄存器中操作

- final 关键字声明的变量,会被CPU添加到寄存器中,读写都很快速

- volatile 它是被设计用来修饰被不同线程访问和修改的变量, 禁止把该变量放到CPU的寄存器中,防止多线程访问出现错乱问题

1、JMM保证final变量初始化时的有序性、禁止编译器和处理器重排序。

2、final作为不可变对象,正确初始化后(没有this逃逸),能够保障可见性。

3、volatile能够保障单次操作的原子性

4、volatile能够保障变量的可见性

锁机制

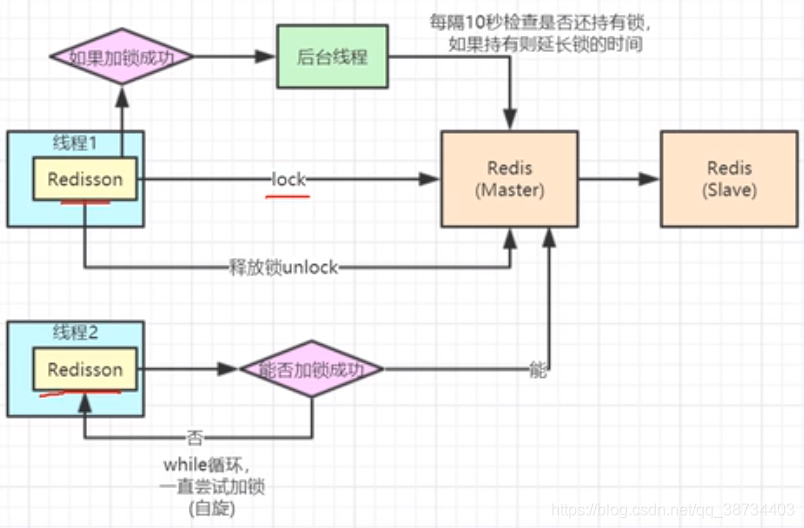

分布式锁

分布式锁一般有三种实现方式:1.数据库锁;2.基于Redis的分布式锁;3. 基于ZooKeeper的分布式锁。线程同步的方式?

① synchronized

② Condition

③ CountDownLatch、CyclicBarrierjava锁及实现

- volatile、synchronized、CAS

- 锁-是为了解决并发操作引起的脏读、数据不一致的问题。

https://www.jianshu.com/p/e674ee68fd3f

java锁机制

1) 所熟知的Java锁机制无非就是Sychornized 锁 和 Lock锁 (对象头知识,偏向锁,轻量级锁,重量级锁)- Lock 同步锁是基于 Java 实现的,而 Synchronized是基于底层操作系统的 Mutex Lock实现的,每次获取和释放锁操作都会带来用户态和内核态的切换,从而增加系统性能开销。

https://www.jianshu.com/p/e674ee68fd3f

2) 在 Java 多线程编程当中,提供了多种实现 Java 线程安全的方式: - 最简单的方式,使用 Synchronization 关键字

- 使用 java.util.concurrent.atomic 包中的原子类,例如 AtomicInteger

- 使用 java.util.concurrent.locks 包中的锁

- 使用线程安全的集合 ConcurrentHashMap

- 使用 volatile 关键字,保证变量可见性(直接从内存读,而不是从线程 cache 读

https://www.cnblogs.com/theworld/p/12056452.html

https://www.jianshu.com/p/e674ee68fd3f

- Lock 同步锁是基于 Java 实现的,而 Synchronized是基于底层操作系统的 Mutex Lock实现的,每次获取和释放锁操作都会带来用户态和内核态的切换,从而增加系统性能开销。

都有什么锁?说说乐观锁悲观锁是什么,怎么实现,volatile关键字,CAS,AQS原理及实现。

1)锁的分类:- 公平锁、非公平锁

- 互斥锁、读写锁

- 乐观锁、悲观锁

synchronized,retreenLock, ReadWriteLock

4)CAS,AQS原理及实现

死锁

- 死锁编码及定位分析:

- 概念:死锁是指多个进程循环等待彼此占有的资源而无限期的僵持等待下去的局面。

即A使用A资源并等待使用B资源,B使用B资源并等待使用A资源 - 必要条件:互斥条件、不可抢占条件、占有且等待条件、循环等待条件

- 死锁处理:死锁的预防、死锁避免、死锁的检测与恢复三种方法。

详见:https://blog.csdn.net/zhang123bl/article/details/89850646 1)死锁是什么(sxt2)

1)产生死锁主要的原因

① 系统资源不足、② 进程运行推进的顺序不合适、③ 资源分配不当

2) 代码、class HoldLockThread implements Runnable{private String lockA;private String lockB;public HoldLockThread(String lockA, String lockB) {this.lockA = lockA;this.lockB = lockB;}@Overridepublic void run() {synchronized (lockA){System.out.println(Thread.currentThread().getName() + "\t 自己持有" + lockA + "\t 尝试获得" + lockB);try { TimeUnit.SECONDS.sleep(2); } catch (InterruptedException e) { e.printStackTrace(); }synchronized (lockB){System.out.println(Thread.currentThread().getName() + "\t 自己持有" + lockA + "\t 尝试获得" + lockB);}}}}public class DeadLockDemo {public static void main(String[] args) {String lockA = "lockA";String lockB = "lockB";new Thread(new HoldLockThread(lockA,lockB) ,"ThreadAAA").start();new Thread(new HoldLockThread(lockB,lockA) ,"ThreadBBB").start();}}

打印:

打印ThreadAAA 自己持有:lockA 尝试获得:lockBThreadBBB 自己持有:lockB 尝试获得:lockA

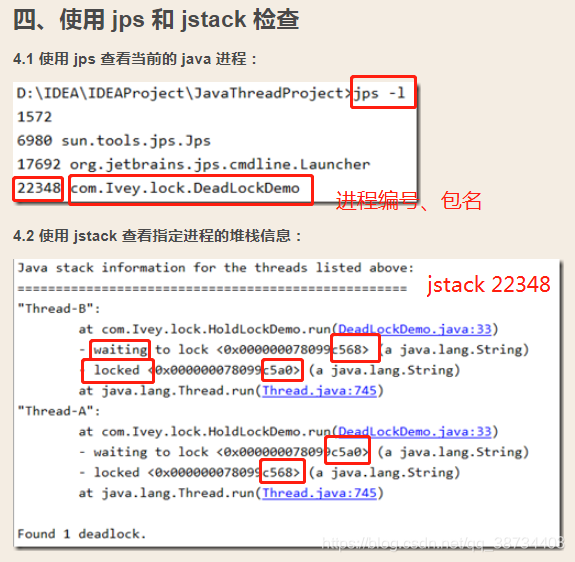

2)死锁怎么定位。

① jps 定位进程号

② jstack 找到死锁查看

linux ps -ef|grep XXxxxx ls -l

windows jps=java ps 只查看java jps -l

另:https://blog.csdn.net/zp357252539/article/details/104292521如何解决死锁

解决死锁问题的方法是:一种是用synchronized,一种是用Lock显式锁实现。

线程排查

1. 排查CPU占满的Java线程

产生CPU100%的原因:某一程序一直占用CPU是导致CPU100%的原因,大概有以下几种情况:

1)Java 内存不够或溢出导致GC overhead问题, GC overhead 导致的CPU 100%问题;

2)死循环问题. 如常见的HashMap被多个线程并发使用导致的死循环, 或者死循环;

3)某些操作一直占用CPU

步骤:

1)jps 获取Java**进程的PID。

2)top -Hp PID 查看对应进程的哪个线程**占用CPU过高。该进程内最耗费CPU的线程

3)echo "obase=16;PID" | bc 将线程的PID转换为16进制,大写转换为小写。

4)jstack pid >> java.txt 导出CPU占用高进程的线程栈

jstack 2444 >stack.txt或者jstack 进程id | grep 16进制线程id

在Java.txt中查找转换成为16进制的线程PID。找到对应的线程栈。

辅助

命令参考

grep "99b" stack.txt -A 25

grep -C 5 foo file 显示file文件里匹配foo字串那行以及上下5行

grep -B 5 foo file 显示foo及前5行

grep -A 5 foo file 显示foo及后5行

对线程状态进行分析。

新建( new )、可运行( runnable )、运行( running )、阻塞( block )、死亡( dead )

如何解决死锁

如何预防死锁?

- 死锁的产生

1)互斥,共享资源 X 和 Y 只能被一个线程占用;

2)占有且等待,线程 T1 已经取得共享资源 X,在等待共享资源 Y 的时候,不释放共享资源 X;

3)不可抢占,其他线程不能强行抢占线程 T1 占有的资源;

4)循环等待,线程 T1 等待线程 T2 占有的资源,线程 T2 等待线程 T1 占有的资源,就是循环等

待。 - 破坏死锁条件

1)对于“占用且等待”这个条件,我们可以一次性申请所有的资源,这样就不存在等待了。

2)对于“不可抢占”这个条件,占用部分资源的线程进一步申请其他资源时,如果申请不到,可以主动释放它占有的资源,这样不可抢占这个条件就破坏掉了。

3)对于“循环等待”这个条件,可以靠按序申请资源来预防。所谓按序申请,是指资源是有线性顺序的,申请的时候可以先申请资源序号小的,再申请资源序号大的,这样线性化后自然就不存在循环了。

- 死锁的产生

互斥、占有且等待、循环等待

- 1)循环等待问题:

破坏占用且等待条件的时,如果转出账本和转入账本不满足同时在文件架上这个条件,就用while死循环的方式来循环等待, - 2)循环等待问题的解决方案?

方案:如果线程要求的条件(转出账本和转入账本同在文件架上)不满足,则线程阻塞自己,进入等待状态;当线程要求的条件(转出账本和转入账本同在文件架上)满足后,通知等待的线程重新执行。其中,使用线程阻塞的方式就能避免循环等待消耗CPU的问题。 - 3)等待-通知机制

一个完整的等待-通知机制:线程首先获取互斥锁,当线程要求的条件不满足时,释放互斥锁,进入等待状态;当要求的条件满足时,通知等待的线程重新获取互斥锁。 - 4)如何用synchronized实现等待-通知机制?

Java语言里,等待-通知机制可以有多种实现方式,比如 Java 语言内置的 synchronized配合wait()、notify()、notifyAll()这三个方法就能轻松实现。 - 5)如何用synchronized实现互斥锁?

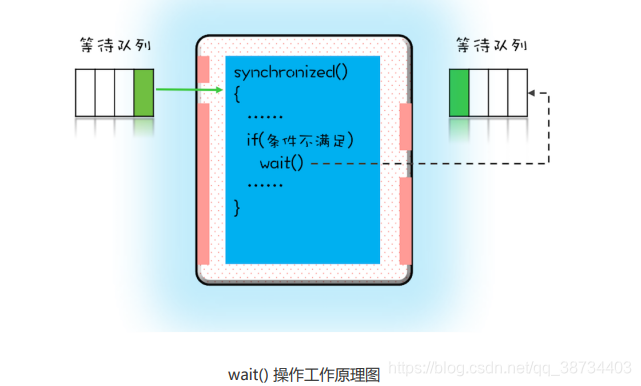

--在下面这个图里,左边有一个等待队列,同一时刻,只允许一个线程进入synchronized保护的临界区(这个临界区可以看作大夫的诊室),当有一个线程进入临界区后,其他线程就只能进入图中左边的等待队列里等待(相当于患者分诊等待)。这个等待队列和互斥锁是一对一的关系,每个互斥锁都有自己独立的等待队列。

--在并发程序中,当一个线程进入临界区后,由于某些条件不满足,需要进入等待状态,Java 对象的 wait() 方法就能够满足这种需求。如上图所示,当调用 wait() 方法后,当前线程就会被阻塞,并且进入到右边的等待队列中,这个等待队列也是互斥锁的等待队列。线程在进入等待队列的同时,会释放持有的互斥锁,线程释放锁后,其他线程就有机会获得锁,并进入临界区了。

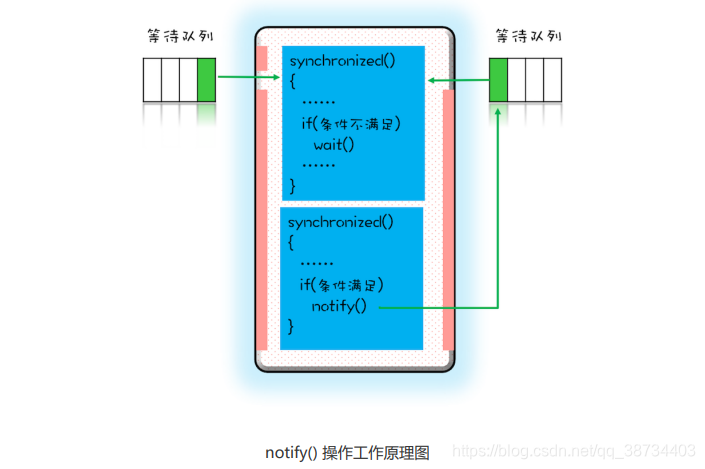

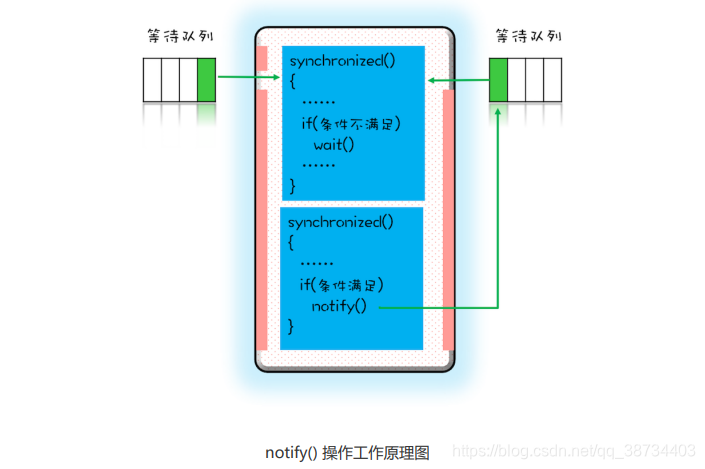

- 那线程要求的条件满足时,如何通知这个等待的线程呢?

就是 Java 对象的 notify()和notifyAll()方法。下图大致描述了这个过程,当条件满足时调用notify(),会通知等待队列(互斥锁的等待队列)中的线程,告诉它条件曾经满足过。

- 为什么说是曾经满足过呢?

注意:notify()只能保证在通知时间点,条件是满足的。而被通知线程的执行时间点和通知的时间点基本上不会重合,所以当线程执行的时候,很可能条件已经不满足了(保不齐有其他线程插队)。 - 还需注意:被通知的线程要想重新执行,仍然需要获取到互斥锁(因为曾经获取的锁在调用 wait() 时已经释放了)。

- 6)使用wait()、notify()、notifyAll()方法?

--synchronized 锁定的是this,那么对应的一定是this.wait()、this.notify()、this.notifyAll();

--synchronized 锁定的是target,那么对应的一定是target.wait()、target.notify()、target.notifyAll() 。

--wait()、notify()、notifyAll()这三个方法能够被调用的前提是已经获取了相应的互斥锁,所以我们会发现 wait()、notify()、notifyAll() 都是在

synchronized{}内部被调用的。如果在 synchronized{}外部调用,或者锁定的 this,而用target.wait() 调用的话,JVM 会抛出一个运行时异常:

java.lang.IllegalMonitorStateException。 - 7)尽量使用 notifyAll()?

--上述使用notifyAll()来实现通知机制,为什么不使用notify()呢?

--这二者是有区别的,notify() 是会随机地通知等待队列中的一个线程,而 notifyAll() 会通知等待队列中的所有线程。从感觉上来讲,应该是 notify() 更好一些,因为即便通知所有线程,也只有一个线程能够进入临界区。实际上使用notify()也很有风险,它的风险在于可能导致某些线程永远不会被通知到。

--假设我们有资源 A、B、C、D,线程 1 申请到了 AB,线程 2 申请到了 CD,此时线程 3 申请AB,会进入等待队列(AB 分配给线程 1,线程 3 要求的条件不满足),线程 4 申请 CD 也会进入等待队列。我们再假设之后线程 1 归还了资源 AB,如果使用notify()来通知等待队列中的线程,有可能被通知的是线程 4,但线程 4 申请的是 CD,所以此时线程 4 还是会继续等待,而真

正该唤醒的线程 3 就再也没有机会被唤醒了。

--所以除非经过深思熟虑,否则尽量使用 notifyAll()。

- 1)循环等待问题:

不可抢占

- Java SDK 并发包通过 Lock 和 Condition 两个接口来实现管程,其中 Lock 用于解决互斥问题,Condition 用于解决同步问题。

- Java 语言本身提供的 synchronized 也是管程的一种实现,既然 Java 从语言层面已经实现了管程了,那为什么还要在SDK里提供另外一种实现呢?

为解决的问题:

死锁问题中,破坏不可抢占条件方案,但是这个方案synchronized没有办法解决。原因是synchronized申请资源的时候,如果申请不到,线程直接进入阻塞状态了,而线程进入阻塞状态,也释放不了线程已经占有的资源。但我们希望的是:对于“不可抢占”这个条件,占用部分资源的线程进一步申请其他资源时,如果申请不到,可以主动释放它占有的资源,这样不可抢占这个条件就破坏掉了。

Java SDK 并发包里的Lock有别于synchronized隐式锁的三个特性:能够响应中断、支持超时和非阻塞地获取锁。

互斥锁lock三种方案:

1)能够响应中断。

synchronized 的问题是,持有锁 A 后,如果尝试获取锁B失败,那么线程就进入阻塞状态,一旦发生死锁,就没有任何机会来唤醒阻塞的线程。但如果阻塞状态的线程能够响应中断信号,也就是说当给阻塞的线程发送中断信号的时候,能够唤醒它,那它就有机会释放曾经持有的锁A。这样就破坏了不可抢占条件了。

2)支持超时。

如果线程在一段时间之内没有获取到锁,不是进入阻塞状态,而是返回一个错误,那这个线程也有机会释放曾经持有的锁。这样也能破坏不可抢占条件。

3)非阻塞地获取锁。如果尝试获取锁失败,并不进入阻塞状态,而是直接返回,那这个线程也有机会释放曾经持有的锁。这样也能破坏不可抢占条件。

--这三种方案可以全面弥补synchronized的问题。这三个方案体现在API上,就是 Lock 接口的三个方法。如下:// 支持中断的 APIvoid lockInterruptibly()throws InterruptedException;// 支持超时的 APIboolean tryLock(long time, TimeUnit unit)throws InterruptedException;// 支持非阻塞获取锁的 APIboolean tryLock();

如何保证可见性?

--Java SDK 里面 Lock 的使用,有一个经典的范例,就是try{}finally{}

,需要重点关注的是在finally里面释放锁。

--可见性是怎么保证的?

--- Java 里多线程的可见性是通过 Happens-Before 规则保证的,

--- synchronized 之所以能够保证可见性,也是因为有一条 synchronized相关的规则:synchronized 的解锁Happens-Before于后续对这个锁的加锁。

--- Java SDK 里面 Lock 靠什么保证可见性呢?例如在下面的代码中,线程 T1 对 value 进行了 +=1 操作,那后续的线程 T2 能够看到 value的正确结果吗?class X {private final Lock rtl = new ReentrantLock();int value;public void addOne() {// 获取锁rtl.lock();try {value+=1;} finally {// 保证锁能释放rtl.unlock();}}}

答案必须是肯定的。Java SDK里面锁原理简述:利用了 volatile 相关的 Happens-Before 规则。Java SDK 里面的ReentrantLock,内部持有一个 volatile 的成员变量 state,获取锁的时候,会读写 state 的值;解锁的时候,也会读写 state的值(简化后的代码如下面所示)。也就是说,在执行 value+=1

之前,程序先读写了一次 volatile 变量 state,在执行 value+=1 之后,又读写了一次 volatile变量 state。根据相关的 Happens-Before 规则:

1)顺序性规则:对于线程 T1,value+=1 Happens-Before 释放锁的操作 unlock();

2)volatile 变量规则:由于 state = 1 会先读取 state,所以线程 T1 的 unlock() 操作Happens-Before 线程 T2 的 lock() 操作;

3)传递性规则:线程 T2 的 lock() 操作 Happens-Before 线程 T1 的 value+=1 。class SampleLock {volatile int state;// 加锁lock() {// 省略代码无数state = 1;}// 解锁unlock() {// 省略代码无数state = 0;}}

所以说,后续线程 T2 能够看到 value 的正确结果

Condition

- Java SDK 并发包里的 Condition

--Condition实现了管程模型里面的条件变量。

--管程中提到 Java 语言内置的管程里只有一个条件变量,而 Lock&Condition实现的管程是支持多个条件变量的,这是二者的一个重要区别。

--很多并发场景下,支持多个条件变量能够让并发程序可读性更好,实现起来也更容易。

--例如,实现一个阻塞队列,就需要两个条件变量。 - 如何利用两个条件变量快速实现阻塞队列呢?

一个阻塞队列,需要两个条件变量,一个是队列不空(空队列不允许出队),另一个是队列不满(队列已满不允许入队)。相

关的代码,重新列出。

public class BlockedQueue<T>{final Lock lock = new ReentrantLock();// 条件变量:队列不满final Condition notFull = lock.newCondition();// 条件变量:队列不空final Condition notEmpty = lock.newCondition();// 入队void enq(T x) {lock.lock();try {while (队列已满){// 等待队列不满notFull.await();}// 省略入队操作...// 入队后, 通知可出队notEmpty.signal();}finally {lock.unlock();}}// 出队void deq(){lock.lock();try {while (队列已空){// 等待队列不空notEmpty.await();}// 省略出队操作...// 出队后,通知可入队notFull.signal();}finally {lock.unlock();}}}

注意:

-- Lock 和 Condition实现的管程,线程等待和通知需要调用await()、signal()、signalAll(),语义和wait()、notify()、notifyAll()是相同的。

-- 区别是,Lock&Condition实现的管程里只能使用前面的await()、signal()、signalAll(),而后面的wait()、notify()、notifyAll() 只有在 synchronized实现的管程里才能使用。

-- 如果一不小心在Lock&Condition实现的管程里调用了wait()、notify()、notifyAll(),那程序可就彻底玩儿完了。- Java SDK 并发包里的 Condition

线程生命周期

- os线程和Java线程_zejian

1 操作系统线程状态

1) 死锁,Deadlock(重点关注)

2) 执行中,Runnable

3) 等待资源,Waiting on condition(重点关注,等待什么资源)

4) 等待获取监视器,Waiting on monitor entry(重点关注)

5) 暂停,Suspended

6) 对象等待中,Object.wait() 或 TIMED_WAITING

7) 阻塞,Blocked(重点关注)

8) 停止,Parked

2 Java线程的状态

- Java语言中线程共有六种状态,分别是:

1)NEW(初始化状态)

2)RUNNABLE(可运行/运行状态)

3)BLOCKED(阻塞状态)

4)WAITING(无时限等待)

5)TIMED_WAITING(有时限等待)

6)TERMINATED(终止状态) 在操作系统层面,Java线程中的BLOCKED、WAITING、TIMED_WAITING是一种状态,即休眠状态。Java线程处于这三种状态之一,那么这个线程就永远没有CPU的使用权。

3线程的状态及转换方式

RUNNABLE与BLOCKED的状态转换

-- RUNNABLE转BLOCKED:一种场景会触发,线程等待synchronized的隐式锁。

-- BLOCKED转RUNNABLE:当等待的线程获得synchronized隐式锁时,就又会从BLOCKED转换到RUNNABLE状态。

RUNNABLE与WAITING的状态转换:3种场景会触发

① 获得synchronized隐式锁的线程,调用无参数的 Object.wait() 方法。

② 调用无参数的Thread.join()方法。

join()是一种线程同步方法,例如有一个线程对象threadA,当调用A.join()的时候,执行这条语句的线程会等待threadA执行完,而等待中的这个线程,其状态会从 RUNNABLE 转换到 WAITING。当线程 thread A 执行完,原来等待它的线程又会从 WAITING 状态转换到 RUNNABLE。

③ 调用 LockSupport.park() 方法。

调用LockSupport.park()方法,当前线程会阻塞,线程的状态会从 RUNNABLE 转换到 WAITING。调用 LockSupport.unpark(Thread thread) 可唤醒目标线程,目标线程的状态又会从 WAITING 状态转换到 RUNNABLE。

RUNNABLE与TIMED_WAITING的状态转换:5种场景会触发

① 调用带超时参数的 Thread.sleep(long millis) 方法;

② 获得synchronized隐式锁的线程,调用带超时参数的Object.wait(long timeout) 方法;

③ 调用带超时参数的 Thread.join(long millis) 方法;

④ 调用带超时参数的 LockSupport.parkNanos(Object blocker, long deadline) 方法;

⑤ 调用带超时参数的 LockSupport.parkUntil(long deadline) 方法。

NEW到RUNNABLE状态

Java刚创建出来的Thread对象就是NEW状态。

从NEW状态转换到RUNNABLE状态,只要调用线程对象的start()方法就可以

从RUNNABLE到TERMINATED状态

-- 线程执行完run()方法后,会自动转换到TERMINATED状态,当然如果执行run()方法的时候异常抛出,也会导致线程终止。

-- 强制中断run()方法的执行,调用 interrupt()方法。阻塞和等待的区别?

--定义+何时触发?

--BLOCKED:一个线程因为等待临界区的锁被阻塞产生的状态

--WAITING:一个线程进入了锁,但是需要等待其他线程执行某些操作。时间不确定- sleep和wait有什么区别?

--对于sleep()方法,我们首先要知道该方法是属于Thread类中的。而wait()方法,则是属于Object类中的。

Thread类的方法:sleep(),yield()等

Object的方法:wait()和notify()等

--sleep()方法导致了程序暂停执行指定的时间,让出cpu该其他线程,但是他的监控状态依然保持者,当指定的时间到了又会自动恢复运行状态。

在调用sleep()方法的过程中,线程不会释放对象锁。

---调用wait()方法的时候,线程会放弃对象锁,进入等待此对象的等待锁定池,只有针对此对象调用notify()方法后本线程才进入对象锁定池准备获取对象锁进入运行状态。 - 参考:https://www.cnblogs.com/hongten/p/hongten_java_sleep_wait.html

JUC

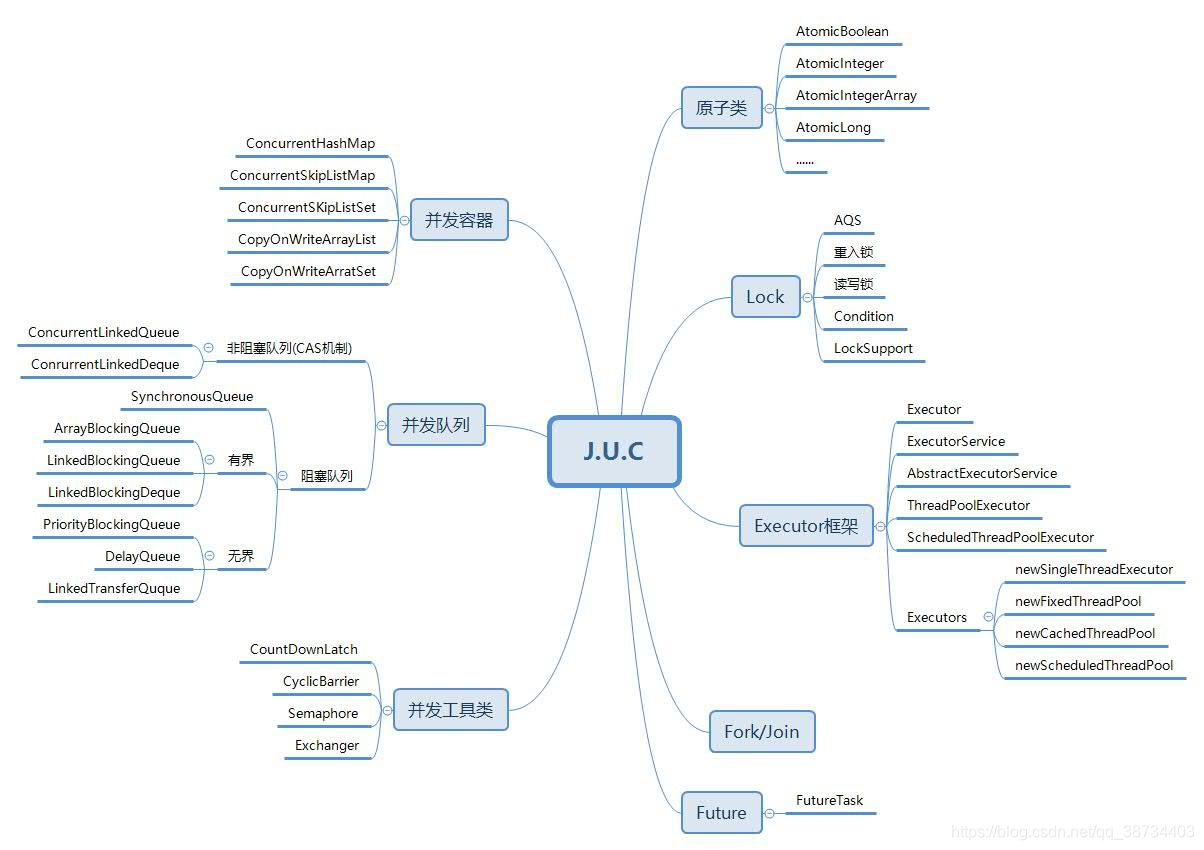

- 1 JUC概念

--Java5提供java.util.concurrent在并发编程中使用的工具类。

--作用:用于定义类似于线程的自定义子系统,包括线程池,异步IO和轻量级任务框架

--还提供了设计用于多线程上下文中的 Collection 实现等;

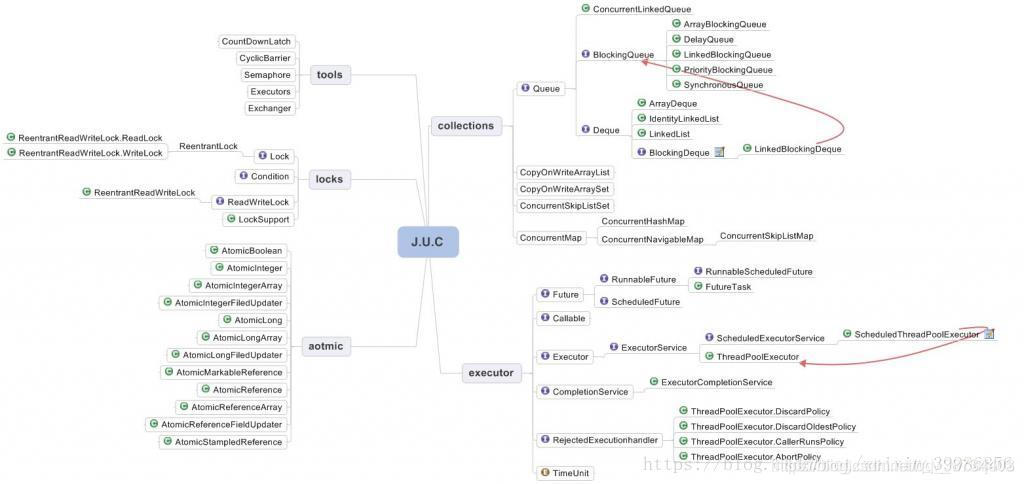

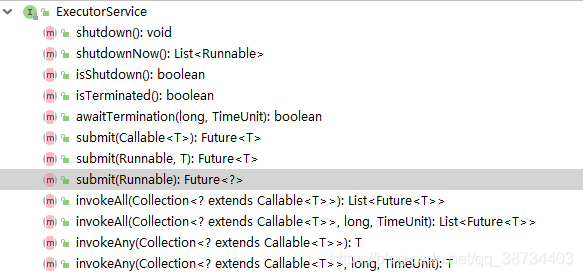

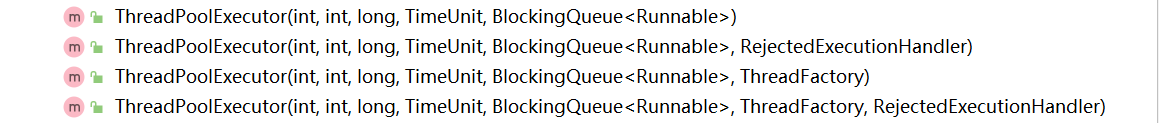

- 2 JUC下的组件

- 3 JUC下的automic包

- jdk1.8的并发包来说,底层基本上就是通过Usafe和CAS机制来实现的。

https://baijiahao.baidu.com/s?id=1647621616629561468&wfr=spider&for=pc

synchronized和lock的区别

- 1 Lock&Condition

Java SDK 并发包通过Lock和Condition两个接口来实现管程,其中 Lock用于解决互斥问题,Condition用于解决同步问题。 - 2 synchronized和lock有什么区别?用新的lock有什么好处?举例说明(sxt2)

1、原始构成

--synchronized 是关键字属于 JVM 层面,monitorenter(底层是通过 monitor 对象来完成, 其实 wait/notify 等方法也依赖于 monitor 对象只有在同步块或方法中才能调 wait/notify 等方法)monitorexit

--Lock是具体类(java.util.concurrent.locks.Lock)是api层面的锁

2、使用方法

--synchronized 不需要用户去手动释放锁,当 synchronized 代码执行完后系统会自动让线程释放对锁的占用

--ReentrantLock 则需要用户去手动释放锁若没有主动释放锁,就有可能导致出现死锁现象。

需要 lock() 和 unlock() 方法配合 try / finally 语句块来完成。

3、等待是否可中断

--synchronized 不可中断,除非抛出异常或者正常运行完成

--ReentrantLock 可中断

① 设置超时方法 tryLock(long timeout, TimeUnit unit)

② lockInterruptibly() 放代码块这,调用 interrupt() 方法可中断

4、加锁是否公平

--synchronized 非公平锁

--ReentrantLock 两者都可以,默认非公平锁,构造方法可以传入 boolean 值,true 为公平锁,false 为非公平锁

5、锁绑定多个条件 Condition

--synchronized 没有

--ReentrantLock 用来实现分组唤醒需要唤醒的线程们,可以精确唤醒,而不是像synchronized要么随机唤醒一个线程要么唤醒全部线程。

代码

Object 的wait()/notify()/notifyAll() 的用法

Condition的 await()、signal()、signalAll()

- lock怎么知道有没有拿到锁?

乐观锁悲观锁

- 1 概念

加锁是一种悲观策略,无锁是一种乐观策略;

1)悲观锁:

--概念:总是假设最坏的情况,每次去拿数据的时候都认为别人会修改,所以每次在拿数据的时候都会上锁,这样别人想拿这个数据就会阻塞直到它拿到锁。

--应用:传统的关系型数据库里,如行锁,表锁等,读锁,写锁等;Java同步原语synchronized关键字的实现;

2)乐观锁

--概念:假设每次去拿数据的时候都认为别人不会修改,所以不会上锁,线程可以不停执行,无需加锁,无需等待,但是在更新的时候会判断一下在此期间别人有没有去更新这个数据,可以使用版本号等机制。

无锁则总是假设对共享资源的访问没有冲突,线程可以不停执行,无需加锁,无需等待,一旦发现冲突,无锁策略则采用一种称为CAS的技术来保证线程执行的安全性。

--应用:乐观锁适用于多读的应用类型,这样可以提高吞吐量,像数据库提供的类似于 write_condition 机制,其实都是提供的乐观锁。Java中 java.util.concurrent.atomic 包下面的原子变量类就是使用了乐观锁的一种实现方式 CAS 实现的。

--实现:版本号或者CAS2种方法 - 3 应用场景

悲观锁和乐观锁是数据库用来保证数据并发安全防止更新丢失的两种方法

乐观锁:适合读操作比较频繁的场景

如果出现大量的写入操作,数据发生冲突的可能性就会增大,为了保证数据的一致性,应用层需要不断的重新获取数据,这样会增加大量的查询操作,降低了系统的吞吐量。

悲观锁:适合写操作比较频繁的场景

如果出现大量的读取操作,每次读取的时候都会进行加锁,这样会增加大量的锁的开销,降低了系统的吞吐量。

CAS + Atomic

- 原子类_zejian

- 汇编底层

- 常见问题

会问:CAS -> Unsafe > CAS底层 -> ABA -> 原子引用更新 -> 如何规避ABA - 讲一讲AtomicInteger,为什么要用CAS而不是syschronized?

回答即可:① 底层原理:自旋锁;② Unsafe类(Unsafe类+CAS思想,即自旋)

syschronized一个时间段只允许一个线程访问,保证了一致性,并发性下降;CAS中的do-while没有加锁,可以反复的通过CAS比较,知道成功,既保证一致性,又提高了并发性。 1 CAS

1)CAS是什么

--概念:CAS 的全称 Compare-And-Swap即比较交换。它是一条 CPU 并发原语。

--功能:是判断内存某一个位置的值是否为预期,如果是则更改这个值,这个过程就是原子的。

--核心思想:执行函数:CAS(V,E,N)

3个参数:V表示要更新的变量,E表示预期值,N表示新值

如CAS(1,1,3)=> 1=1,则将1置为3

--CAS 并发原语现在 JAVA 语言中就是 sun.misc.Unsafe 类中的各个方法。调用 UnSafe 类中的 CAS 方法,JVM 会帮我们实现出 CAS 汇编指令。这是一种完全依赖硬件的功能,通过它实现了原子操作。由于 CAS 是一种系统原语,原语属于操作系统用语范畴,是由若干条指令组成,用于完成某一个功能的过程,并且原语的执行必须是连续的,在执行的过程中不允许被中断,也就是说 CAS 是一条原子指令,不会造成所谓的数据不一致的问题。(即线程安全)

2)UnSafe:JVM的原始类,部分属性方法native修饰

--Unsafe 是 CAS 的核心类,由于 Java 方法无法直接访问底层系统,而需要通过本地(native)方法来访问, Unsafe 类相当一个后门,基于该类可以直接操作特定内存的数据。Unsafe 类存在于 sun.misc 包中,其内部方法操作可以像 C 指针一样直接操作内存,因为 Java 中 CAS 操作执行依赖于 Unsafe 类。

--变量 vauleOffset,表示该变量值在内存中的偏移量,因为 Unsafe 就是根据内存偏移量来获取数据原值的。

--变量 value 用 volatile 修饰,保证了多线程之间的内存可见性,value是同一份。

--Unsafe类中的compareAndSwapInt,是一个本地方法,实现位于unsafe.cpp中。

2.1)Unsafe类一些属性、方法:

--类和实例对象以及变量的操作://获得给定对象的指定偏移量offset的int值,使用volatile语义,总能获取到最新的int值。public native int getIntVolatile(Object o, long offset);

--Unsafe类中CAS 操作相关:

Java中无锁操作CAS基于以下3个方法实现,在Atomic系列内部方法是基于下述方法的实现的。//第一个参数o为给定对象,offset为对象内存的偏移量,通过这个偏移量迅速定位字段并设置或获取该字段的值,//expected表示期望值,x表示要设置的值,下面3个方法都通过CAS原子指令执行操作。public final native boolean compareAndSwapObject(Object o, long offset,Object expected, Object x);public final native boolean compareAndSwapInt(Object o, long offset,int expected,int x);public final native boolean compareAndSwapLong(Object o, long offset,long expected,long x);

--指针类Unsafe类中JDK 1.8新增的几个方法,它们的实现是基于上述的CAS方法 int型为例 非native

//1.8新增,给定对象o,根据获取内存偏移量指向的字段,将其增加delta,//这是一个CAS操作过程,直到设置成功方能退出循环,返回旧值public final int getAndAddInt(Object o, long offset, int delta) {int v;do {//获取内存中最新值v = getIntVolatile(o, offset);//通过CAS操作} while (!compareAndSwapInt(o, offset, v, v + delta));return v;}//1.8新增,方法作用同上,只不过这里操作的long类型数据public final long getAndAddLong(Object o, long offset, long delta) {...}//1.8新增,给定对象o,根据获取内存偏移量对于字段,将其 设置为新值newValue,//这是一个CAS操作过程,直到设置成功方能退出循环,返回旧值public final int getAndSetInt(Object o, long offset, int newValue) {int v;do {v = getIntVolatile(o, offset);} while (!compareAndSwapInt(o, offset, v, newValue));return v;}// 1.8新增,同上,操作的是long类型public final long getAndSetLong(Object o, long offset, long newValue) {...}//1.8新增,同上,操作的是引用类型数据public final Object getAndSetObject(Object o, long offset, Object newValue) {...}

--挂起与恢复(park unpark os 线程挂起)

--内存屏障(这个volitile有用到)2 Atomic

并发包中的原子操作类(Atomic系列),从JDK 1.5开始提供了java.util.concurrent.atomic包,在该包中提供了许多基于CAS实现的原子操作类原子更新基本类型

1)3个基本类型

AtomicBoolean:原子更新布尔类型

AtomicInteger:原子更新整型

AtomicLong:原子更新长整型

这3个类的实现原理和使用方式几乎是一样的,这里我们以AtomicInteger为例进行分析

2)AtomicIntegerpublic class AtomicInteger extends Number implements java.io.Serializable {...// 获取指针类Unsafeprivate static final Unsafe unsafe = Unsafe.getUnsafe();//下述变量value在AtomicInteger实例对象内的内存偏移量private static final long valueOffset;static {try {//通过unsafe类的objectFieldOffset()方法,获取value变量在对象内存中的偏移//通过该偏移量valueOffset,unsafe类的内部方法可以获取到变量value对其进行取值或赋值操作valueOffset = unsafe.objectFieldOffset(AtomicInteger.class.getDeclaredField("value"));} catch (Exception ex) { throw new Error(ex); }}//当前AtomicInteger封装的int变量valueprivate volatile int value;...//当前值加1,返回新值,底层CAS操作public final int incrementAndGet() {return unsafe.getAndAddInt(this, valueOffset, 1) + 1;}...}

--重点分析自增操作方法实现过程,其他方法自增实现原理一样。

--发现AtomicInteger类中所有自增或自减的方法都间接调用Unsafe类中的getAndAddInt()方法实现了CAS操作,从而保证了线程安全,关于getAndAddInt,是Unsafe类中1.8新增的方法,源码如下//Unsafe类中的getAndAddInt方法public final int getAndAddInt(Object o, long offset, int delta) {int v;do {v = getIntVolatile(o, offset);} while (!compareAndSwapInt(o, offset, v, v + delta));return v;}

--getAndAddInt通过一个while循环不断的重试更新要设置的值,直到成功为止,调用的是Unsafe类中的compareAndSwapInt方法,是一个CAS操作方法。注意的是,上述源码分析是基于JDK1.8的,如果是1.8之前的方法,AtomicInteger源码实现有所不同,是基于for死循环的,如下

//JDK 1.7的源码,由for的死循环实现,并且直接在AtomicInteger实现该方法,//JDK1.8后,该方法实现已移动到Unsafe类中,直接调用getAndAddInt方法即可public final int incrementAndGet() {for (;;) {int current = get();int next = current + 1;if (compareAndSet(current, next))return next;}}

① atomicInteger.getAndIncreament:解决i++线程安全问题

--方法调用的 unsafe.getAndAddInt(this,valueoffset,1)

this:当前对象

valueoffset:内存偏移量,即内存地址

getAndAddInt:在unsafe类,实现使用了先获取当前地址值getIntVolatile,再比较交换compareAndSwapInt,没得到正确值会一直CAS3 原子更新引用-AtomicReference

AtomicReference原子类,即原子更新引用类型。

AtomicReference原子类内部是如何实现CAS操作的呢?

-- AtomicReference与AtomicInteger的实现原理基本是一样的,最终执行的还是Unsafe类,关于AtomicReference的其他方法也是一样的public class AtomicReference<V> implements java.io.Serializable {private static final Unsafe unsafe = Unsafe.getUnsafe();private static final long valueOffset;static {try {valueOffset = unsafe.objectFieldOffset(AtomicReference.class.getDeclaredField("value"));} catch (Exception ex) { throw new Error(ex); }}//内部变量value,Unsafe类通过valueOffset内存偏移量即可获取该变量private volatile V value;//CAS方法,间接调用unsafe.compareAndSwapObject(),它是一个//实现了CAS操作的native方法public final boolean compareAndSet(V expect, V update) {return unsafe.compareAndSwapObject(this, valueOffset, expect, update);}//设置并获取旧值public final V getAndSet(V newValue) {return (V)unsafe.getAndSetObject(this, valueOffset, newValue);}//省略其他代码......}//Unsafe类中的getAndSetObject方法,实际调用还是CAS操作public final Object getAndSetObject(Object o, long offset, Object newValue) {Object v;do {v = getObjectVolatile(o, offset);} while (!compareAndSwapObject(o, offset, v, newValue));return v;}

4 CAS缺点

代码如下:public final int getAndAddInt(Object var1, long var2, int var4) {int var5;do {var5 = this.getIntVolatile(var1, var2);} while(!this.compareAndSwapInt(var1, var2, var5, var5 + var4));return var5;}

1)循环时间长开销很大:

有个do-while,CAS失败会一直尝试,会给CPU带来很大开销,效率低于 synchronized

2)只能保证一个共享变量的原子操作

多共享变量,循环CAS会破坏原子性,只能加锁

3)ABA问题5 ABA问题解决

原子类AtomicInterger的ABA问题?原子更新引用知道吗?

1)CAS会导致ABA问题

--CAS算法实现一个重要前提需要取出内存中某时刻的数据并在当下时刻比较并替换,那么在这个时间差类会导致数据的变化。

--示例:(一个慢取出后挂起,快的已经更改了值,慢的再用原来的值更改)

有线程one,two两个线程,one线程较慢需要十秒钟,two线程较快尽需两秒,

一个线程one从内存位置中取出A,这时候另一个线程two也从内存中取出A,并且线程two进行了一些操作将值变成了B,然后线程内有一些其他操作two又将V位置的数据变成A,这时候线程one进行CAS操作发现内存中仍然是A,然后线程one操作成功。

--尽管线程one的CAS操作成功,但是不代表这个过程就是没有问题的。因为one得到的这个内存中的值已经发生了许多问题.

2)原子引用:AotmicReference类AotmicReference<User> aotmicReference = new AotmicReference<>();aotmicReference.set();aotmicReference.compareAndSet();

3)时间戳原子引用

- 新增一种修改版本号的机制(类似时间戳)

4)问题解决 AtomicStampedReference类,boolean

atomicStampedReference=new AtomicStampedReference<>(值,时间戳-版本号)atomicStampedReference.compareAndSet(现值,期望值,期望版本号,新版本号)

AtomicStampedReference

--概念:

一个带有时间戳的对象引用,在每次修改后,AtomicStampedReference不仅会设置新值而且还会记录更改的时间。当AtomicStampedReference设置对象值时,对象值以及时间戳都必须满足期望值才能写入成功。

--内部实现思想:

通过一个键值对Pair存储数据和时间戳,在更新时对数据和时间戳进行比较,只有两者都符合预期才会调用Unsafe的compareAndSwapObject方法执行数值和时间戳替换,也就避免了ABA的问题。

--内部实现原理:public class AtomicStampedReference<V> {//通过Pair内部类存储数据和时间戳private static class Pair<T> {final T reference;final int stamp;private Pair(T reference, int stamp) {this.reference = reference;this.stamp = stamp;}static <T> Pair<T> of(T reference, int stamp) {return new Pair<T>(reference, stamp);}}//存储数值和时间的内部类private volatile Pair<V> pair;//构造器,创建时需传入初始值和时间初始值public AtomicStampedReference(V initialRef, int initialStamp) {pair = Pair.of(initialRef, initialStamp);}}...// 接着看看其compareAndSet方法的实现public boolean compareAndSet(V expectedReference,V newReference,int expectedStamp,int newStamp) {Pair<V> current = pair;returnexpectedReference == current.reference &&expectedStamp == current.stamp &&((newReference == current.reference &&newStamp == current.stamp) ||casPair(current, Pair.of(newReference, newStamp)));}

看下casPair():

同时对当前数据和当前时间进行比较,只有两者都相等是才会执行casPair()方法,单从该方法的名称就可知是一个CAS方法,最终调用的还是Unsafe类中的compareAndSwapObject方法:private boolean casPair(Pair<V> cmp, Pair<V> val) {return UNSAFE.compareAndSwapObject(this, pairOffset, cmp, val);}

从 Java1.5 开始 JDK 的 atomic包里提供了一个类 AtomicStampedReference 来解决 ABA 问题。

自旋锁

- 自旋锁_zj

- 是什么(sxt2)

自旋锁(spinlock):尝试获取锁的线程不会立即阻塞,而是采取循环的方式去获取锁,这样的好处是减少线程上下文切换的消耗,缺点是循环会消耗CPU。(阻塞的反义自旋)

--概念:自旋锁是一种假设在不久将来,当前的线程可以获得锁,因此虚拟机会让当前想要获取锁的线程做几个空循环(这也是称为自旋的原因),在经过若干次循环后,如果得到锁,就顺利进入临界区。如果还不能获得锁,那就会将线程在操作系统层面挂起,这种方式确实也是可以提升效率的。

--问题:当线程越来越多竞争很激烈时,占用CPU的时间变长会导致性能急剧下降,因此Java虚拟机内部一般对于自旋锁有一定的次数限制,可能是50或者100次循环后就放弃,直接挂起线程,让出CPU资源。 手写一个自旋锁(sxt2) AtomicReference实现

import java.util.concurrent.TimeUnit;import java.util.concurrent.atomic.AtomicReference;/*** 题目:实现一个自旋锁* 自旋锁好处:循环比较获取直至成功为止,没有类似wait的阻塞。** 通过CAS操作完成自旋锁,A线程先进来调用myLock方法,自己持有5秒钟,* B随后进来后发现,当前线程持有锁,不是null,* 所以只能通过自旋等待,直到A释放锁后B随后抢到。*/public class SpinLockDemo {// 原子引用线程AtomicReference<Thread> atomicReference = new AtomicReference<>();public void myLock(){Thread thread = Thread.currentThread(); // 当前进来的线程System.out.println(thread.getName() + "\t come in!");while(!atomicReference.compareAndSet(null,thread)){//期望值,现值为null,当前线程进去}}// 解锁public void myUnlock(){Thread thread = Thread.currentThread();atomicReference.compareAndSet(thread,null); // 用完,设置为nullSystem.out.println(thread.getName() + "\t invoked myUnlock()");}public static void main(String[] args) {SpinLockDemo spinLockDemo = new SpinLockDemo();new Thread(()->{spinLockDemo.myLock();// 暂停一会线程try {TimeUnit.SECONDS.sleep(5);} catch (InterruptedException e) {e.printStackTrace();}spinLockDemo.myUnlock();},"AA").start();// 保证A先启动try {TimeUnit.SECONDS.sleep(1);} catch (InterruptedException e) {e.printStackTrace();}new Thread(()->{spinLockDemo.myLock();spinLockDemo.myUnlock();},"BB").start();}}

- 说说自旋锁咋实现的

1)概念

自旋锁(spinlock):是指当一个线程在获取锁的时候,如果锁已经被其它线程获取,那么该线程将循环等待,然后不断的判断锁是否能够被成功获取,直到获取到锁才会退出循环。

2)存在的问题

① 如果某个线程持有锁的时间过长,就会导致其它等待获取锁的线程进入循环等待,消耗CPU。使用不当会造成CPU使用率极高。

② 上面Java实现的自旋锁不是公平的,即无法满足等待时间最长的线程优先获取锁。不公平的锁就会存在“线程饥饿”问题。

3)优点

① 自旋锁不会使线程状态发生切换,一直处于用户态,即线程一直都是active的;不会使线程进入阻塞状态,减少了不必要的上下文切换,执行速度快。

3)例子

ublic class SpinLock {private AtomicReference cas = new AtomicReference();public void lock() {Thread current = Thread.currentThread();// 利用CASwhile (!cas.compareAndSet(null, current)) {// DO nothing}}public void unlock() {Thread current = Thread.currentThread();cas.compareAndSet(current, null);}}

lock()方法利用的CAS,当第一个线程A获取锁的时候,能够成功获取到,不会进入while循环,如果此时线程A没有释放锁,另一个线程B又来获取锁,此时由于不满足CAS,所以就会进入while循环,不断判断是否满足CAS,直到A线程调用unlock方法释放了该锁。

https://www.jianshu.com/p/9d3660ad4358

AQS(AbstractQueuedSynchronizer) ★

- AQS_zejian|

- unlock()操作必须在finally代码块中确保即使临界区执行抛出异常,线程最终也能正常释放锁

可重入锁

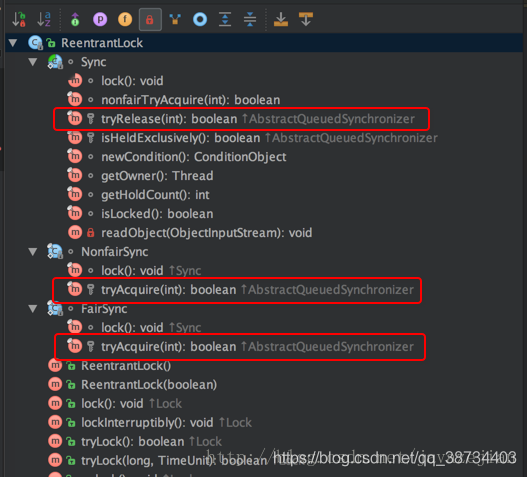

- Lock为接口,ReentrantLock是Lock的实现类

- 又名递归锁,ReentrantLock/Synchronized就是一个典型的可重入锁。

- 最大作用:避免死锁

可重入锁概念:

-- ReentrantLock翻译叫可重入锁。所谓可重入锁,顾名思义,指的是线程可以重复获取同一把锁。

-- 同一个线程外层函数获得锁之后,内层递归函数仍然能够获取该锁的代码,在同一个线程在外层方法获取锁的时候,在进入内层方法会自动获取锁

-- 如下代码,当线程 T1 执行到 ①处时,已经获取到了锁 rtl ,当在 ① 处调用get() 方法时,会在 ② 再次对锁 rtl执行加锁操作。

此时,如果锁 rtl 是可重入的,那么线程T1可以再次加锁成功;如果锁 rtl 是不可重入的,那么线程 T1 此时会被阻塞。class X {private final Lock rtl = new ReentrantLock();int value;public int get() {// 获取锁rtl.lock(); ②try {return value;} finally {// 保证锁能释放rtl.unlock();}}public void addOne() {// 获取锁rtl.lock();try {value = 1 + get(); ①} finally {// 保证锁能释放rtl.unlock();}}}

- 可重入函数

指的是多个线程可以同时调用该函数,每个线程都能得到正确结果;同时在一个线程内支持线程切换,无论被切换多少次,结果都是正确的。多线程可以同时执行,还支持线程切换,这意味着什么呢?线程安全啊。所以,可重入函数是线程安全的。

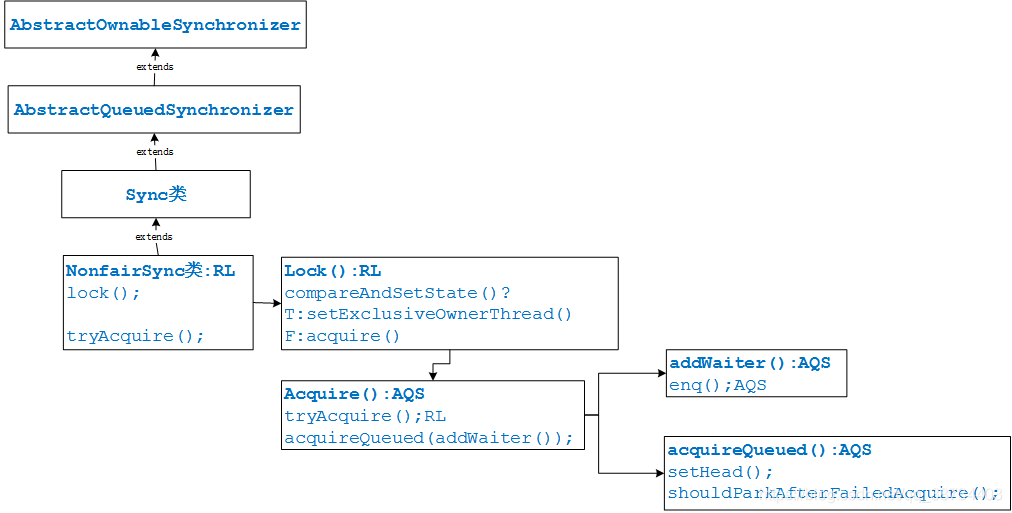

AQS

- RL_zejian|

- AQS原理及实现?

- 类在java.util.concurrent.locks包下面

- 概念

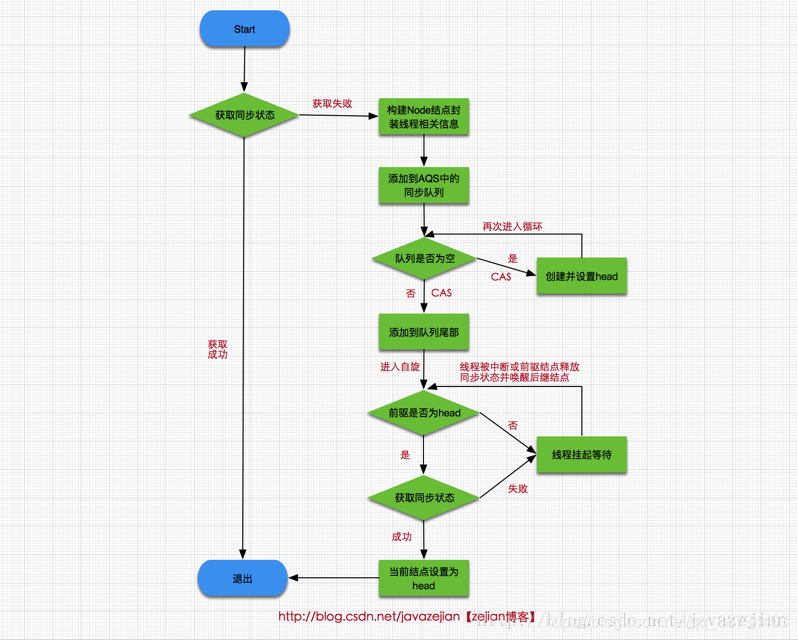

AQS是一个用来构建锁和同步器的框架,使用AQS能简单且高效地构造出应用广泛的大量的同步器,比如我们提到的ReentrantLock,Semaphore,其他的诸如ReentrantReadWriteLock,SynchronousQueue,FutureTask等等皆是基于AQS的。当然,我们自己也能利用AQS非常轻松容易地构造出符合我们自己需求的同步器。 - AQS核心思想是,如果被请求的共享资源空闲,则将当前请求资源的线程设置为有效的工作线程,并且将共享资源设置为锁定状态。如果被请求的共享资源被占用,那么就需要一套线程阻塞等待以及被唤醒时锁分配的机制,这个机制AQS是用CLH队列锁实现的,即将暂时获取不到锁的线程加入到队列中。

- AQS 对资源的共享方式

AQS定义两种资源共享方式

① Exclusive(独占):只有一个线程能执行,如ReentrantLock。又可分为公平锁和非公平锁:

*公平锁:按照线程在队列中的排队顺序,先到者先拿到锁

*非公平锁:当线程要获取锁时,无视队列顺序直接去抢锁,谁抢到就是谁的

② Share(共享):多个线程可同时执行,如Semaphore/CountDownLatch。Semaphore、CountDownLatch、 CyclicBarrier、ReadWriteLock 我们都会在后面讲到。

ReentrantReadWriteLock 可以看成是组合式,因为ReentrantReadWriteLock也就是读写锁允许多个线程同时对某一资源进行读。

不同的自定义同步器争用共享资源的方式也不同。自定义同步器在实现时只需要实现共享资源 state 的获取与释放方式即可,至于具体线程等待队列的维护(如获取资源失败入队/唤醒出队等),AQS已经在顶层实现好了。 AQS底层使用了模板方法模式

同步器的设计是基于模板方法模式的,如果需要自定义同步器一般的方式是这样(模板方法模式很经典的一个应用):

使用者继承AbstractQueuedSynchronizer并重写指定的方法。(这些重写方法很简单,无非是对于共享资源state的获取和释放)

将AQS组合在自定义同步组件的实现中,并调用其模板方法,而这些模板方法会调用使用者重写的方法。

这和我们以往通过实现接口的方式有很大区别,这是模板方法模式很经典的一个运用。

AQS使用了模板方法模式,自定义同步器时需要重写下面几个AQS提供的模板方法:isHeldExclusively()//该线程是否正在独占资源。只有用到condition才需要去实现它。tryAcquire(int)//独占方式。尝试获取资源,成功则返回true,失败则返回false。tryRelease(int)//独占方式。尝试释放资源,成功则返回true,失败则返回false。tryAcquireShared(int)//共享方式。尝试获取资源。负数表示失败;0表示成功,但没有剩余可用资源;正数表示成功,且有剩余资源。tryReleaseShared(int)//共享方式。尝试释放资源,成功则返回true,失败则返回false。

默认情况下,每个方法都抛出 UnsupportedOperationException。 这些方法的实现必须是内部线程安全的,并且通常应该简短而不是阻塞。AQS类中的其他方法都是final ,所以无法被其他类使用,只有这几个方法可以被其他类使用。

*以ReentrantLock为例,state初始化为0,表示未锁定状态。A线程lock()时,会调用tryAcquire()独占该锁并将state+1。此后,其他线程再tryAcquire()时就会失败,直到A线程unlock()到state=0(即释放锁)为止,其它线程才有机会获取该锁。当然,释放锁之前,A线程自己是可以重复获取此锁的(state会累加),这就是可重入的概念。但要注意,获取多少次就要释放多么次,这样才能保证state是能回到零态的。

*再以CountDownLatch以例,任务分为N个子线程去执行,state也初始化为N(注意N要与线程个数一致)。这N个子线程是并行执行的,每个子线程执行完后countDown()一次,state会CAS(Compare and Swap)减1。等到所有子线程都执行完后(即state=0),会unpark()主调用线程,然后主调用线程就会从await()函数返回,继续后余动作。

*一般来说,自定义同步器要么是独占方法,要么是共享方式,他们也只需实现tryAcquire-tryRelease、tryAcquireShared-tryReleaseShared中的一种即可。但AQS也支持自定义同步器同时实现独占和共享两种方式,如ReentrantReadWriteLock。-----------------------------具体-------------------

AQS的原理概要,如下源码- 1 AQS工作原理概要

--概念:AbstractQueuedSynchronizer(AQS)又称为队列同步器;

--作用:用来构建锁或其他同步组件的基础框架;

--state:内部通过一个int类型的成员变量state来控制同步状态:

① 当state=0,则说明没有任何线程占有共享资源的锁;

② 当state=1,则说明有线程目前正在使用共享变量,其他线程必须加入同步队列进行等待;

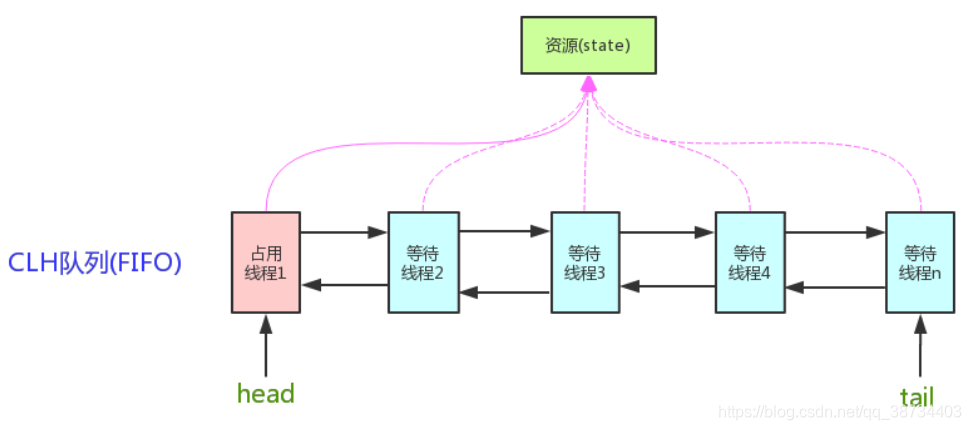

--同步队列:AQS内部通过内部类Node构成FIFO的同步队列来完成线程获取锁的排队工作;

--等待队列:AQS同时利用内部类ConditionObject构建等待队列,当Condition调用await()方法后,线程将会加入等待队列中,而当Condition调用signal()方法后,线程将从等待队列转移动同步队列中进行锁竞争。

注意:这里涉及到两种队列,一种的同步队列,当线程请求锁而等待后将加入同步队列等待,而另一种则是等待队列(可有多个),通过Condition调用await()方法释放锁后,将加入等待队列。 2 AQS中的同步队列模型

1)AQS

--head和tail:分别是AQS中的变量。

head:指向同步队列的头部,注意head为空结点,不存储信息。

tail:指向同步队列的队尾,同步队列采用的是双向链表的结构这样可方便队列进行结点增删操作。

--state: state变量则是代表同步状态。

state=0:执行当线程调用lock方法进行加锁后,如果此时state的值为0,则说明当前线程可以获取到锁(在本篇文章中,锁和同步状态代表同一个意思),同时将state设置为1,表示获取成功。

state=1:如果state已为1,也就是当前锁已被其他线程持有,那么当前执行线程将被封装为Node结点加入同步队列等待。

--Node结点:是对每一个访问同步代码的线程的封装。/** AQS抽象类*/public abstract class AbstractQueuedSynchronizerextends AbstractOwnableSynchronizer{//指向同步队列队头private transient volatile Node head;//指向同步的队尾private transient volatile Node tail;//同步状态,0代表锁未被占用,1代表锁已被占用private volatile int state;//省略其他代码......}

2)Node节点

从图中的Node的数据结构也可看出,其包含了需要同步的线程本身以及线程的状态,如是否被阻塞,是否等待唤醒,是否已经被取消等。每个Node结点内部关联其前继结点prev和后继结点next,这样可以方便线程释放锁后快速唤醒下一个在等待的线程,Node是AQS的内部类,其数据结构如下:

-- SHARED(shared)和EXCLUSIVE(exclusive)常量:分别代表共享模式和独占模式。

① 共享模式:是一个锁允许多条线程同时操作;

如信号量Semaphore采用的就是基于AQS的共享模式实现的。

② 独占模式:是同一个时间段只能有一个线程对共享资源进行操作,多余的请求线程需要排队等待;

如ReentranLock。

--waitStatus变量:表示当前被封装成Node结点的等待状态。

共4种:

① CANCELLED:值为1,在同步队列中等待的线程等待超时或被中断,需要从同步队列中取消该Node的结点,其结点的waitStatus为CANCELLED,即结束状态,进入该状态后的结点将不会再变化。

② SIGNAL:值为-1,被标识为该等待唤醒状态的后继结点,当其前继结点的线程释放了同步锁或被取消,将会通知该后继结点的线程执行。说白了,就是处于唤醒状态,只要前继结点释放锁,就会通知标识为SIGNAL状态的后继结点的线程执行。

③ CONDITION:值为-2,与Condition相关,该标识的结点处于等待队列中,结点的线程等待在Condition上,当其他线程调用了Condition的signal()方法后,CONDITION状态的结点将从等待队列转移到同步队列中,等待获取同步锁。

④ PROPAGATE:值为-3,与共享模式相关,在共享模式中,该状态标识结点的线程处于可运行状态。

⑤ 0状态:值为0,代表初始化状态。

--pre和next:分别指向当前Node结点的前驱结点和后继结点;

--thread变量:存储的请求锁的线程。

--nextWaiter:与Condition相关,代表等待队列中的后继结点,后续会有更详细的分析。static final class Node {static final Node SHARED = new Node(); //共享模式static final Node EXCLUSIVE = null; //独占模式static final int CANCELLED = 1; //标识线程已处于结束状态static final int SIGNAL = -1; //等待被唤醒状态static final int CONDITION = -2; //条件状态,static final int PROPAGATE = -3; //在共享模式中使用表示获得的同步状态会被传播volatile int waitStatus; //等待状态,存在CANCELLED、SIGNAL、//CONDITION、PROPAGATE 4种volatile Node prev; //同步队列中前驱结点volatile Node next; //同步队列中后继结点volatile Thread thread; //请求锁的线程Node nextWaiter; //等待队列中的后继结点,这个与Condition有关final boolean isShared() { //判断是否为共享模式return nextWaiter == SHARED;}final Node predecessor() throws NullPointerException { //获取前驱结点Node p = prev;if (p == null)throw new NullPointerException();elsereturn p;}//.....}

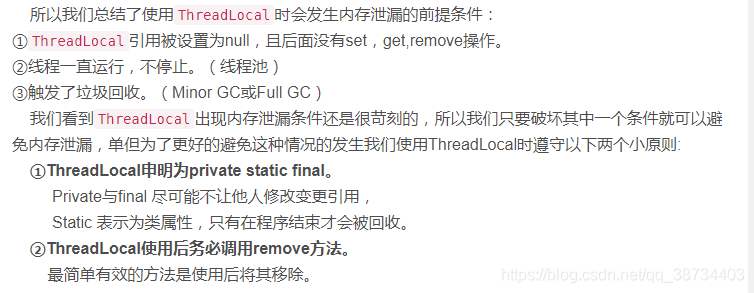

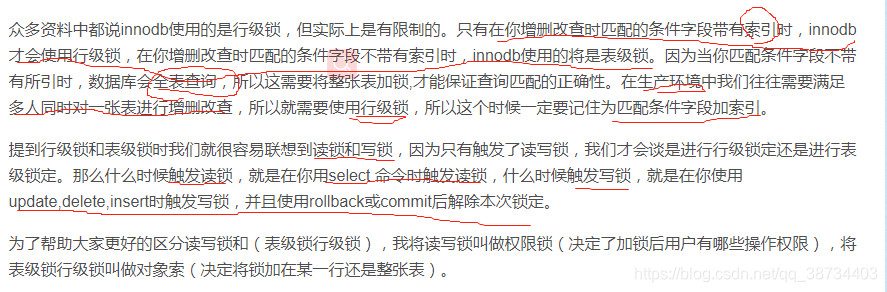

3)总结