@sambodhi

2018-07-17T01:07:48.000000Z

字数 3929

阅读 2435

人工智能医疗安全:我们有麻烦了!

作者|Luke Oakden-Rayner

译者|Liu zhiyong

编辑|Chen Lixin

AI前线导读: 2017年,在中国,医疗人工智能行业融资总额超过17亿元人民币,进入了落地比拼阶段。想象一下吧,未来有一天,你起大早从黄牛手里买到了一张人工智能医学专家号,人工智能医生取代了人类医生,开始诊断你的病情。那么,病人们真的会抛弃老专家而去相信人工智能医生吗?虽然,医疗人工智能声势浩大,但是,医疗人工智能真的安全吗?让我们看看Luke Oakden-Rayner是怎么看待的人工智能医疗安全,也许有所启迪。

本文是新博客系列的开篇之作,该系列是关于我可能会写的最重要的主题:人工智能医疗安全。这场讨论可谓是一场及时雨,因为我们正在接近一个拐点。在真实诊所中,人工智能系统第一次取代了人类的判断。有史以来,人工智能系统第一次对患者造成了直接的伤害,不安全的系统导致了超支、伤害甚至死亡。

这是有史以来,人工智能系统第一次真正对医疗灾难负责的事件。

如果听上去像是坏兆头,情况会是这样。我认为还是我们不够小心所致。

医疗安全

我们在考虑近期的人工智能安全问题时,需要认识到:人类医学领域的人工智能,与几乎所有其他领域中的人工智能是不同的。在科技界,业绩往往高于一切,而风险则被视为次要的。这点在许多硅谷软件公司的非官方座右铭得到了体现:“快速行动,破除陈规”(move fast and break things)。与软件公司不同的是,许多医生奉行的信条以“勿为有损之事”(first, do no harm)开始,这是西方最早的医生誓词(希波克拉底誓词)。由于医学研究对生命和健康的风险要求,我们必须把安全放在第一位。医学研究都遵循了这一点。例如,药物公司被要求在被允许测试药效之前证明其安全性。

在医学领域之外的人工智能,我们已经目睹了硅谷精神带来的问题。存在偏差或缺陷的系统已经对公众产生了恶劣的影响:Google的照片标签系统将皮肤黝黑的用户识别为大猩猩;Microsoft的聊天机器人“Tay”不学好,有了种族歧视的恶行;Uber和Tesla的自动驾驶汽车无法应对相当普通的交通状况,发生车祸并致人死亡。

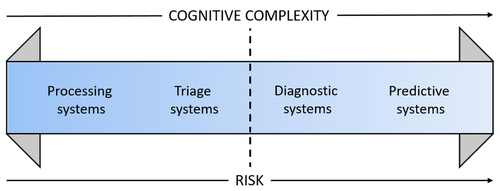

有种简短的描述就是将医学人工智能视为在人类应用工具(即传统医疗软件)和完全自主的决策者之间的风险范围内的操作。在风险范围的极端情况下,系统不仅能够独立运行,而且还能执行人类自己无法完成的任务。如此一来,无论决策过程多么透明,人们都无法对系统进行评估。

如果我们将典型的医学人工智能任务置于这个风险范围之内,它可能看起来如下图所示那样的:

虚线是一个拐点,我们从向人类专家提供信息的系统过渡到能够独立做出医疗决策的系统。

而现在,我们正处在这样一个拐点上。

快速行动……

有许多基于深度学习的人工智能系统得到了监管机构的批准,包括Arterys的检测和测量系统,以及Viz.AI的脑卒中系统。这些系统都有一些共同之处:每个决策都需要人类专家参与。这些系统知识为人类专家提供额外的信息,以便他们据此作出决策。虽然应用这些系统并不会对患者造成伤害,尽管这种情况这不大可能会出现。

也有一些系统的界限有点模糊。美国食品和药物管理局(Food and Drug Administration,FDA)批准了一项系统,用于检测心脏病患者心房颤动的动态心电图监测仪,心脏病学强调了医生可能会关注的领域,但最终的判断还是要取决于他们。这里的问题是,如果这个系统大部分是准确的,医生真的会花时间煞费苦心地检查几个小时的心电图吗?乳房X光检查的经验是,计算机顾问甚至可能会恶化患者的结果,尽管这可能出乎意料。以下是Kohli和Jha的相关引用,回顾了数十年来对多读者测试(multi-reader testing)中表现良好的系统的后续研究:

CAD不仅在没有提高癌症检测的情况下增加了召回率,而且在某些情况下甚至降低了检测某些癌症的灵敏度,特别是没有钙化的病变。CAD会使新手产生一种错误的安全感。因此,CAD具有较低的灵敏度和较低的特异性,是一种无法弥补的质量成像测试。

这些系统显然会产生意想不到的意外后果,但结果的差异往往很小,需要数年时间才能显现出来。这并不意味着我们忽视了这些风险,只是灾难的风险相当低。

现在我们到了拐点上。

几个月前,FDA批准了由IDx开发的一个新的人工智能系统,它能够做出独立的医疗决策。这个系统可以在家庭医生的办公室操作,分析患者视网膜的照片,并确定该患者是否需要转诊给眼科医生。FDA明确表示:

IDx-DR是第一个被授权用于市场营销的设备,它可以在不需要临床医生解释图像或结果的情况下提供筛查决策,这使得它可以由通常不参与眼科治疗的医疗服务提供者使用。

就自主决策而言,这似乎是相当良性的。目前,转诊眼科医生的决定是基于几个因素做出的(澳大利亚指南请参阅这篇pdf文档:http://u6.gg/dMgaq),但是视网膜图像评估确实起了很大的作用。这种自动化的转诊系统在实践中很有可能行得通。但是,尽管有很大的潜在好处(大约50%的糖尿病患者没有经常接受定期筛查),而且“转诊与否”的决定很少会立即对视力造成威胁,但在没有进行临床测试的情况下批准这样的系统会引起一些担忧。

随着风险范围的进一步扩大,医疗推特(twitter)也受到了反对,因为NHS已经在使用“Babylon健康人工智能”(babylonhealth AI)驱动的自动智能手机分诊系统。这是绝对有可能导致严重的伤害,因为它建议什么时候去(或不去)医院。引起一些医生高度关注的是,它似乎建议,如果出现典型的心脏病发作症状,就呆在家里;如果是脑膜炎就休息;如果是中风就缓解疼痛。

PE(pulmonary embolism,肺栓塞)的未治疗死亡率在5%到50%之间。肋软骨关节炎(Costochondritis)是一种发生在胸部关节的疼痛,通常是由于过度使用所致。这样的建议会杀人,这并不是什么好主意。

据我所知,为了回应医生们的担忧,一些NHS机构正在调查这项技术的使用情况。

最后,几家公司(即Google、Enlitic等公司)一直在实施“离岸外包”(off-shoring),他们将人工智能产品带到监管环境较为宽松的管辖区。虽然这种做法在药物检测中很普遍(在这种情况下会存在严重的风险),但这些公司似乎并没有使用这些设置进行测试,而是采取了离岸外包来避免完全测试。这些人群极度缺乏服务,任何治疗都比没有治疗好,这种理由都是非常值得怀疑的。许多有希望的治疗方法已经被放弃了,因为它们造成的伤害远远超过了预防。

这里的重点不是具体批评这些公司。他们中的许多家公司都是伟大的公司,我认识的人都很棒、体贴、细心。但我们必须认识到,即便是最谨慎的人,也可能做出导致悲剧的决定,这就是我们首先要进行监管的原因。

真正的问题是,FDA、NHS和其他国家的各个监管机构似乎都不关心人工智能自主决策的具体风险。他们将这些系统视为简单的医疗设备,允许人工智能决策系统在临床上使用,只有适度证据支持它们,并且没有进行调查可能出现的意外后果。

……破除陈规

虽然FDA在本届政府的领导下肯定在减少监管,但目前的“自由放任”(Laissez-faire)做法是否完全是有意为之,或者它是否也反映了任何新技术带来的监管惰性,目前尚不清楚。不管怎样,我们需要记住我们的历史。过去,松懈的医疗监管导致了悲剧的发生。

一些重要的例子:

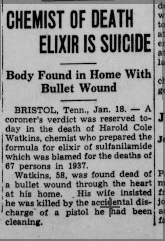

- 磺胺酏剂(1930年代)。磺胺被认为是一种相当安全的抗生素,但是负责在S.E.生产磺胺的化学家所在的公司Massengill决定使用一种名为DEG的溶剂来制造“灵丹妙药”。这种化合物有很高的毒性,造成了107人的死亡。这一事件以及随之而来的公众抗议催生了新的法律,为今天的FDA的诞生奠定了基础。为了进一步证明有必要建立强有力的监管环境,自1980年代以来,DEG在全球范围内已经造成了1000多人的死亡,其中大多数是幼儿。最近的一次事件是2009年发生在尼日利亚,造成了至少有84名7岁以下的儿童死亡。

- 沙利度胺(Thalidomide,酞胺呱啶酮,一种原用作孕妇的镇静剂。商品名为反应停)(1950年代)。沙利度胺实际上是监管的成功案例。在磺胺灾难后,FDA加大了监管力度,由于沙利度胺缺乏安全性证据,因此美国禁止销售这种用于控制孕期恶心的药物。当时,大多数司法管辖区尚未建立类似的权威机构,而沙利度胺在许多国家的药店柜台上架了。沙利度胺导致了全球范围内大约10000例出生缺陷和2000例婴儿死亡。多亏了Frances Kelsey和FDA,美国几乎完全避免了这种情况。

我们是否有可能争取以磺胺酏剂或沙利度胺这样大规模事件为标准进行人工智能的活动呢?在接下来的几篇文章中,我将讨论与如何测试这些系统相关的若干关键问题。就目前而言,我对批准有风险的人工智能系统所需的证据水平深感担忧。

Samuel Massengill在出庭时引用了他自己的一句话,就他的产品造成107人死亡的事件作证道:

“我们一直在提供合法的专业需求,而不是从来没有预见到意料之外的结果。”

这家公司的首席化学家很可能不同意这种说法。

对我们所有人来说,这是一个关于因为粗心大意而付出个人代价的警示故事。如果我们没有从医疗监管的历史中学到任何东西,我们需要记住:未预料到的和不可预料的并不是一回事。

原文连接: Medical AI Safety: We have a problem.

https://lukeoakdenrayner.wordpress.com/2018/07/11/medical-ai-safety-we-have-a-problem/