@Arslan6and6

2016-10-10T06:54:52.000000Z

字数 1377

阅读 829

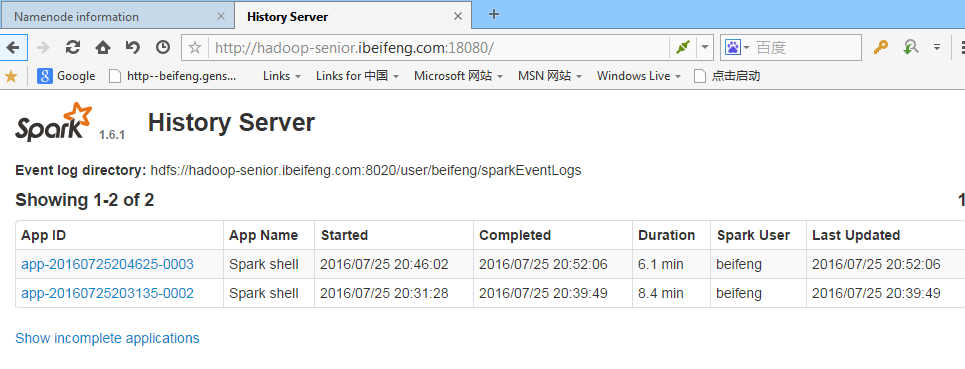

Spark HistoryServer

spark

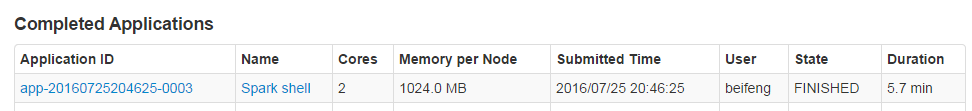

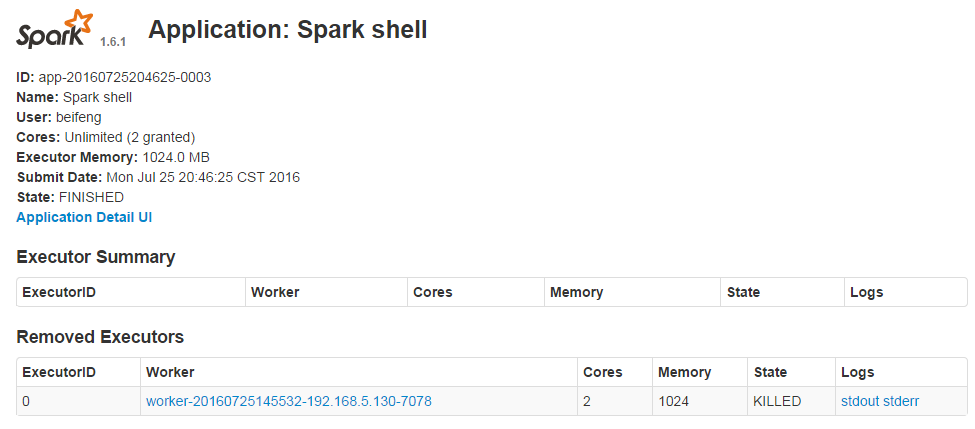

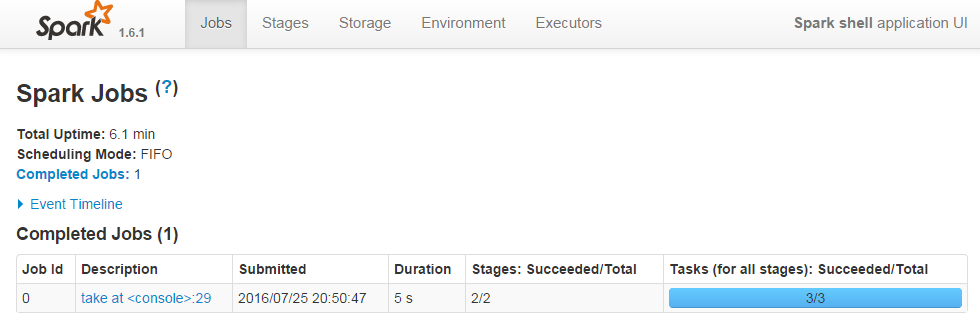

监控运行完成的Spark Applicaiton。

分为两个部分:

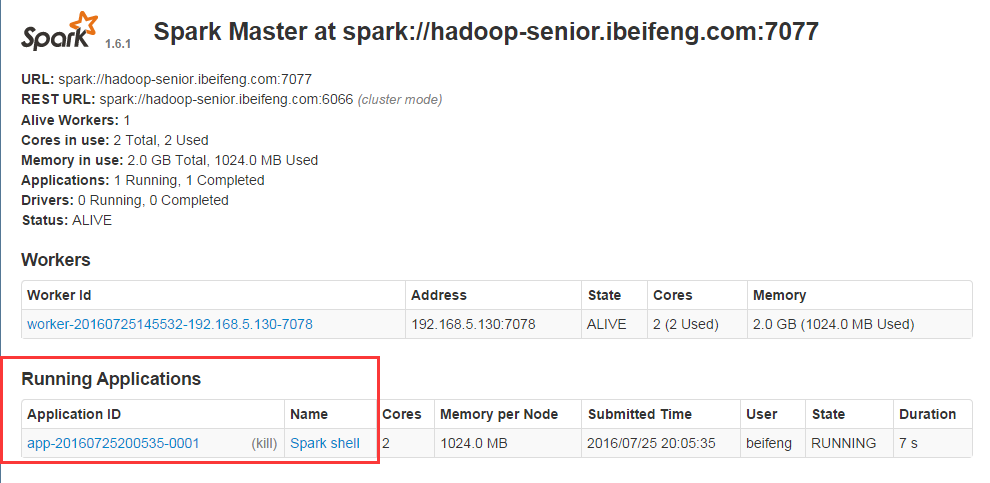

第一、设置SparkApplicaiton在运行时,需要记录日志信息

第二、启动HistoryServer,通过界面查看

vi $SPARK_HOME/conf/spark-defaults.confspark.master spark://hadoop-senior.ibeifeng.com:7077

$bin/spark-shell

同样添加如下信息:开启事件日志及事件事件日志位置

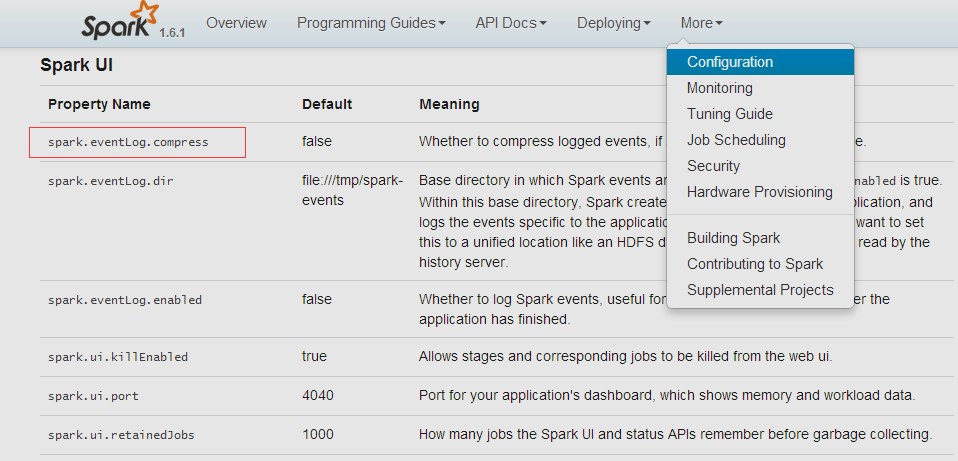

spark.eventLog.enabled truespark.eventLog.dir hdfs://hadoop-senior.ibeifeng.com:8020/user/beifeng/sparkEventLogs

第一部分配置完成

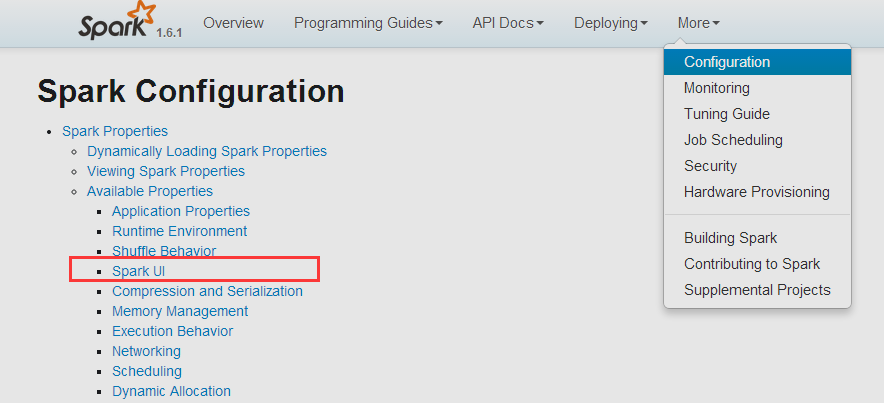

关于其他属性

spark.eventLog.compress 日志存储是否压缩

同样填写入spark-defaults.conf

spark.eventLog.compress true

重新执行 $bin/spark-shell 后

...INFO scheduler.EventLoggingListener: Logging events to hdfs://hadoop-senior.ibeifeng.com:8020/user/beifeng/sparkEventLogs/app-20160725203135-0002.snappy...scala> val rdd = sc.textFile("/input")scala> val wordCountRdd = rdd.flatMap(_.split(" ")).map((_,1)).reduceByKey(_ + _)scala> exit

还可以执行第二部分 启动HistoryServer,通过界面查看

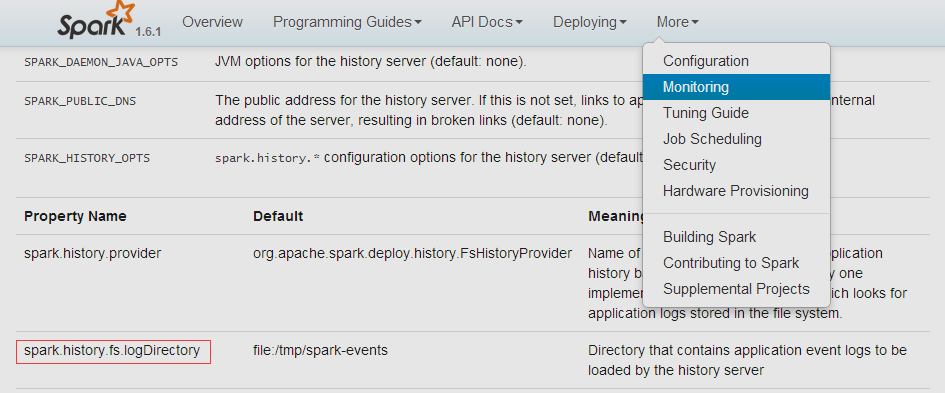

首先配置 spark-env.sh 中的 SPARK_HISTORY_OPTS

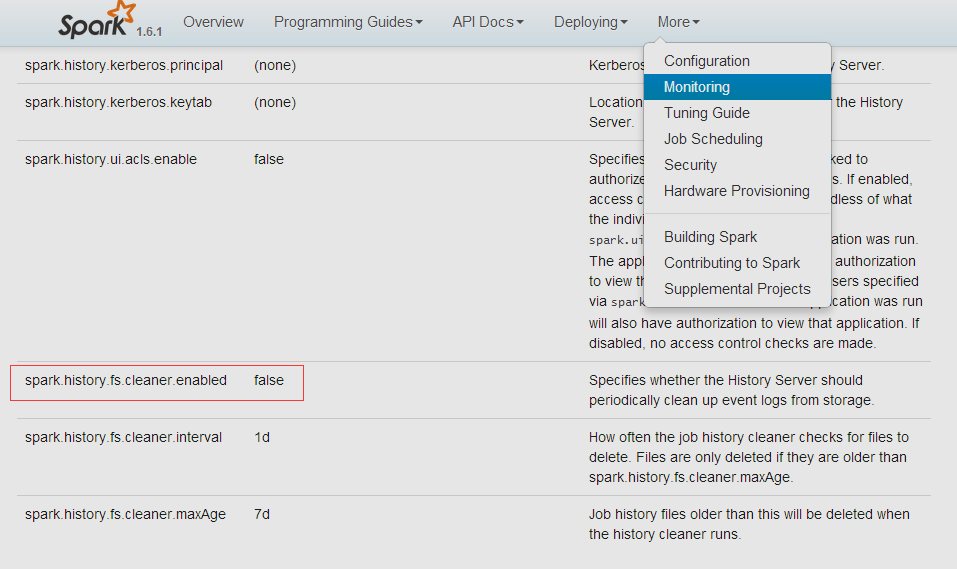

SPARK_HISTORY_OPTS="-Dspark.history.fs.logDirectory=hdfs://hadoop-senior.ibeifeng.com:8020/user/beifeng/sparkEventLogs -Dspark.history.fs.cleaner.enabled=true"

sbin/start-history-server.shstarting org.apache.spark.deploy.history.HistoryServer, logging to /opt/modules/spark-1.6.1-bin-2.5.0-cdh5.3.6/logs/spark-beifeng-org.apache.spark.deploy.history.HistoryServer-1-hadoop-senior.ibeifeng.com.out[beifeng@hadoop-senior spark-1.6.1-bin-2.5.0-cdh5.3.6]$ jps3183 SparkSubmit3098 Worker3327 DataNode5154 HistoryServer3257 NameNode5203 Jps3012 Master